如何在服务器上通过ollama部署本地大模型

如何在服务器上通过ollama部署本地大模型

第一步:下载离线的ollama安装包

curl -L https://ollama.com/download/ollama-linux-amd64.tgz -o ollama-linux-amd64.tgz

第二步:加压安装包到指定的目录

sudo tar -C /usr -xzf ollama-linux-amd64.tgz

第三步:注册服务

vim /etc/systemd/system/ollama.service

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=root

Group=root

Restart=always

RestartSec=3

# 下面的环境变量标识对外暴漏服务,否则的话ollama默认只能在本地调用

Environment="OLLAMA_HOST=0.0.0.0"

[Install]

WantedBy=default.target

systemctl start ollama 启动

systemctl stop ollama 关闭

第五步:下载大模型

可以直接 ollama run qwen2.5 来下载运行大模型,具体会下载几b的 参考官网 https://ollama.com/library/qwen2.5

后面的是离线下载qwen2.5-7b为例

由于我没有gpu服务,所以下载gguf格式的大模型

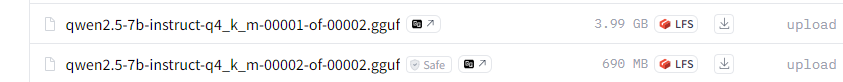

在huggingface上下载模型

一般来说大模型文件会比较大,在网上会被分片存储

上图就是两个文件,下面就要进行模型文件合并

下载llama.cpp

https://github.com/ggerganov/llama.cpp/releases

我下载的是llama-b3906-bin-win-vulkan-x64版本

然后进到解压包里面使用命令进行合并

···

./llama-gguf-split.exe --merge ../qwen2.5-7b-instruct-q4_k_m-00001-of-00002.gguf ../qwen2.5-7b-instruct-q4_k_m.gguf

···

合并之后就是一个完整的大模型文件了,然后上传到linux服务器上

在linux服务器上创建模型文件

vim Modelfile

FROM ./vicuna-33b.Q4_0.gguf

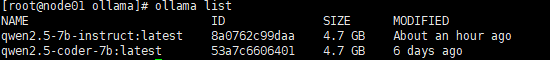

ollama create 模型名称 -f Modelfile

使用 ollama run 模型名称 即可启动对应的模型

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· 上周热点回顾(3.3-3.9)

· winform 绘制太阳,地球,月球 运作规律