centos7.6搭建K8s(Kubernetes)

基于kubeamd方式部署K8s解决方案

Master:192.168.0.26 node1:192.168.0.191 node2:192.168.0.94

一、初始化操作

1、首先关闭三台服务器的防火墙

systemctl stop firewalld #永久关闭

systemctl disable firewalld #永久关闭

永久关闭selinux

sed -i 's/enforcing/disabled/' /etc/selinux/config

关闭swap分区

swapoff -a #临时

sed -ri 's/.*swap.*/#&/' /etc/fstab #永久关闭

2、给三台主机添加主机名称方便管理

hostnamectl set-hostname ecs-K8s-master

hostnamectl set-hostname ecs-K8s-node1

hostnamectl set-hostname ecs-K8s-node2

在master服务器添加hosts,其他不用添加

/etc/hosts配置文件中加入你的ip及修改的名字

192.168.0.26 ecs-K8s-master

192.168.0.191 ecs-K8s-node1

192.168.0.94 ecs-K8s-node2

3、将桥接的IPV4流量传递到iptanles的链

/etc/sysctl.d/k8s.conf 三台服务器的配置文件加入下面两行。

net.bridge.bridge-nf-call-ip6tables=1

net.bridge.bridge-nf-call-iptables=1

执行如下立即生效

sysctl --system

4、三台服务器同步时间

yum -y install ntpdate -y

ntpdate time.windows.com

二、所有节点的准备工作

1、所有节点安装docker

wget -i http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

cp docker-ce.repo /etc/yum.repos.d/

安装所需软件包

yum install -y yum-utils

yum -y install device-mapper-persistent-data

yum -y install lvm2

查看各版本docker

yum list docker-ce --showduplicates | sort -r

安装dockers

yum install docker-ce-18.06.1.ce-3.el7

配置开机自启动

systemctl enable docker

查看是否自启动(enabled)

systemctl list-unit-files | grep docker

启动dockers

systemctl start docker

2、Docker中的仓库配置(所有节点)

cat > /etc/docker/daemon.json << EOF

{

"registry-mirrors": ["https://b9pmyelo.mirror.aliyuncs.com"]

}

EOF

配置完成需要重启docker

systemctl restart docker

3、添加阿里云yum软件源(所有节点执行)

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

4、部署kubeadm,kubelet和kubectl(所有节点执行)

由于版本更新频繁,这里指定版本号部署

rpm --rebuilddb

yum update

yum clean all

yum install -y kubelet-1.18.0 kubeadm-1.18.0 kubectl-1.18.0

检查是否安装

rpm -qa | grep kubelet

rpm -qa | grep kubeadm

rpm -qa | grep kubectl

rpm -qa | grep kubernetes-cni

启动kubelet,并设置开机启动

systemctl enable kubelet && systemctl start kubelet

5、初始化master(在master上面执行)

###apiserver-advertise-address指定master的ip地址

###pod-network-cidr指定Pod网络的范围,这里使用flannel网络方案

kubeadm init --kubernetes-version=1.18.0 --apiserver-advertise-address=192.168.0.26 --image-repository registry.aliyuncs.com/google_containers --service-cidr=10.1.0.0/16 --pod-network-cidr=10.244.0.0/16

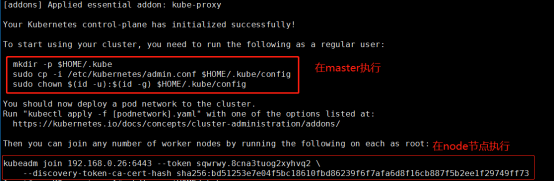

完成后结果如下,不过有两部分需要在master,与node上面执行。

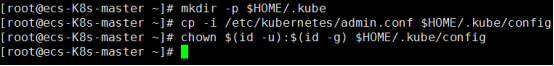

在mster执行如下

6、加入kubernetes node

执行完成可以使用kubectl get nodes 查看当前节点信息。已经有我们master的节点信息了。

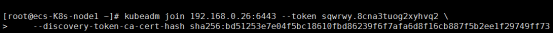

在所有node节点执行上图的命令,将node节点加入。

Node1执行

Node2执行

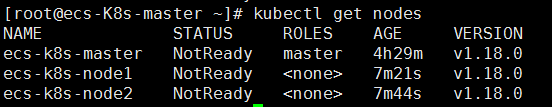

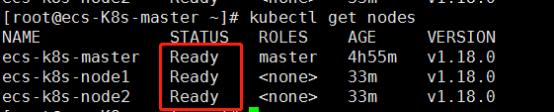

在master节点执行kubectl get nodes,查看是否两个节点加入。

7、部署CNI网络插件(在master执行)

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

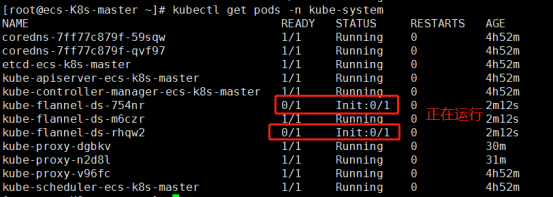

kubectl get pods -n kube-system

查看是否执行完成已经运行

上面的状态全部为1/1时,使用kubectl get nodes,查看是否是已经就绪

集群已经搭建完成。

8、测试kubernetes集群

在kubernetes集群中创建一个pod,验证是否正常运行。

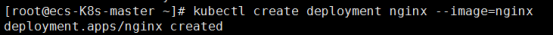

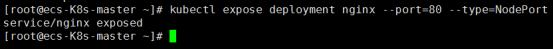

kubectl create deployment nginx --image=nginx 拉取一个nginx

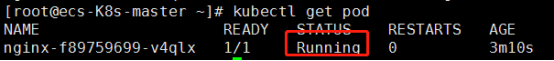

kubectl get pod 查看是否拉取完成。Running已经拉取完成

当状态是running时执行对外进行端口暴露。

kubectl expose deployment nginx --port=80 --type=NodePort

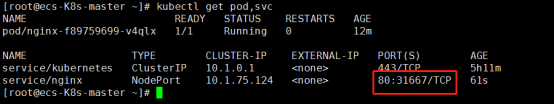

kubectl get pod,svc 查看对外的端口

这边实验是通过华为云服务器测试,需要在云平台的安全组开放这个端口,不然无法访问,如果是虚拟机的话就直接访问就行。

查看nginx部署在哪个节点上面:kubectl get pod -o wide

测试node1节点的ip加上31667访问成功,因为查看pod是运行在node1节点上的,所以使用node1的ip加端口测试。

k8s集群搭建完成