Label Smoothing(标签平移)

作用

标签平滑(Label smoothing),像L1、L2和dropout一样,是机器学习领域的一种正则化方法,通常用于分类问题,目的是防止模型在训练时过于自信地预测标签,改善泛化能力差的问题。

原理分析

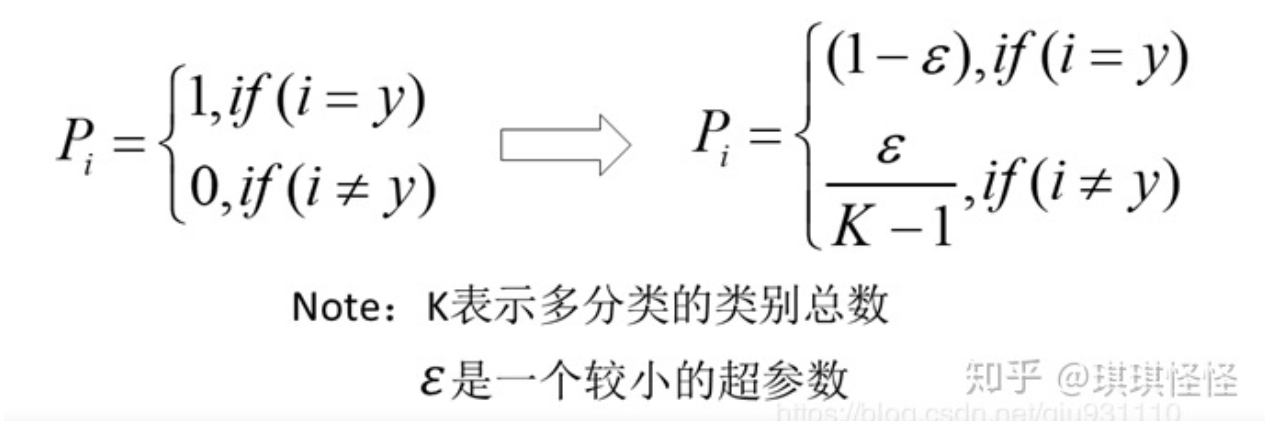

- 以上便为从onehot编码到标签偏移的公式。可以清楚的看到做完这种变化之后把原来onehot为0的地方变大了,为1的地方变小了,这样就导致在算交叉熵的时候不会只考虑相应类别的那个预测对应的损失,此时会把对所有类别的预测都会考虑进来算损失,使得对所有类别的预测都会相应的变大,只不过经过smoothing之后真实类别的那部分权重更大,模型会更加侧重于对应真实类别的那个预测。

- 避免模型对于正确标签过于自信,使得预测正负样本的输出值差别不那么大,从而避免过拟合,提高模型的泛化能力

- 超参数一般设置为0.1

代码实现(pytorch)

def label_smooth(label, n_class=3,alpha=0.1): """ 标签平滑 :param label: 真实lable :param n_class: 类别数目 :param alpha: 平滑系数 :return: """ k = alpha / (n_class - 1) # temp [batch_size,n_class] temp = torch.full((label.shape[0], n_class), k) # scatter_.(int dim, Tensor index, Tensor src),这个函数比较难理解——用src张量根据dim和index来修改temp中的元素 temp = temp.scatter_(1, label.unsqueeze(1), (1-alpha)) return temp

本文来自博客园,作者:SXQ-BLOG,转载请注明原文链接:https://www.cnblogs.com/sxq-blog/p/16716290.html

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· winform 绘制太阳,地球,月球 运作规律

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 上周热点回顾(3.3-3.9)

· 超详细:普通电脑也行Windows部署deepseek R1训练数据并当服务器共享给他人