《深入理解Spark-核心思想与源码分析》(一)总体规划和第一章环境准备

《深入理解Spark 核心思想与源码分析》 耿嘉安著

本书共计486页,计划每天读书20页,计划25天完成。

2018-12-20 1-20页

凡事豫则立,不豫则废;言前定,则不跲;事前定,则不困。

——《礼记.中庸》

第一章:

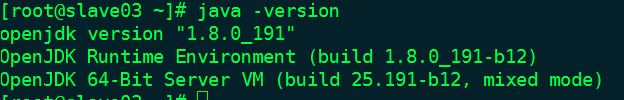

1、运行环境,安装JDK。

2、运行环境,安装scala。

wget http://downloads.typesafe.com/scala/2.10.4/scala-2.10.4.tgz

安装版本2.10.4

chmod 775 scala-2.10.4.tgz

tar -xzvf scala-2.10.4.tgz

cd ~

vim .bash_profile

export SCALA_HOME=/home/hyshf/scala-2.10.4

export PATH=$PATH:$SCALA_HOME/bin

重启客户端。输入scala

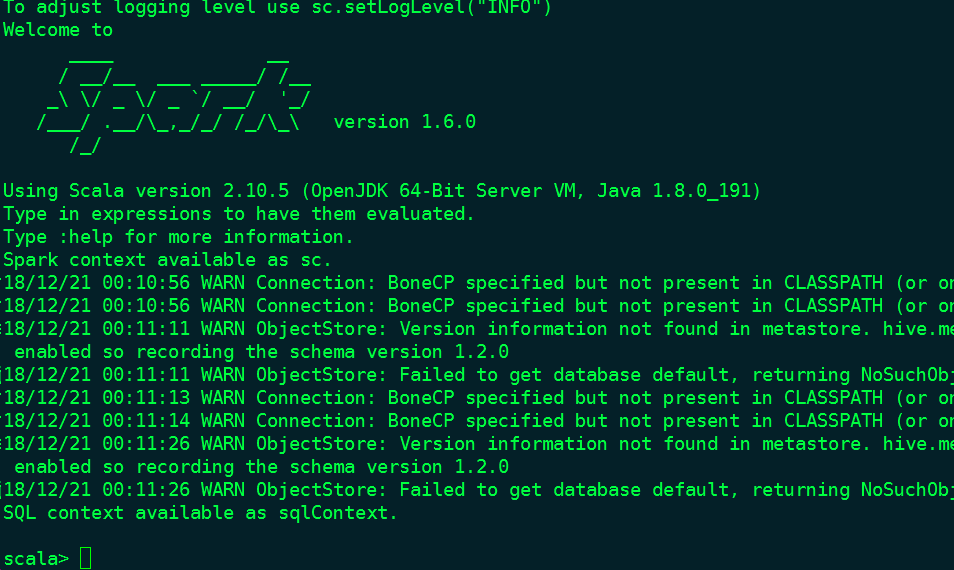

3、安装Spark。

wget http://archive.apache.org/dist/spark/spark-1.6.0/spark-1.6.0-bin-hadoop2.6.tgz

chmod 775 spark-1.6.0-bin-hadoop2.6.tgz

tar -xzvf spark-1.6.0-bin-hadoop2.6.tgz

在添加配置:

cd ~

vim .bash_profile

export SPARK_HOME=/home/hyshf/spark-1.6.0-bin-hadoop2.6

需要再进入Spark做设置

export SPARK_MASTER_IP=127.0.0.1

export SPARK_LOCAL_IP=127.0.0.1

进入目录./spark-shell

1.2.2 执行word-count

scala> val lines=sc.textFile("../README.md",2)

scala> val words=lines.flatMap(line=>line.split(""))

scala> val ones=words.map(w=>(w,1))

val counts=ones.reduceByKey(_+_)

counts.foreach(println)

1.3 阅读环境准备

1.4 Spark源代码编译与调试