sc.textfile 读hdfs130M文件为什么是2个分区的问题?

一个application有多个job(一个行动算子触发一个job);

每个job在发生shuffle(比如:reduceByKey)时,就会被拆成一个stage;

每个stage被拆为多个task,task被分配到executor上执行,一个task会有一个线程去执行,一个task处理一小片数据。

reduceByKey,前为stage0,后为stage1 :

stage0执行到reduceByKey时,会为后面stage1的每个task,都创建一个文件;

stage1的每个task,会在各个节点上的各个task创建的属于自己的文件(每个文件里,一定存放相同key对应的values; 但一个文件可能有多个key,及其对应的values; 相同key的values一定是进入同一个文件),拉取数据;

stage1的每个task所拉取到的数据,一定是相同key对应的数据。因为针对相同key对应的values,才能去执行执行自定义的function操作(+)。

spark并行度:指的就是spark作业中,各个stage的task数量。也就代表了spark作业在各个阶段(stage)的并行度。

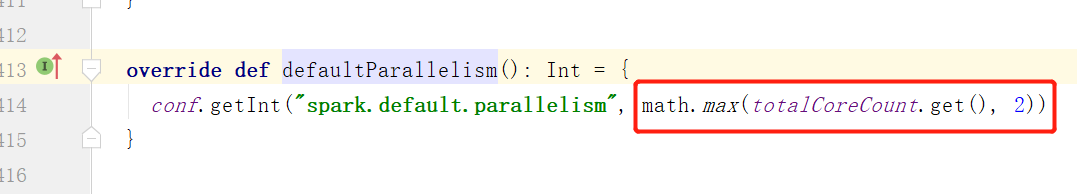

文件数计算的分区数如果大于2则取Min

那如果文件数小于2的话会走 求得最大即为2,所以当分区数是1时为了保证至少要两个

求得最大即为2,所以当分区数是1时为了保证至少要两个

浙公网安备 33010602011771号

浙公网安备 33010602011771号