介绍与安装

Kafka是分布式发布-订阅消息系统,最初由LinkedIn公司开发,之后成为之后成为Apache基金会的一部分,由Scala和Java编写。Kafka是一种快速、可扩展的、设计内在就是分布式的,分区的和可复制的提交日志服务。

它与传统系统相比,有以下不同:

- 它被设计为一个分布式系统,易于向外扩展;

- 它同时为发布和订阅提供高吞吐量;

- 它支持多订阅者,当失败时能自动平衡消费者;

- 它将消息持久化到磁盘,因此可用于批量消费,例如ETL,以及实时应用程序。

基础概念

- Broker:Kafka集群包含一个或多个服务器,这些服务器就是Broker

- Topic:每条发布到Kafka集群的消息都必须有一个Topic

- Partition:是物理概念上的分区,为了提供系统吞吐率,在物理上每个Topic会分成一个或多个Partition,每个Partition对应一个文件夹

- Producer:消息产生者,负责生产消息并发送到Kafka Broker

- Consumer:消息消费者,向kafka broker读取消息并处理的客户端。

- Consumer Group:每个Consumer属于一个特定的组,组可以用来实现一条消息被组内多个成员消费等功能。

安装kakfka

从官网下载Kafka安装包,解压安装,或直接使用命令下载。

wget http://mirror.bit.edu.cn/apache/kafka/1.0.0/kafka_2.11-1.0.0.tgz

解压安装

tar -zvxf kafka_2.11-1.0.0.tgz -C /usr/local/ cd /usr/local/kafka_2.11-1.0.0/

修改配置文件

vim config/server.properties 修改其中 broker.id=1 log.dirs=data/kafka-logs

功能验证

启动zookeeper

使用安装包中的脚本启动单节点Zookeeper实例:

./bin/zookeeper-server-start.sh -daemon config/zookeeper.properties

启动Kafka服务

使用kafka-server-start.sh启动kafka服务:

./bin/kafka-server-start.sh config/server.properties

创建Topic

使用kafka-topics.sh 创建但分区单副本的topic test

./bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic test

查看Topic

./bin/kafka-topics.sh --list --zookeeper localhost:2181

[root@localhost kafka_2.11-1.0.0]# ./bin/kafka-topics.sh --list --zookeeper localhost:2181 Picked up _JAVA_OPTIONS: -Xms512m -Xmx512m -Xmn126m test

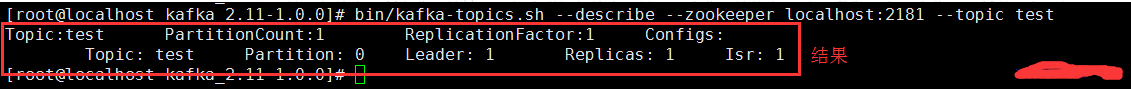

--describe

[root@localhost kafka_2.11-1.0.0]# ./bin/kafka-topics.sh --describe --zookeeper localhost:2181

Picked up _JAVA_OPTIONS: -Xms512m -Xmx512m -Xmn126m

Topic:test PartitionCount:1 ReplicationFactor:1 Configs:

Topic: test Partition: 0 Leader: 1 Replicas: 1 Isr: 1

Topic:test2 PartitionCount:3 ReplicationFactor:1 Configs:

Topic: test2 Partition: 0 Leader: 1 Replicas: 1 Isr: 1

Topic: test2 Partition: 1 Leader: 1 Replicas: 1 Isr: 1

Topic: test2 Partition: 2 Leader: 1 Replicas: 1 Isr: 1

产生消息

使用kafka-console-producer.sh 发送消息

./bin/kafka-console-producer.sh --broker-list localhost:9092 --topic test

消费消息

使用kafka-console-consumer.sh 接收消息并在终端打印

./bin/kafka-console-consumer.sh --zookeeper localhost:2181 --topic test --from-beginning

[root@localhost kafka_2.11-1.0.0]# bin/kafka-console-producer.sh --broker-list localhost:9092 --topic test Picked up _JAVA_OPTIONS: -Xms512m -Xmx512m -Xmn126m >1 >2 >kafka > ----------------------------------------------------------------------------------- [root@localhost kafka_2.11-1.0.0]# ./bin/kafka-console-consumer.sh --zookeeper localhost:2181 --topic test --from-beginning Picked up _JAVA_OPTIONS: -Xms512m -Xmx512m -Xmn126m Using the ConsoleConsumer with old consumer is deprecated and will be removed in a future major release. Consider using the new consumer by passing

[bootstrap-server] instead of [zookeeper]. 1 2 kafka

删除Topic

bin/kafka-topics.sh --delete --zookeeper localhost:2181 --topic test

查看描述 Topic 信息

./bin/kafka-topics.sh --describe --zookeeper localhost:2181 --topic test

第一行给出了所有分区的摘要,每个附加行给出了关于一个分区的信息。 由于我们只有一个分区,所以只有一行。

“Leader”: 是负责给定分区的所有读取和写入的节点。 每个节点将成为分区随机选择部分的领导者。

“Replicas”: 是复制此分区日志的节点列表,无论它们是否是领导者,或者即使他们当前处于活动状态。

“Isr”: 是一组“同步”副本。这是复制品列表的子集,当前活着并被引导到领导者。

集群配置

Kafka支持两种模式的集群搭建:

- 单机多broker集群配置;

- 多机多broker集群配置。

单机多breoker

利用单节点部署多个broker。不同的broker不同的id,监听端口以及日志目录,如:

- 将配置文件复制两份

cp config/server.properties config/server-1.properties cp config/server.properties config/server-2.properties

- 修改配置文件信息

vim config/server-1.properties #修改内容 broker.id=2 listeners=PLAINTEXT://your.host.name:9093 log.dirs=/data/kafka-logs-1

- 启动多个kafka服务

in/kafka-server-start.sh config/server-1.properties bin/kafka-server-start.sh config/server-2.properties

- 最后按照上面方法产生和消费信息。

多机多broker

分别在多个节点按上述方式安装Kafka,配置启动多个Zookeeper 实例。如:192.168.18.130、192.168.18.131、192.168.18.132三台机器

分别配置多个机器上的Kafka服务 设置不同的broke id,zookeeper.connect设置如下:

zookeeper.connect=192.168.18.130:2181,192.168.18.131:2181,192.168.18.132:218

安装php扩展:

安装lib库

git clone https://github.com/edenhill/librdkafka.git ./configure make sudo make install

安装rdkafka

git clone https://github.com/arnaud-lb/php-rdkafka.git cd php-rdkafka phpize ./configure make all -j 5 sudo make install 此时会在/usr/lib/php/extensions/debug-non-zts-20151012/目录下有rdkafka.so文件 将extension=rdkafka.so增加在php.ini文件中

或者:

下载地址:https://github.com/edenhill/librdkafka

wget https://github.com/edenhill/librdkafka/archive/v0.9.4.tar.gz -O librdkafka-0.9.4.tar.gz tar -zxvf librdkafka-0.9.4.tar.gz cd librdkafka-0.9.4 yum install gcc-c++ ./configure make make install

安装php-rdkafka

下载地址:https://github.com/arnaud-lb/php-rdkafka

wget https://github.com/arnaud-lb/php-rdkafka/archive/3.0.1.tar.gz -O php-rdkafka-3.0.1.tar.gz tar -zxvf php-rdkafka-3.0.1.tar.gz cd php-rdkafka-3.0.1 phpize ./configure --with-php-config=php-config make make install

或者:

$ cd ~/download $ wget -c https://github.com/edenhill/librdkafka/archive/v0.11.0.tar.gz $ tar xvzf v0.11.0.tar.gz $ yum -y install zlib zlib-devel openssl openssl-devel cyrus-sasl2 cyrus-sasl-devel $ ./configure $ make $ sudo make install

$ cd ~/download # 下载扩展源代码 $ wget -c https://github.com/arnaud-lb/php-rdkafka/archive/3.0.4.tar.gz # 解压 $ tar xvzf 3.0.4.tar.gz $ cd php-rdkafka-3.0.4 # 编译 $ /usr/local/php/bin/phpize ./configure --with-php-config=/usr/local/php/bin/php-config --with-rdkafka # 安装 $ make all -j 5 $ make install

本文来自博客园,作者:孙龙-程序员,转载请注明原文链接:https://www.cnblogs.com/sunlong88/articles/9747627.html

浙公网安备 33010602011771号

浙公网安备 33010602011771号