tensorflow学习005——多层感知器(神经网络)与激活函数

之前学习的线性回归模型其实是单个神经元:计算输入特征的加权和,然后使用一个激活函数计算输出。上面的线性回归实际并没有涉及激活函数,直接将结果输出了。

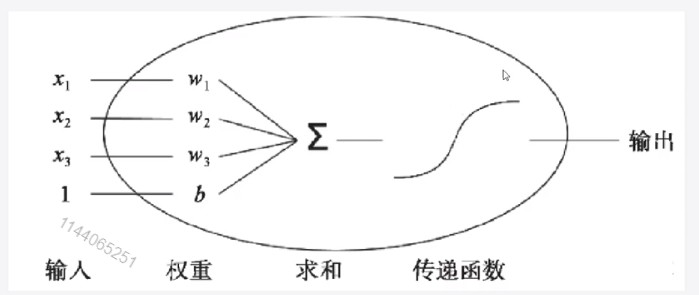

单个神经元进行二分类,如图2-5所示

图2-5

x1,x2,x3是一个数据的输入,w1,w2,w3是权重,b是偏置,最后输出以恶搞分类结果

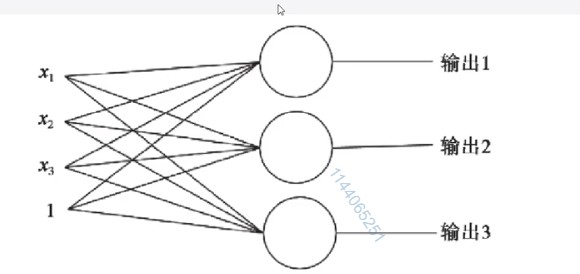

多个神经元进行多酚类,如图2-6所示

图2-6

上面这两种都是属于单层网络,其缺陷是无法拟合“异或”运算。

神经元要求数据必须是线性可分的

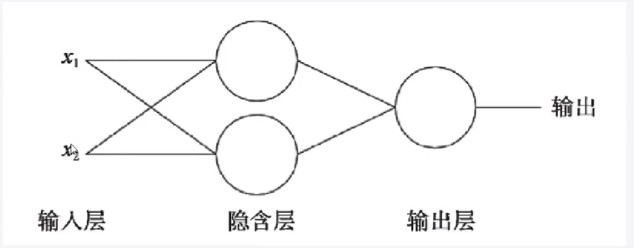

生物的神经元一层一层连接起来,当神经信号达到某一个条件,这个神经元就会激活,然后继续传递信息下取。为了继续使用神经网络解决这种不具备线性可分性的问题,采取在神经网络的输入端和输出端之间插入更多的神经元,如图2-7所示。

图2-7

激活函数就是将线性转化为非线性

常见的激活函数

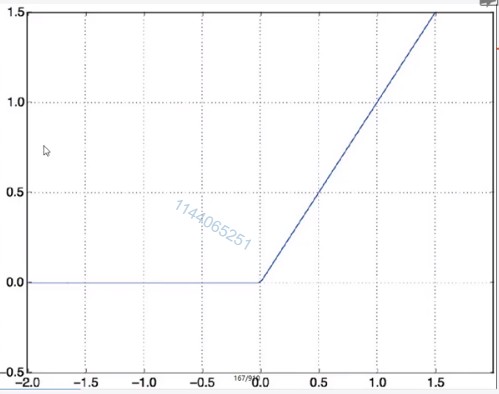

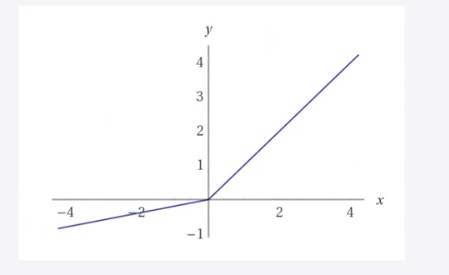

1:Relu() 如图2-8所示。是Relu()激活函数,当x小于0,结果为0;当x大于0,原样输出

图2-8

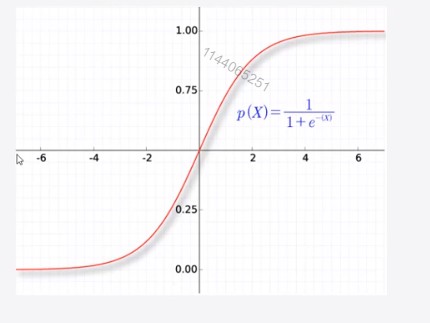

2:sigmoid将结果限制在了0到1之间,很少用于中间层。

图2-9

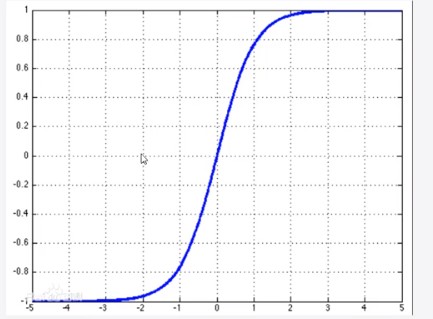

3:tanh激活函数,输出范围在-1到1之间。

图2-10

4:Leak relu

图2-11

作者:孙建钊

出处:http://www.cnblogs.com/sunjianzhao/

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文连接,否则保留追究法律责任的权利。