循环神经网络 (Recurrent Neural Network, RNN)

1 RNN forward and backword Propagation

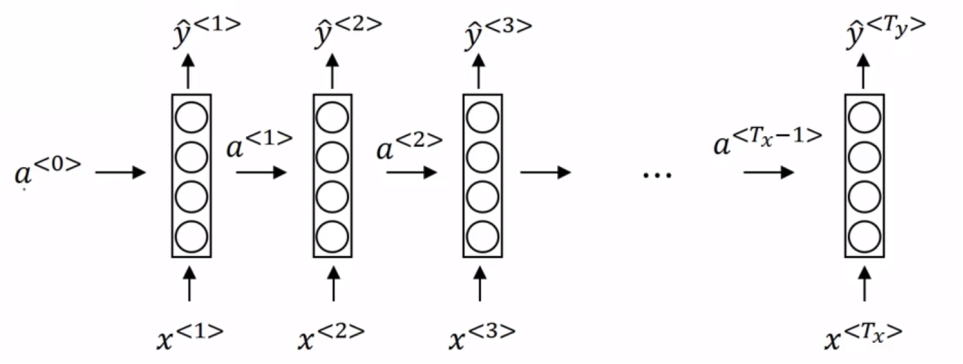

RNN 中,每个时间步的输出都会利用到当前时间步的输入和上一个时间步输出的激活值。每个时间步中的参数是共享的。

可以看出输出值 y3 与输入值 x1、x2、x3 都有关。

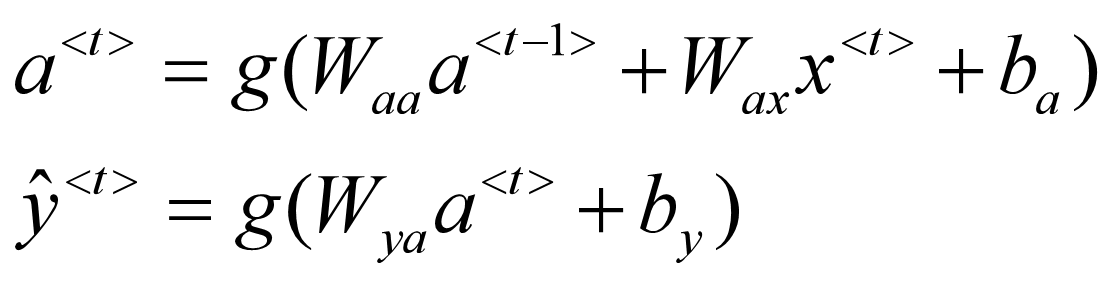

其中 a0=0,函数 g 一般是 tanh、Relu、Sigmoid、softmax 等激活函数。还可以简写为:

Wa、ba、Wy、by 都是共享的参数。

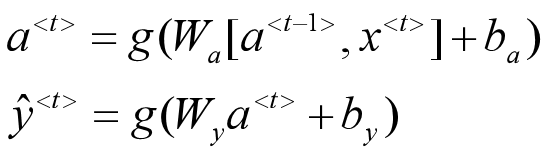

损失函数:

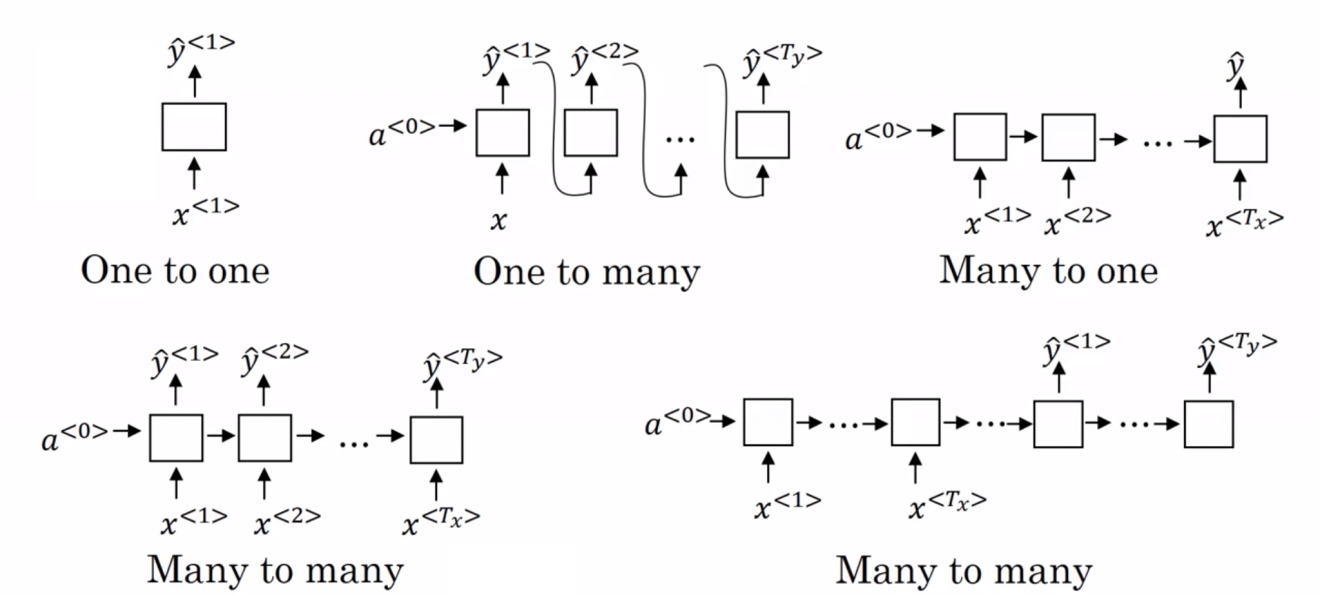

2. Examples of RNN architectures

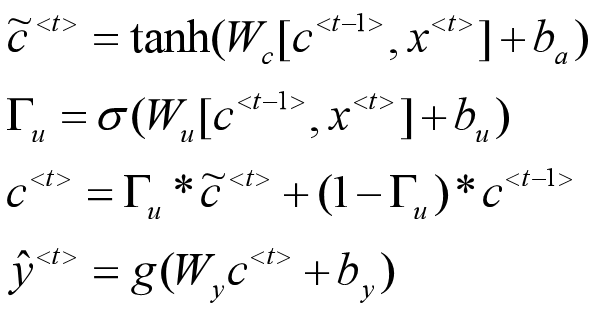

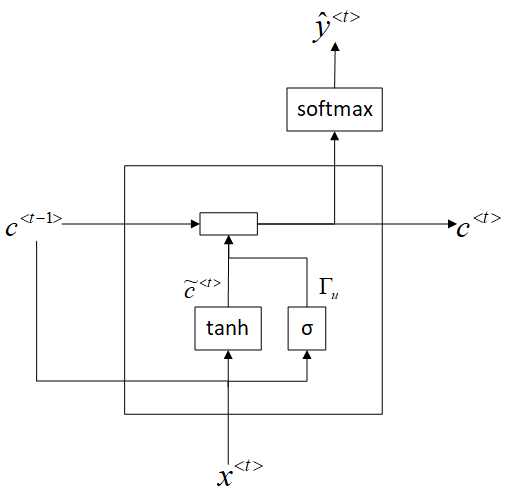

3. GRU (Gated Recurrent Unit)

用一个门来控制 ct 的更新

Γu=0 时,c(t)=c(t-1),前面的值就被保留下来了,寻找更长时间的依赖,可以解决梯度消失的问题。

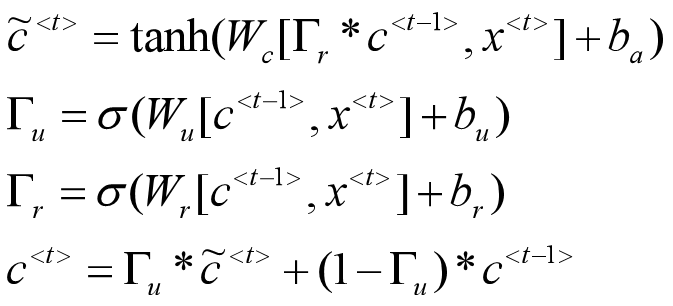

Full GRU:

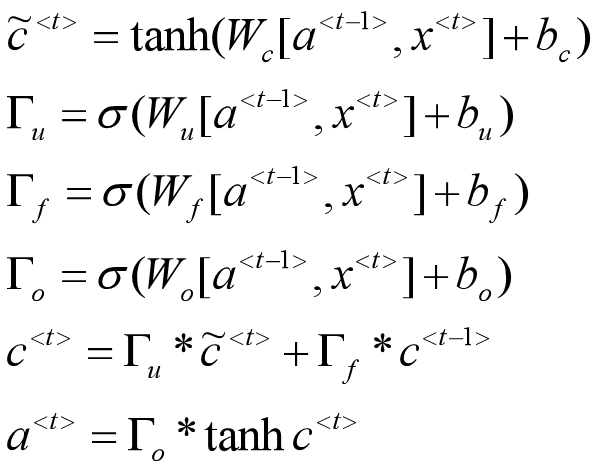

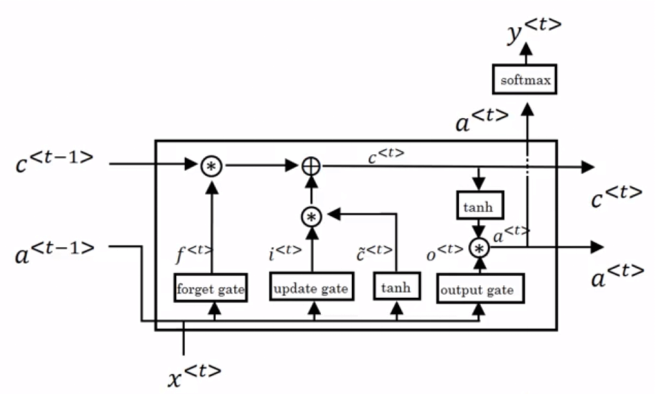

4. LSTM (Long short term memory) unit

浙公网安备 33010602011771号

浙公网安备 33010602011771号