tensorflow疑问总结

1.sigmoid 函数为什么不好?

(1)激活函数计算量大(在正向传播和反向传播中都包含幂运算和除法)

(2)反向传播求误差梯度时,求导涉及除法

(3)Sigmoid倒数取值范围是[0,0.25],由于神经网络反向传播时‘链式反应’,很容易出现梯度消失的情况

(4)Sigmoid的输出不是0均值,这会导致后一层神经元将会得到上一层输出的非0均值的信号作为输入,随着网络的加深,会改变数据的原始分布

2.Relu函数的优势?

不会出现梯度消失

3.上采样,下采样是什么?

上采样就是放大图像,常用方法是内插值(传统插值,基于边缘的插值,基于区域的图像插值算法),下采样就是缩小图像。

4.激活函数定义?

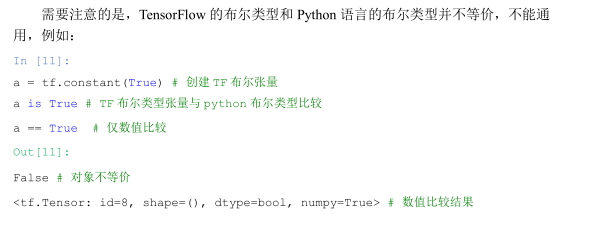

5.tensorflow的布尔类型和python的布尔类型不等阶,不能通用

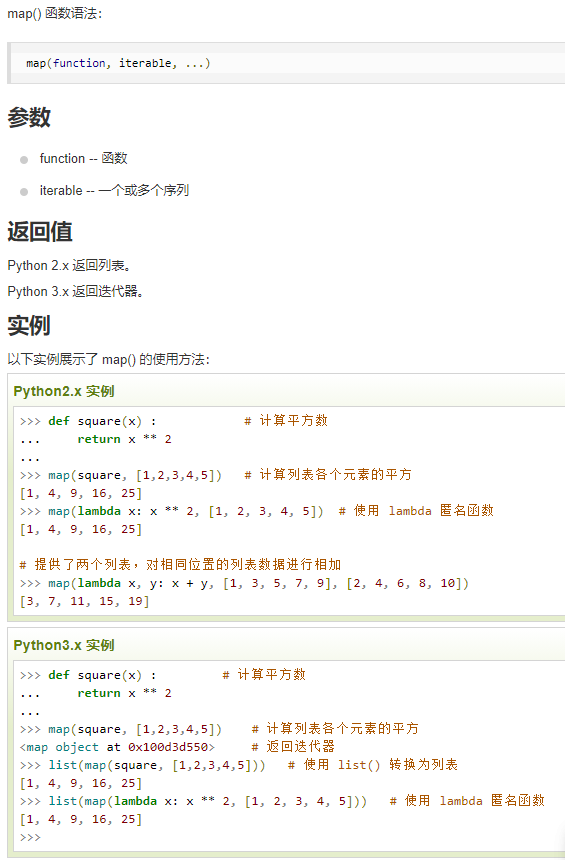

6. map()用法

7.round()用法

round(x,[,n])

x--数值表达式

n--数值表达式,表示小数点位数

返回值是浮点数x的四舍五入

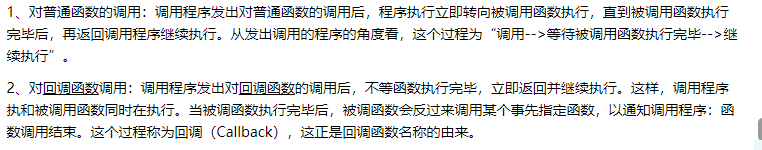

8.回调函数和普通函数有什么区别

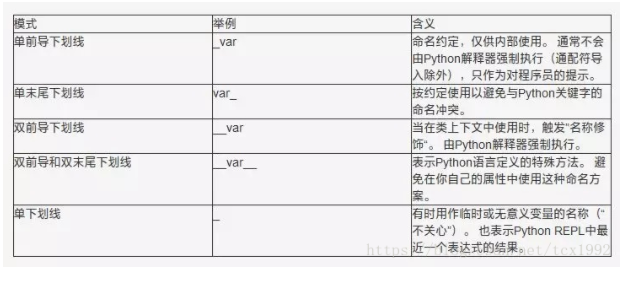

9. Python下划线区别

-----------------参考菜鸟驿站

浙公网安备 33010602011771号

浙公网安备 33010602011771号