算法金 | 读者问了个关于深度学习卷积神经网络(CNN)核心概念的问题

大侠幸会,在下全网同名[算法金] 0 基础转 AI 上岸,多个算法赛 Top [日更万日,让更多人享受智能乐趣]

读者问了个关于卷积神经网络核心概念的问题,如下,

【问】神经元、权重、激活函数、参数、图片尺寸,卷积层、卷积核,特征图,平均池化,全家平均池化,全连接层、隐藏层,输出层 【完整问题】神经元、权重、激活函数、参数、图片尺寸,卷积层、卷积核,特征图平均池化,全家平均池化,全连接层、隐藏层,输出层,这一堆的概念,他们之间分别由什么关联和区别,啊啊啊我嘎了~

很好的问题,搞清楚概念很重要

嘎同学,一路走好~

1. 基本构件

1.1 神经元

神经元是神经网络中的基本处理单元,模拟生物神经元的功能。它接收输入,进行加权求和,然后通过一个激活函数生成输出。

1.2 权重

权重是连接神经元的参数,决定了输入信号的重要性和贡献。在训练过程中,通过优化算法调整权重,以最小化预测误差。

1.3 激活函数

激活函数决定了神经元输出的形式。常用的激活函数包括 ReLU、Sigmoid 和 Tanh。它们非线性化输入信号,帮助网络学习复杂模式。

1.4 参数

参数通常指网络中的权重和偏置,是学习过程中需要优化的部分。

2. 网络结构

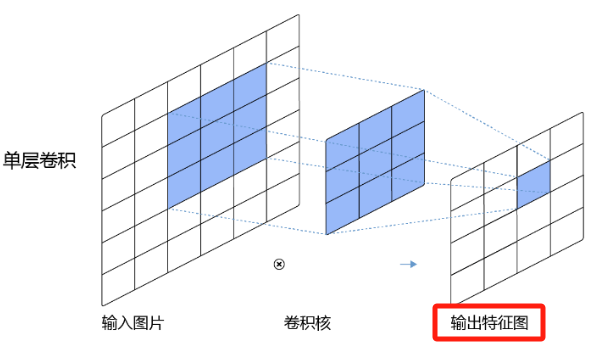

2.1 卷积层

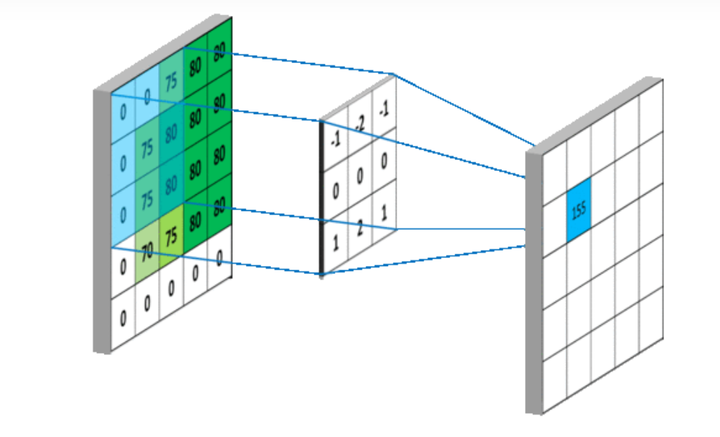

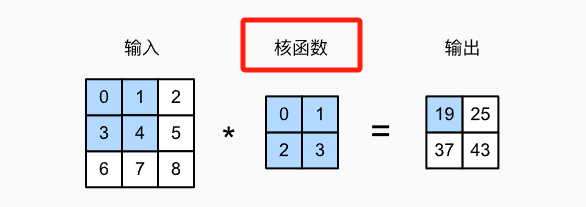

卷积层用于处理像图片这样的空间数据。它通过卷积核在输入数据上滑动,提取特征,生成特征图。

2.2 卷积核

卷积核是卷积层中的一组权重,用于检测图像中的局部特征,如边缘或纹理。

2.3 特征图

特征图是卷积核应用于输入数据后的输出,表示了输入中的某些特定特征。

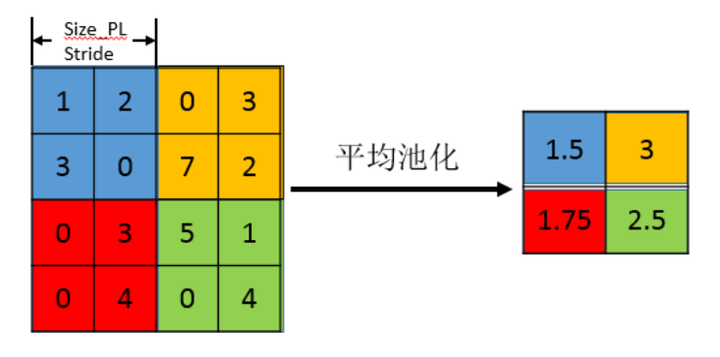

2.4 平均池化(Average Pooling)

平均池化是一种降维操作,通过计算输入特征图中一定区域的平均值来减少数据的空间尺寸。

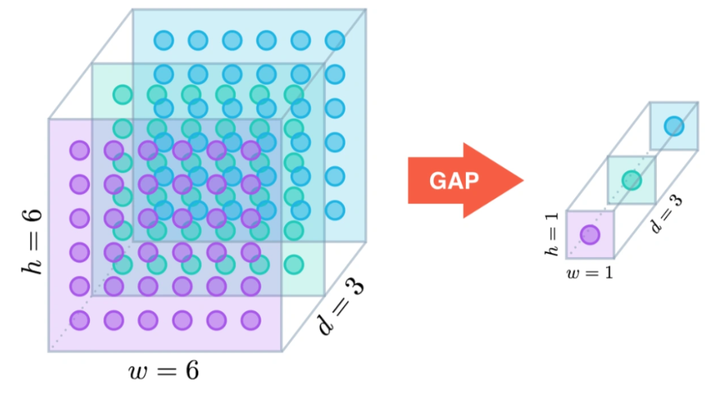

2.5 全局平均池化(Global Average Pooling)

全局平均池化是对整个特征图进行平均池化,每个特征图变为一个单一的数值。它常用于网络的末端,减少参数量,防止过拟合。

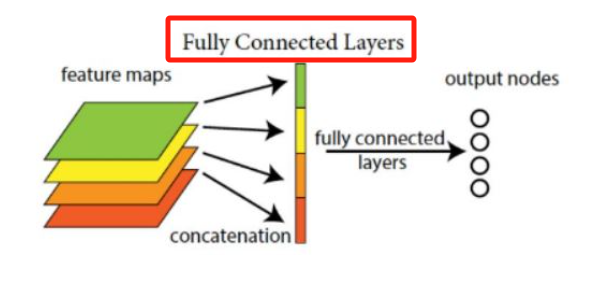

2.6 全连接层(Fully Connected Layer)

全连接层是传统神经网络中的层,其中每个输入节点都与每个输出节点连接。它通常用于学习特征组合。

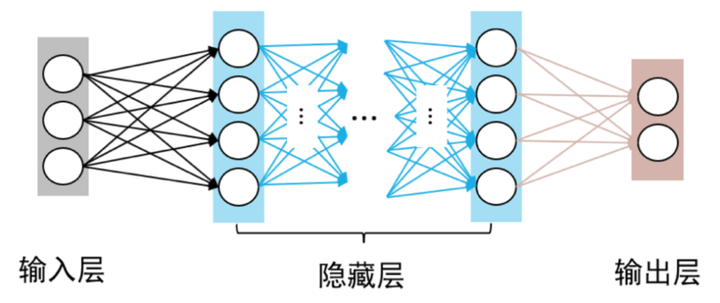

2.7 隐藏层

隐藏层位于输入层和输出层之间,其节点数和类型可以根据需要调整,用于提取越来越抽象的数据特征。

2.8 输出层

输出层是网络的最后一层,用于产生最终的预测结果。

3. 量化的联系和对比

- 神经元数量与网络的能力和复杂度相关。

- 权重数量直接影响训练的难度和过拟合的风险。

- 激活函数的选择影响网络的收敛速度和性能。

- 卷积核大小和步长决定特征图的尺寸。

- 池化层降低特征维度,增强模型的泛化能力。

- 全连接层参数数量通常最多,容易造成模型过大和过拟合。

通过调整这些概念的具体实现,可以设计出适合不同任务的神经网络架构。

4. 深入探讨

4.1 神经元和权重的作用

神经元通过权重将输入信号进行加权,再经过激活函数处理,输出新的信号。这个过程是模拟大脑中神经元的工作方式。权重的调整(即学习过程)是通过反向传播算法进行的,其核心是减小实际输出与期望输出之间的差异。

4.2 卷积层的设计思想

卷积层的设计是为了识别图像中的局部模式。与传统的全连接层相比,卷积层通过局部连接和权重共享大大减少了参数数量,提高了模型的空间不变性,使网络更适合处理图像等高维数据。

4.3 激活函数的选择

不同的激活函数对网络的学习能力和性能有显著影响。例如,ReLU(线性整流函数)由于其计算简单且减少梯度消失问题,成为隐藏层的首选。而Sigmoid和Tanh函数由于其输出范围(Sigmoid 是 [0,1],Tanh 是 [-1,1])和平滑的梯度特性,常用于输出层,特别是在分类和回归问题中。

4.4 参数量化与模型性能

在设计网络时,通常需要在参数数量(即模型复杂度)与计算效率、过拟合风险之间找到平衡。例如,更深或含有更多神经元的网络可能能更好地学习训练数据中的复杂模式,但同时也更容易过拟合,尤其是在数据量较小的情况下。

4.5 全连接层与卷积层的对比

全连接层和卷积层的主要区别在于连接模式和参数共享。全连接层中每个输入节点都与每个输出节点连接,没有参数共享,适合处理非空间(非图像)数据。卷积层通过局部连接和参数共享,适合捕捉空间和时序数据中的局部特征,如视频和图像。

[ 抱个拳,总个结 ]

通过这些基础概念的合理组合和设计,可以构建出适用于各种任务的神经网络模型。

每个组件都有其特定的功能和作用,精确的设计可以帮助模型更有效地学习和泛化。

在现代深度学习的发展中,理解这些概念的内在联系和差异是至关重要的,这有助于我们构建更加高效和强大的人工智能系统。

感谢嘎同学,这是用生命在学习啊。。。

全网同名,日更万日,让更多人享受智能乐趣

烦请大侠多多 分享、在看、点赞,助力算法金又猛又持久、很黄很 BL 的日更下去;我们一起,让更多人享受智能乐趣

同时邀请大侠 关注、星标 算法金,围观日更万日,助你功力大增、笑傲江湖

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】凌霞软件回馈社区,博客园 & 1Panel & Halo 联合会员上线

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】博客园社区专享云产品让利特惠,阿里云新客6.5折上折

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· CSnakes vs Python.NET:高效嵌入与灵活互通的跨语言方案对比

· 【.NET】调用本地 Deepseek 模型

· Plotly.NET 一个为 .NET 打造的强大开源交互式图表库

· 上周热点回顾(2.17-2.23)

· 如何使用 Uni-app 实现视频聊天(源码,支持安卓、iOS)