DPDK与SR-IOV应用场景及性能对比

DPDK与SR-IOV两者目前主要用于提高IDC(数据中心)中的网络数据包的加速。但是在NFV(网络功能虚拟化)场景下DPDK与SR-IOV各自的使用场景是怎样的?以及各自的优缺点?

本文主要通过从以下几点来阐述这个问题:

1、什么是DPDK?

2、什么是SR-IOV?

3、DPDK与SR-IOV有何不同?

4、DPDK与SR-IOV各自适合的应用场景是怎样的?

1、什么是DPDK?

DPDK(Data Plane Development Kit)是6Wind、Intel开发的一款高性能的数据平面开发工具包。为了方便理解DPDK我们先了解下Linux内核是如何处理网络数据包的。

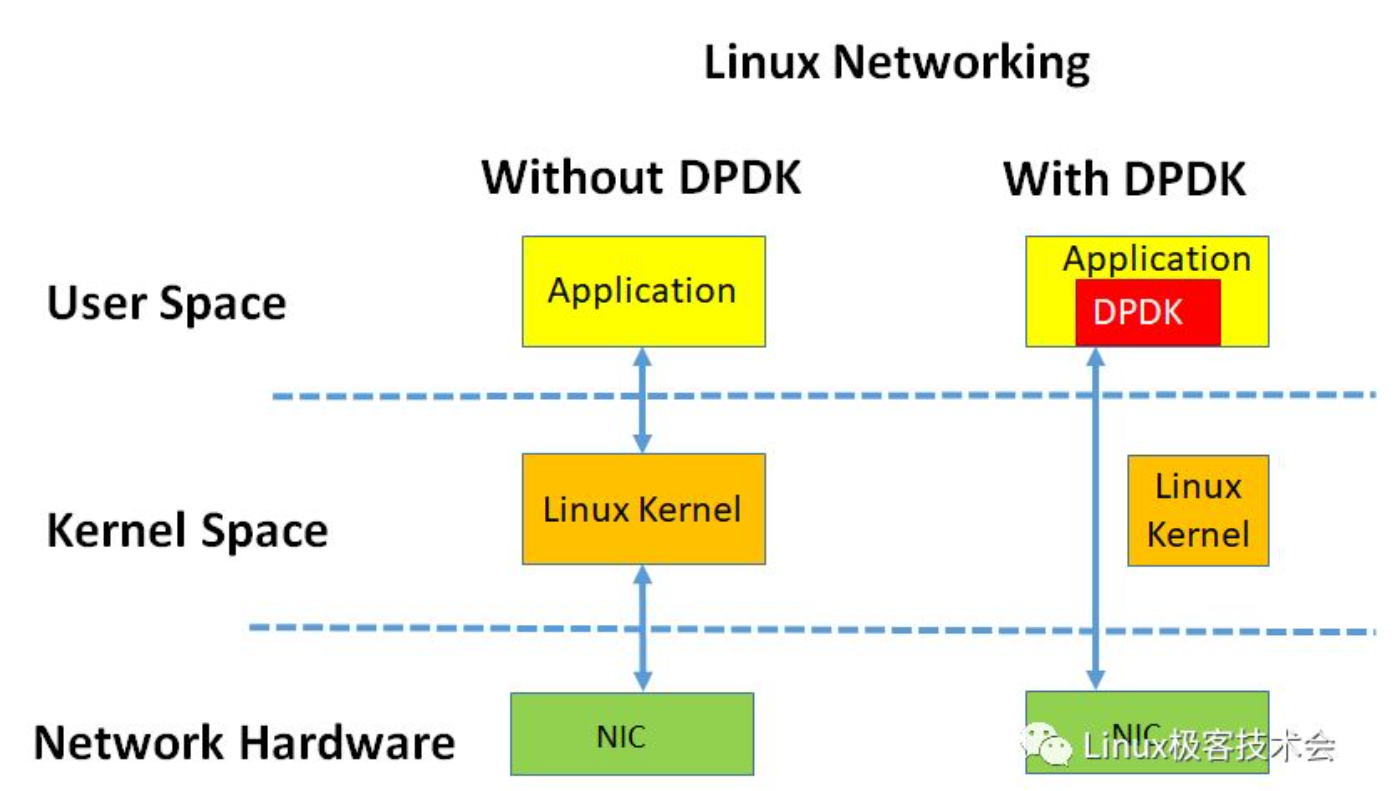

图1 左:Linux kernel 右:DPDK

默认情况下,Linux 使用内核来处理网络数据包,随着IDC(数据中心)NIC速率逐步从40G到目前主流的100G,未来将逐步替换为400G。Linux内核已经不再适合处理高速网络。

内核弊端:

1、中断处理:当网络中大量数据包到来时,会频繁产生中断请求,频繁的中断会产生较高的性能开销、并造成上下文的切换产生时延。

2、内存拷贝:网络数据包到来时,网卡通过 DMA 等拷贝到内核缓冲区,内核协议栈再从内核空间拷贝到用户态空间,在 Linux 内核协议栈中,这个耗时操作甚至占到了数据包整个处理流程的 57.1%。

3、局部性失效:目前主流处理器都是多个CPU核心的,这意味着一个数据包的处理可能跨多个 CPU 核心。比如:一个数据包可能中断在 cpu0,内核态处理在 cpu1,用户态处理在 cpu2,这样跨多个核心,容易造成 CPU 缓存失效,造成局部性失效。

从前面的分析得知目前网络IO的实现的方式中,内核是导致性能瓶颈的原因所在,要解决性能问题就需要绕过内核,直接在用户态收发包。

1、内核bypass:通过UIO(Userspace I/O)旁路数据包,实现用户态数据包收发,减少上下文切换以及内存拷贝。

2、使用多核编程代替多线程编程:设置 CPU 的亲和性,将线程和 CPU 核进行一比一绑定,减少彼此之间调度切换。

3、使用大页内存代替普通的内存:减少 cache-miss。

4、采用无锁技术:解决资源竞争问题。

2、带有OVS的DPDK

什么是OVS?

OVS(Open vSwitch)是一款高质量的开源虚拟交换机,运行在hypervisor中并为虚拟机提供虚拟网络。

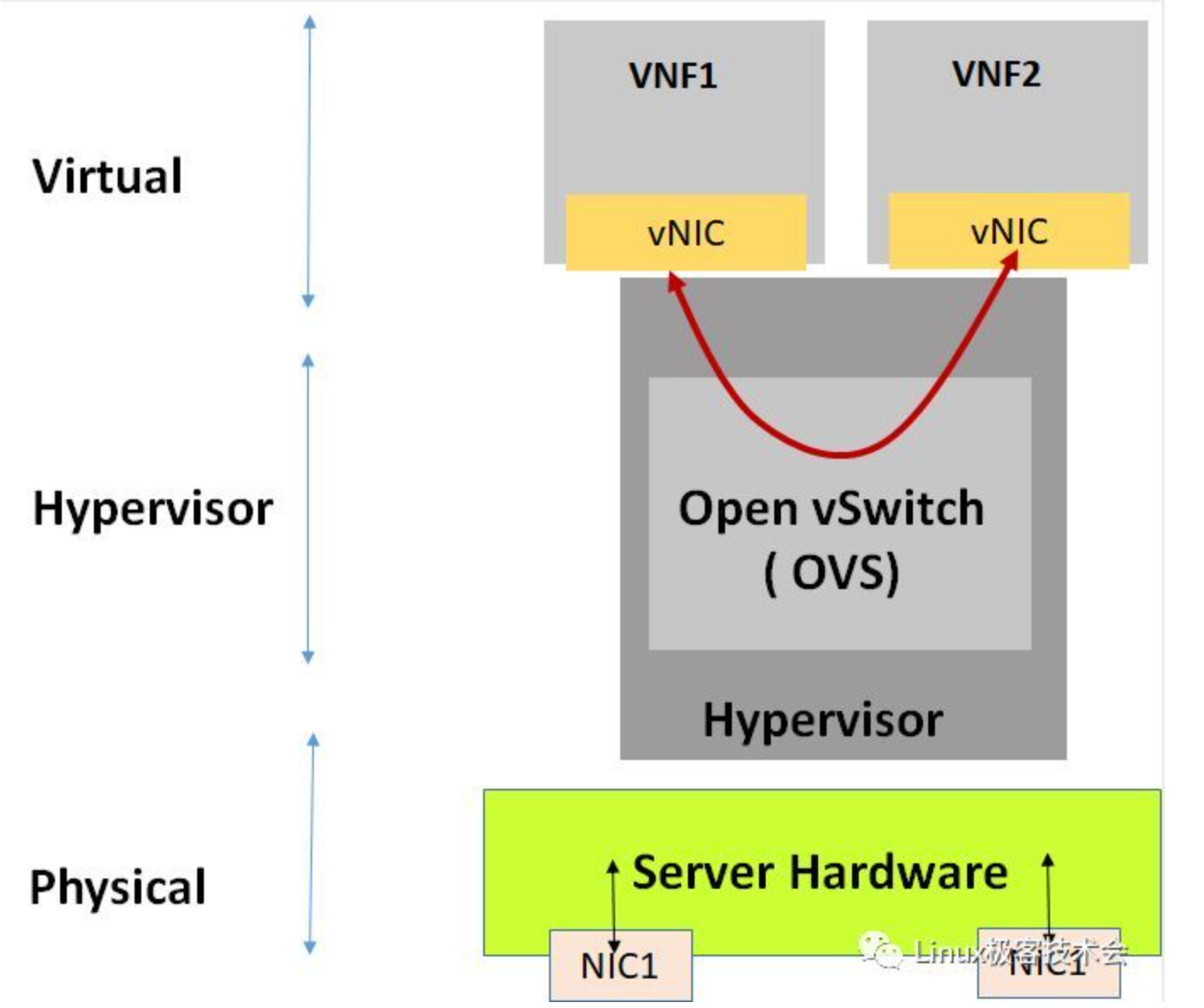

图2 NVF中OVS所处位置

OVS是实施VNF(Virtual Network Function)的一部分,位于hypervisor中,如图2所示流量可以从一个VNF通过OVS传递到另一个VNF中。

OVS 的转发平面是内核的一部分,无论OVS有多好,它都面临着与前面讨论的 Linux 网络协议栈相同的问题。

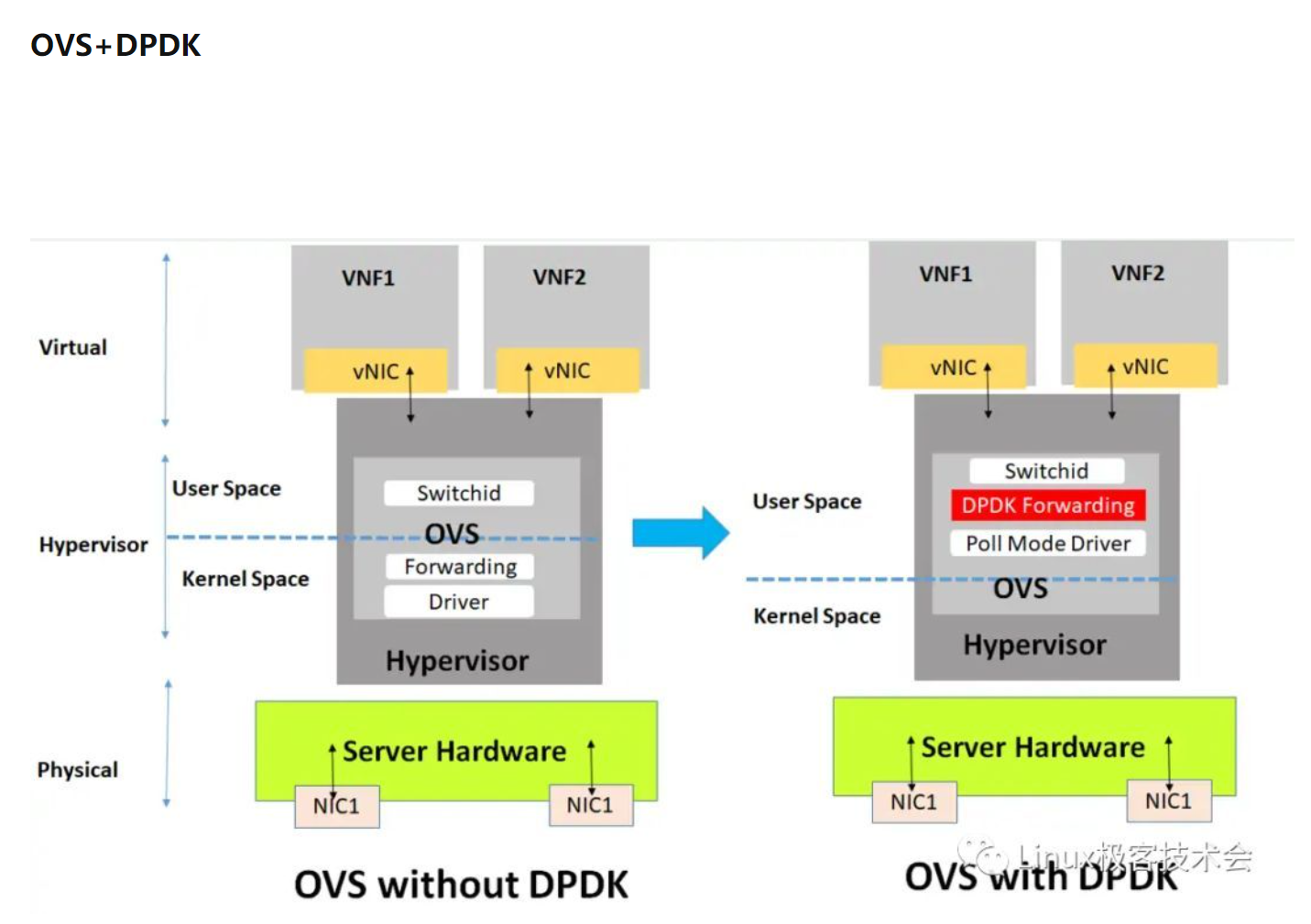

图3 左:Kernel+OVS 右:DPDK+OVS

如图3所示:基于 DPDK 的转发路径替换标准的 OVS 内核转发路径,在主机上创建一个用户空间 vSwitch,它完全运行在用户空间中从而提高了 OVS 交换机的性能。

3、SR-IOV

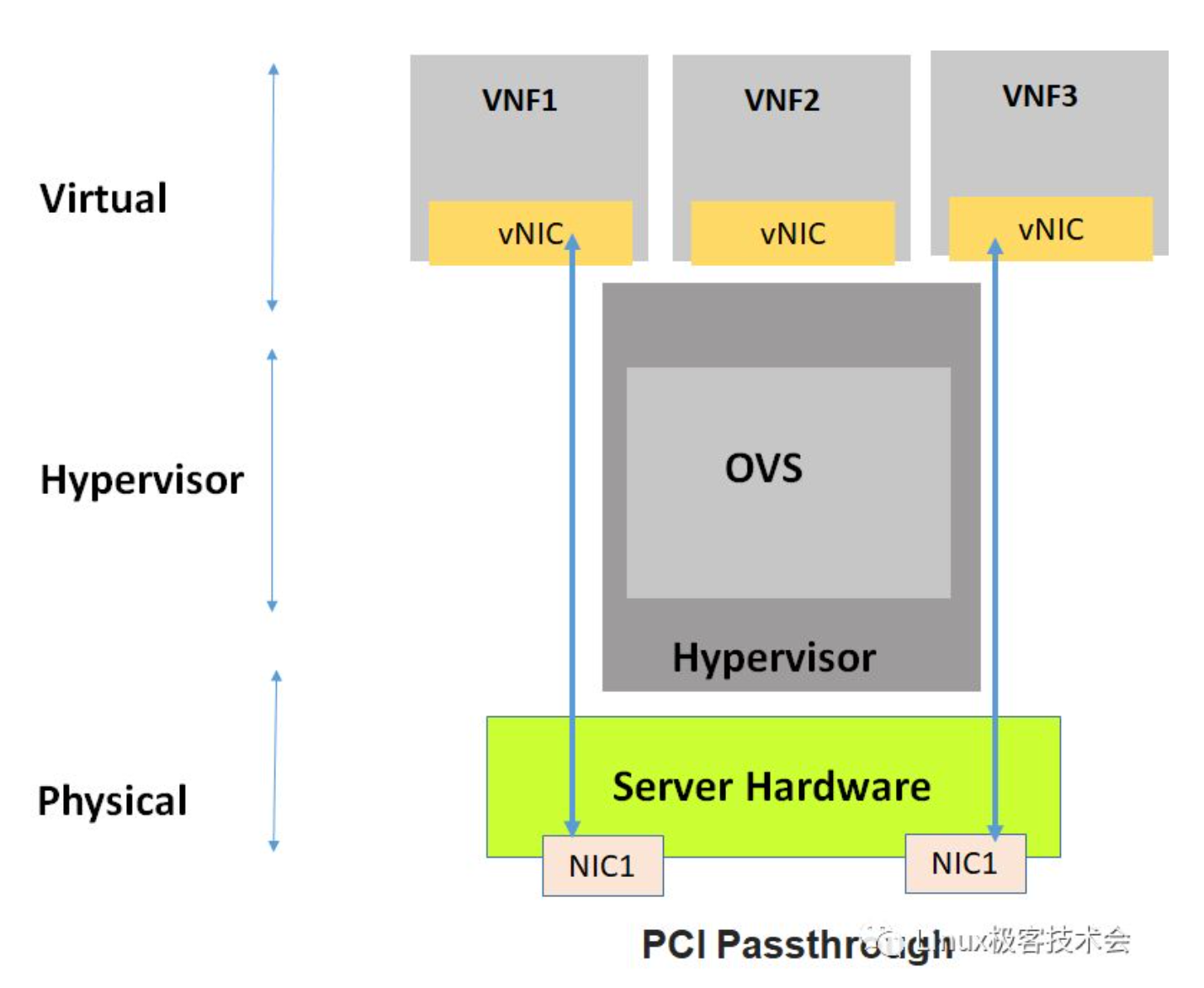

在讲述SR-IOV之前我们先讲述一下PCI直通技术。

什么是PCI直通?

PCI直通:不使用hypervisor也可以向虚拟机提供完整的网卡。虚拟机认为自己与网卡直接相连。如图4所示,有两个NIC卡和两个VNF,每个都独占访问其中一个NIC卡。

图4 网卡直通

PCI直通缺点:由于下面的两个网卡被VNF1和VNF3独占。并且没有第三个专用网卡分配给VNF2使用。

什么是SR-IOV?

SR-IOV(Single Root I/O Virtualization)规范:定义了一种用于虚拟化PCIe设备的机制。这种机制可以将单个PCIe以太网控制器虚拟化为多个PCIe设备

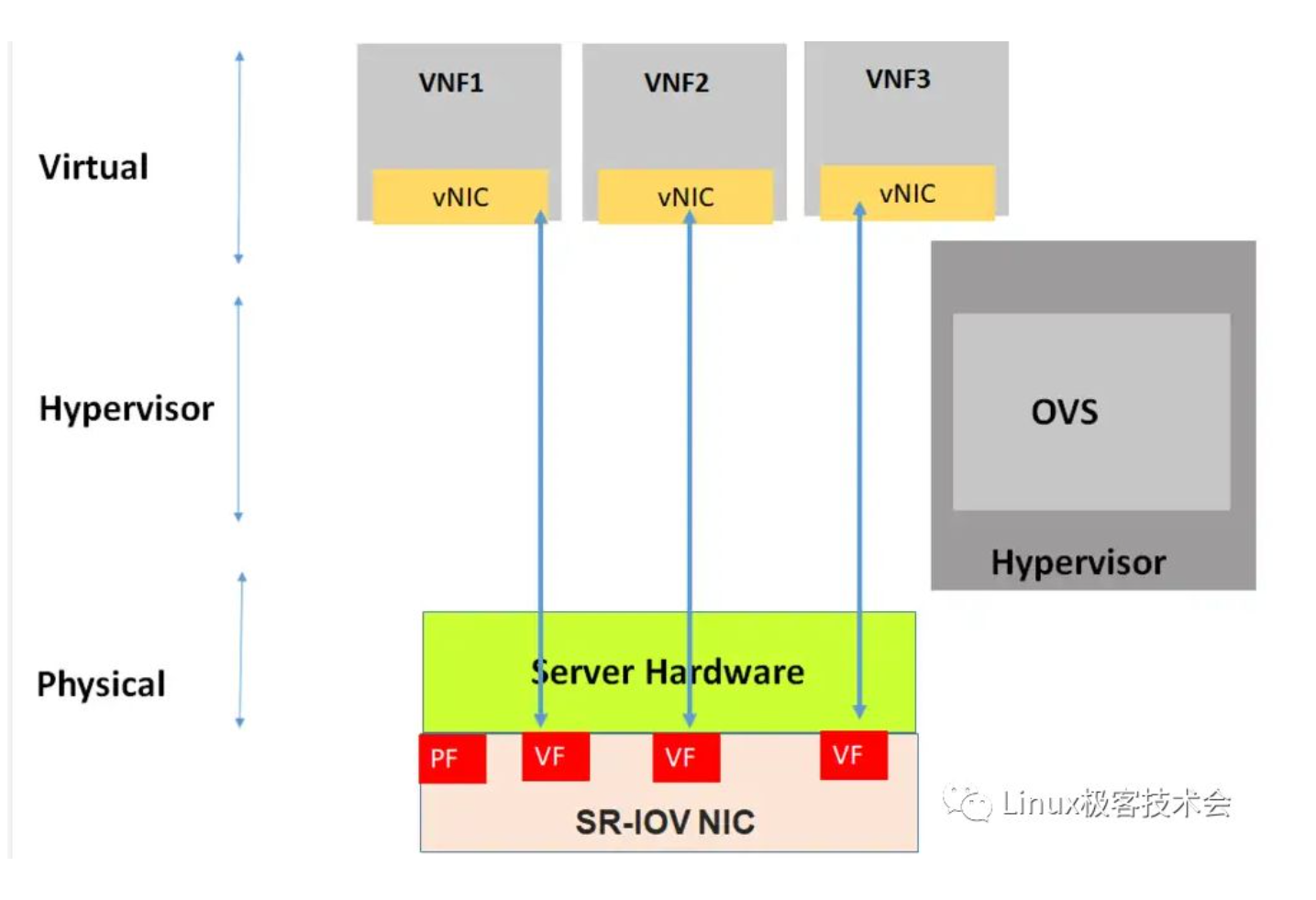

图5 SR-IOV

通过创建PCIe设备的VF,每个VF可以分配给单个VM/VNF,从而消除由于网卡不够的问题。

4、DPDK vs SR-IOV

数据中心中存在东西向流量与南北向流量。

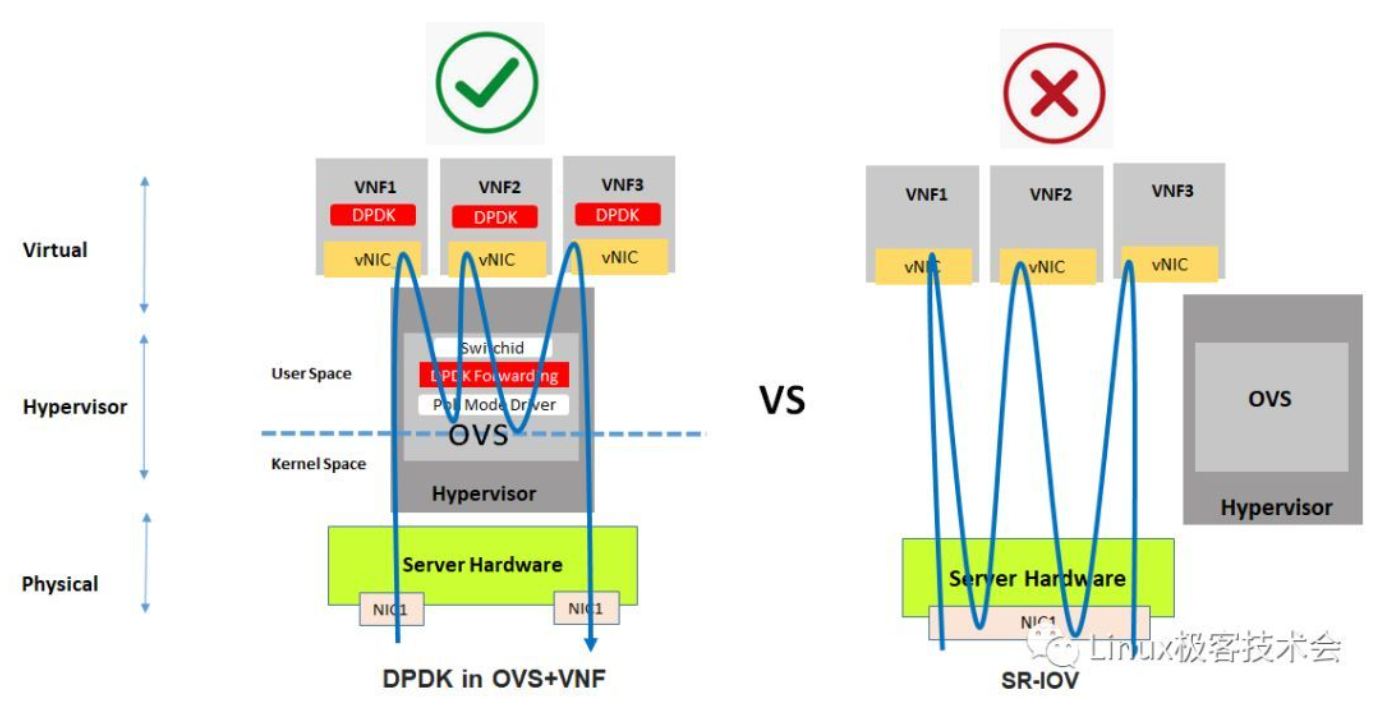

图6

在同一个服务器内的东西向流量,DPDK性能优于SR-IOV。这很容易理解:如果流量是在服务器内部路由/交换的,而不是到NIC。SR-IOV没有任何优势。相反,SR-IOV会成为一个瓶颈(流量路径会变长,网卡资源会被占用)。

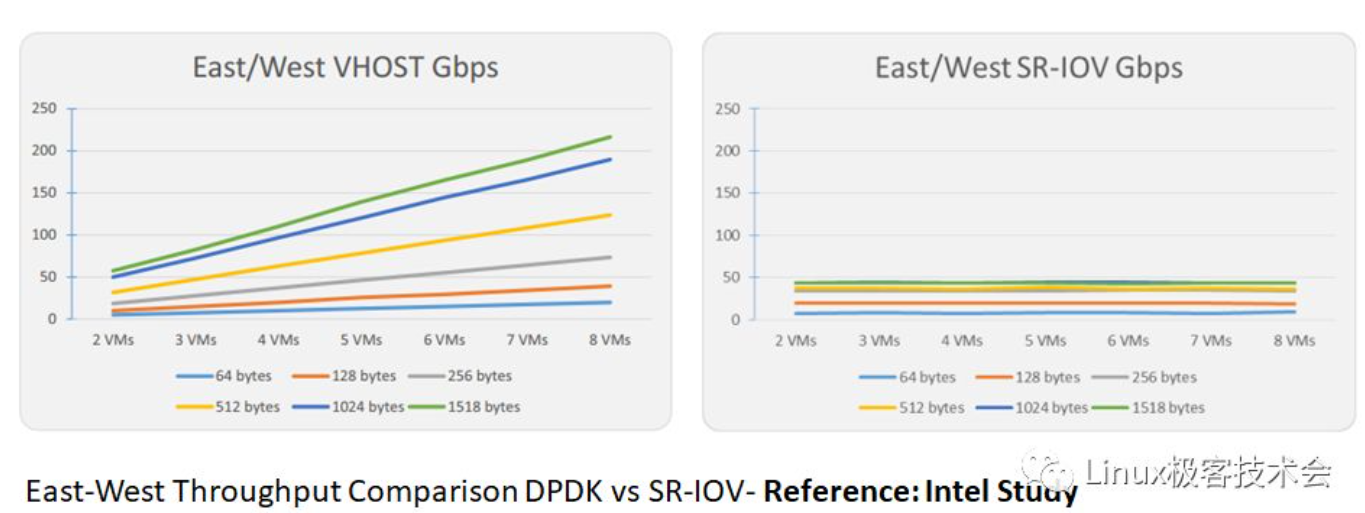

图7为Intel官方给出东西向流量场景下DPDK与SR-IOV的性能测试数据。

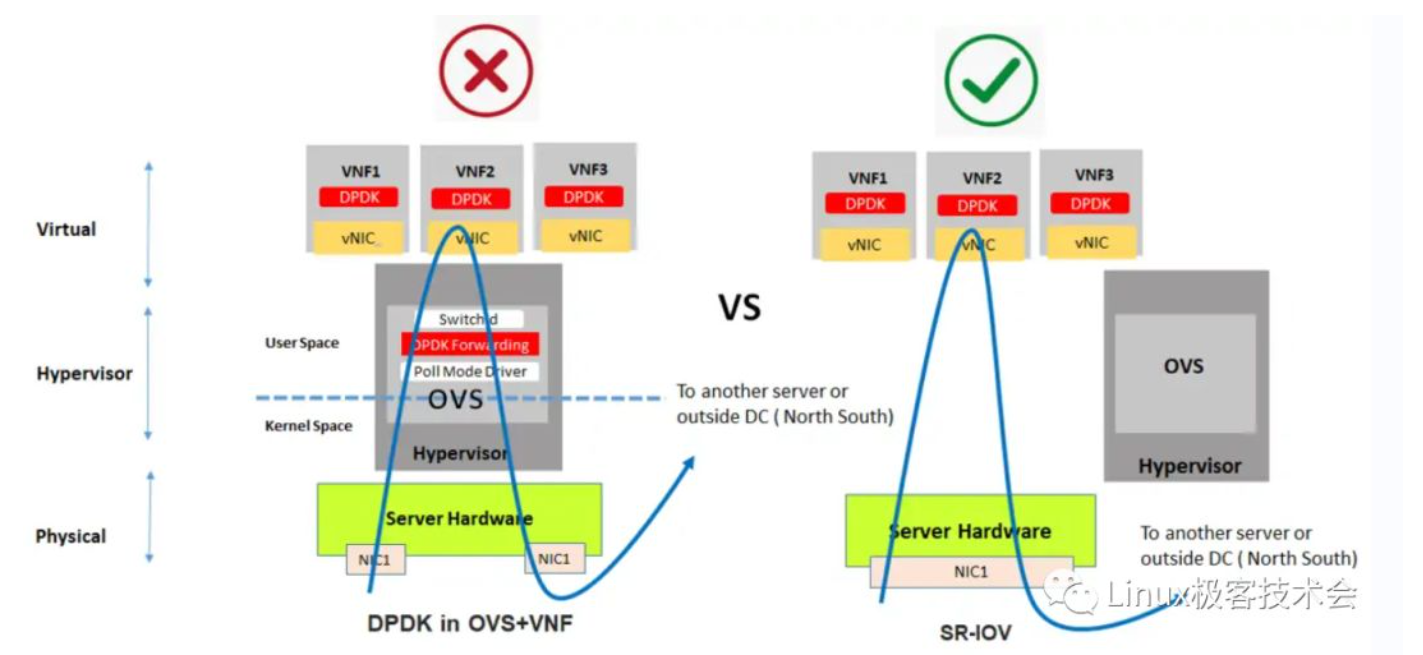

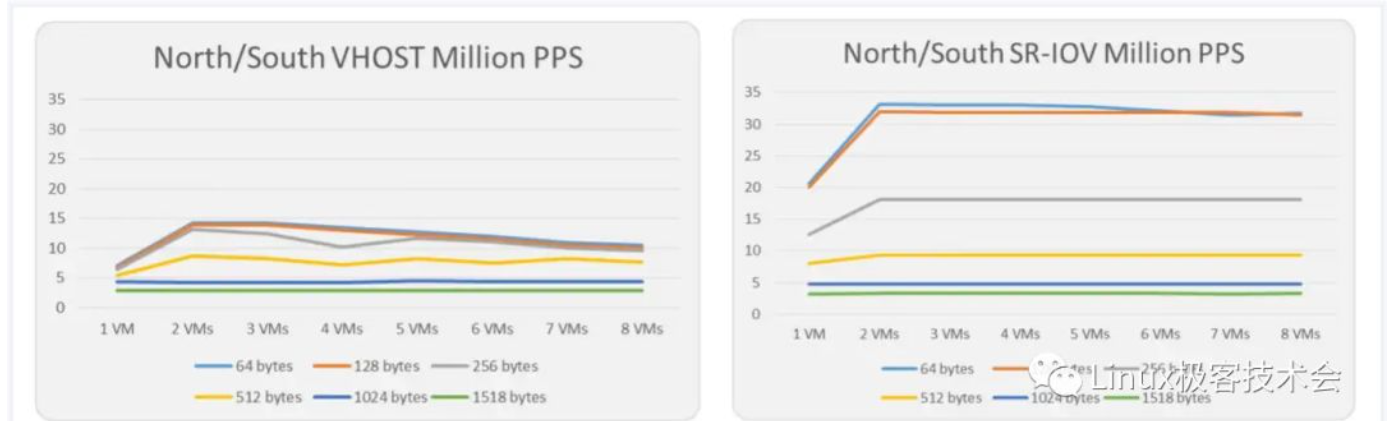

在南北流量(也包括从一个服务器到另一个服务器的东西流量)的场景中,SR-IOV性能要优于DPDK。

图8

图9

图9为Intel官方给出的南北向流量场景下DPDK与SR-IOV的性能测试数据。

浙公网安备 33010602011771号

浙公网安备 33010602011771号