深度学习之深度卷积神经网络(AlexNet)

在上一篇提到的LeNet中,虽然LeNet可以在早期的⼩数据集上取得好的成绩,但是在更⼤的真实数据集上的表现并不尽如⼈意。因为:

- 神经⽹络计算复杂;训练⼀个多通道、多层和有⼤量参数的卷积神经⽹络在当年很难完成。

- 当时没有⼤量深⼊研究参数初始化和⾮凸优化算法等诸多领域,导致复杂的神经⽹络的训练通常较困难。

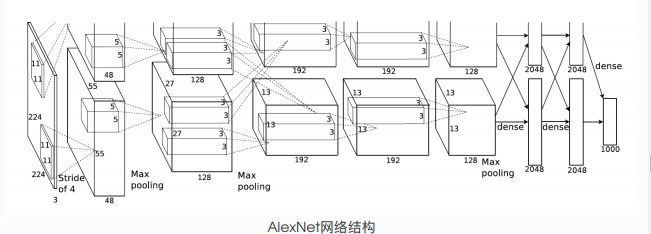

2012年,AlexNet横空出世。这个模型的名字来源于论⽂第⼀作者的姓名Alex Krizhevsky。AlexNet使⽤了8层卷积神经⽹络,并以很⼤的优势赢得了ImageNet 2012图像识别挑战赛。它⾸次证明了学习到的特征可以超越⼿⼯设计的特征,从⽽⼀举打破计算机视觉研究的前状。

AlexNet与LeNet的设计理念⾮常相似,但也有显著的区别。

- 与相对较⼩的LeNet相⽐,AlexNet包含8层变换,其中有5层卷积和2层全连接隐藏层,以及1个全连接输出层。

- AlexNet将sigmoid激活函数改成了更加简单的ReLU激活函数。① ReLU激活函数的计算更简单,例如它并没有sigmoid激活函数中的求幂运算。② ReLU激活函数在不同的参数初始化⽅法下使模型更容易训练。

- AlexNet通过丢弃法(参⻅3.13节)来控制全连接层的模型复杂度。⽽LeNet并没有使⽤丢弃法。

- AlexNet引⼊了⼤量的图像增⼴,如翻转、裁剪和颜⾊变化,从⽽进⼀步扩⼤数据集来缓解过拟合。