基于Adaboost模型的数据预测和分类matlab仿真

1.程序功能描述

AdaBoost(Adaptive Boosting)是一种集成学习方法,由Yoav Freund和Robert Schapire于1995年提出,主要用于提高弱分类器的性能,最终构建一个强分类器。其核心理念是通过迭代训练一系列弱分类器,并给予分类效果好的弱分类器更高的权重,最后将这些弱分类器组合起来形成强分类器。

2.测试软件版本以及运行结果展示

MATLAB2022A版本运行

3.核心程序

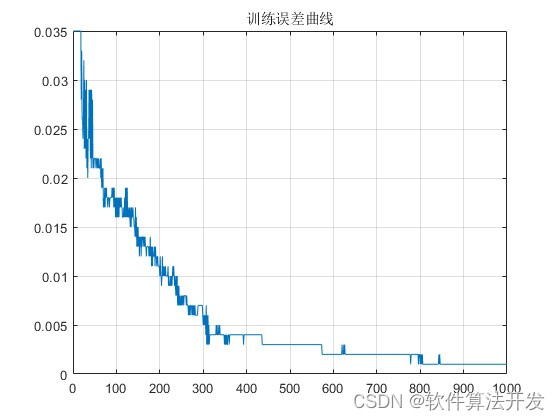

% 显示随着弱分类器数量增加,分类错误率的变化

error = zeros(1, length(models));

for i = 1:length(models)

error(i) = models(i).error;

end

figure

plot(error)

grid on

title('训练误差曲线');

% 创建测试数据

% 创建测试数据

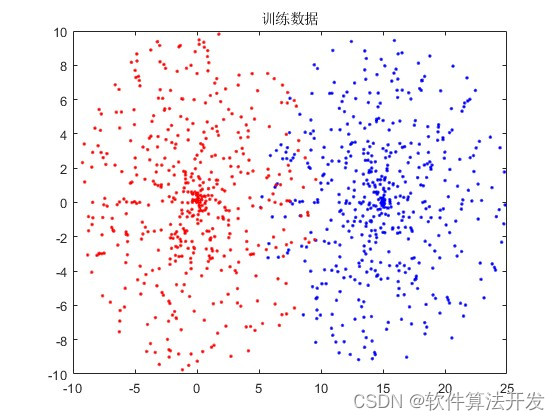

rng(2)

LEN = 500;

theta = rand(LEN,1) * 2 * pi;

Rad1 = rand(LEN,1) * 10;

Rad2 = rand(LEN,1) * 10;

Lab1 = [(sin(theta) .* Rad1)+10 (cos(theta) .* Rad1)];

Lab2 = [(sin(theta) .* Rad2) (cos(theta) .* Rad2)];

testdata = [Lab1; Lab2];

clear theta Rad;

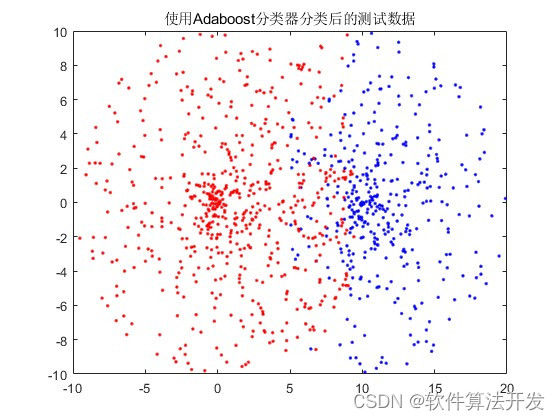

% 使用训练好的Adaboost模型对测试数据进行分类

pred_lab = func_AdaBoost(models, testdata);

% 获取测试结果

Lab1 = testdata(pred_lab == 1, :);

Lab2 = testdata(pred_lab == -1, :);

figure

plot(Lab1(:, 1), Lab1(:, 2), 'b.');

hold on

plot(Lab2(:, 1), Lab2(:, 2), 'r.');

title('使用Adaboost分类器分类后的测试数据');

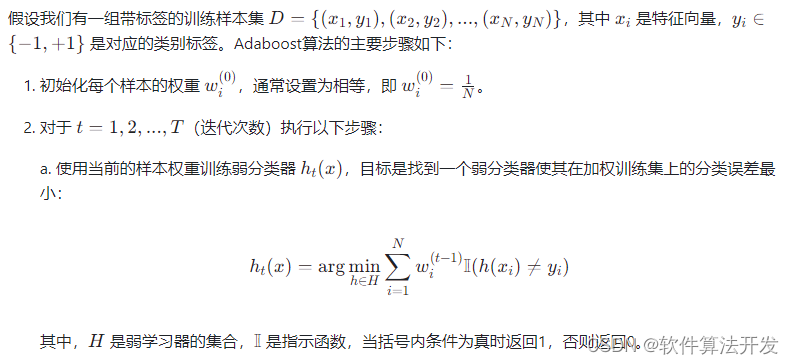

4.本算法原理

AdaBoost(Adaptive Boosting)是一种集成学习方法,由Yoav Freund和Robert Schapire于1995年提出,主要用于提高弱分类器的性能,最终构建一个强分类器。其核心理念是通过迭代训练一系列弱分类器,并给予分类效果好的弱分类器更高的权重,最后将这些弱分类器组合起来形成强分类器。

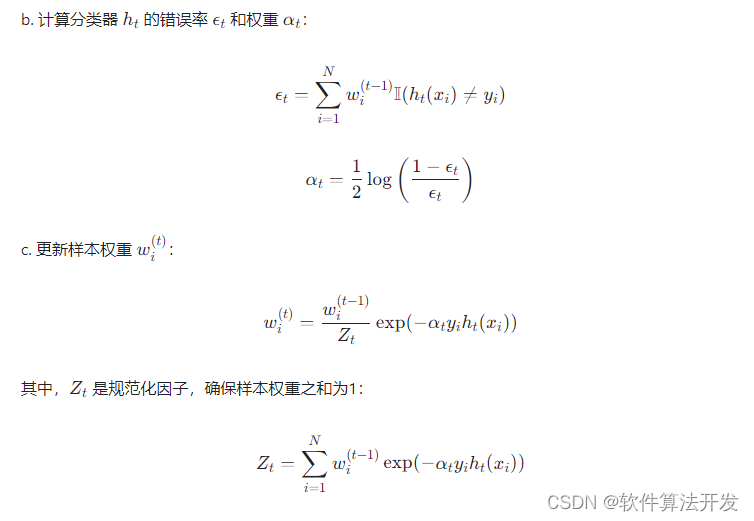

Adaboost通过逐步调整样本权重,让算法更加关注在前一轮中被误分类的样本,从而逐渐修正模型。