K8S集群安装

1、环境准备

1.1、机器环境

- 节点CPU核数必须是 :>= 2核 /内存要求必须是:>=2G ,否则k8s无法启动

- DNS网络: 最好设置为 本地网络连通的DNS,否则网络不通,无法下载一些镜像

- 兼容问题:

docker 19 对应 kubernetes1.19.x

docker 20 对应 kubernetes 1.20.x

在k8s1.21.1之后 k8s的默认容器不是Docker是Containerd

1.2、设置主机名

# 设置主机名为 kmaster hostnamectl set-hostname kmaster --static # 设置另外一台为 kworker1 hostnamectl set-hostname kworker1 --static # 看看别名是否生效 hostname

1.3、配置IP host映射关系

# 编辑/etc/hosts文件,配置映射关系 vi /etc/hosts 192.168.x.x kmaster 192.168.x.x kworker1

1.4、安装依赖环境(注意:每一台机器都需要安装此依赖环境)

yum install -y conntrack ntpdate ntp ipvsadm ipset jq iptables curl sysstatlibseccomp wget vim net-tools git iproute lrzsz bash-completion tree bridge-utils unzip bind-utils gcc

1.5、关闭selinux(必须操作)

# 因为在K8S集群安装的时候需要执行脚本,如果Selinux没有关闭它会阻止执行。 # 关闭swap分区【虚拟内存】并且永久关闭虚拟内存 swapoff -a && sed -i '/ swap / s/^\(.*\)$/#\1/g' /etc/fstab # 关闭selinux setenforce 0 && sed -i 's/^SELINUX=.*/SELINUX=disabled/' /etc/selinux/config

2、系统设置调整

2.1、调整内核参数

# 创建一个 kubernetes.conf 并写入内容 cat > kubernetes.conf <<EOF net.bridge.bridge-nf-call-iptables=1 net.bridge.bridge-nf-call-ip6tables=1 net.ipv4.ip_forward=1 net.ipv4.tcp_tw_recycle=0 vm.swappiness=0 vm.overcommit_memory=1 vm.panic_on_oom=0 fs.inotify.max_user_instances=8192 fs.inotify.max_user_watches=1048576 fs.file-max=52706963 fs.nr_open=52706963 net.ipv6.conf.all.disable_ipv6=1 net.netfilter.nf_conntrack_max=2310720 EOF # 将优化内核文件拷贝到/etc/sysctl.d/文件夹下,这样优化文件开机的时候能够被调用 cp kubernetes.conf /etc/sysctl.d/kubernetes.conf # 手动刷新,让优化文件立即生效 sysctl -p /etc/sysctl.d/kubernetes.conf

2.2、调整时区

# 由于时间相差太大的worker会被master踢掉,所以要检查下时间,如果时间都相同,就无须调整了 # 设置系统时区为中国/上海 timedatectl set-timezone "Asia/Shanghai" # 将当前的UTC 时间写入硬件时钟 timedatectl set-local-rtc 0 # 重启依赖于系统时间的服务 systemctl restart rsyslog systemctl restart crond

2.3、设置日志保存方式

2.3.1、创建保存日志的目录

# 创建保存日志的目录 mkdir /var/log/journal

2.3.2、创建配置文件存放目录

# 创建配置文件存放目录 mkdir /etc/systemd/journald.conf.d

2.3.3、创建配置文件

cat > /etc/systemd/journald.conf.d/99-prophet.conf <<EOF [Journal] Storage=persistent Compress=yes SyncIntervalSec=5m RateLimitInterval=30s RateLimitBurst=1000 SystemMaxUse=10G SystemMaxFileSize=200M MaxRetentionSec=2week ForwardToSyslog=no EOF

2.3.4、重启systemd journald 的配置

# 重启systemd journald 的配置 systemctl restart systemd-journald

2.3.5、kube-proxy 开启 ipvs 前置条件

modprobe br_netfilter cat > /etc/sysconfig/modules/ipvs.modules <<EOF #!/bin/bash modprobe -- ip_vs modprobe -- ip_vs_rr modprobe -- ip_vs_wrr modprobe -- ip_vs_sh modprobe -- nf_conntrack_ipv4 EOF #使用lsmod命令查看这些文件是否被引导 chmod 755 /etc/sysconfig/modules/ipvs.modules && bash /etc/sysconfig/modules/ipvs.modules && lsmod | grep -e ip_vs -e nf_conntrack_ipv4 =========================执行结果================================ ip_vs_sh 16384 0 ip_vs_wrr 16384 0 ip_vs_rr 16384 0 ip_vs 147456 6 ip_vs_rr,ip_vs_sh,ip_vs_wrr nf_conntrack_ipv4 20480 0 nf_defrag_ipv4 16384 1 nf_conntrack_ipv4 nf_conntrack 114688 2 ip_vs,nf_conntrack_ipv4 libcrc32c 16384 2 xfs,ip_vs

3、Docker安装

3.1、docker的安装

docker安装详情见 Ubuntu安装docker 或者 CentOS安装docker

3.2、设置docker daemon文件

/etc/docker/daemon.json文件,如果不存在则新增改文件,如果存在则在下面追加。

#创建/etc/docker目录 mkdir /etc/docker #更新daemon.json文件 cat > /etc/docker/daemon.json <<EOF { "exec-opts": ["native.cgroupdriver=systemd"], "log-driver": "json-file", "log-opts": { "max-size": "100m" }, "storage-driver": "overlay2" } EOF #注意:一定注意编码问题,出现错误---查看命令:journalctl -amu docker 即可发现错误 #创建,存储docker配置文件 # mkdir -p /etc/systemd/system/docker.service.d

3.3、重启docker服务

# 重新加载daemon以及重启docker systemctl daemon-reload && systemctl restart docker && systemctl enable docker

4、kubeadm安装K8S

4.1、yum仓库镜像(二选一)

# 国内镜像配置(国内建议配置) cat <<EOF > /etc/yum.repos.d/kubernetes.repo [kubernetes] name=Kubernetes baseurl=http://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64 enabled=1 gpgcheck=0 repo_gpgcheck=0 gpgkey=http://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg http://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg EOF # 官网镜像配置 cat <<EOF > /etc/yum.repos.d/kubernetes.repo [kubernetes] name=Kubernetes baseurl=https://packages.cloud.google.com/yum/repos/kubernetes-el7-x86_64 enabled=1 gpgcheck=1 repo_gpgcheck=1 gpgkey=https://packages.cloud.google.com/yum/doc/yum-key.gpg https://packages.cloud.google.com/yum/doc/rpm-package-key.gpg EOF

4.2、安装kubeadm 、kubelet、kubectl(1.20.5)

# 指定版本 yum install -y kubelet-1.20.5 kubeadm-1.20.5 kubectl-1.20.5 --disableexcludes=kubernetes systemctl enable kubelet && systemctl start kubelet

注意:以上操作所有机器都必须安装

5、准备k8s镜像

5.1、修改配置文件

# 找一个目录创建配置文件,也可以自己找地方新增个k8s目录 kubeadm config print init-defaults > kubeadm-init.yaml

该文件有两处需要修改:

- 将advertiseAddress: 1.2.3.4修改为本机地址,比如使用192.168.1.1作为master,就修改advertiseAddress: 192.168.1.1(推荐用内网ip)

- 将imageRepository: k8s.gcr.io修改为imageRepository: registry.cn-hangzhou.aliyuncs.com/google_containers

修改完毕后文件如下:

apiVersion: kubeadm.k8s.io/v1beta2 bootstrapTokens: - groups: - system:bootstrappers:kubeadm:default-node-token token: abcdef.0123456789abcdef ttl: 24h0m0s usages: - signing - authentication kind: InitConfiguration localAPIEndpoint: advertiseAddress: 10.0.4.13 bindPort: 6443 nodeRegistration: criSocket: /var/run/dockershim.sock name: kmaster taints: - effect: NoSchedule key: node-role.kubernetes.io/master --- apiServer: timeoutForControlPlane: 4m0s apiVersion: kubeadm.k8s.io/v1beta2 certificatesDir: /etc/kubernetes/pki clusterName: kubernetes controllerManager: {} dns: type: CoreDNS etcd: local: dataDir: /var/lib/etcd imageRepository: registry.cn-hangzhou.aliyuncs.com/google_containers kind: ClusterConfiguration kubernetesVersion: v1.20.0 networking: dnsDomain: cluster.local serviceSubnet: 10.96.0.0/12 scheduler: {}

5.2、根据配置文件拉取镜像

# 使用kubeadm-init.yaml文件拉取所需要的镜像 kubeadm config images pull --config kubeadm-init.yaml

6、K8S的Master部署

6.1、执行初始化

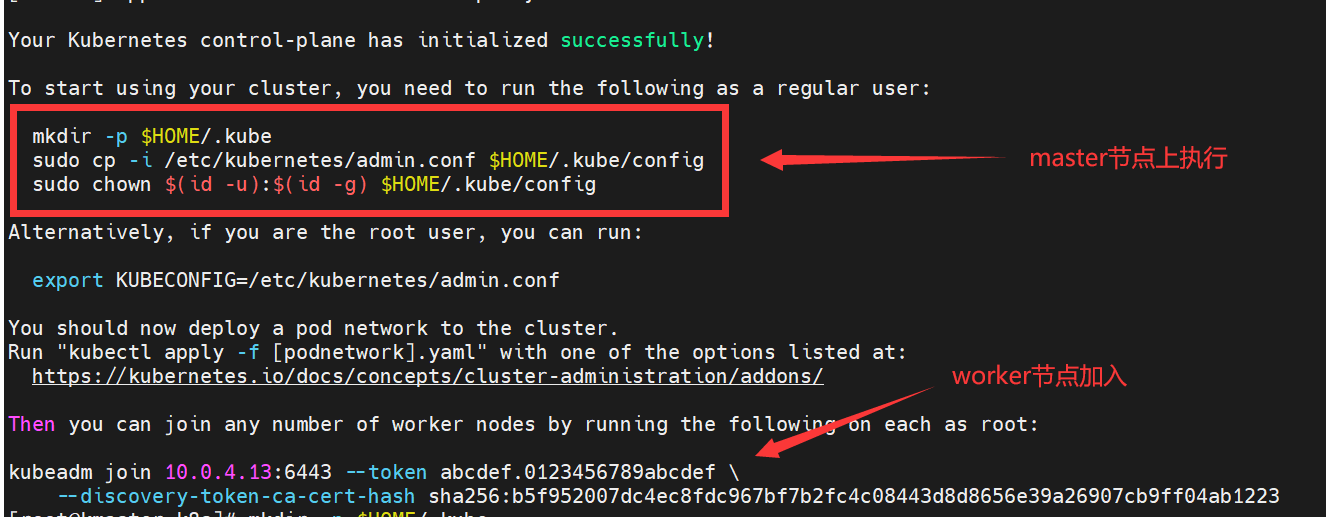

# 初始化 kubeadm init --config kubeadm-init.yaml # 出现类似以下提示,表示初始化成功 kubeadm join 10.0.4.13:6443 --token abcdef.0123456789abcdef \ --discovery-token-ca-cert-hash sha256:b5f952007dc4ec8fdc967bf7b2fc4c08443d8d8656e39a26907cb9ff04ab1223

master节点初始化成功后,根据内容提示,执行相应脚本(根据具体的提示复制了执行)

# master节点初始化成功后,根据内容提示,执行相应脚本(根据具体的提示复制了执行) mkdir -p $HOME/.kube sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config sudo chown $(id -u):$(id -g) $HOME/.kube/config # worker节点加入master执行的脚本(注意,如果是云服务器,则需要开启6443端口,默认是不开启的,不开启时worker节点会加入失败) kubeadm join 10.0.4.13:6443 --token abcdef.0123456789abcdef \ --discovery-token-ca-cert-hash sha256:b5f952007dc4ec8fdc967bf7b2fc4c08443d8d8656e39a26907cb9ff04ab1223

6.2、查看Master节点网络状态

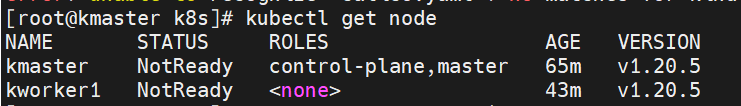

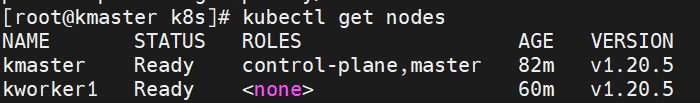

# 执行kubectl命令查看机器节点 kubectl get node ----------------------------------------- NAME STATUS ROLES AGE VERSION master NotReady master 48m v1.20.1 # 发现节点STATUS是NotReady的,是因为没有配置网络

6.3、worker节点加入master

# worker节点加入master执行的脚本(注意,如果是云服务器,则需要开启6443端口,默认是不开启的,不开启时worker节点会加入失败) kubeadm join 10.0.4.13:6443 --token abcdef.0123456789abcdef \ --discovery-token-ca-cert-hash sha256:b5f952007dc4ec8fdc967bf7b2fc4c08443d8d8656e39a26907cb9ff04ab1223

注意:worker节点加入master时,需要保证master节点的机器6443端口开放,否则会加入失败,我这边是云服务器,直接正在控制台开启即可,我这边指定了worker节点的ip。

6.4、验证状态

执行kubectl get node查看所有node信息,会发现所有node都是NotReady的,是因为没有配置网络。

6.5、配置网络

6.5.1、下载calico.yaml

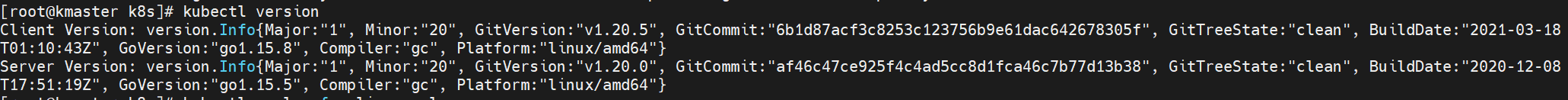

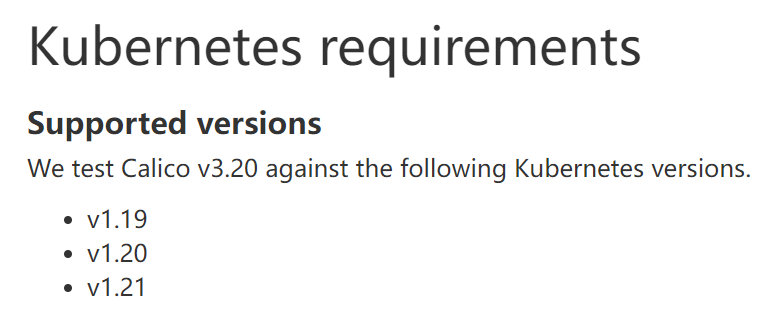

calico.yaml版本 与 k8s版本相关,需要先查询k8s的版本并且下载相对应的calico.yaml,否则应用网络的时候会报错。

# 查看k8s版本 kubectl version

查看k8s对应的calico的版本 https://projectcalico.docs.tigera.io/archive/v3.20/getting-started/kubernetes/requirements

发现Calico V3.20支持 k8s的v1.20版本,则下载3.20版本:https://docs.projectcalico.org/v3.20/manifests/calico.yaml

如果文件无法下载,则可以在服务器上先创建名为calico.yaml的文件,然后把内容复制进去。

6.5.2、修改calico.yaml文件

# 修改文件 vi calico.yaml ## 编辑calico.yaml ## 修改calico.yaml文件设置指定的网卡 # Cluster type to identify the deployment type - name: CLUSTER_TYPE value: "k8s,bgp" # IP automatic detection(配置网络) - name: IP_AUTODETECTION_METHOD value: "interface=eth0" # Auto-detect the BGP IP address. - name: IP value: "autodetect" # Enable IPIP - name: CALICO_IPV4POOL_IPIP value: "Never" # 构建calico网络 kubectl apply -f calico.yaml

追加:

- name: IP_AUTODETECTION_METHOD value: "interface=eth0"

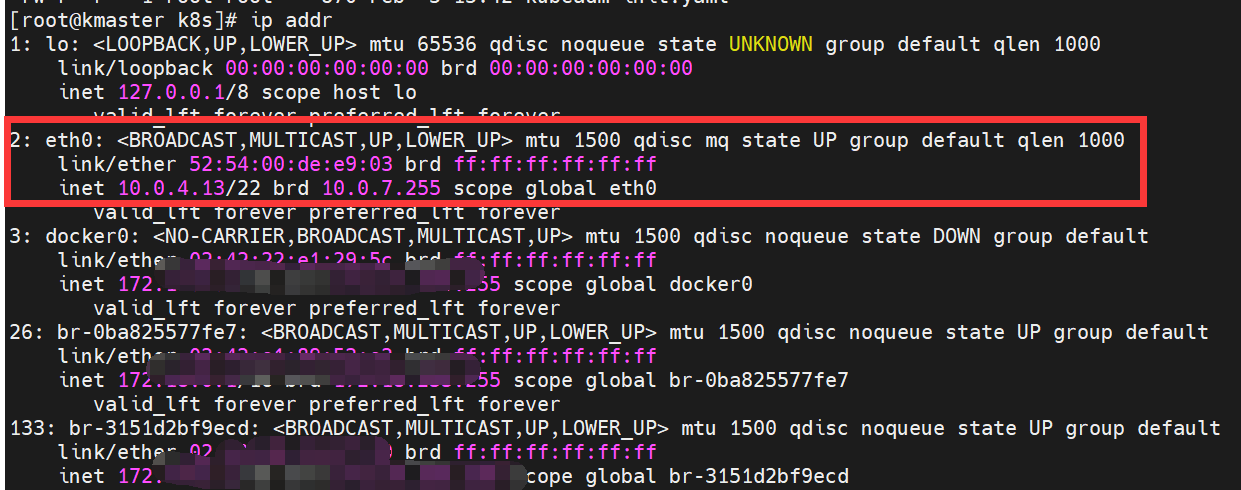

interface=eth0:其中eth0是机器内网ip网卡名称,可以用ip addr查看当前机器的网络。如果不指定则可能会分派到其他网络上。

我这边两条机器的内网是10.0.4网段的,所以要固定是eth0网卡

CALICO_IPV4POOL_IPIP:改成Never

6.5.3、构建完网络后,查看node状态

# 查看node状态 kubectl get node --------------------------------------------------- NAME STATUS ROLES AGE VERSION kmaster Ready master 48m v1.20.5 kworker Ready <none> 56m v1.20.5

看到STATUS是Ready的,说明网络已经通了。

7、遇到的问题

问题1:安装好后,并且使用kuboard连接后查看到有一些基础服务没有起来(位于kube-system命名空间下的一些服务)

问题2:还发现kuboard安装在master节点上,无法访问启动在worker节点上的容器日志,也无法进度容器内部(其实是超时了)

经过排查,由于我使用的是云服务器,worker节点没有开启相应的端口,去云服务器控制台上开启即可,开启时端口直接指定成ALL(因为咱也不知道具体会用到哪个端口),ip指定安装kuboard的机器的内网ip即可。