1.官网下载flink安装包

# wget https://archive.apache.org/dist/flink/flink-1.13.1/flink-1.13.1-bin-scala_2.11.tgz

2.解压

# tar -zxvf flink-1.13.1-bin-scala_2.11.tgz -C /home/hadoop/app/

3.修改配置文件flink-conf.yaml

# vim /home/hadoop/app/flink-1.13.1/conf/flink-conf.yaml

修改配置

jobmanager.rpc.address:localhost

taskmanager.numberOfTaskSlots: 2

rest.port: 8081

修改master

vim /home/hadoop/app/flink-1.13.1/conf/masters

添加

dba-04:8081

dba-05:8081

修改slaves

vim /opt/baiwan/flink-1.13.1/conf/slaves

添加

dba-01

dba-02

dba-03

flink-conf.yaml文件参数说明:

基础配置

# jobManager 的IP地址

jobmanager.rpc.address: localhost

# JobManager 的端口号

jobmanager.rpc.port: 6123

# JobManager JVM heap 内存大小

jobmanager.heap.size: 1024m

# TaskManager JVM heap 内存大小

taskmanager.heap.size: 1024m

# 每个 TaskManager 提供的任务 slots 数量大小

taskmanager.numberOfTaskSlots: 1

# 程序默认并行计算的个数

parallelism.default: 1

# 文件系统来源

# fs.default-scheme

高可用配置

# 可以选择 'NONE' 或者 'zookeeper'.

# high-availability: zookeeper

# 文件系统路径,让 Flink 在高可用性设置中持久保存元数据

# high-availability.storageDir: hdfs:///flink/ha/

# zookeeper 集群中仲裁者的机器 ip 和 port 端口号

# high-availability.zookeeper.quorum: localhost:2181

# 默认是 open,如果 zookeeper security 启用了该值会更改成 creator

# high-availability.zookeeper.client.acl: open

容错及检查点配置

# 用于存储和检查点状态

# state.backend: filesystem

# 存储检查点的数据文件和元数据的默认目录

# state.checkpoints.dir: hdfs://namenode-host:port/flink-checkpoints

# savepoints 的默认目标目录(可选)

# state.savepoints.dir: hdfs://namenode-host:port/flink-checkpoints

# 用于启用/禁用增量 checkpoints 的标志

# state.backend.incremental: false

web端配置

# 基于 Web 的运行时监视器侦听的地址.

#jobmanager.web.address: 0.0.0.0

# Web 的运行时监视器端口

rest.port: 8081

# 是否从基于 Web 的 jobmanager 启用作业提交

# jobmanager.web.submit.enable: false

4.配置环境变量

# vim /etc/profile

添加

export FLINK_HOME=/home/hadoop/app/flink-1.13.1

export PATH=$PATH:$FLINK_HOME/bin

5.分发到其他节点

#scp -r /home/hadoop/app/flink-1.13.1 hadoop@dba-02:/home/hadoop/app

#scp -r /home/hadoop/app/flink-1.13.1 hadoop@dba-03:/home/hadoop/app

#scp -r /home/hadoop/app/flink-1.13.1 hadoop@dba-04:/home/hadoop/app

#scp -r /home/hadoop/app/flink-1.13.1 hadoop@dba-05:/home/hadoop/app

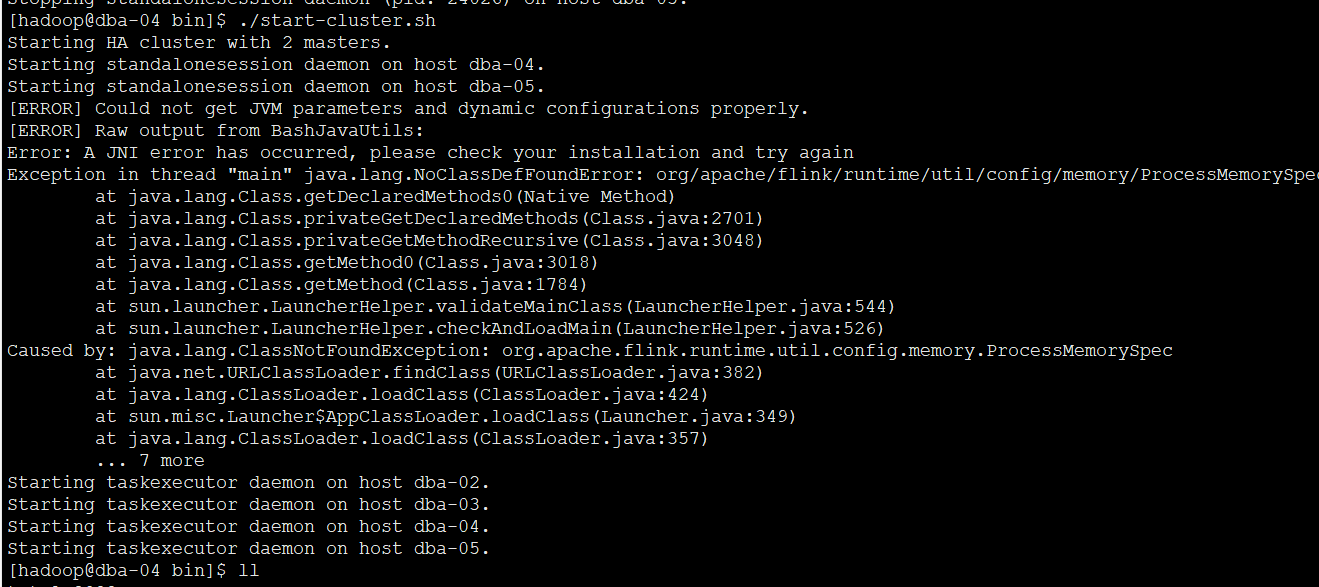

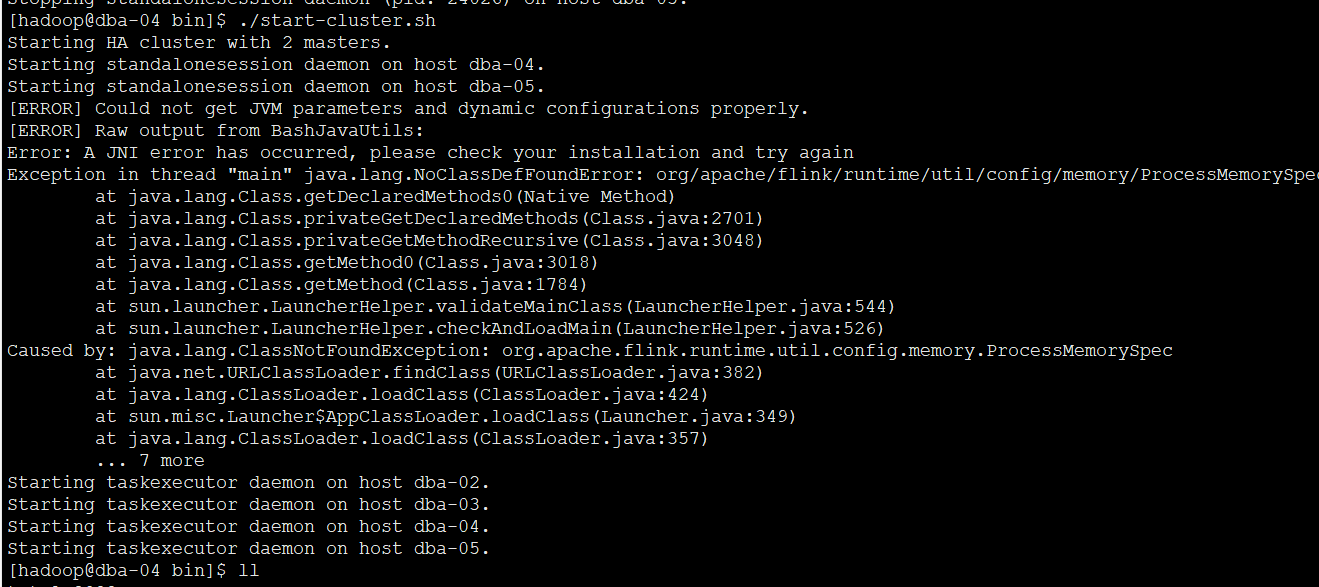

6.master节点上启动flink集群

# cd /home/hadoop/app/flink-1.13.1/bin

# ./start-cluster.sh

常见错误

错误1,报错如上

解决方法:检查flink-config.yaml文件,master文件,workers文件的正确性,一般是由于这些文件配置错误导致

报错:Caused by: java.net.BindException: Could not start rest endpoint on any port in port range 8081

解决方法:flink默认端口rest.port=8081,端口最容易被占用,改为其他不常用的端口8085