卷积神经网络—第二周

一、为什么要进行实例探究

本章将介绍几个典型的CNN案例:

LeNet-5

AlexNET

VGG

还有ResNet、Inception Neural Network

二、经典网络

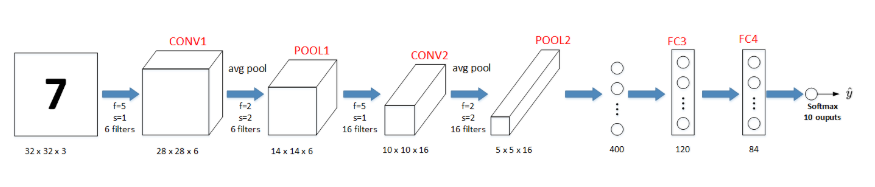

lenet-5神经网络使用的是avg_pool,参数也不多只有六万个,使用的是sigmoid和tanh激活函数

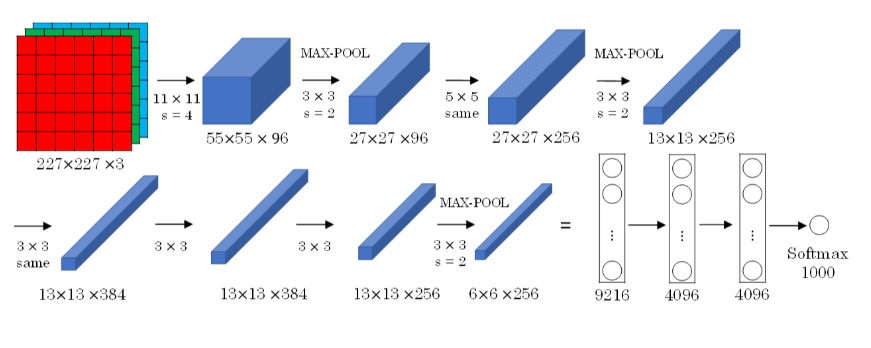

alexnet参数更多了,达到了六千万个,同时使用了relu激活函数

vgg-16网络比较整齐,分别是卷积层,池化层,卷积,池化,而且缩小放大倍数都是2,参数达到一亿多个

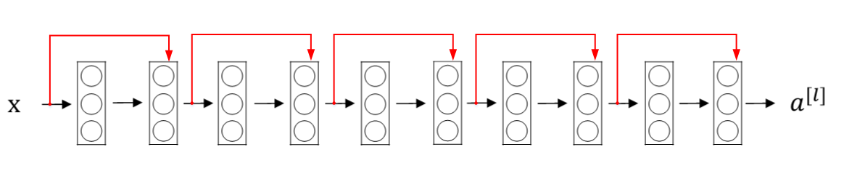

三、残差网络

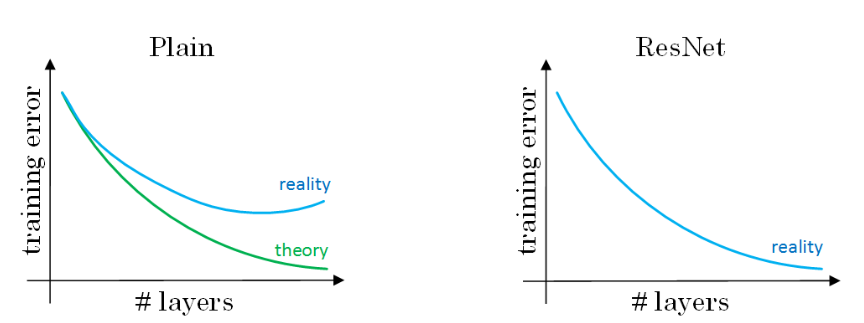

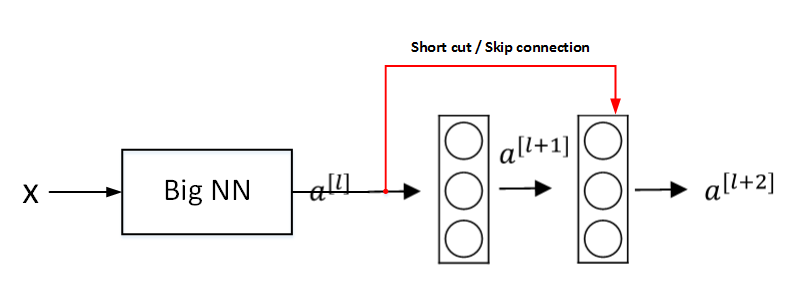

随着神经网络的加深,由于梯度消失和梯度爆炸,这时候就提出了resnets,这个网络通过人为的让某些层跳过下一层,隔层相连。

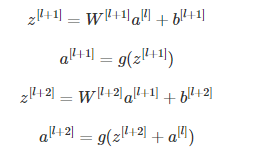

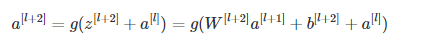

公式如下:与普通神经网络一样,只不过在a l+2 那里不同,

对于训练误差更小。

四、残差网络为什么有用

这里a l+2的表达式是这样的,如果由于wb梯度消失,那么由于relu的激活函数,a l+2 = a l

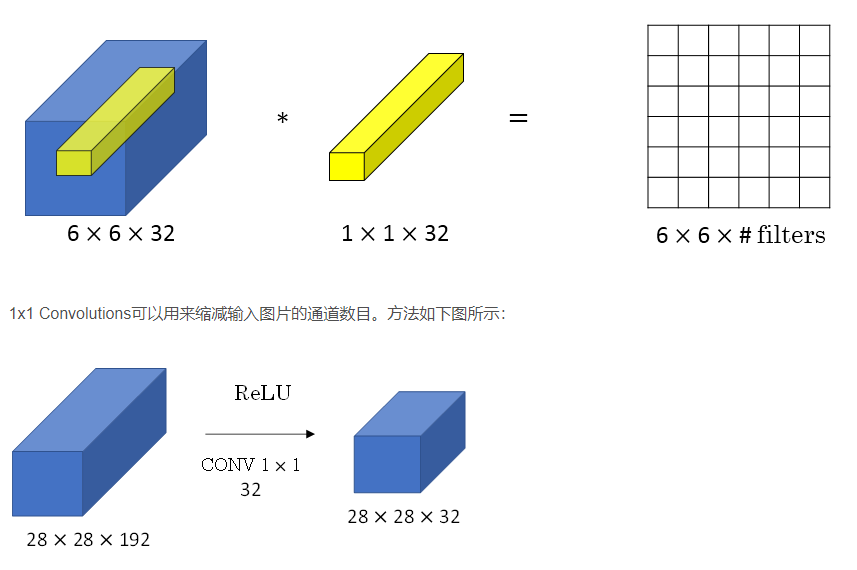

五、网络中的网络以及1*1卷积

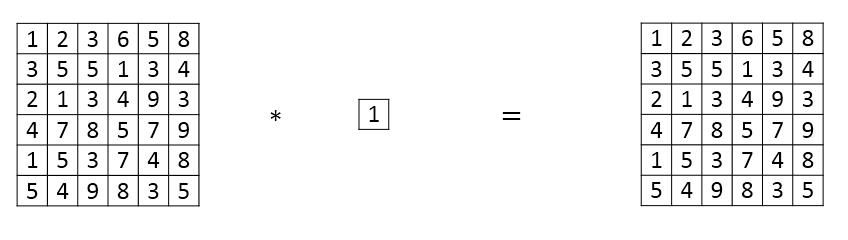

通过1*1的卷积效果其实就是跟全连接层差不多

可以通过1*1卷积核来压缩通道的数量

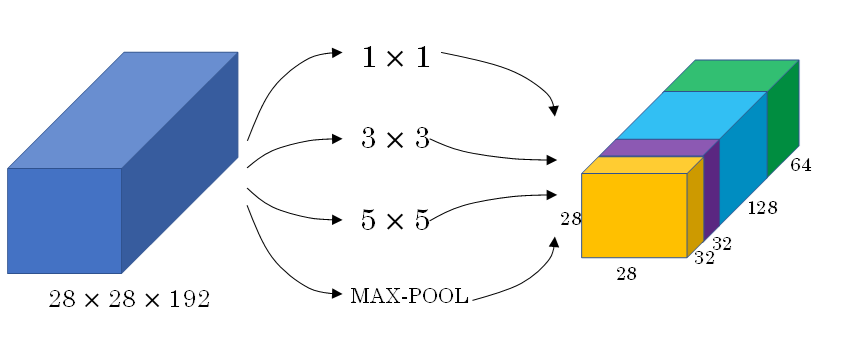

六、谷歌inception网络简介

在inception network中单层网络可以使用多种尺寸的过滤器,比如,1*1,3*3,5*5的,同样也可以把池化层并入进去,不过要使用same padding保证维度一样才能够拼接

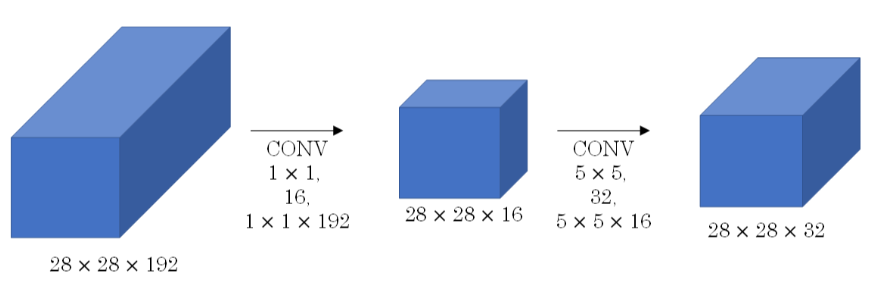

不过由于这种多个过滤器导致计算量特别大,所以需要在中间引入一个瓶颈层,1*1的卷积层

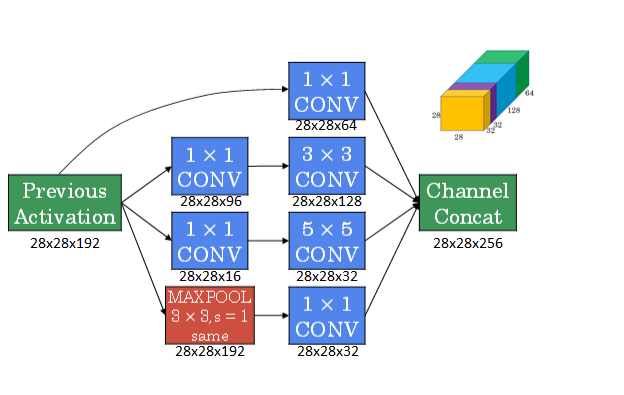

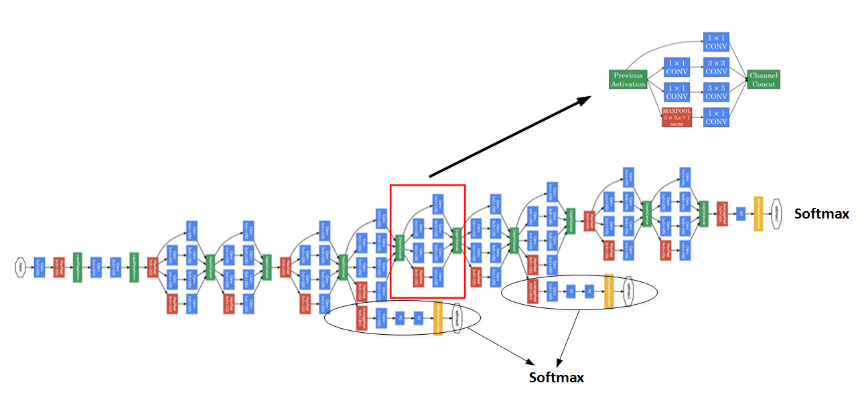

七、inception网络

单个的inception模块如下,通过多个的过滤器堆叠起来最后形成输出

多个inception模块结合起来就是inception网络,不过需要注意的是,inception网络在中间隐藏层也会有softmax输出防止过拟合

八、使用开源的实验方案

介绍了github的使用,可以从上面下载之前别人实现过的项目

九、迁移学习

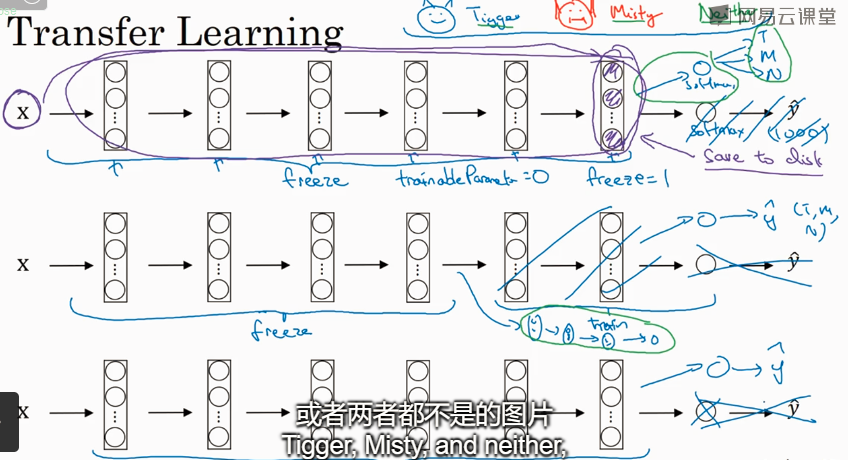

通过网上可以下载别人已经实现过的神经网络模型和参数权重来作为你的基础,在这个基础之上来做迁移学习:

1、如果数据量很少,那么就改掉最后一层的softmax换成你自己的,其他的冻结,然后来做训练

2、如果数据量还可以,可以冻结一部分,把后面几层的网络换成你自己的

3、如果数据量很多,可以使用他们的权重作为你的初始权重来训练。

十、数据扩充

可以通过对图片进行处理来增加数据量,比如镜像,裁剪、改变RGB的数值等等都可以

十一、计算机视觉现状