spark和scala的搭建

Scala--部署安装步骤

(1)上传并解压安装scala安装包

例:tar -zxvf scala--** -C 指定位置

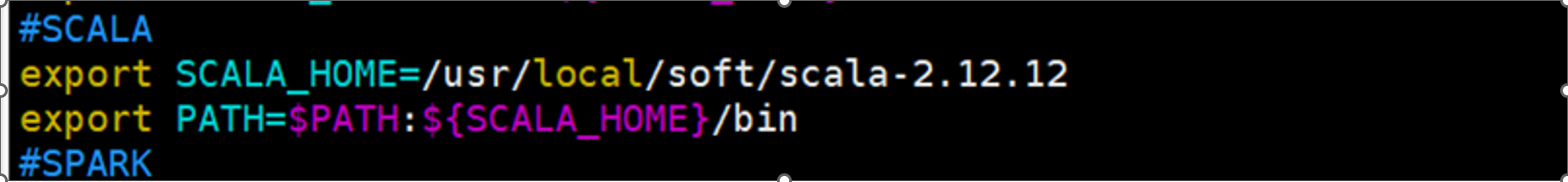

(2)设置环境变量

vim /etc/profile

export SCALA_HOME=spark软件包位置

export PATH=$PATH:${SCALA_HOME}/bin

source /etc/profile使环境变量生效

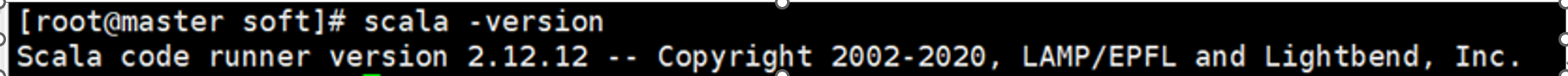

(3)验证scala 启动成功

spark--部署与安装

(1)上传并解压安装spark安装包

tar -zxvf / export/ software/ spark-** -C 指定位置

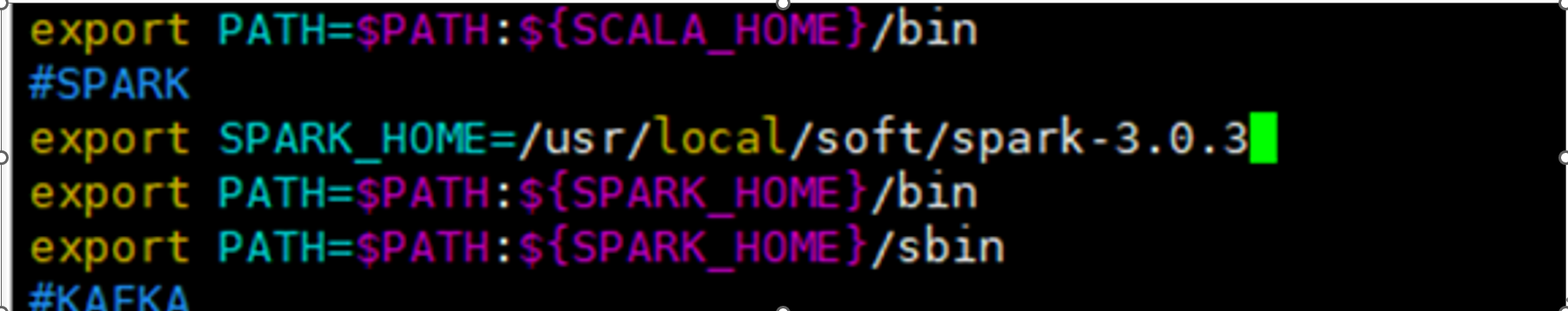

(2)设置环境变量

vim /etc/profile

export SPARK_HOME=spark软件包位置

export PATH=$PATH:${SPARK_HOME}/bin

export PATH=$PATH:${SPARK_HOME}/sbin

(3)修改配置文件

A.先备份文件cp spark env.sh.template spark-env.sh

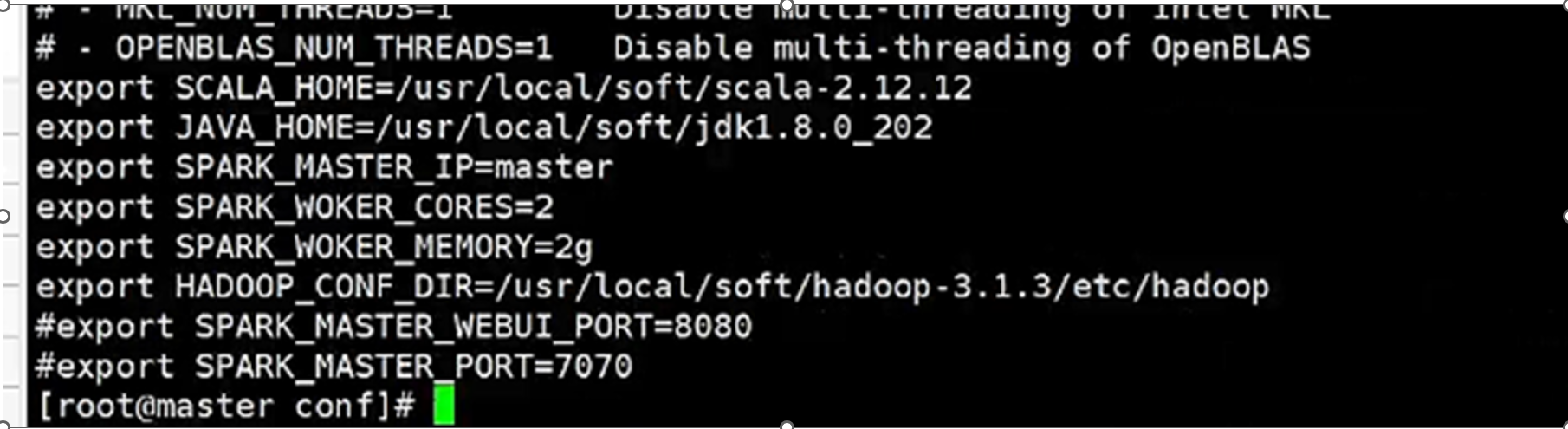

B.修改配置文件-spark-env.sh

添加一下内容:

export SCALA_HOME=spark软件包位置

export JAVA_HOME=java软件包位置

export SPARK_MASTER_IP=master

export SPARK_WOKER_CORES=2

export SPARK_WOKER_MEMORY=2g

export HADOOP_CONF_DIR=hadoop软件包位置

(#)export SPARK_MASTER_WEBUI_PORT=8080

(#)export SPARK_MASTER_PORT=7070

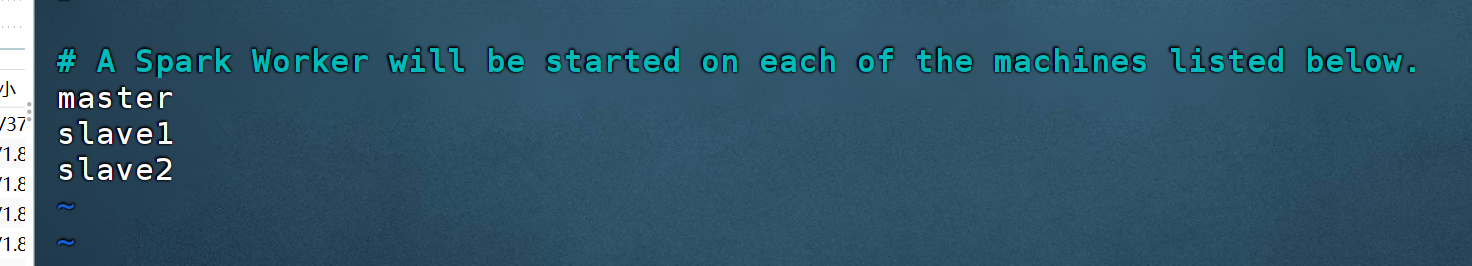

(3.1)在conf/创建slaves文件,指定master,slave1,slave2

(4)分发文件 --分别通过scp命令将软件包拷贝到节点(slave1,slave2)

scp -r spark slave1:目的地

scp -r spark slave1:目的地

(5)分别在slave1 slave2上设置环境变量

vim /etc/profile

export SPARK_HOME=spark软件包位置

export PATH=$PATH:${SPARK_HOME}/bin

export PATH=$PATH:${SPARK_HOME}/sbin

(6)启动集群:spark/sbin目录下:./start-all.sh

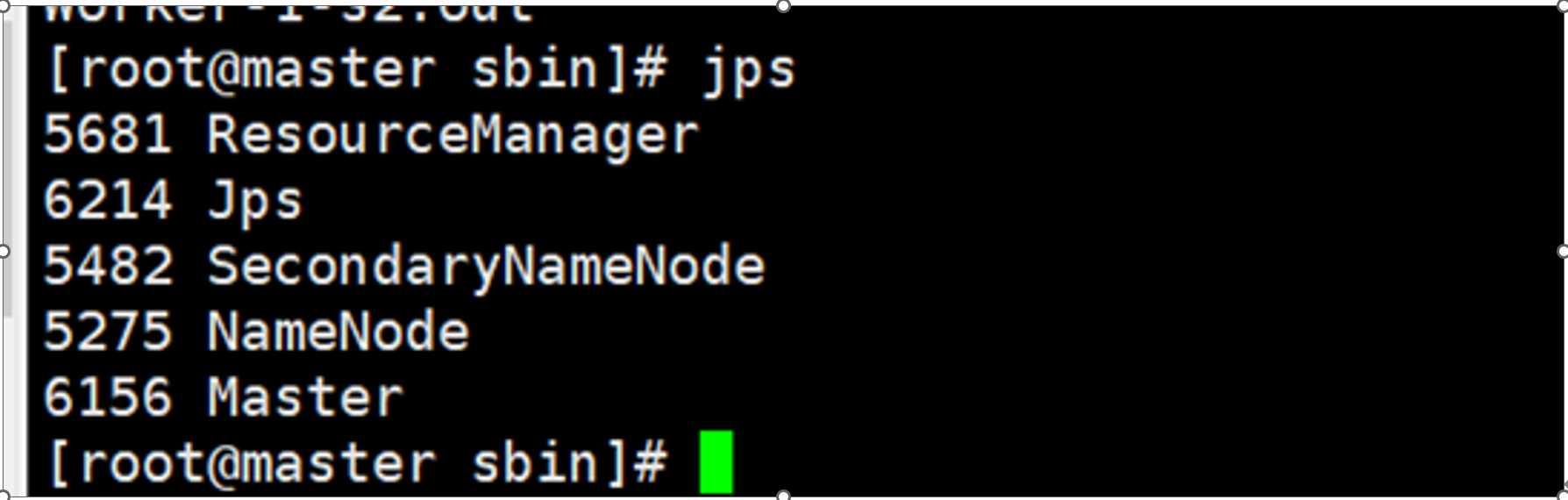

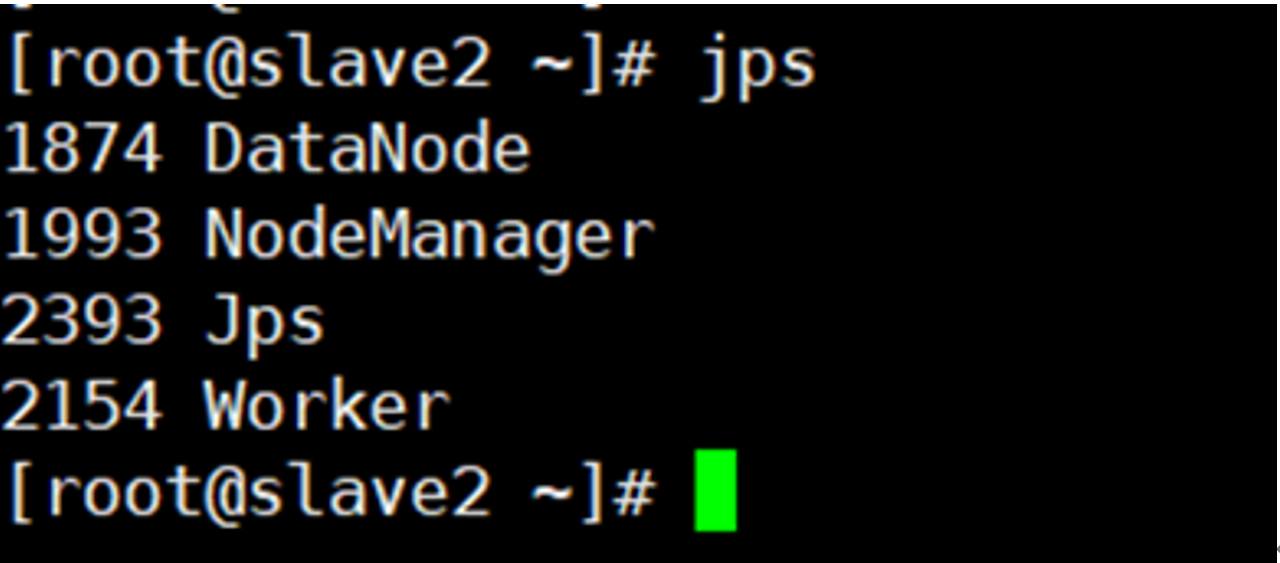

查看节点:

maser:

slave1:

slave2:

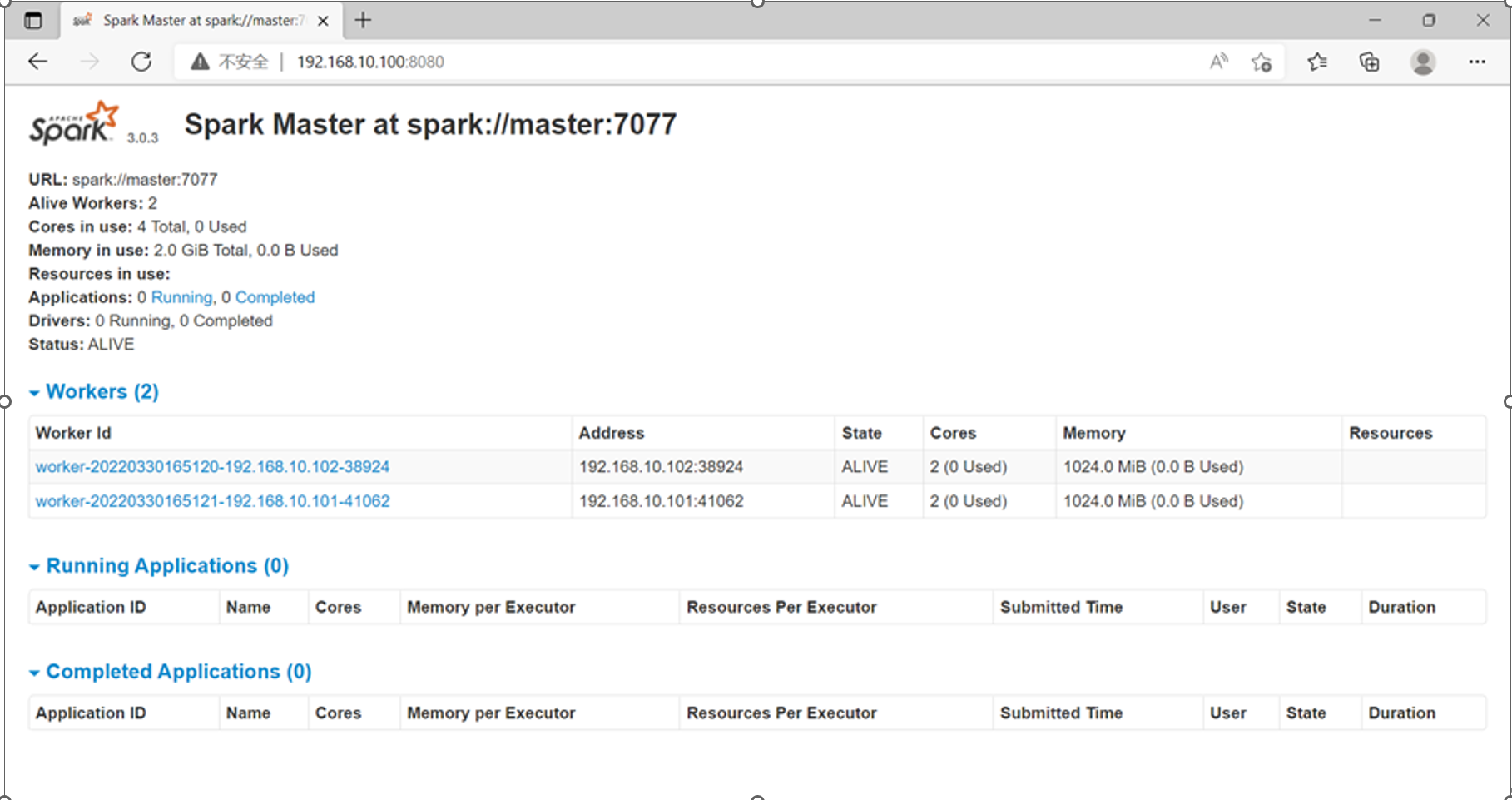

spark验证 ---浏览器输入ip:8080

单机伪分布式spark搭建

1.上传并解压安装scala安装包

2.复制模板文件

注:在目录中进入/conf,复制spark-env.sh.template文件为spark-env.sh

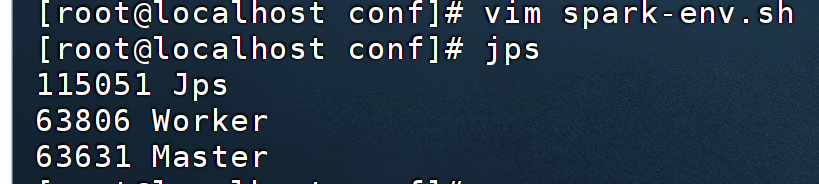

3.修改配置文件spark-env.sh

export JAVA_HOME=/root/123/jdk

export HADOOP_HOME=/root/123/hadoop

export HADOOP_CONF_DIR=/root/123/hadoop/etc/hadoop

export SPART_MASTER_IP=master

export SPART_LOCAL_IP=master

4.进入目录下的/sbin启动soark集群

命令: ./start-all.sh

5.jps查看

浙公网安备 33010602011771号

浙公网安备 33010602011771号