吴恩达机器学习笔记31-梯度检验(Gradient Checking)

当我们对一个较为复杂的模型(例如神经网络)使用梯度下降算法时,可能会存在一些

不容易察觉的错误,意味着,虽然代价看上去在不断减小,但最终的结果可能并不是最优解。

为了避免这样的问题,我们采取一种叫做梯度的数值检验(Numerical Gradient Checking)

方法。这种方法的思想是通过估计梯度值来检验我们计算的导数值是否真的是我们要求的。

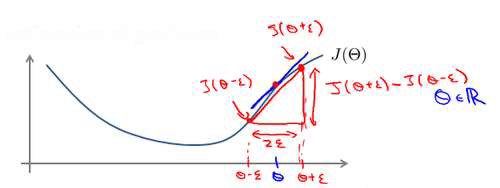

对梯度的估计采用的方法是在代价函数上沿着切线的方向选择离两个非常近的点然后

计算两个点的平均值用以估计梯度。即对于某个特定的 𝜃,我们计算出在 𝜃-𝜀 处和 𝜃+𝜀 的

代价值(𝜀是一个非常小的值,通常选取 0.001),然后求两个代价的平均,用以估计在 𝜃

处的代价值。

当𝜃是一个向量时,我们则需要对偏导数进行检验。因为代价函数的偏导数检验只针对

一个参数的改变进行检验,下面是一个只针对𝜃1进行检验的示例:

最后我们还需要对通过反向传播方法计算出的偏导数进行检验。

利用反向传播的方法,对计算出的偏导数存储在矩阵 𝐷𝑖𝑗

(𝑙) 中。检验时,我们要将该矩阵展开

成为向量,同时我们也将 𝜃 矩阵展开为向量,我们针对每一个 𝜃 都计算一个近似的梯度

值,将这些值存储于一个近似梯度矩阵中,最终将得出的这个矩阵同 𝐷𝑖𝑗

(𝑙) 进行比较。

浙公网安备 33010602011771号

浙公网安备 33010602011771号