吴恩达机器学习笔记9-多变量梯度下降

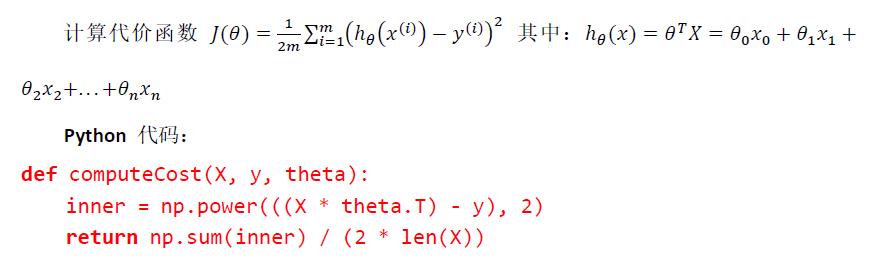

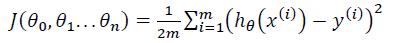

与单变量线性回归类似,在多变量线性回归中,我们也构建一个代价函数,则这个代价

函数是所有建模误差的平方和,即:

其中:ℎ𝜃(𝑥) = 𝜃𝑇𝑋 = 𝜃0 + 𝜃1𝑥1 + 𝜃2𝑥2+. . . +𝜃𝑛𝑥𝑛 ,

我们的目标和单变量线性回归问题中一样,是要找出使得代价函数最小的一系列参数。

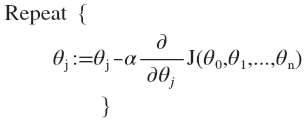

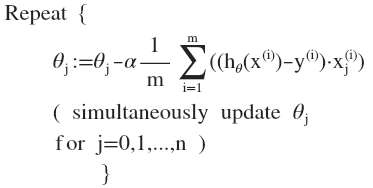

多变量线性回归的批量梯度下降算法为:

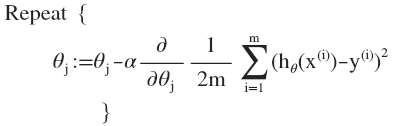

即:

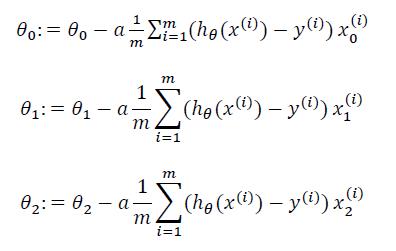

求导数后得到:

当𝑛 >= 1时,

我们开始随机选择一系列的参数值,计算所有的预测结果后,再给所有的参数一个新的

值,如此循环直到收敛。

代码示例: