python处理大型json文件的方法

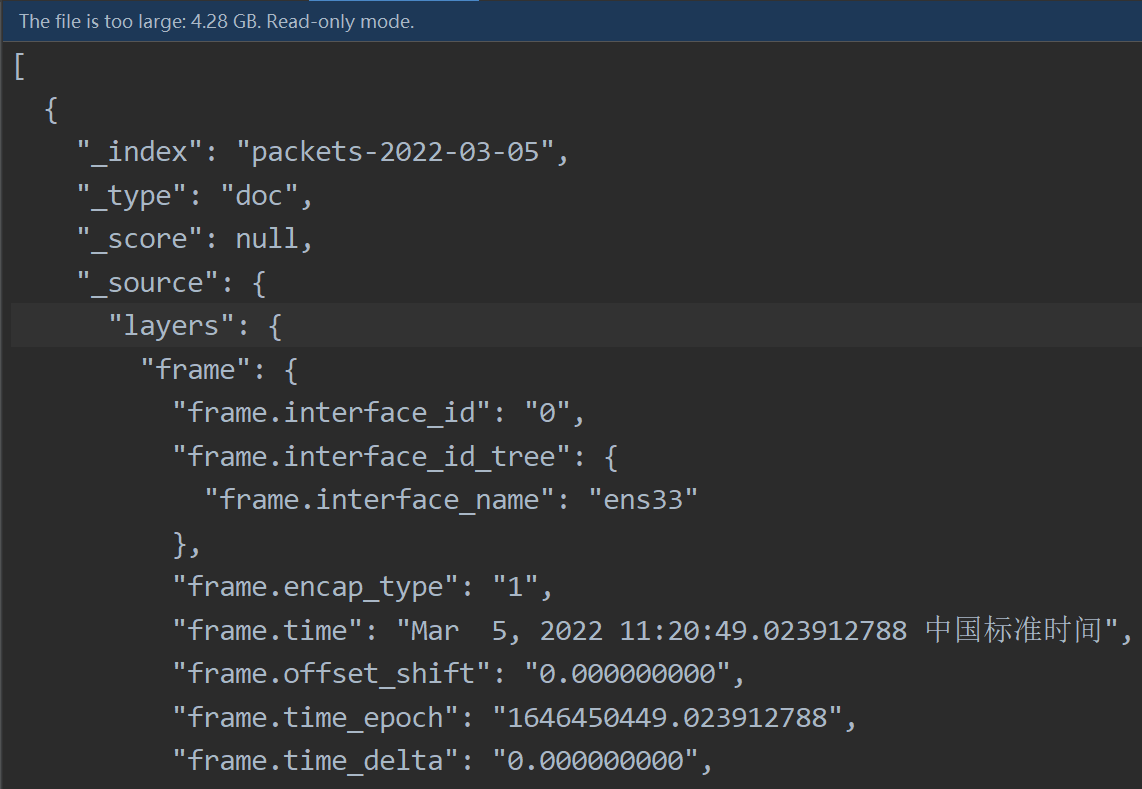

- 如图所示,要处理的数据是一个json数组,而且非常大

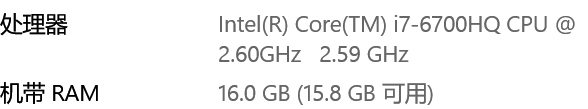

- 下图为电脑配置,使用 json.load() 方法加载上述json文件电脑直接卡死

- 解决思路:

先用python进行预处理,即一整个json数据加载慢,那就分开加载,每次加载一个json对象,然后使用 json.dumps()方法 存储到txt中,方便读取。当然也可以存储到内存中,根据情况而定。

算法思想:因为 json 是一种结构化的数据,所以 {} 是成对存在的。因为使用逐行读取的方法读入json文件,所以根据 {} 的数量来判断是否读取了一个完整的json对象,如果是完整的,则使用 json.dumps()方法 存储到txt中。

getUsefullData(temp + line,id)这个方法是提取自己需要的数据

def jsonProcess(fileName,round): id = 1 with open(fileName, 'r', encoding='utf-8') as f,open('../tempData/tempFile'+str(round)+'.txt','w') as tempFile: # content = ijson.items(f, '_source.item') # content = json.load(f) line = f.readline() line = f.readline() temp = '' khNum = 0 id = 1 while line: # print(line) if line.find('{') != -1: khNum += 1 if line.find('}') != -1: khNum -= 1 if khNum == 0: line = line.replace(',','') try: data = getUsefullData(temp + line,id) id += 1 if len(data) > 1: # print(data) tempFile.write(json.dumps(data)+'\n') temp = '' line = f.readline() continue except BaseException: break temp += line line = f.readline()

读取方法:

with open('../tempData/tempFile'+str(round)+'.txt') as f: dataList = f.readlines() # 解析保存好的list for data in dataList: data = json.loads(data)

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· Manus的开源复刻OpenManus初探

· 写一个简单的SQL生成工具

· AI 智能体引爆开源社区「GitHub 热点速览」

· C#/.NET/.NET Core技术前沿周刊 | 第 29 期(2025年3.1-3.9)