scrapy框架图片爬取

只需要将img的src的属性值进行解析,提交到管道,管道就会对图片的src进行请求发送获取图片的二进制类型的数据,且还会帮我们进行持久化存储

使用流程:

数据解析(图片的地址)

将存储图片地址的item提交到制定的管道类

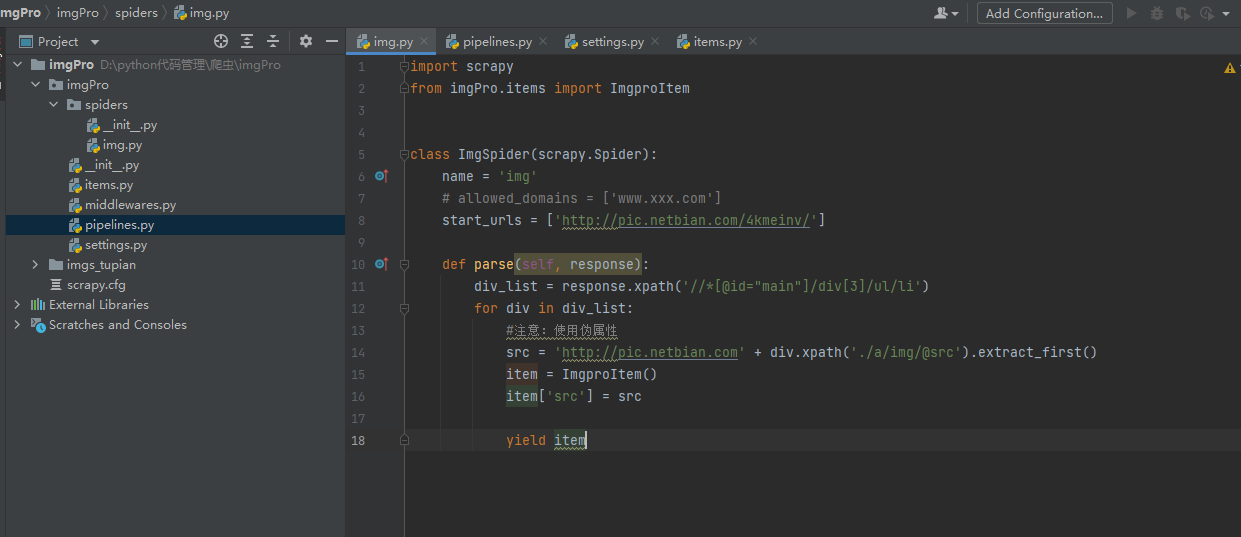

import scrapy

from imgPro.items import ImgproItem

class ImgSpider(scrapy.Spider):

name = 'img'

# allowed_domains = ['www.xxx.com']

start_urls = ['http://pic.netbian.com/4kmeinv/']

def parse(self, response):

div_list = response.xpath('//*[@id="main"]/div[3]/ul/li')

for div in div_list:

#注意:使用伪属性

src = 'http://pic.netbian.com' + div.xpath('./a/img/@src').extract_first()

item = ImgproItem()

item['src'] = src

yield item

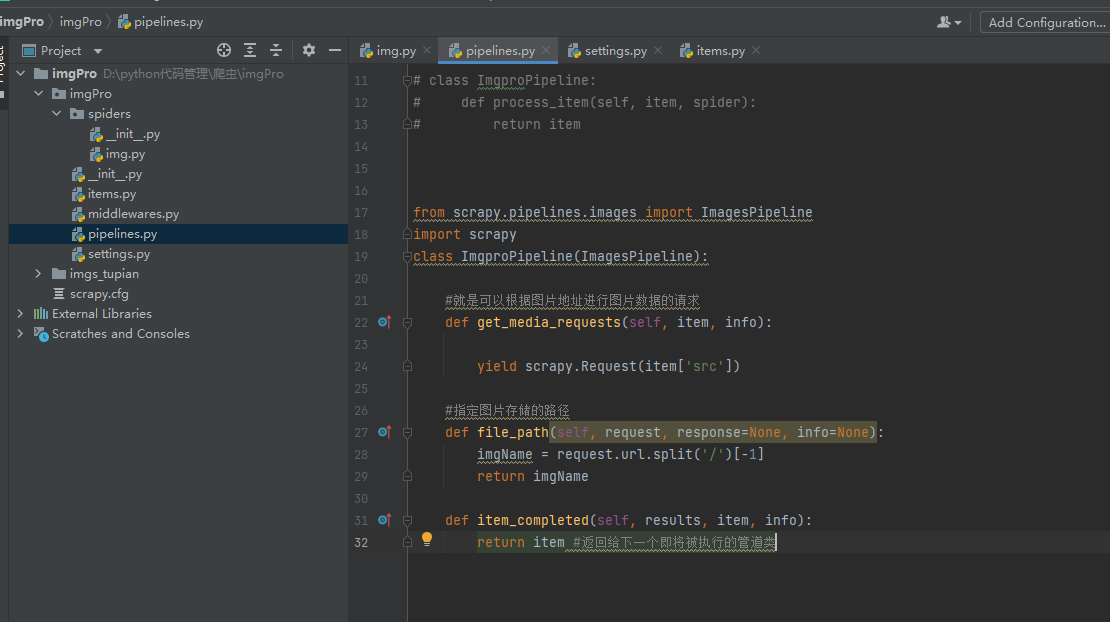

在管道文件中自定制一个基于ImagesPipeLine的一个管道类

get_media_request

file_path

item_completed

from scrapy.pipelines.images import ImagesPipeline

import scrapy

class ImgproPipeline(ImagesPipeline):

#就是可以根据图片地址进行图片数据的请求

def get_media_requests(self, item, info):

yield scrapy.Request(item['src'])

#指定图片存储的路径

def file_path(self, request, response=None, info=None):

imgName = request.url.split('/')[-1]

return imgName

def item_completed(self, results, item, info):

return item #返回给下一个即将被执行的管道类

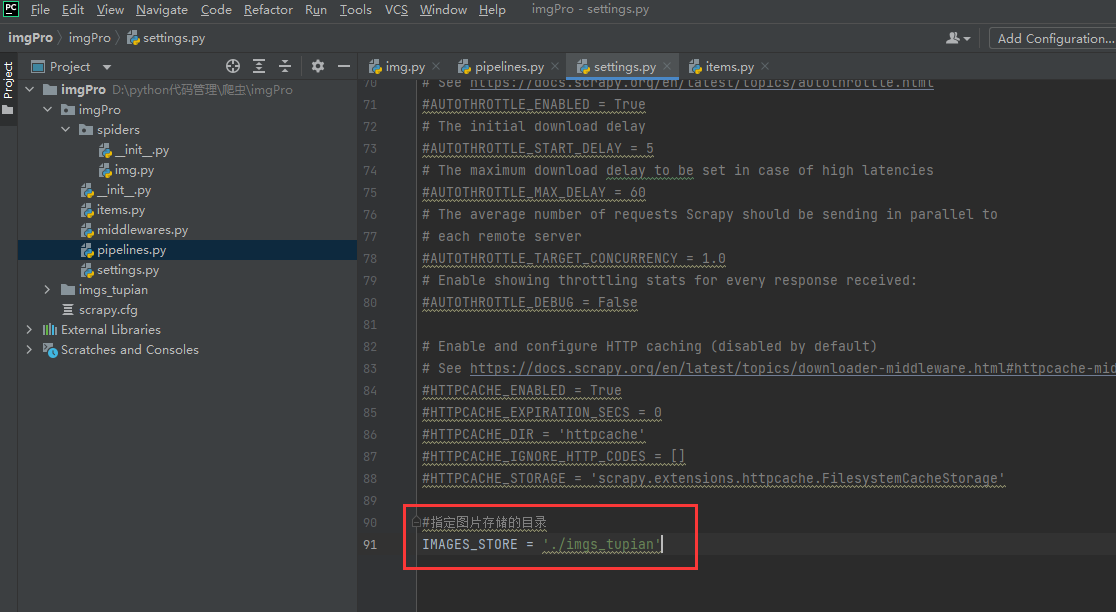

在配置文件中:

指定图片存储的目录:IMAGES_STORE = './imgs_tupian'

指定开启的管道:自定制的管道类

浙公网安备 33010602011771号

浙公网安备 33010602011771号