scrapy框架全站数据爬取

前言

每个网站都有很多页码,将网站中某板块下的全部页码对应的页面数据进行爬取

实现方式有两种:

1、将所有页面的url添加到start_urls列表(不推荐)

2、自行手动进行请求发送(推荐)yield scrapy.Request(url,callback):callback专门用做于数据解析

下面我们介绍第二种方法

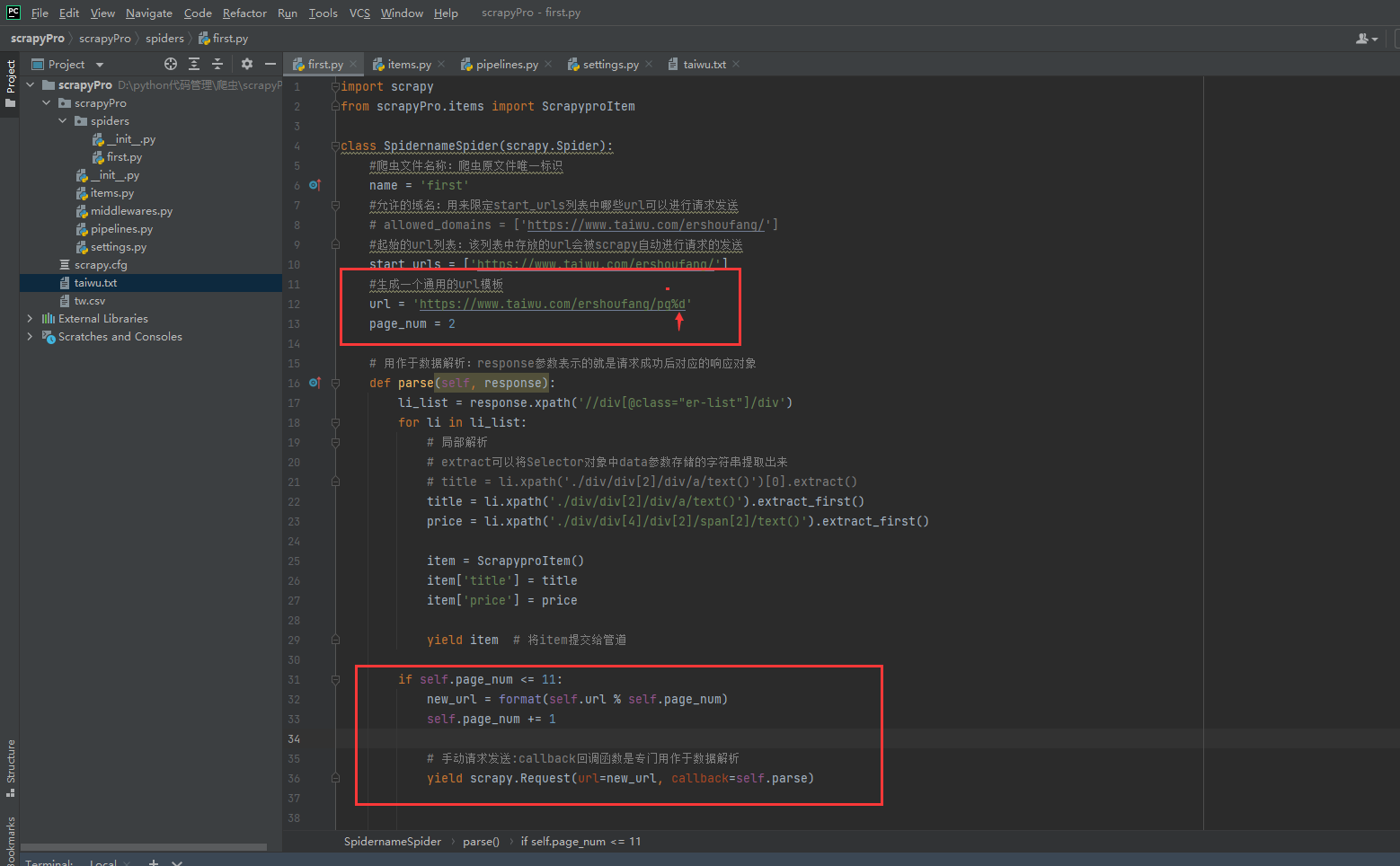

数据解析处理

import scrapy

from scrapyPro.items import ScrapyproItem

class SpidernameSpider(scrapy.Spider):

#爬虫文件名称:爬虫原文件唯一标识

name = 'first'

#允许的域名:用来限定start_urls列表中哪些url可以进行请求发送

# allowed_domains = ['https://www.taiwu.com/ershoufang/']

#起始的url列表:该列表中存放的url会被scrapy自动进行请求的发送

start_urls = ['https://www.taiwu.com/ershoufang/']

#生成一个通用的url模板

url = 'https://www.taiwu.com/ershoufang/pg%d'

page_num = 2

# 用作于数据解析:response参数表示的就是请求成功后对应的响应对象

def parse(self, response):

li_list = response.xpath('//div[@class="er-list"]/div')

for li in li_list:

# 局部解析

# extract可以将Selector对象中data参数存储的字符串提取出来

# title = li.xpath('./div/div[2]/div/a/text()')[0].extract()

title = li.xpath('./div/div[2]/div/a/text()').extract_first()

price = li.xpath('./div/div[4]/div[2]/span[2]/text()').extract_first()

item = ScrapyproItem()

item['title'] = title

item['price'] = price

yield item # 将item提交给管道

if self.page_num <= 11:

new_url = format(self.url % self.page_num)

self.page_num += 1

# 手动请求发送:callback回调函数是专门用作于数据解析

yield scrapy.Request(url=new_url, callback=self.parse)

浙公网安备 33010602011771号

浙公网安备 33010602011771号