摘要:

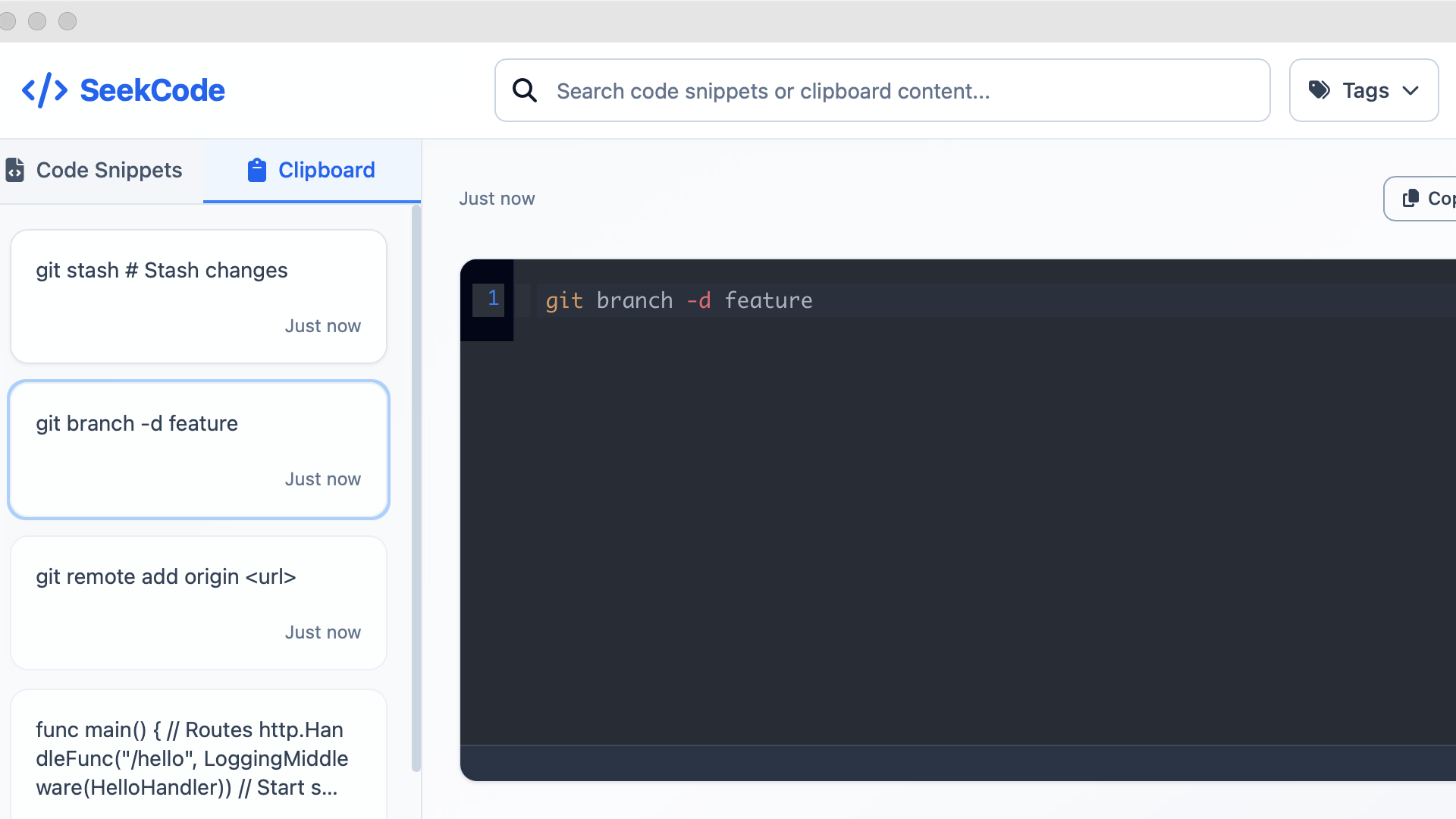

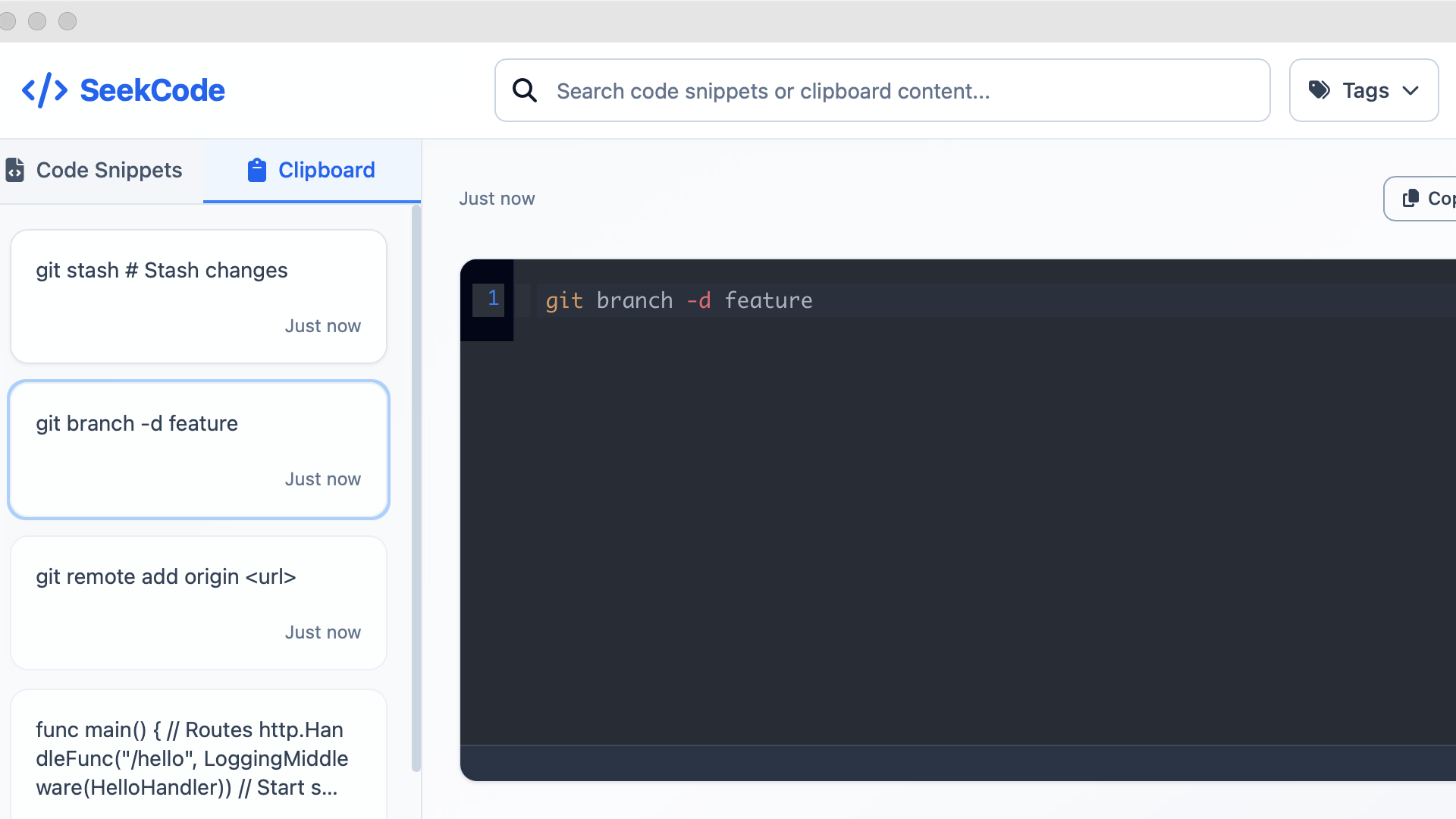

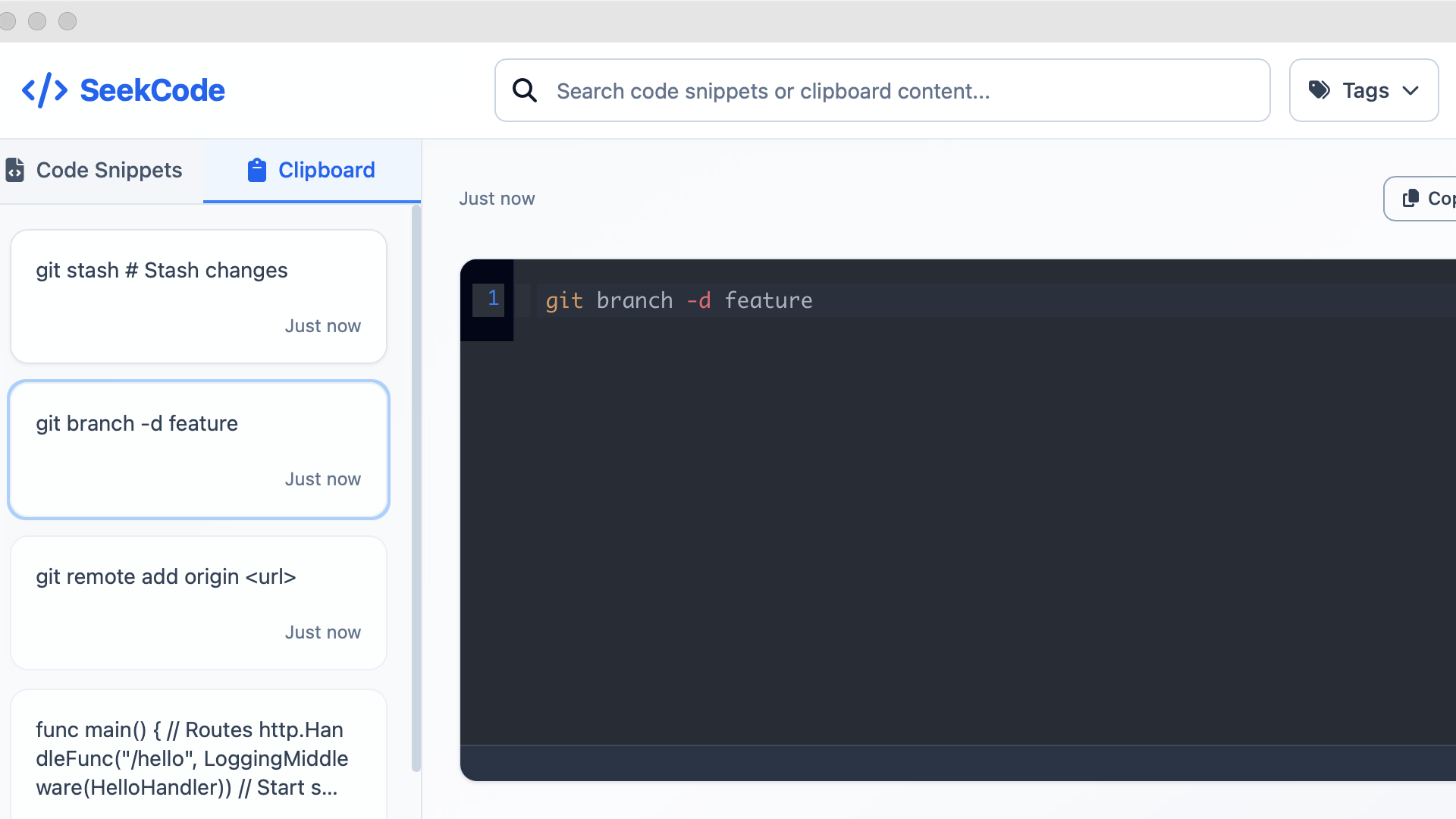

作为一名开发者,我经常为找不到之前用过的代码而烦恼。在又一次因为找代码浪费了大把时间后,我决定利用周末时间来解决这个问题。 为什么要做这个工具? 相信很多开发者都有类似的经历: 🔍 "上次那段代码到底存在哪儿了?" 📋 "糟糕,刚复制了别的内容,之前的代码丢了" 📝 "记得保存过,但是翻遍所有

阅读全文

posted @ 2025-08-03 13:07

seekrays2

阅读(293)

推荐(0)

摘要:

在Kubernetes中,通常kube schduler和kube controller manager都是多副本进行部署的来保证高可用,而真正在工作的实例其实只有一个。这里就利用到 的选主机制,保证leader是处于工作状态,并且在leader挂掉之后,从其他节点选取新的leader保证组件正常工

阅读全文

posted @ 2020-02-16 20:40

seekrays2

阅读(2080)

推荐(0)

摘要:

# 一、执行流程 首先我们构建一个简单http server: ```go package main import ( "log" "net/http" ) func main() { http.HandleFunc("/", func(w http.ResponseWriter, r *http.

阅读全文

posted @ 2020-01-22 11:07

seekrays2

阅读(884)

推荐(0)

摘要:

# 使用场景 在golang项目编写过程中,需要对项目不断的进行构建`go build`并调试以快速发现问题,而我们每次进行手动的进行`go build`又太重复,所以写了这么一个工具`gowatch`来实时的监听文件的改动并编译。 # 快速入门 ## 安装使用 ``` go get github.

阅读全文

posted @ 2020-01-13 12:36

seekrays2

阅读(1178)

推荐(0)

摘要:

我们经常在使用CLI工具的时候,都会有这样的参数输出: 可以打印出构建时对应的版本信息,比如 Version,Go Version,Git Commit等,这个是如何实现的呢? 实现 主要是通过ldflags参数来实现在构建的时候对变量进行赋值。 比如下面一段代码: 构建命令: 程序输出: 参数说明

阅读全文

posted @ 2020-01-09 21:33

seekrays2

阅读(887)

推荐(0)

摘要:

预览地址:http://demo.zzblo.com/sc/2013/11/201311131041下载地址:http://sc.zzblo.com/js/201311/79.html

阅读全文

posted @ 2013-11-13 15:07

seekrays2

阅读(157)

推荐(0)

摘要:

如果一个用户看到一个普通的404错误页面他或许不会多做一些停留。而如果一个有创造性的404页面它肯定会激发访客多做一些停留来研究这个页面。所以想让你的404页面多一些访客量停留那就在上面多一些创造性的空间。今天站长素材专门收集了50个很有趣的404创意页面,里面有一些超越性的创意和添加动画的创意 页面。收藏着对你绝对不会后悔。1.The Many Faces of2.Daniel Karcher3.dario esteban brozzi4.Audiko5.The Movie Nerd6.I Love Icons7.Molome8.Kikk Festival9.Week done10.Cent

阅读全文

posted @ 2013-11-12 12:47

seekrays2

阅读(229)

推荐(0)

摘要:

网页背景大全——花布纹网页背景下载地址:http://sc.zzblo.com/web/201311/64.html?1384138069

阅读全文

posted @ 2013-11-11 10:49

seekrays2

阅读(292)

推荐(0)

摘要:

对于二叉树:的几种遍历方式1、先序遍历:先序遍历是先输出根节点,再输出左子树,最后输出右子树。上图的先序遍历结果就是:ABCDEF2、中序遍历:中序遍历是先输出左子树,再输出根节点,最后输出右子树。上图的中序遍历结果就是:CBDAEF3、后序遍历:后序遍历是先输出左子树,再输出右子树,最后输出根节点。上图的后序遍历结果就是:CDBFEA#include #include typedef char TelemType;typedef struct TNode{TelemType data;struct TNode *lchild,*rchild;} BitNode;//声明BitNode* cr

阅读全文

posted @ 2013-10-14 21:38

seekrays2

阅读(5858)

推荐(1)

摘要:

作者:silenceper日期:2013-10-03原文地址:http://silenceper.com/archives/952.html我是在CentOS 6.3 中进行的。使用到的软件:redis2.6.16 :http://download.redis.io/releases/redis-2.6.16.tar.gztcl : http://prdownloads.sourceforge.net/tcl/tcl8.6.1-src.tar.gzphp redis 扩展:https://github.com/nicolasff/phpredisphpRedisAdmin(redis管理工具)

阅读全文

posted @ 2013-10-04 18:05

seekrays2

阅读(483)

推荐(0)

作为一名开发者,我经常为找不到之前用过的代码而烦恼。在又一次因为找代码浪费了大把时间后,我决定利用周末时间来解决这个问题。 为什么要做这个工具? 相信很多开发者都有类似的经历: 🔍 "上次那段代码到底存在哪儿了?" 📋 "糟糕,刚复制了别的内容,之前的代码丢了" 📝 "记得保存过,但是翻遍所有 阅读全文

作为一名开发者,我经常为找不到之前用过的代码而烦恼。在又一次因为找代码浪费了大把时间后,我决定利用周末时间来解决这个问题。 为什么要做这个工具? 相信很多开发者都有类似的经历: 🔍 "上次那段代码到底存在哪儿了?" 📋 "糟糕,刚复制了别的内容,之前的代码丢了" 📝 "记得保存过,但是翻遍所有 阅读全文

作为一名开发者,我经常为找不到之前用过的代码而烦恼。在又一次因为找代码浪费了大把时间后,我决定利用周末时间来解决这个问题。 为什么要做这个工具? 相信很多开发者都有类似的经历: 🔍 "上次那段代码到底存在哪儿了?" 📋 "糟糕,刚复制了别的内容,之前的代码丢了" 📝 "记得保存过,但是翻遍所有 阅读全文

作为一名开发者,我经常为找不到之前用过的代码而烦恼。在又一次因为找代码浪费了大把时间后,我决定利用周末时间来解决这个问题。 为什么要做这个工具? 相信很多开发者都有类似的经历: 🔍 "上次那段代码到底存在哪儿了?" 📋 "糟糕,刚复制了别的内容,之前的代码丢了" 📝 "记得保存过,但是翻遍所有 阅读全文

浙公网安备 33010602011771号

浙公网安备 33010602011771号