大数据常见组件zookeeper Kafka flume组件的常用操作命令

本文主要汇总了大数据常用组件zookeeper、kafka、flume的常用命令行操作

Zookeeper常用命令操作

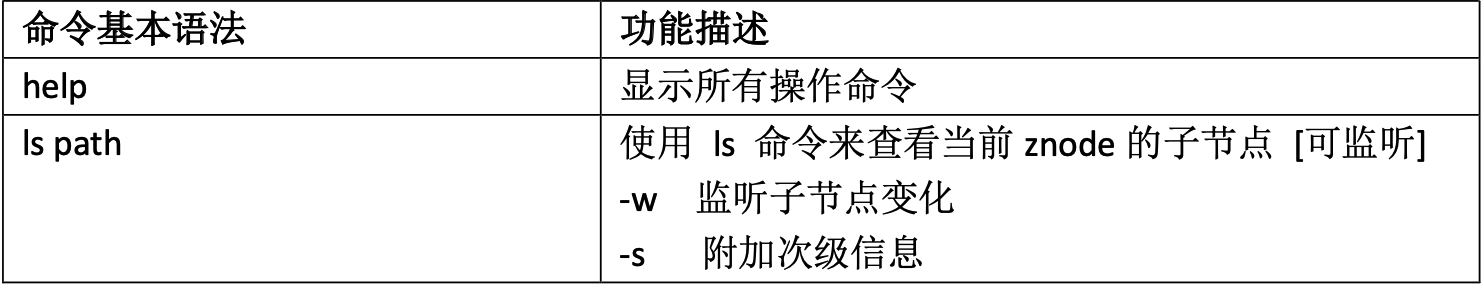

命令行语法

1)启动客户端

[atguigu@hadoop102 zookeeper-3.5.7]$ bin/zkCli.sh -server hadoop102:2181

2)显示所有操作命令

[zk: hadoop102:2181(CONNECTED) 1] help

查看节点信息

1)查看当前znode节点中所包含的信息

[zk: hadoop102:2181(CONNECTED) 0] ls / [zookeeper]

2)查看当前节点的详细信息

[zk: hadoop102:2181(CONNECTED) 5] ls -s / [zookeeper]cZxid = 0x0

ctime = Thu Jan 01 08:00:00 CST 1970 mZxid = 0x0

mtime = Thu Jan 01 08:00:00 CST 1970 pZxid = 0x0

cversion = -1

dataVersion = 0

aclVersion = 0

ephemeralOwner = 0x0

dataLength = 0

numChildren = 1

(1)czxid:创建节点的事务 zxid每次修改ZooKeeper状态都会产生一个ZooKeeper事务ID。事务ID是ZooKeeper中所 有修改总的次序。每次修改都有唯一的 zxid,如果 zxid1 小于 zxid2,那么 zxid1 在 zxid2 之 前发生。

(2)ctime:znode 被创建的毫秒数(从 1970 年开始)

(3)mzxid:znode 最后更新的事务 zxid

(4)mtime:znode 最后修改的毫秒数(从 1970 年开始)

(5)pZxid:znode 最后更新的子节点 zxid

(6)cversion:znode 子节点变化号,znode 子节点修改次数

(7)dataversion:znode 数据变化号

(8)aclVersion:znode 访问控制列表的变化号

(9)ephemeralOwner:如果是临时节点,这个是 znode 拥有者的 session id。如果不是临时节点则是 0。

(10)dataLength:znode 的数据长度

(11)numChildren:znode 子节点数量

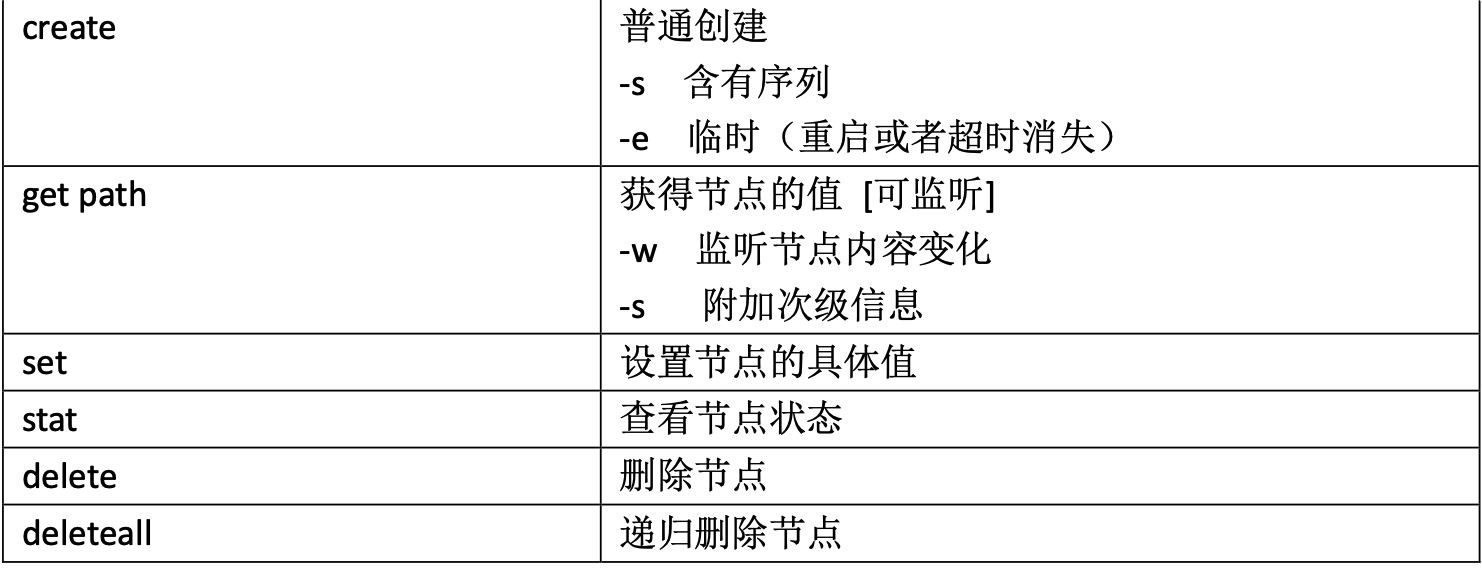

创建节点

节点主要分为四类,永久不带序号,永久带序号,临时不带序号,临时带序号节点;

永久表示客户端与zookeeper断开连接之后,该节点依旧存在;

临时表示客户端与zookeeper断开连接之后,该节点将会删除;

1)创建1个普通节点(永久+不带序号节点)

create /sanguo "diaochan"

注意:创建节点要赋值

2)获取节点值

get -s /sanguo

3)创建带序号节点(永久+带序号节点)

create -s /sanguo/weiguo "caocao"

4)创建短暂不带序号节点(短暂+不带序号节点)

create -e /sanguo/wuguo "zhouyu"

5)创建短暂带序号节点(短暂+带序号节点)

create -e -s /sanguo/wuguo "zhouyu"

6)修改节点值

set /sanguo/weiguo "simayi"

Kafka常用命令操作

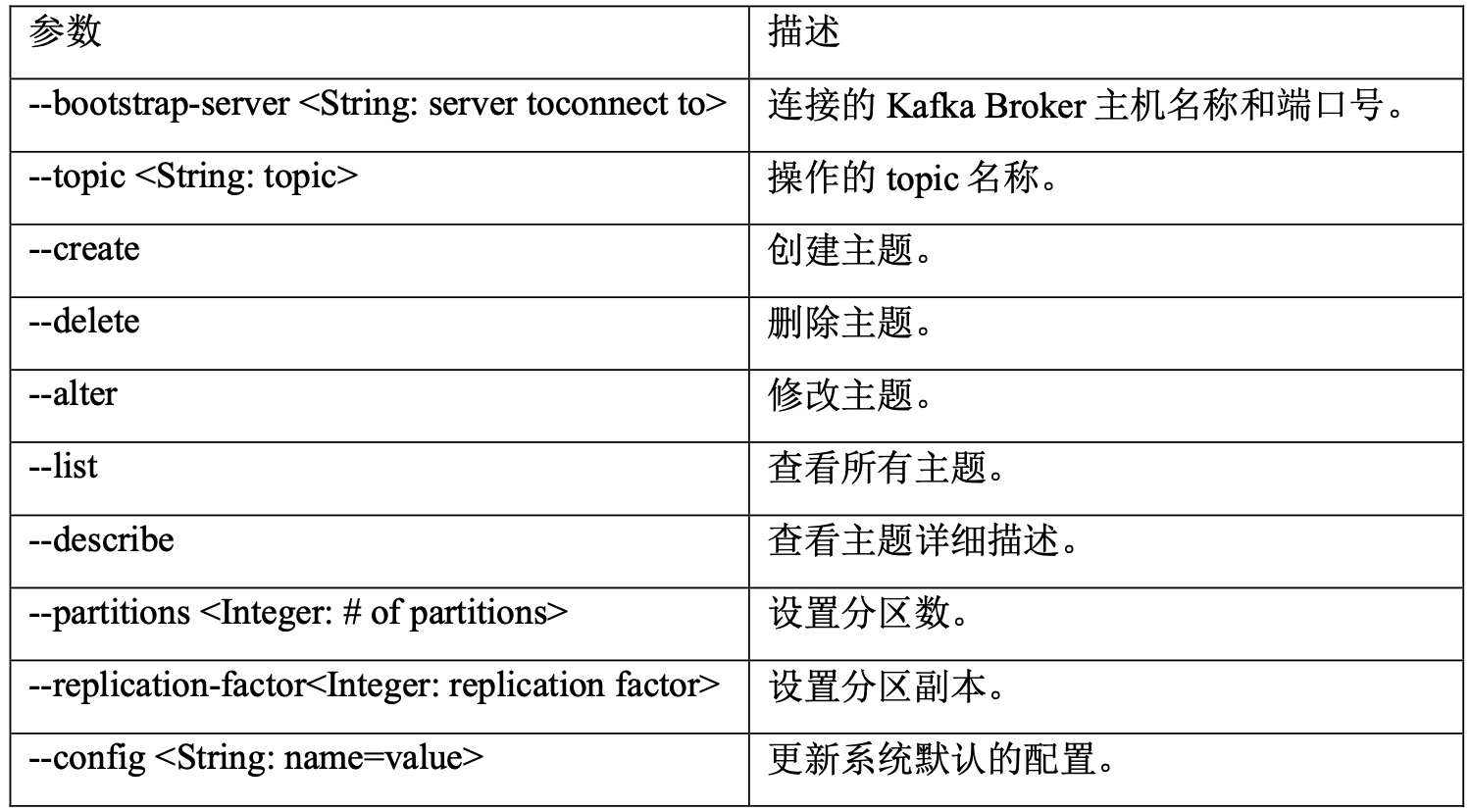

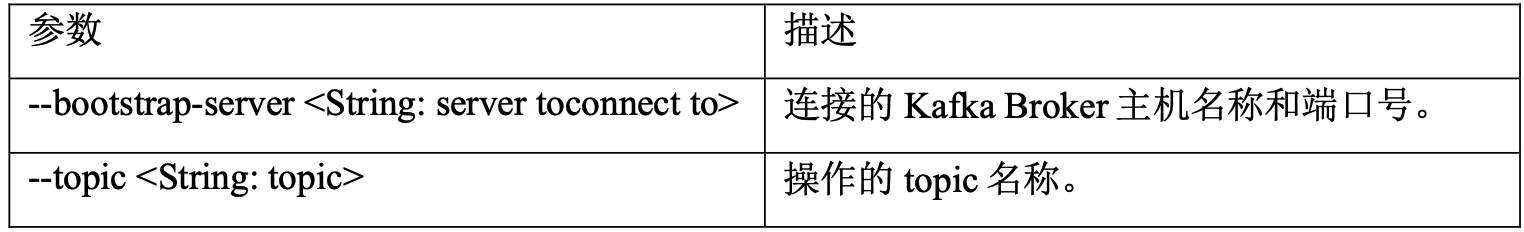

主题命令操作

均在组件根目录下面的操作

1)查看命令

bin/kafka-topics.sh

2)查看服务器所有topic

bin/kafka-topics.sh --bootstrap-server hadoop102:9092 --list

3)创建first topic

bin/kafka-topics.sh --bootstrap-server hadoop102:9092 --create --partitions 1 --replication-factor 3 --topic first

4)查看first主题详情

bin/kafka-topics.sh --bootstrap-server hadoop102:9092 --describe --topic first

5) 修改分区

bin/kafka-topics.sh --bootstrap-server hadoop102:9092 --alter --topic first --partitions 3

6)删除主题

bin/kafka-topics.sh --bootstrap-server hadoop102:9092 --delete --topic first

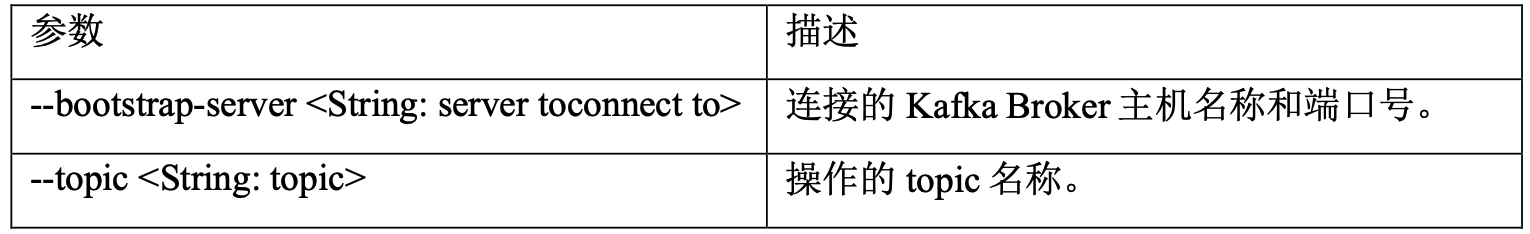

生产者命令行操作

1)查看操作生产者命令参数

bin/kafka-console-producer.sh

2)发送消息

bin/kafka-console-producer.sh --bootstrap-server hadoop102:9092 --topic first

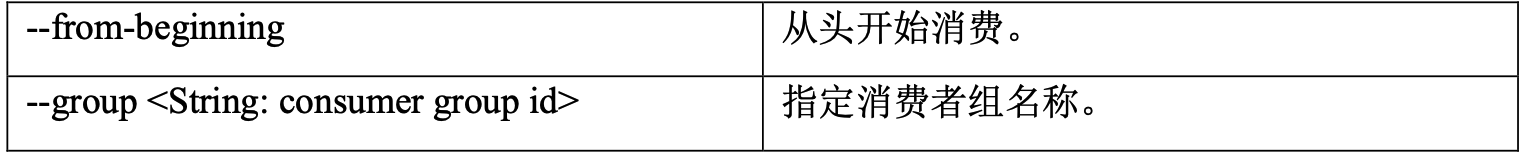

消费者命令行操作

1)查看消费者操作命令

bin/kafka-console-consumer.sh

2)消费信息

(1)消费first主题中的数据

bin/kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --topic first

(2)把主题中的所有数据都读取出来(包括历史数据)

bin/kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --from-beginning --topic first

flume常用命令

1)启动命令

/bin/flume-ng agent --name a1 --conf-file conf/file-flume-kafka.conf &

2)隐藏输出控制台信息

nohup /opt/module/flume/bin/flume-ng agent --conf-file /opt/module/flume/conf/kafka-flume-hdfs.conf --name a1 -Dflume.root.logger=INFO,LOGFILE >/opt/module/flume/log2.txt 2>&1 &

浙公网安备 33010602011771号

浙公网安备 33010602011771号