利用wget命令实现爬虫的简单抓取

wget命令相信很多人并不陌生,但是绝大多数仅仅是利用它下载文件使用。其实它还有个作用,就是爬取数据。

它虽然不如Python,Java手写代码那么灵活,但是对于需求简单的,用这个足够了。

话不多说,首先上抓取命令(以抓取博客园为例):

wget -o /tmp/wget.log -P /root/data --no-parent --no-verbose -m -D www.cnblogs.com -N --convert-links --random-wait -A html,HTML,shtml,SHTML https://www.cnblogs.com/

上面命令直接在linux执行,就能实现抓取。

参数解释:

-o:存放日志路径。

-P:存放数据目录。

--no-parent: 不追溯至父目录。

--no-verbose:关闭详尽输出,但不进入安静模式。

-m:-N -r -l inf --no-remove-listing 的缩写形式。

-D:逗号分隔的可接受的域列表。

-N:只获取比本地文件新的文件。

--convert-links:让下载得到的 HTML 或 CSS 中的链接指向本地文件。

--random-wait:随机等待时间。

-A:逗号分隔的可接受的扩展名列表。

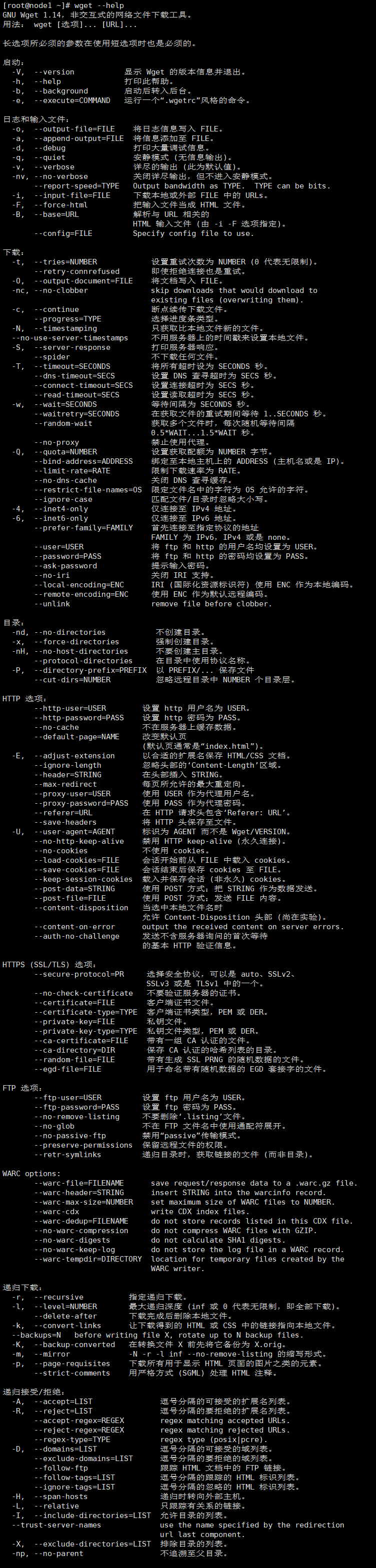

这里仅仅列出了上面用到的命令,其它的wget命令可以使用wget --help来查看。

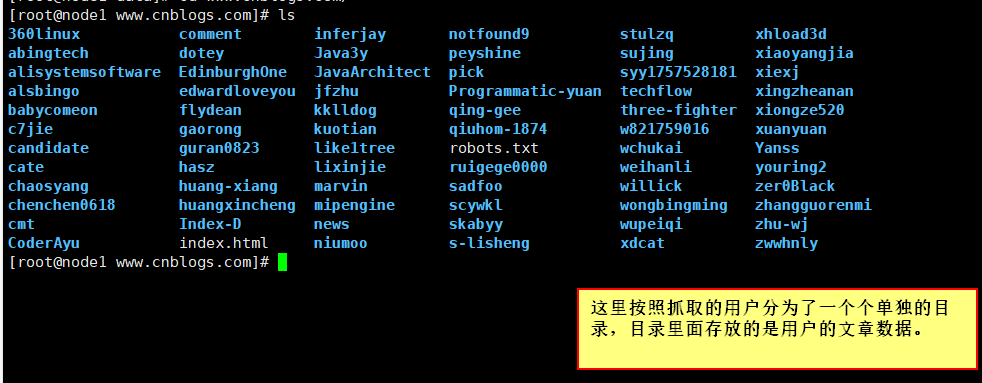

最后放下抓取效果:

百闻不如一见,百见不如一做,只有做了,才知道问题出现在哪儿,才能去解决问题。