梯度下降法-7.总结

1. 梯度下降方法比较

- 批量梯度下降法(Batch Gradient Descent)

- 随机梯度下降法(Stochastic Gradient Descent)

- 小批量梯度下降法(mini-Batch Gradient Desent)

之前我们讲解了两种梯度下降法,一种为批量梯度下降法,每一次下降过程所有样本都要参与,特点是求解的速度比较慢,但是稳定,一定会向损失函数下降的最快的方向前进,而另一种为随机梯度下降法,每一次下降的过程是针对某一个样本,特点是求解速度快,但是不稳定,每一次的方向是不确定的,甚至会向梯度下降的反方向移动,所以我们可以结合这两种方法的优缺点,每次取k个样本进行梯度下降,这种方法称为小批量梯度下降法

2. 随机的好处:

- 跳出局部最优解

- 更快的运行速率

机器学习领域很多算法都会使用到随机的特点:随机搜索,随机森林

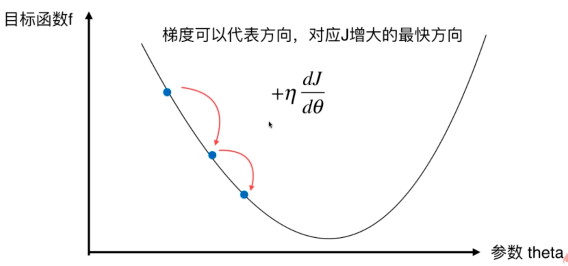

3. 梯度上升法

梯度下降法解决的是最小化损失函数,与之对应的是梯度上升法,解决的是最大化效用函数: