0 对抗样本

本系列笔者将对自己的对抗样本学习做一个全面地整理与总结。

定义

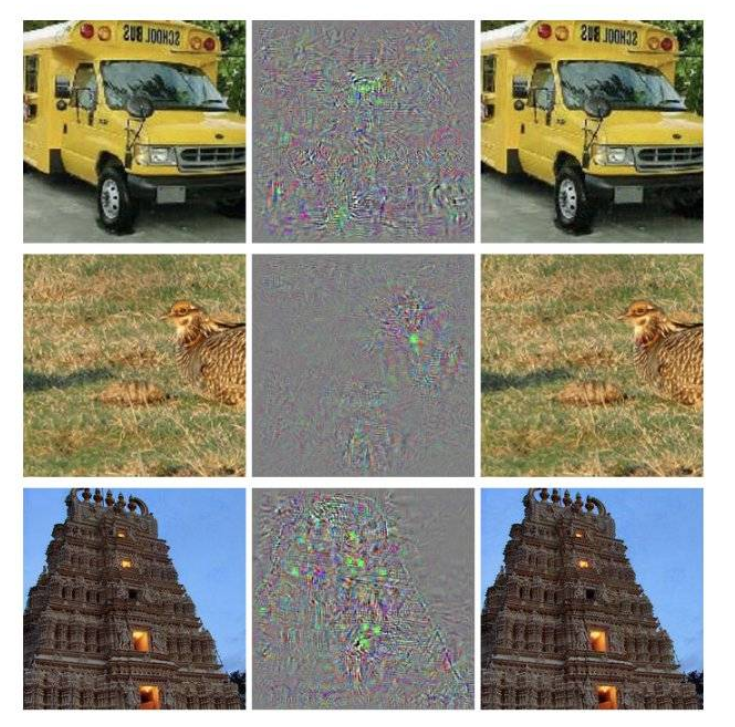

对抗样本指的是攻击者故意设计的,被用来输入到机器学习模型里,引发模型出错的值,它就像是让机器在视觉上产生幻觉一样。由于神经网络学习到的那个函数是不连续的,只需要在原始图片上做微小的扰动,就能让处理后的图片以很高的置信度被错误分类,甚至能让处理后的图片被分类一个指定的标签,这样的图片被称为对抗样本。如下图所示,左边的一列是原始图片,中间是加入的噪声,右边一列是处理后的对抗样本。

发展历史

对抗样本的概念在2013年提出,随后的五年里,领域内学者证明了对抗样本对各种算法效果的影响。2014年,Goodfellow对生成对抗样本的方法及相关知识进行了对比和论述,并对方法进行了优化。2016年,kurakin等人对对抗样本对机器学习系统的影响进行了证明。随后,在2017年,Huang等人在论文中证明了现阶段广泛使用的强化学习算法,比如DQN、TRPO和A3C,在“对抗样本”面前都十分脆弱。

主要事件

|

年份 |

事件 |

相关论文/Reference |

|

2013 |

提出了对抗样本的概念 |

Szegedy C, Zaremba W, Sutskever I, et al. Intriguing properties of neural networks[J]. arXiv preprint arXiv:1312.6199, 2013. |

|

2014 |

对生成对抗样本的方法及相关知识进行了比较和论述,并提出了一些新的生成对抗样本的方法 |

Goodfellow I J, Shlens J, Szegedy C. Explaining and harnessing adversarial examples[J]. arXiv preprint arXiv:1412.6572, 2014. |

|

2016 |

证明了对抗样本对机器学习系统的影响 |

Kurakin A, Goodfellow I, Bengio S. Adversarial examples in the physical world[J]. arXiv preprint arXiv:1607.02533, 2016. |

|

2017 |

论文中证明了现阶段广泛使用的增强学习算法,比如DQN、TRPO和A3C,在“对抗样本”面前都十分脆弱。 |

Huang S, Papernot N, Goodfellow I, et al. Adversarial attacks on neural network policies[J]. arXiv preprint arXiv:1702.02284, 2017. Behzadan V, Munir A. Vulnerability of deep reinforcement learning to policy induction attacks[C]//International Conference on Machine Learning and Data Mining in Pattern Recognition. Springer, Cham, 2017: 262-275. |

发展分析

瓶颈

对抗样本可以针对神经网络进行攻击,进而导致神经网络输出错误的结果。这样也会破坏机器学习算法的稳健性。

未来发展方向

找到合适的办法分辨对抗样本和真实样本的区别,可以有利于未来机器学习实用化的发展进程。

Reference

https://www.jiqizhixin.com/graph/technologies/c7d01434-2e7f-4b7e-9322-390aad6abb12

浙公网安备 33010602011771号

浙公网安备 33010602011771号