CDH| 组件的安装-HDFS的配置 | Flume| Kafka|

一. HDFS的参数配着

1. 修改HDFS的权限检查配置

关闭HDFS中的权限检查:dfs.permissions。

2. 配置Hadoop支持LZO

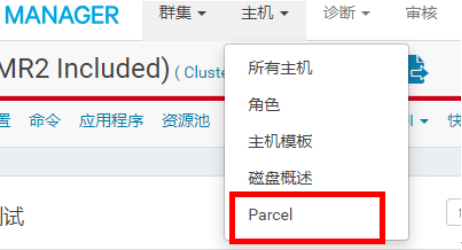

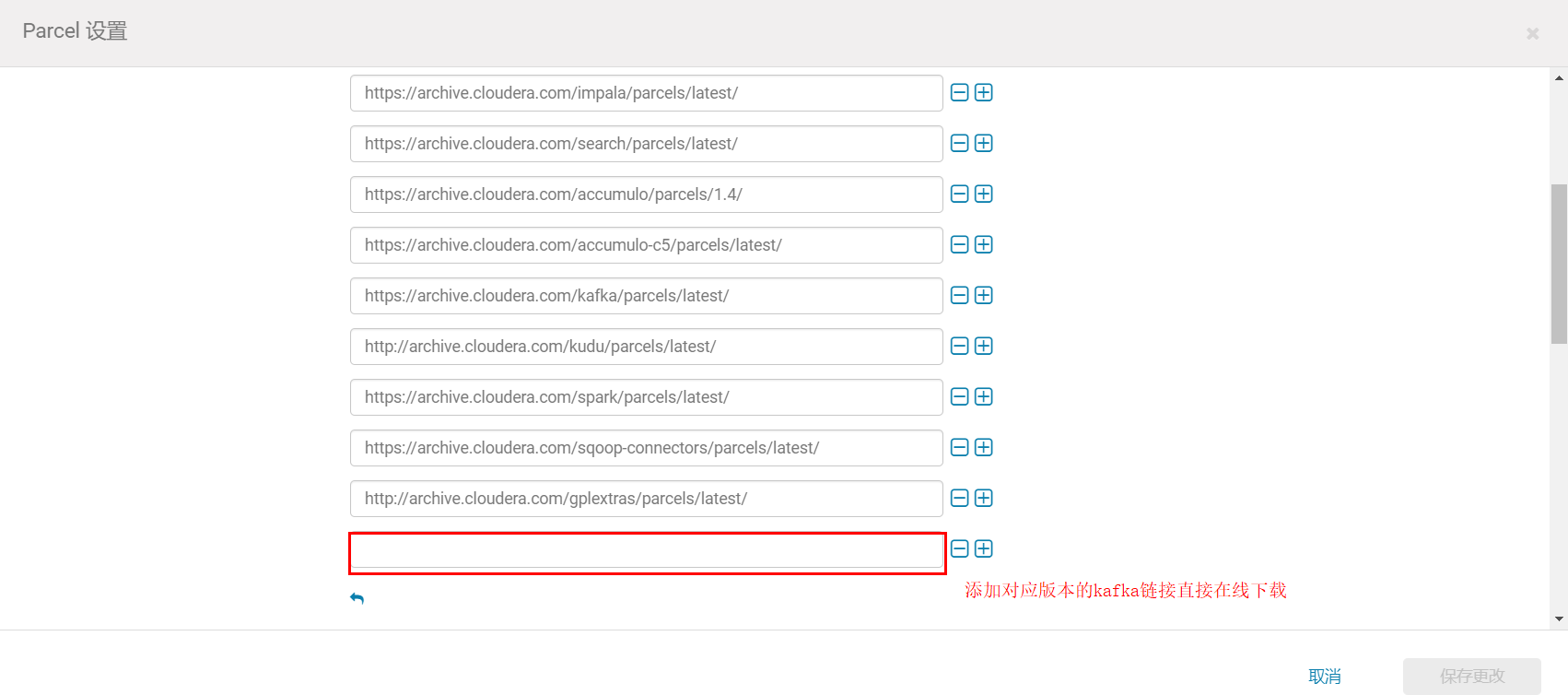

点击主机,在下拉菜单中点击Parcel

点击配置

找到远程Parcel存储库URL,点击最后一栏的加号,增加一栏,输入

http://archive.cloudera.com/gplextras/parcels/latest/,之后点击保存更改

返回Parcel列表,可以看到多出了LZO,选择下载,下载完成后选择分配,分配完成后选择激活。

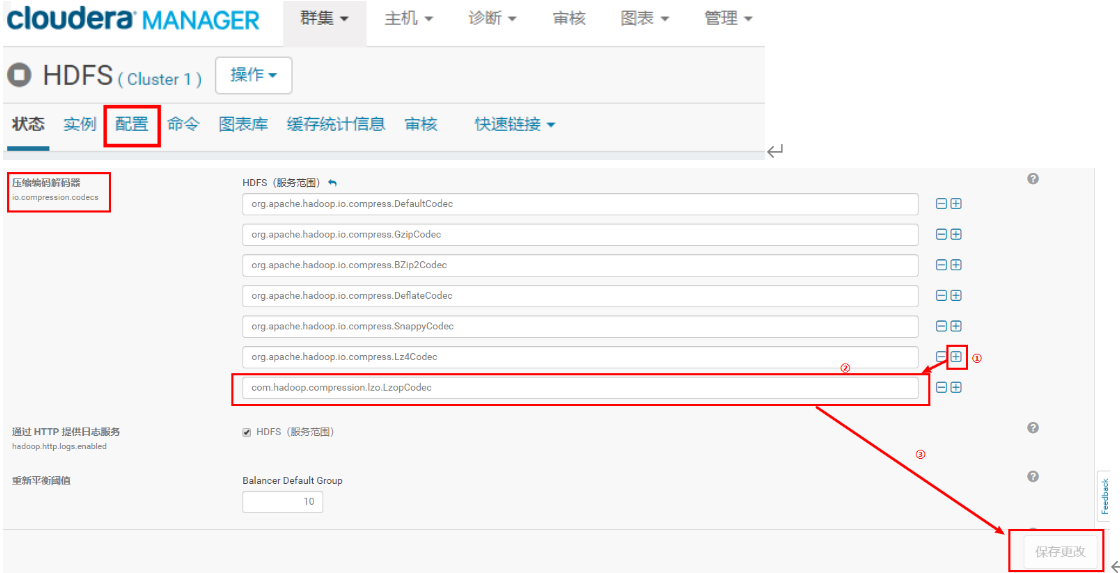

安装完LZO后,打开HDFS配置,找到“压缩编码解码器”一栏,点击加号,添加com.hadoop.compression.lzo.LzopCodec后保存更改

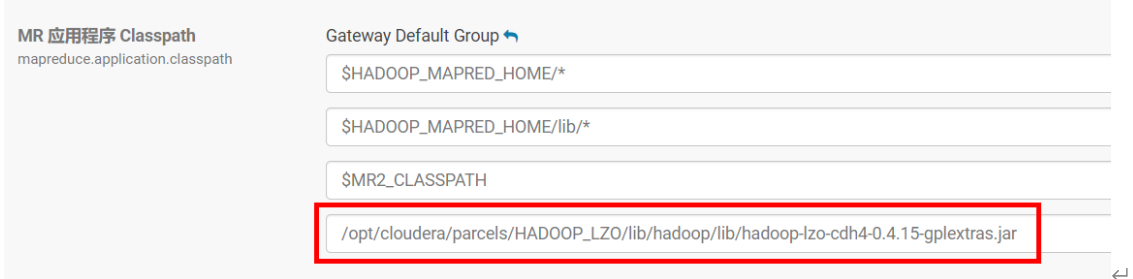

打开YARN配置,找到MR 应用程序 Classpath,添加/opt/cloudera/parcels/HADOOP_LZO/lib/hadoop/lib/hadoop-lzo-cdh4-0.4.15-gplextras.jar

更新过期配置,重启进程

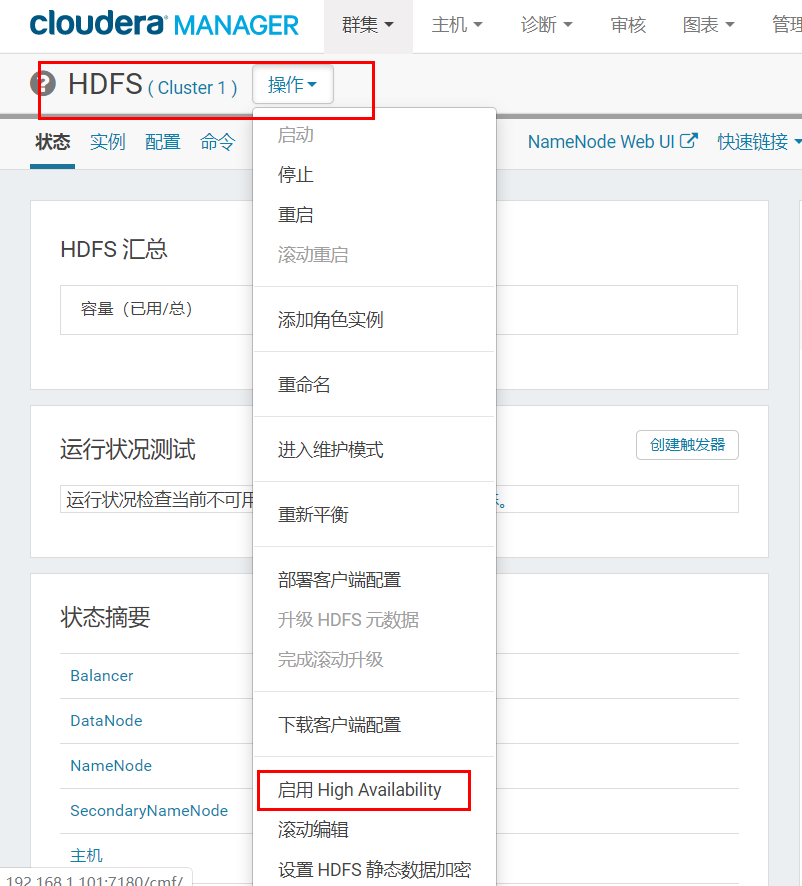

3. 配置NameNode HA

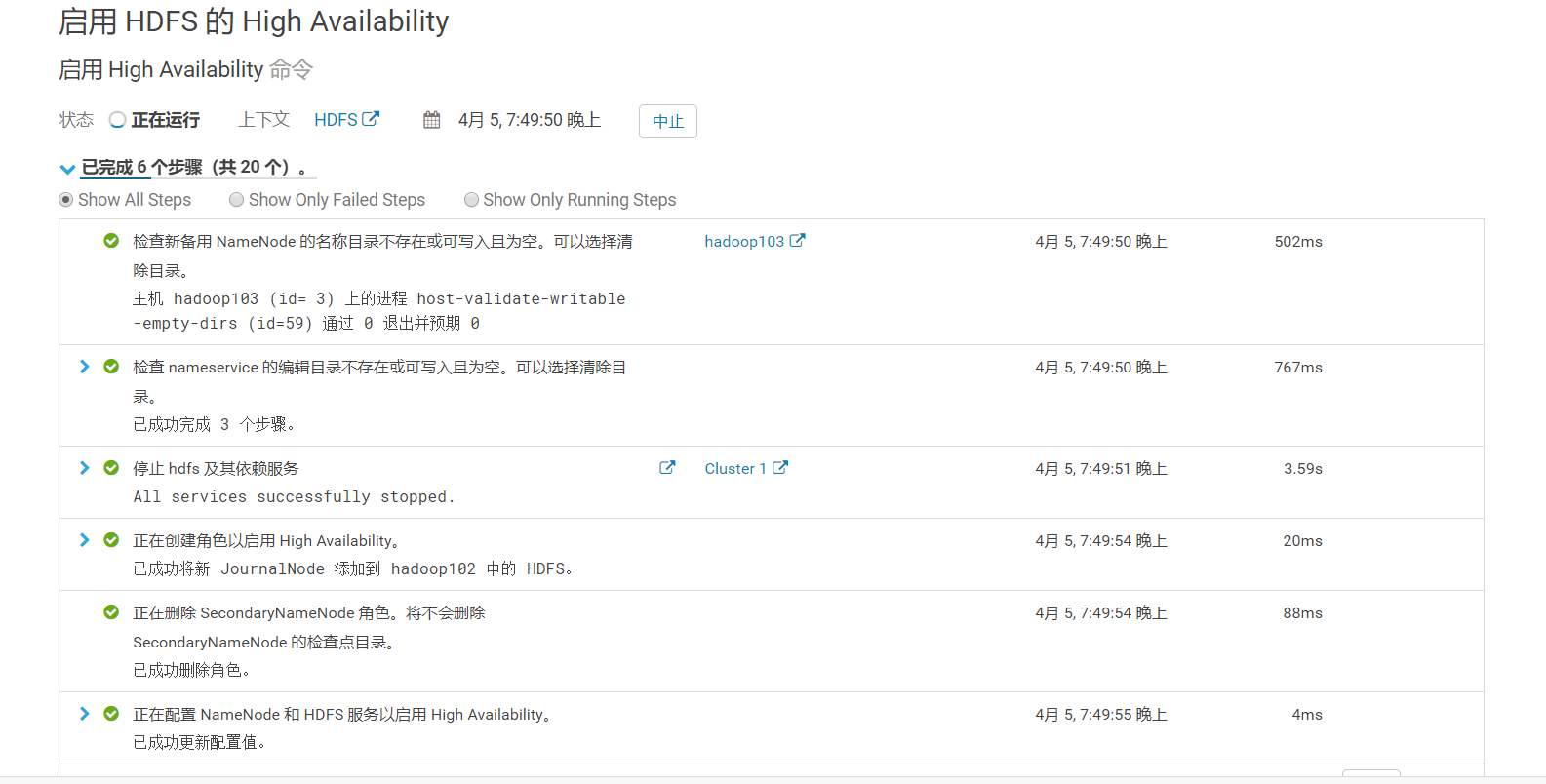

1)进入HDFS页面点击启用High Availability

2)命名

3)分配角色

4)审核更改

5)等待启动服务

二. Flume安装

1. 日志采集Flume安装

三. Kafka安装

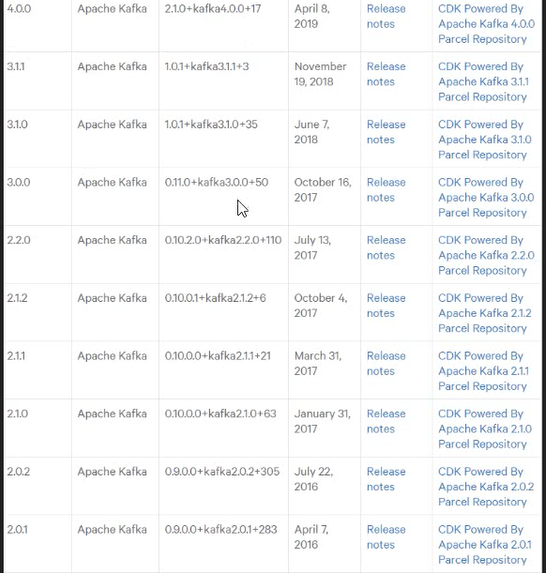

可以选择在线安装和离线包安装,在线安装下载时间较长,离线包安装时间较短。这里我们为了节省时间,选择离线安装。

方式一直接点击下载,但是版本问题

方式二:

方式三:离线安装

csd包: http://archive.cloudera.com/csds/kafka/

parcel包: http://archive.cloudera.com/kafka/parcels/3.0.0/

1)在hadoop101上创建/opt/cloudera/csd目录

[root@hadoop101 parcel-repo]# mkdir -p /opt/cloudera/csd

2)上传KAFKA-1.2.0.jar到/opt/cloudera/csd目录,并修改所有者和所有者的组

[root@hadoop101 cloudera]# chown cloudera-scm:cloudera-scm /opt/cloudera/csd/ -R

3)上传KAFKA-4.0.0-1.4.0.0.p0.1-el6.parcel、KAFKA-4.0.0-1.4.0.0.p0.1-el6.parcel.sha1到

/opt/cloudera/parcel-repo目录,并修改KAFKA-4.0.0-1.4.0.0.p0.1-el6.parcel.sha1名称为KAFKA-4.0.0-1.4.0.0.p0.1-el6.parcel.sha

[root@hadoop101 cloudera]# ll

总用量 16

drwxr-xr-x 2 root root 4096 4月 5 20:24 csd

drwxr-xr-x 2 root root 4096 4月 5 19:39 parcel-cache

drwxr-xr-x 2 cloudera-scm cloudera-scm 4096 4月 5 19:38 parcel-repo

drwxr-xr-x 5 cloudera-scm cloudera-scm 4096 4月 5 19:39 parcels

[root@hadoop101 cloudera]# cd csd/

[root@hadoop101 csd]# ll

总用量 0

[root@hadoop101 csd]# ll

总用量 8

-rw-r--r-- 1 root root 5670 4月 5 20:26 KAFKA-1.2.0.jar

[root@hadoop101 csd]# chown cloudera-scm:cloudera-scm /opt/cloudera/csd/ -R

[root@hadoop101 csd]# ll

总用量 8

-rw-r--r-- 1 cloudera-scm cloudera-scm 5670 4月 5 20:26 KAFKA-1.2.0.jar

4)ClouderManager中选择Parcel->检查Parcel->Kafka点击分配->激活

5)ClouderManager中选择Parcel->检查Parcel->Kafka点击分配->激活

[root@hadoop101 parcel-repo]# ll

总用量 1647188

-rw-r--r-- 1 root root 1620405492 4月 5 18:14 CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel

-rw-r--r-- 1 root root 41 4月 5 18:14 CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.sha

-rw-r----- 1 root root 61986 4月 5 18:16 CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.torrent //代表已经激活

-rw-r----- 1 root root 140552 4月 5 19:38 HADOOP_LZO-0.4.15-1.gplextras.p0.123-el6.parcel

-rw-r----- 1 root root 41 4月 5 19:38 HADOOP_LZO-0.4.15-1.gplextras.p0.123-el6.parcel.sha

-rw-r----- 1 root root 188 4月 5 19:38 HADOOP_LZO-0.4.15-1.gplextras.p0.123-el6.parcel.torrent

-rw-r--r-- 1 root root 66008160 4月 5 20:34 KAFKA-3.0.0-1.3.0.0.p0.40-el6.parcel

-rw-r--r-- 1 root root 41 4月 5 20:34 KAFKA-3.0.0-1.3.0.0.p0.40-el6.parcel.sha1

-rw-r--r-- 1 root root 72312 4月 5 18:13 manifest.json

[root@hadoop101 parcel-repo]# mv /opt/cloudera/parcel-repo/KAFKA-3.0.0-1.3.0.0.p0.40-el6.parcel.sha1 KAFKA-3.0.0-1.3.0.0.p0.40-el6.parcel.sha

//所有框架都要这样改名

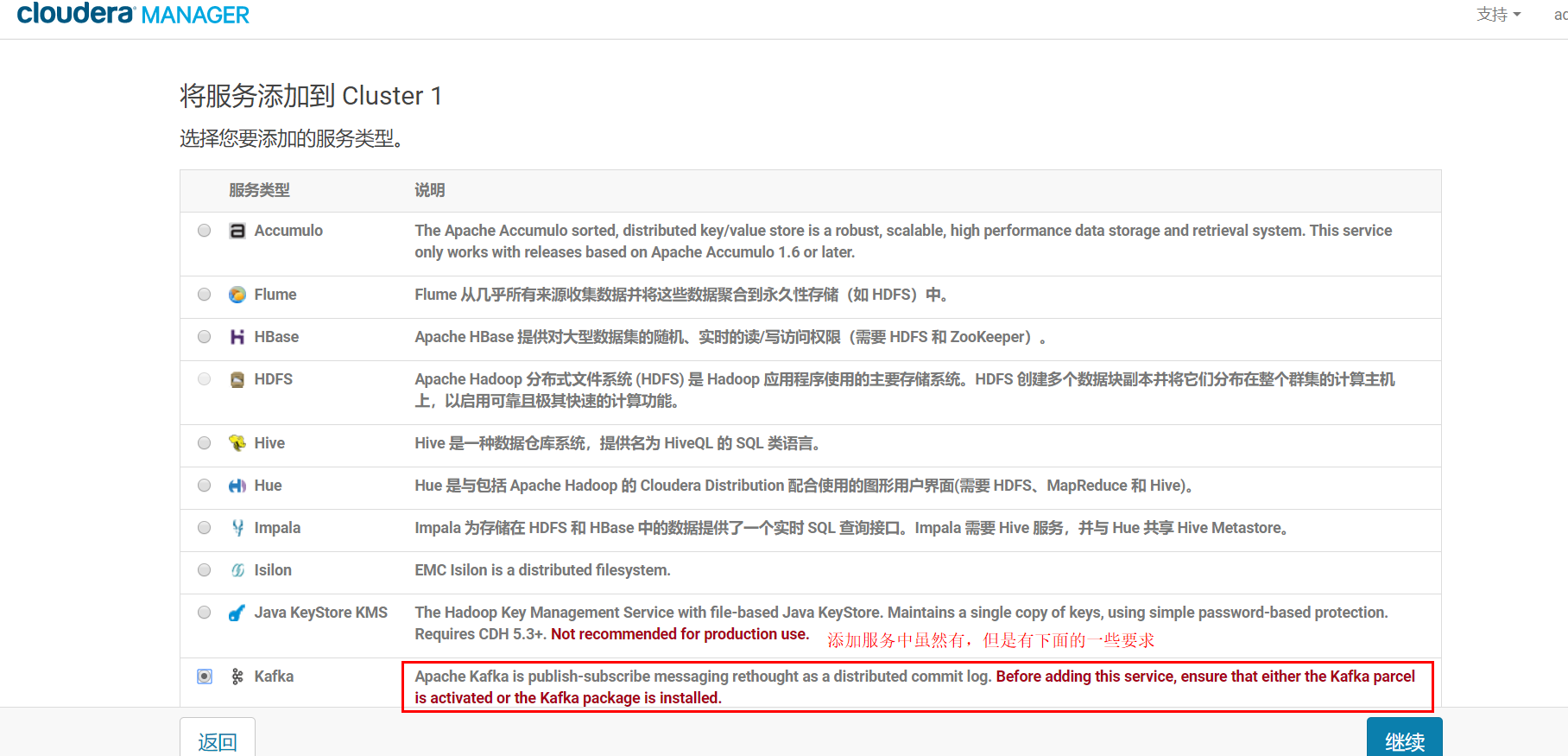

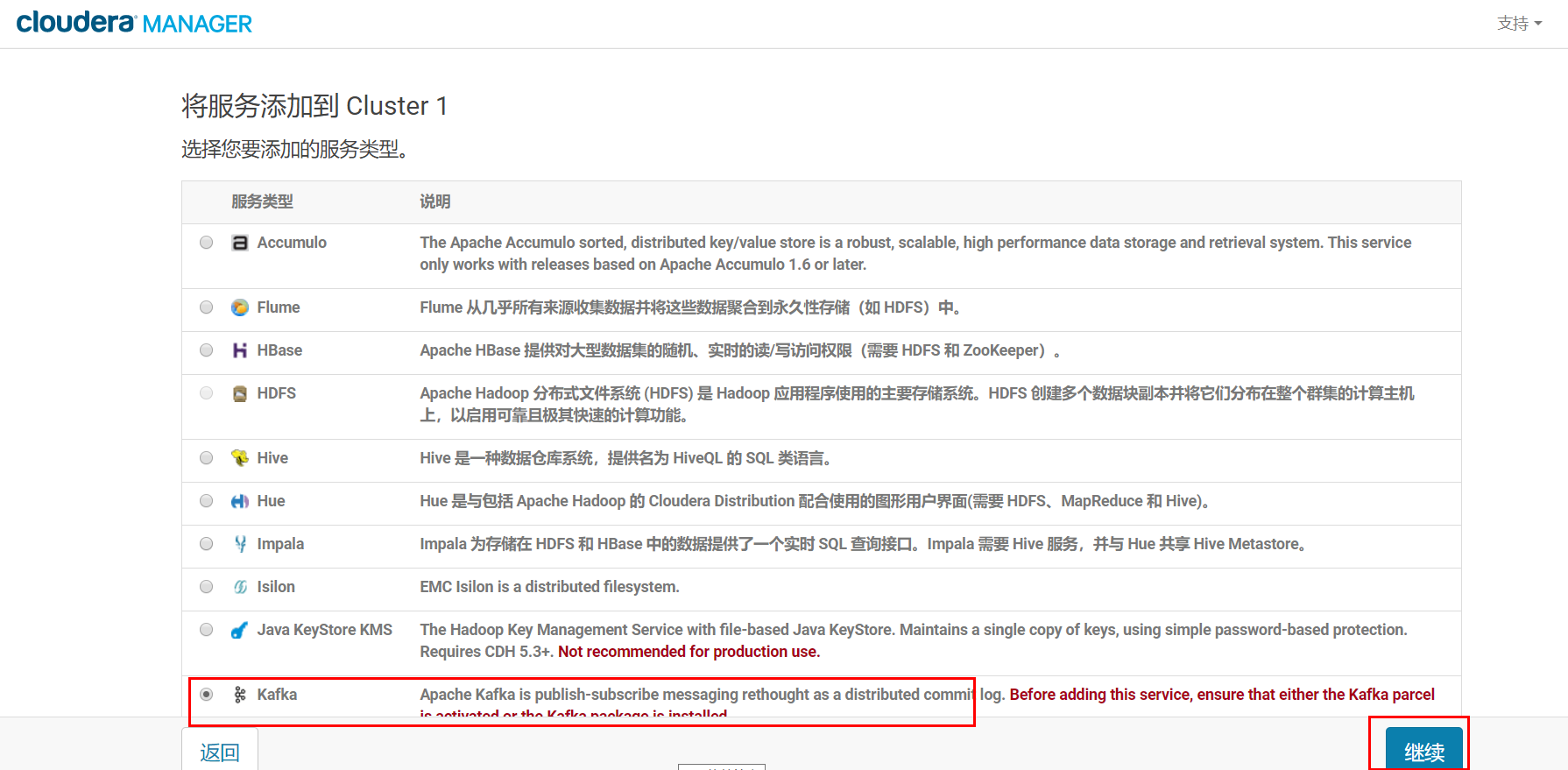

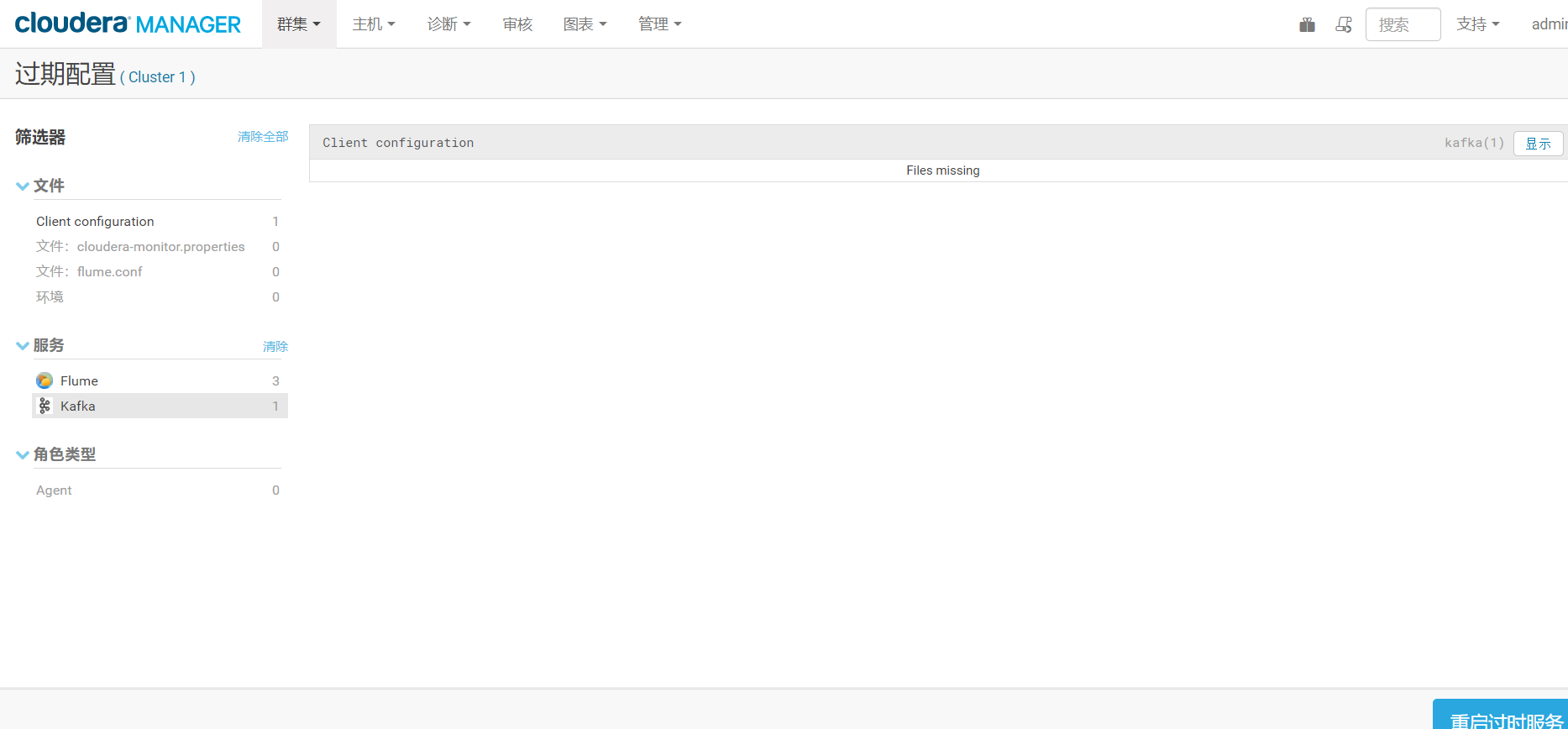

Kafka安装

回到首页,点击添加服务

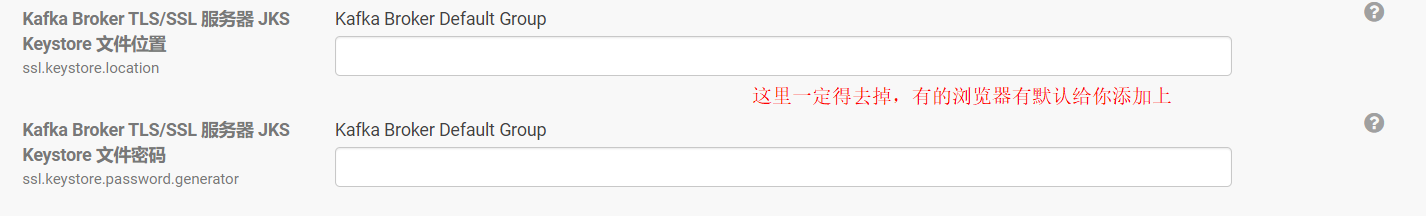

修改Kafka的堆大小为256M

Sqoop的安装

验证是否按照成功 [hdfs@hadoop104 ~]$ sqoop-list-databases --connect jdbc:mysql://hadoop104:3306 --username root -P Warning: /opt/cloudera/parcels/CDH-5.12.1-1.cdh5.12.1.p0.3/bin/../lib/sqoop/../accumulo does not exist! Accumulo imports will fail. Please set $ACCUMULO_HOME to the root of your Accumulo installation. 19/08/21 16:29:45 INFO sqoop.Sqoop: Running Sqoop version: 1.4.6-cdh5.12.1 Enter password: 19/08/21 16:29:49 INFO manager.MySQLManager: Preparing to use a MySQL streaming resultset. information_schema cm hive hue mysql oozie performance_schema test

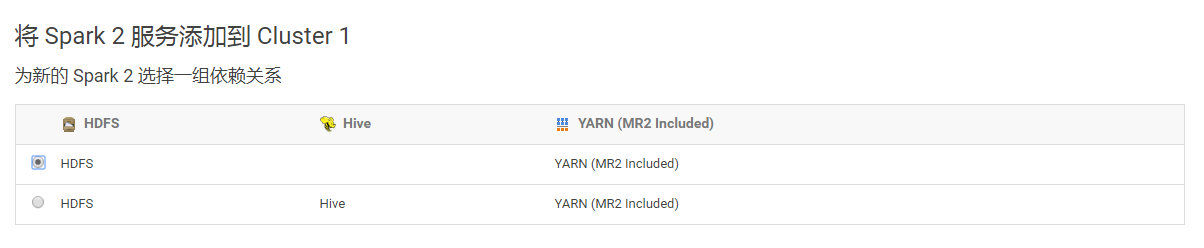

CDH5.12.1安装Spark2.1

在CDH5.12.1集群中,默认安装的spark是1.6版本,这里需要将其升级为spark2.1版本。经查阅官方文档,发现spark1.6和2.x是可以并行安装的,也就是说可以不用删除默认的1.6版本,可以直接安装2.x版本,它们各自用的端口也是不一样的。

Cloudera发布Apache Spark 2概述(可以在这里面找到安装方法和parcel包的仓库)

cloudera的官网可以下载相关的parcel 的离线安装包:https://www.cloudera.com/documentation/spark2/latest/topics/spark2_installing.html

Cloudera Manager及5.12.0版本的介绍:https://www.cloudera.com/documentation/enterprise/latest/topics/cm_ig_parcels.html#cmug_topic_7_11_5__section

升级过程

1 安装准备

1)所需软件:http://archive.cloudera.com/spark2/csd/

2)Parcels 包的下载地址:http://archive.cloudera.com/spark2/parcels/2.1.0.cloudera1/

2 安装过程

1)创建csd目录

mkdir -p /opt/cloudera/csd/

2)上传文件SPARK2_ON_YARN-2.1.0.cloudera1.jar 到 /opt/cloudera/csd/下面

3)上传文件SPARK2-2.1.0.cloudera1-1.cdh5.7.0.p0.120904-el6.parcel和SPARK2-2.1.0.cloudera1-1.cdh5.7.0.p0.120904-el6.parcel.sha1 到/opt/cloudera/parcel-repo/

4)修改所属用户及用户组:

chown -R cloudera-scm:cloudera-scm /opt/cloudera

5)将SPARK2-2.1.0.cloudera1-1.cdh5.7.0.p0.120904-el6.parcel.sha1重命名为SPARK2-2.1.0.cloudera1-1.cdh5.7.0.p0.120904-el6.parcel.sha

mv SPARK2-2.1.0.cloudera1-1.cdh5.7.0.p0.120904-el6.parcel.sha1 SPARK2-2.1.0.cloudera1-1.cdh5.7.0.p0.120904-el6.parcel.sha

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· winform 绘制太阳,地球,月球 运作规律

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· AI与.NET技术实操系列(五):向量存储与相似性搜索在 .NET 中的实现

· 超详细:普通电脑也行Windows部署deepseek R1训练数据并当服务器共享给他人