Python之爬虫相关Beautiful Soup

Python之爬虫相关Beautiful Soup

1. Beautiful Soup的简介

简单来说,Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据。官方解释如下:

Beautiful Soup提供一些简单的、python式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出一个完整的应用程序。

Beautiful Soup自动将输入文档转换为Unicode编码,输出文档转换为utf-8编码。你不需要考虑编码方式,除非文档没有指定一个编码方式,这时,Beautiful Soup就不能自动识别编码方式了。然后,你仅仅需要说明一下原始编码方式就可以了。

Beautiful Soup已成为和lxml、html6lib一样出色的python解释器,为用户灵活地提供不同的解析策略或强劲的速度。

Beautiful Soup的安装:

Beautiful Soup 3 目前已经停止开发,推荐在现在的项目中使用Beautiful Soup 4,不过它已经被移植到BS4了,也就是说导入时我们需要 import bs4 。所以这里我们用的版本是 Beautiful Soup 4.3.2 (简称BS4),另外据说 BS4 对 Python3 的支持不够好,不过我用的是 Python2.7.7,如果有小伙伴用的是 Python3 版本,可以考虑下载 BS3 版本。

1、pip安装:

pip3 install BeautifulSoup4

2、手动安装

如果想安装最新的版本,请直接下载安装包来手动安装,也是十分方便的方法。在这里我安装的是 Beautiful Soup 4.3.2

https://pypi.python.org/pypi/beautifulsoup4/4.3.2

下载完成之后解压

运行下面的命令即可完成安装

sudo python setup.py install

然后需要安装 lxml easy_install lxml/ pip install lxml 另一个可供选择的解析器是纯Python实现的 html5lib , html5lib的解析方式与浏览器相同,可以选择下列方法来安装html5lib: easy_install html5lib/ pip install html5lib

Beautiful Soup支持Python标准库中的HTML解析器,还支持一些第三方的解析器,如果我们不安装它,则 Python 会使用 Python默认的解析器,lxml 解析器更加强大,速度更快,推荐安装。

2、开启Beautiful Soup 之旅

官方文档:

http://beautifulsoup.readthedocs.io/zh_CN/latest/

例子:爬取6vhao.com的电影:

import requests from bs4 import BeautifulSoup # 下载页面 response = requests.get(url='http://www.hao6v.com/gvod/zx.html') response.encoding = 'gbk' soup = BeautifulSoup(response.text,"html.parser") div = soup.find(name='div',id='main') title=div.find(attrs={'class': 't'}).string print(title) ul=div.find(name='ul') li_list=ul.find_all(name='li') for li in li_list: a_href=li.find(name='a').get('href') a_font=li.find(name='a').text print(a_font) print(a_href) print("-----")

功能:

soup 是获得文档的对象。然后,文档被转换成 Unicode ,并且 HTML 的实例都被转换成 Unicode 编码。然后,Beautiful Soup 选择最合适的解析器来解析这段文档,如果手动指定解析器那么 Beautiful Soup 会选择指定的解析器来解析文档。但是一般最好手动指定解析器,并且使用 requests 与 BeautifulSoup 结合使用, requests 是用于爬取网页源码的一个库,此处不再介绍,requests 更多用法请参考Requests 2.10.0 文档。- 要解析的文档是什么类型: 目前支持, html, xml, 和 html5

- 指定使用哪种解析器: 目前支持, lxml, html5lib, 和 html.parser

对象的种类

Beautiful Soup 将复杂 HTML 文档转换成一个复杂的树形结构,每个节点都是 Python 对象,所有对象可以归纳为 4 种: Tag , NavigableString , BeautifulSoup , Comment .

Tag:通俗点讲就是 HTML 中的一个个标签,像上面的div,p。每个Tag有两个重要的属性name和attrs,name指标签的名字或者tag本身的name,attrs通常指一个标签的class。NavigableString:获取标签内部的文字,如,soup.p.string。BeautifulSoup:表示一个文档的全部内容。Comment:Comment对象是一个特殊类型的NavigableString对象,其输出的内容不包括注释符号.

示例

下面是一个示例,带你了解 Beautiful Soup 的常见用法:

import sys reload(sys) sys.setdefaultencoding('utf-8') from bs4 import BeautifulSoup import requests html_doc = """ <head> <meta charset="utf-8"> <meta http-equiv="X-UA-Compatible" content="IE=Edge"> <title>首页 - 简书</title> </head> <body class="output fluid zh cn win reader-day-mode reader-font2 " data-js-module="recommendation" data-locale="zh-CN"> <ul class="article-list thumbnails"> <li class=have-img> <a class="wrap-img" href="/p/49c4728c3ab2"><img src="//upload-images.jianshu.io/upload_images/2442470-745c6471c6f8258c.jpg?imageMogr2/auto-orient/strip%7CimageView2/1/w/300/h/300" alt="300" /></a> <div> <p class="list-top"> <a class="author-name blue-link" target="_blank" href="/users/0af6b163b687">阿随向前冲</a> <em>·</em> <span class="time" data-shared-at="2016-07-27T07:03:54+08:00"></span> </p> <h4 class="title"><a target="_blank" href="/p/49c4728c3ab2"> 只装了这六款软件,工作就高效到有时间逛某宝刷某圈</a></h4> <div class="list-footer"> <a target="_blank" href="/p/49c4728c3ab2"> 阅读 1830 </a> <a target="_blank" href="/p/49c4728c3ab2#comments"> · 评论 35 </a> <span> · 喜欢 95</span> <span> · 打赏 1</span> </div> </div> </li> </ul> </body> """ soup = BeautifulSoup(html_doc, 'html.parser', from_encoding='utf-8') # 查找所有有关的节点 tags = soup.find_all('li', class_="have-img") for tag in tags: image = tag.img['src'] article_user = tag.p.a.get_text() article_user_url = tag.p.a['href'] created = tag.p.span['data-shared-at'] article_url = tag.h4.a['href'] # 可以在查找的 tag 下继续使用 find_all() tag_span = tag.div.div.find_all('span') likes = tag_span[0].get_text(strip=True)

tag,例如,soup.li。如果想要得到所有的<li> 标签,或是通过名字得到比一个 tag 更多的内容的时候,就需要用到 find_all(),find_all() 方法搜索当前 tag 的所有 tag 子节点,并判断是否符合过滤器的条件find_all() 所接受的参数如下:

find_all( name , attrs , recursive , string , **kwargs )

1、 按 name 搜索: name 参数可以查找所有名字为 name 的 tag,字符串对象会被自动忽略掉:

soup.find_all("li")

2、按 id 搜索: 如果包含一个名字为 id 的参数,搜索时会把该参数当作指定名字 tag 的属性来搜索:

soup.find_all(id='link2')

3、按 attr 搜索:有些 tag 属性在搜索不能使用,比如 HTML5 中的 data-* 属性,但是可以通过 find_all() 方法的 attrs 参数定义一个字典参数来搜索包含特殊属性的 tag:

data_soup.find_all(attrs={"data-foo": "value"})

4、按 CSS 搜索: 按照 CSS 类名搜索 tag 的功能非常实用,但标识CSS 类名的关键字 class 在 Python 中是保留字,使用 class 做参数会导致语法错误.从 Beautiful Soup 的 4.1.1 版本开始,可以通过 class_ 参数搜索有指定 CSS 类名的 tag:

soup.find_all('li', class_="have-img")

5、string参数:通过string参数可以搜搜文档中的字符串内容.与name参数的可选值一样,string参数接受 字符串 , 正则表达式 , 列表,True。 看例子:

soup.find_all("a", string="Elsie")

6、recursive 参数:调用 tag 的 find_all() 方法时,Beautiful Soup 会检索当前 tag 的所有子孙节点,如果只想搜索 tag 的直接子节点,可以使用参数 recursive=False .

soup.find_all("title", recursive=False)

find_all() 几乎是 Beautiful Soup中最常用的搜索方法,也可以使用其简写方法,以下代码等价:

soup.find_all("a") soup("a")

find

find(name,attrs,recursive,text,**kwargs)

find返回的匹配结果的第一个元素

其他一些类似的用法:

find_parents()返回所有祖先节点,find_parent()返回直接父节点。

find_next_siblings()返回后面所有兄弟节点,find_next_sibling()返回后面第一个兄弟节点。

find_previous_siblings()返回前面所有兄弟节点,find_previous_sibling()返回前面第一个兄弟节点。

find_all_next()返回节点后所有符合条件的节点, find_next()返回第一个符合条件的节点

find_all_previous()返回节点后所有符合条件的节点, find_previous()返回第一个符合条件的节点

get_text()

如果只想得到 tag 中包含的文本内容,那么可以用 get_text() 方法,这个方法获取到 tag中包含的所有文版内容包括子孙 tag 中的内容,并将结果作为 Unicode 字符串返回:

tag.p.a.get_text()

如果想看更多内容,请参考 Beautiful Soup 4.4.0 文档 (中文文档)。

3、解析器

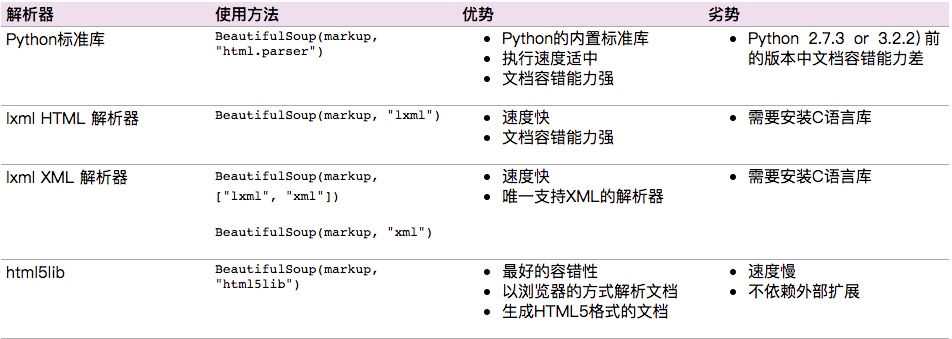

Beautiful Soup支持Python标准库中的HTML解析器,还支持一些第三方的解析器,如果我们不安装它,则 Python 会使用 Python默认的解析器,lxml 解析器更加强大,速度更快,推荐安装。

下面是常见解析器:

推荐使用lxml作为解析器,因为效率更高. 在Python2.7.3之前的版本和Python3中3.2.2之前的版本,必须安装lxml或html5lib, 因为那些Python版本的标准库中内置的HTML解析方法不够稳定.

+===================================================================+

总结

推荐使用lxml解析库,必要时使用html.parser

标签选择筛选功能弱但是速度快

建议使用find()、find_all() 查询匹配单个结果或者多个结果

如果对CSS选择器熟悉建议使用select()

记住常用的获取属性和文本值的方法

浙公网安备 33010602011771号

浙公网安备 33010602011771号