【模型部署】在C++和Python中搭建TensorRT环境

1. C++端安装

TensorRT安装过程比较简单,和OpenCV类似,特别需要注意的是与CUDA和cuDNN版本的对应。

1.1 CUDA和cuDNN版本

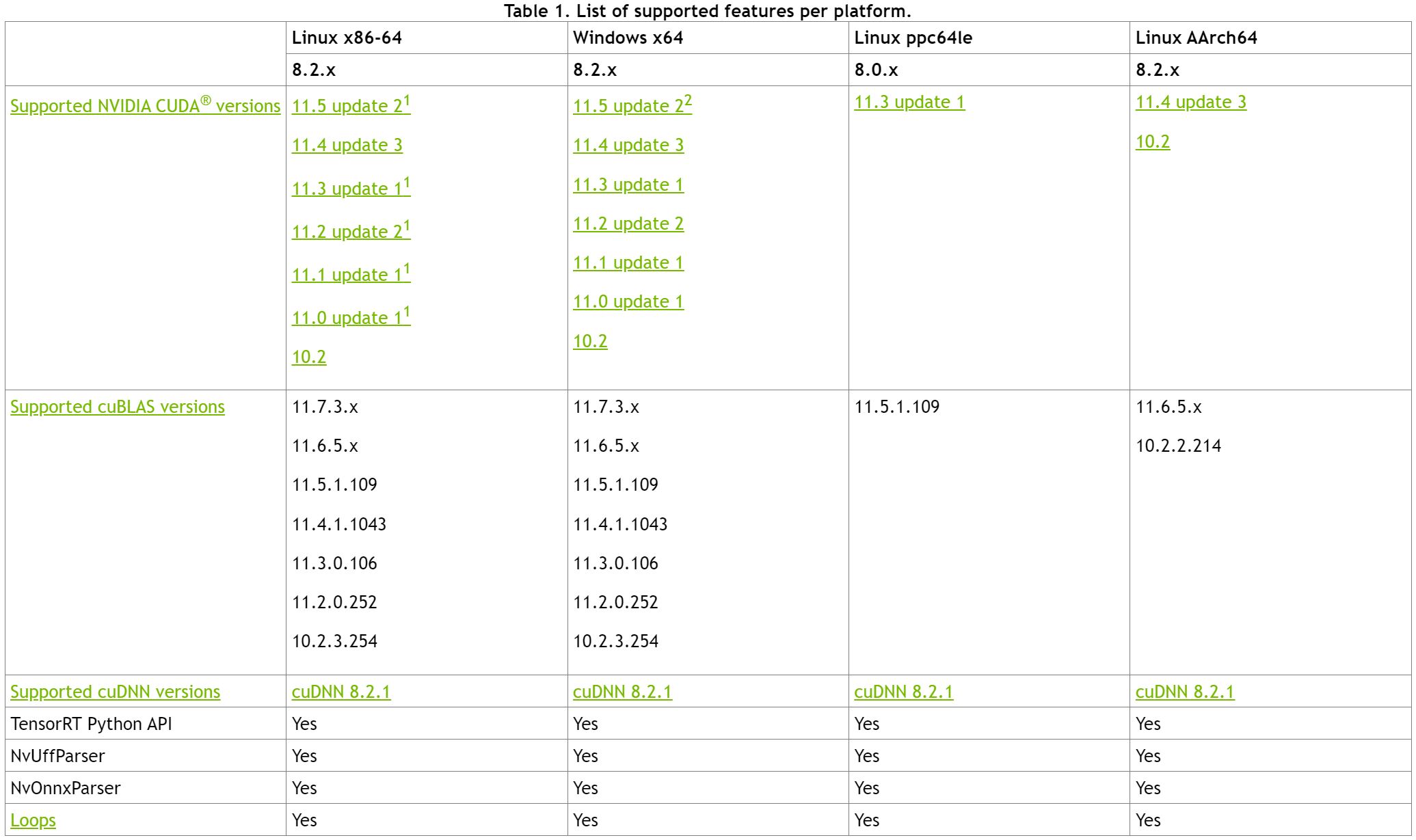

在安装TensorRT之前,请严格按照官方要求安装与TensorRT相匹配的CUDA和cuDNN。各版本安装要求可参考官方文档。以TensorRT8.2.5为例,各平台支持的CUDA和cuDNN版本如下,我下载的版本是CUDA11.3 update1 + cuDNN8.2.1

1.2 TensorRT下载

官网下载链接:https://developer.nvidia.com/nvidia-tensorrt-download(需要注册NVIDIA账号)

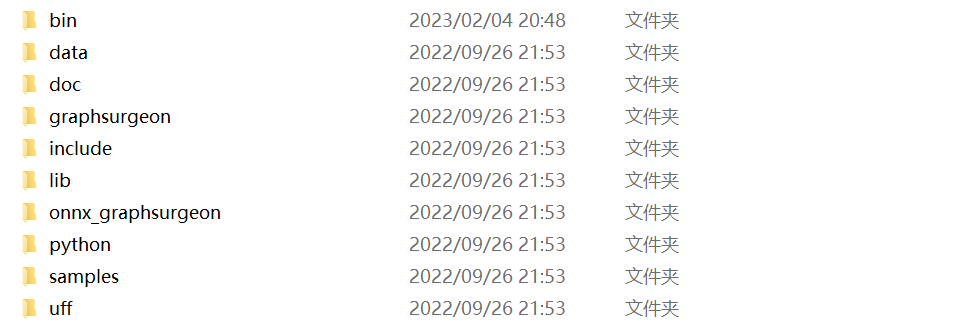

点击上边网址,下载想要版本的安装包,解压后如下

1.3 Path环境变量

![]()

1.4 VS中配置

VC++目录包含目录:

![]()

VC++目录库目录:

![]()

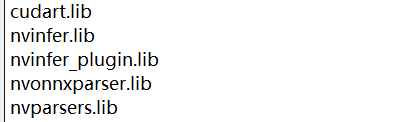

链接器输入:

2. Python端安装

打开TensorRT安装包中的python文件夹,这里提供了不同python版本的TensorRT包

进入当前使用的python环境下安装

1 | pip install D:\TensorRT-8.2.5.1\python\tensorrt-8.2.5.1-cp38-none-win_amd64.whl |

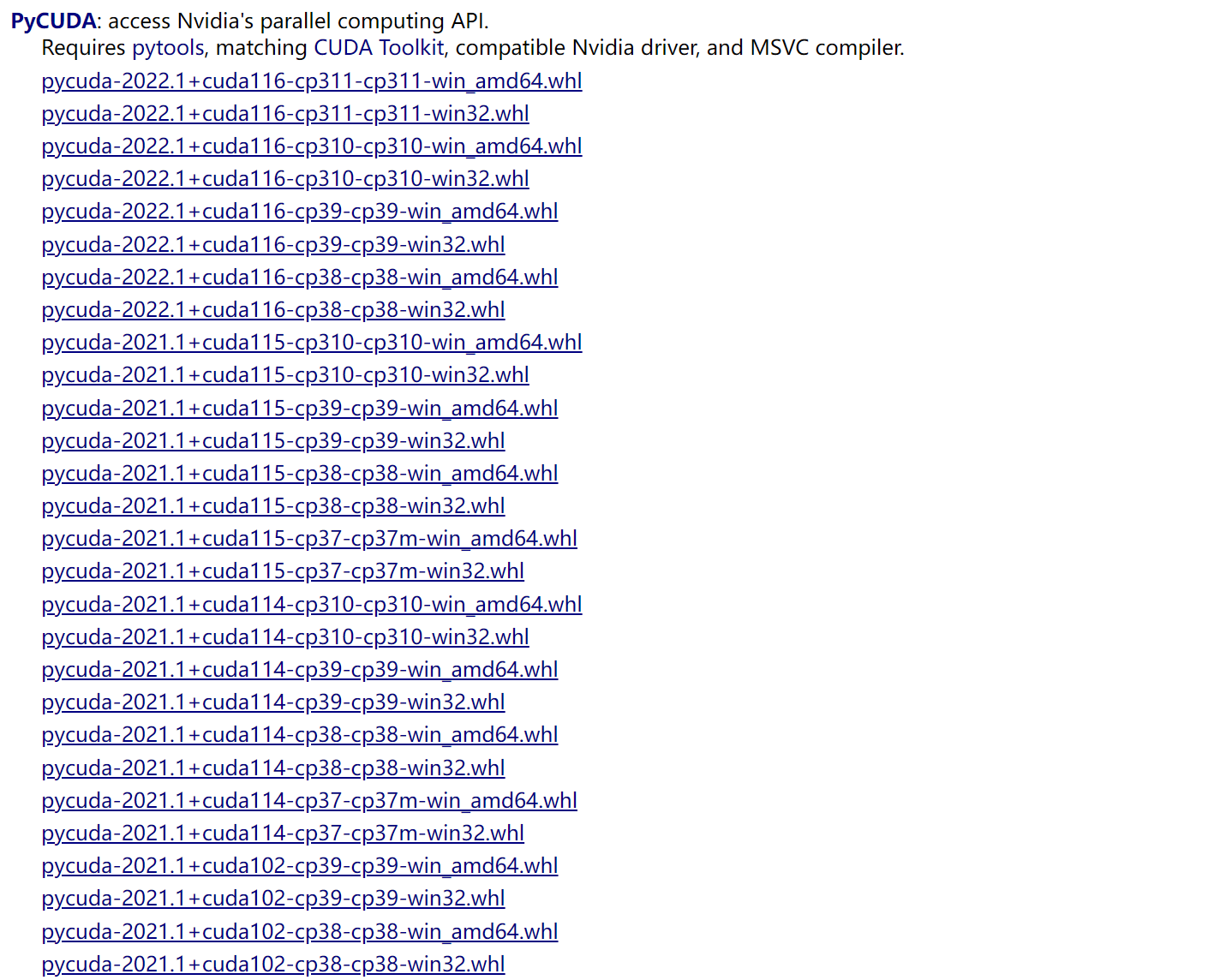

另外还需要安装pycuda,这里pip install pycuda老是失败,可以先在下边网站下载好安装包,再进行安装

官方下载地址:https://pypi.org/project/pycuda/#description

第三方地址:https://www.lfd.uci.edu/~gohlke/pythonlibs/#pycuda(下载速度快)

下载完成,进入python环境安装

1 | pip install D:\pycuda-2021.1+cuda114-cp38-cp38-win_amd64.whl |

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· ollama系列1:轻松3步本地部署deepseek,普通电脑可用

· 按钮权限的设计及实现

· Apache Tomcat RCE漏洞复现(CVE-2025-24813)