爬虫基础

1.利用requests.get(url)获取网页页面的html文件

import requests

newsurl='http://news.gzcc.cn/html/xiaoyuanxinwen/'

res = requests.get(newsurl) #返回response对象

res.encoding='utf-8'

2.利用BeautifulSoup的HTML解析器,生成结构树

from bs4 import BeautifulSoup

soup = BeautifulSoup(res.text,'html.parser')

3.找出特定标签的html元素

soup.p #标签名,返回第一个

soup.head

soup.p.name #字符串

soup.p. attrs #字典,标签的所有属性

soup.p. contents # 列表,所有子标签

soup.p.text #字符串

soup.p.string

soup.select(‘li')

4.取得含有特定CSS属性的元素

soup.select('#p1Node')

soup.select('.news-list-title')

5.练习:

取出h1标签的文本

取出a标签的链接

取出所有li标签的所有内容

取出第2个li标签的a标签的第3个div标签的属性

取出一条新闻的标题、链接、发布时间、来源

import requests

from bs4 import BeautifulSoup

re =requests.get('http://news.gzcc.cn/html/xiaoyuanxinwen/')

re.encoding='utf-8'

soup=BeautifulSoup(re.text,'html.parser')

for h1 in soup.find_all('h1'):

print(h1.text)

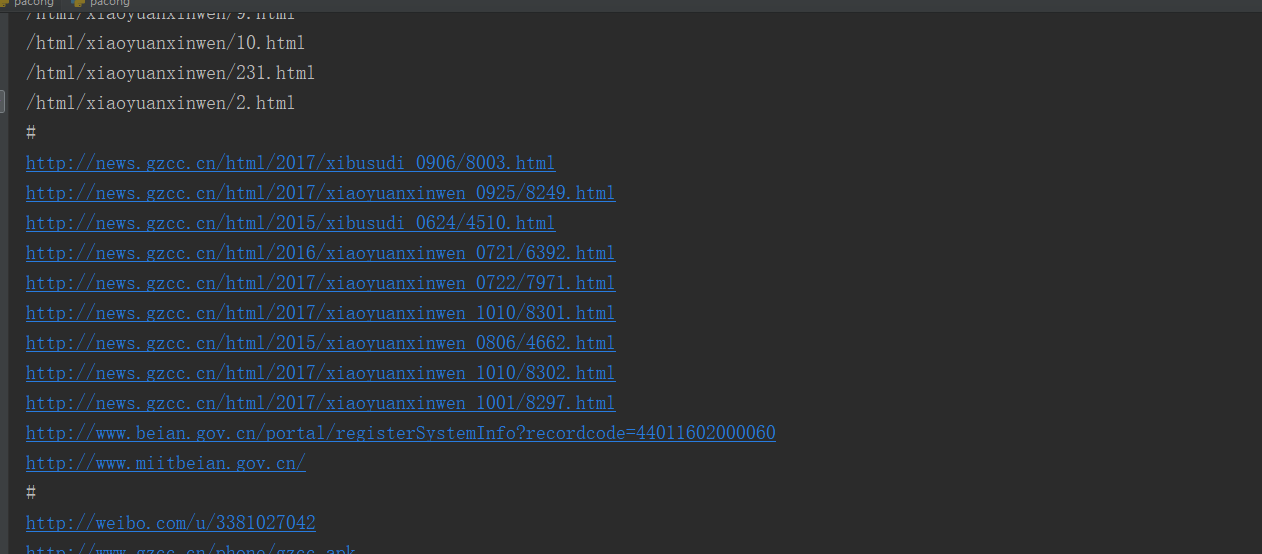

for a in soup.find_all('a'):

print(a.attrs.get('href'))

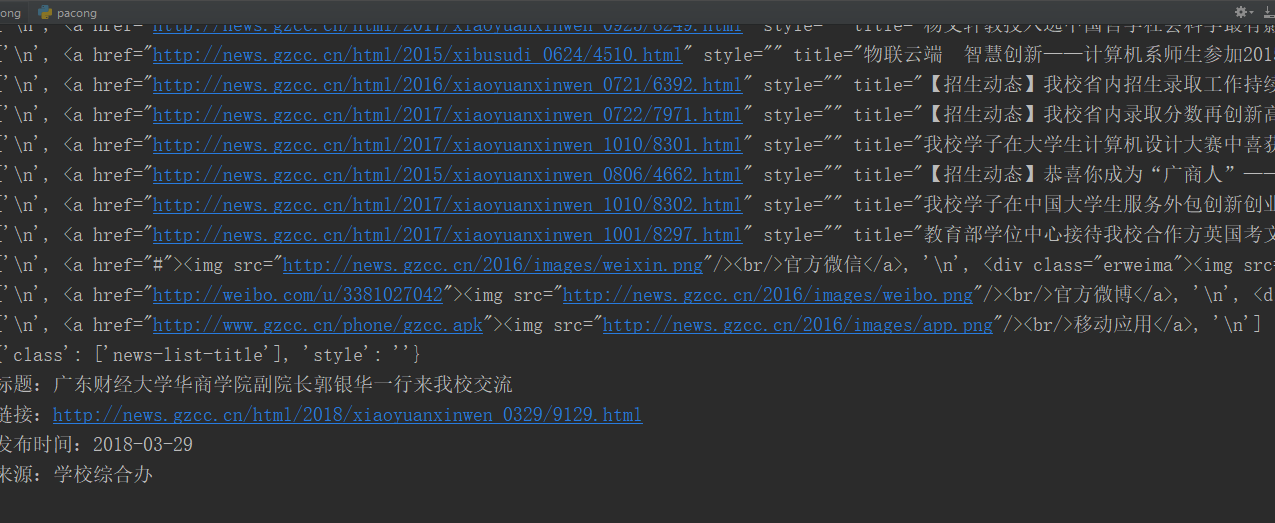

for li in soup.find_all('li'):

print(li.contents)

print(soup.find_all('li')[8].a.find_all('div')[2].attrs)

print('标题:'+soup.select('.news-list-title')[1].text)

print('链接:'+soup.select('a')[13]['href'])

print('发布时间:'+soup.select('.news-list-info')[1].span.text)

print('来源:'+soup.select('.news-list-info')[1].select('span')[1].text)

浙公网安备 33010602011771号

浙公网安备 33010602011771号