五, Hive-数据的导入和导出

五, Hive-数据的导入和导出

5.1 数据导入

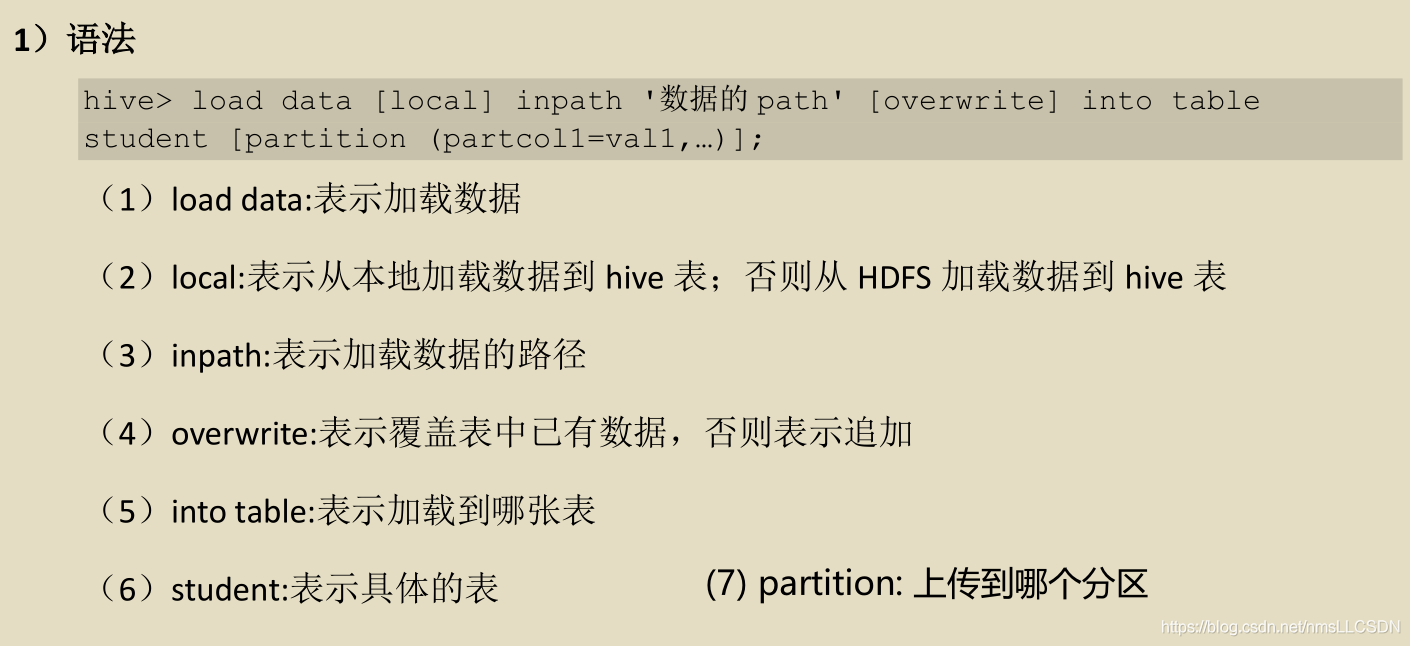

法1, 向表中装载数据(load)

[案例实操]

-

创建表

-

加载本地文件到此表中

-

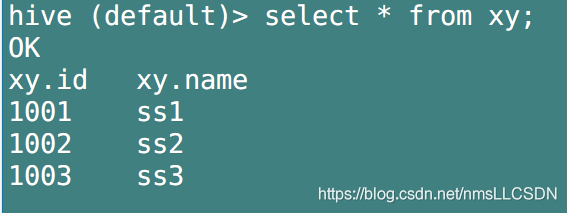

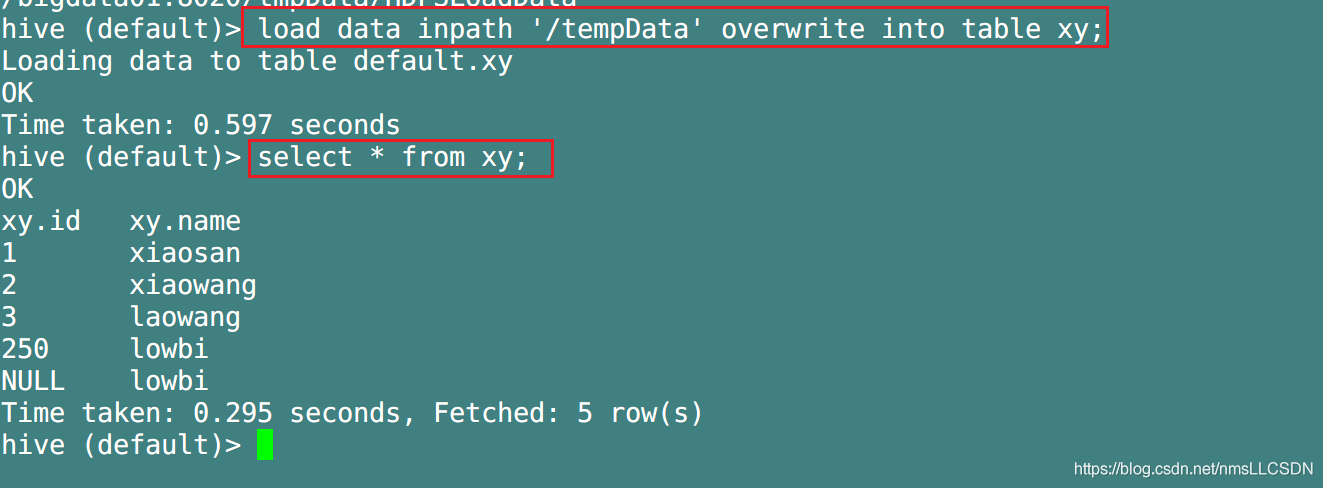

加载HDFS文件到此表中不进行覆盖

执行load之后, HDFS的inpat路径中就不再含有这个数据文件, 因为这个文件被移动到hdfs中存储hive数据的目录中(在hdfs中默认路径为 /user/hive/warehouse/表名)去了.

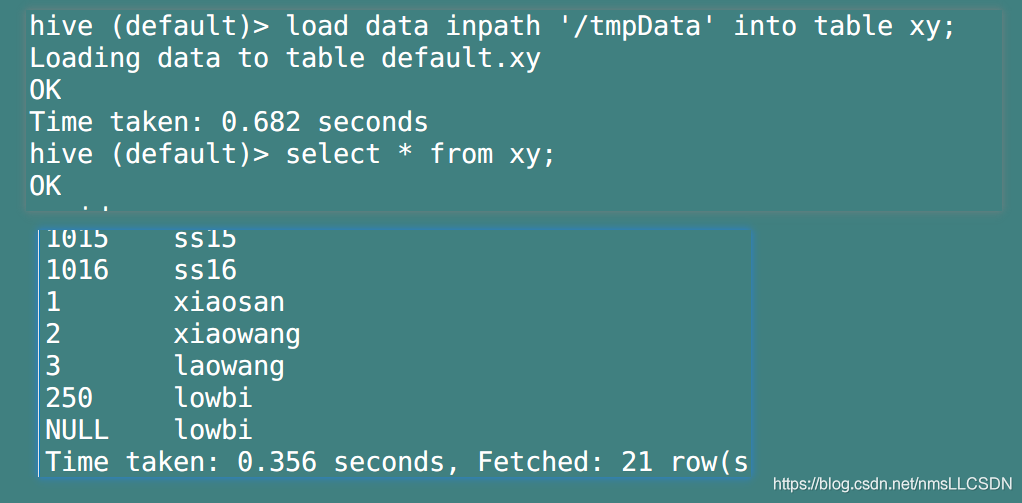

- 加载HDFS文件到此表中进行覆盖

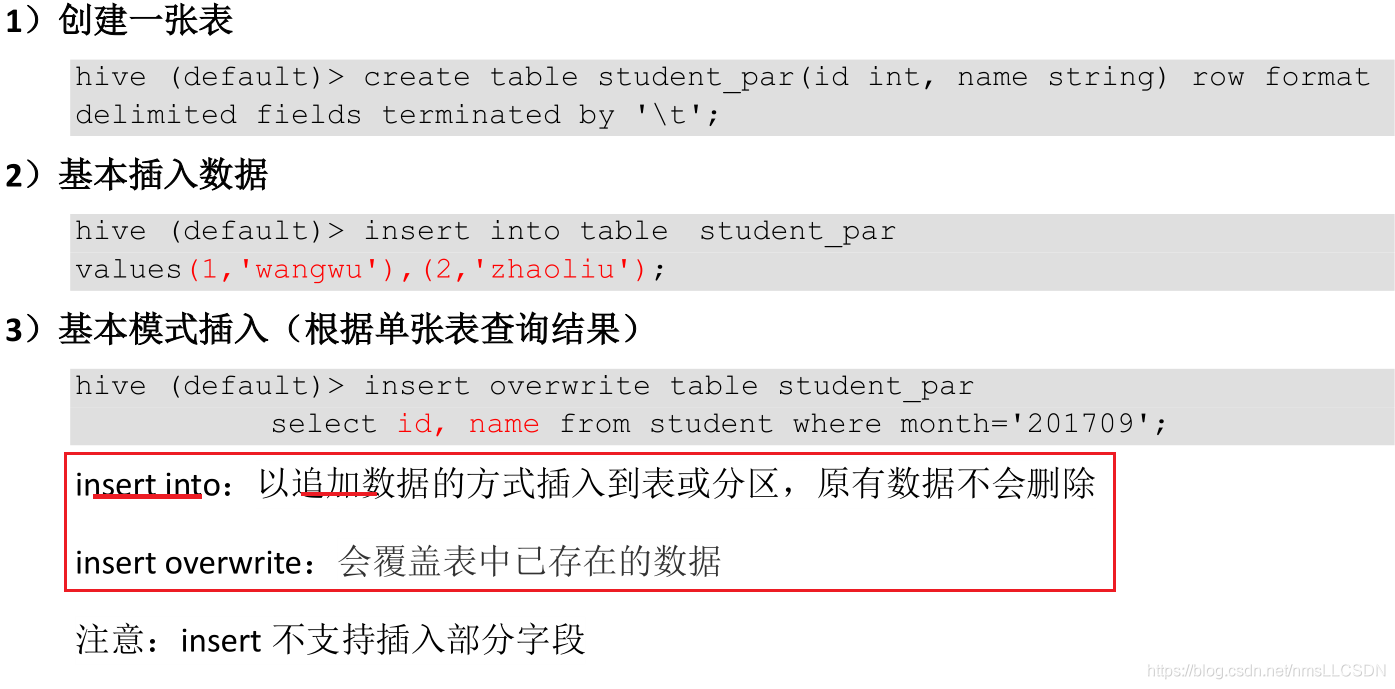

法2, 通过查询语句向表中插入数据(insert)

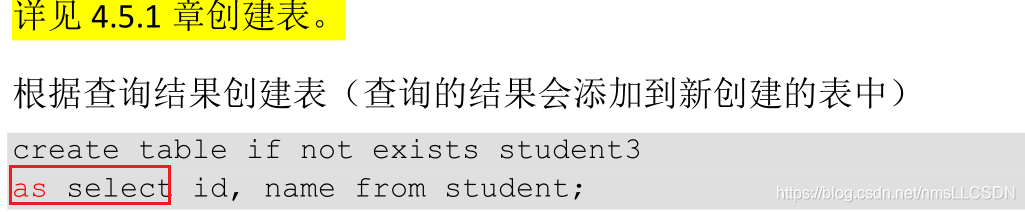

法3, 通过查询表来新建表(As select 语句)

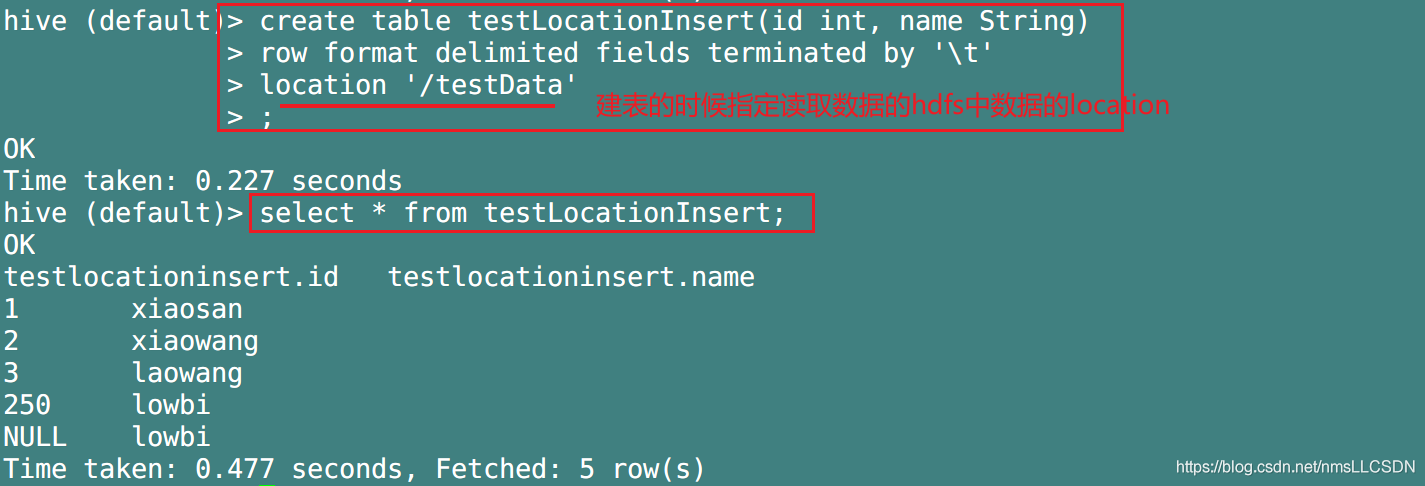

法3, 创建表时通过 Location指定加载数据路径(通常这个表是外部表)

- 准备文件

- 通过 Location指定加载数据路径

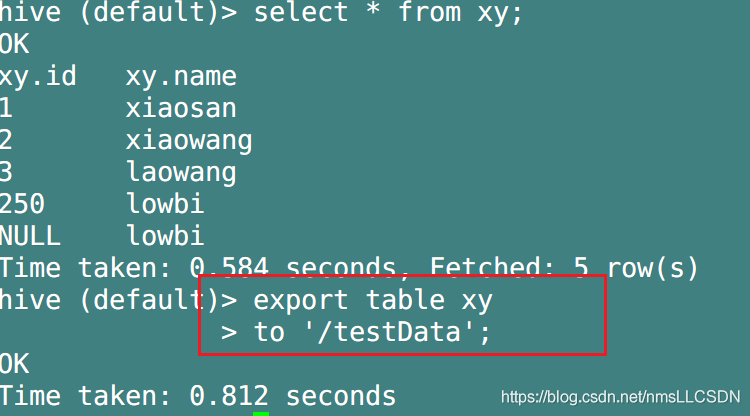

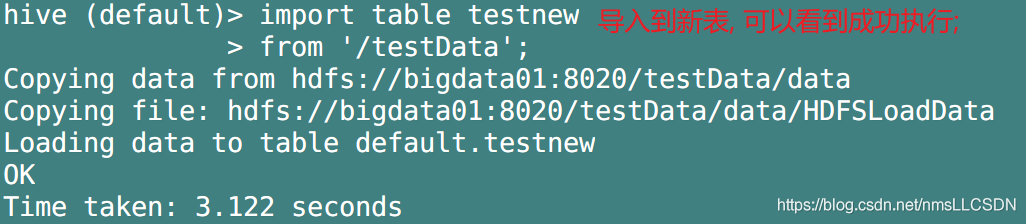

法4, 从HDFS文件中Import(导入)数据到指定 Hive表中

前置条件: 先Export 导出

5.2 数据导出

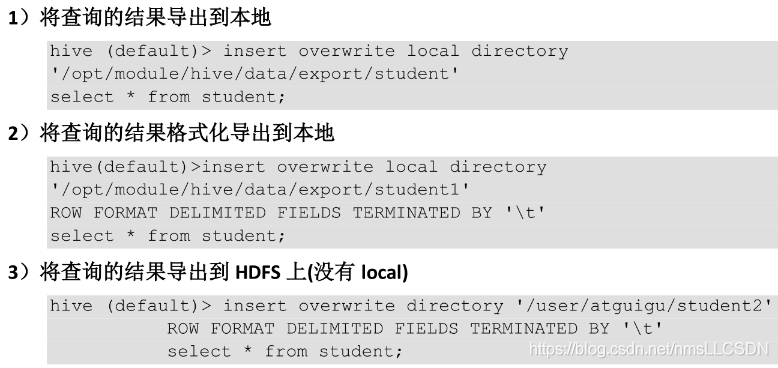

法1, Insert 导出

法2, Hadoop命令导出到本地(hdfs 的下载)

法3, Hive shell命令 导出

注意: 图中小错误, 一个

>是覆盖. 两个>>是追加

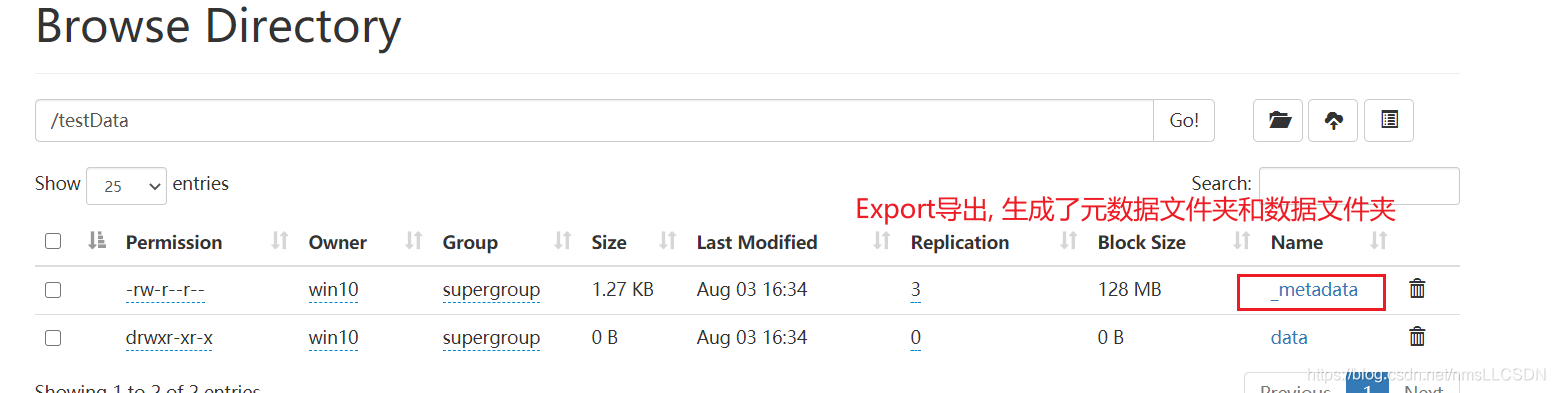

法4, Export 导出到HDFS上

- export table xx to ‘path’

- import table xx from ‘path’

千万要注意. import到的表要求: 要么不存在, 要么不包含数据(空表)

-

新表

-

已存在的空表

法5, Sqoop导出(以后学)

法6, 清除表中数据(Truncate)

Truncate只能清除管理表对应HDFS上的数据(内部表还在),无法清除外部表(会报错).

, 清除表中数据(Truncate)

Truncate只能清除管理表对应HDFS上的数据(内部表还在),无法清除外部表(会报错).

drop命令只能删除表, 无法删除HDFS上的数据.

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 全程不用写代码,我用AI程序员写了一个飞机大战

· DeepSeek 开源周回顾「GitHub 热点速览」

· 记一次.NET内存居高不下排查解决与启示

· MongoDB 8.0这个新功能碉堡了,比商业数据库还牛

· .NET10 - 预览版1新功能体验(一)