空间索引Spatial Indexing

空间索引Spatial Indexing

大家第一次接触到index应该是在上数据库这门课的时候。之所以数据库需要index,主要是因为数据量和应用层面的操作这两个原因,缺一不可。回忆下数据库最基本的操作:增删改查以及稍复杂些的比如连接操作,基本都需要先锁定数据位置,再执行操作。而定位这个步骤,如果没有index,基本都是O(n)的时间复杂度,这是一个非常“耗时”的操作。虽然从复杂度角度并不能算高,但是数据库访问是非常基础非常频繁的操作,性能直接影响到终端用户。所以非常微小的提升都是非常必要的。(如果是对于数据挖掘的算法,这类算法的用户通常是研究人员,那算法的速度快慢则显得非常次要,而accuracy则更为重要)。上面说,数据量大是使用index的一个原因,那为什么现在大量的机器学习算法,那些需要海量数据的算法不需要index呢?因为这些数据都是用来training或testing,而在这些步骤中,不需要预先定位数据位置。除了个别算法,比如KNN算法的prediction步骤,需要找到K个最近邻来判断给定item的label属性。“找”这个操作就需要定位。注意这里的定位不再是指在存储器上的位置,而是在空间中的位置,这里的空间,是由数据的维度张成的空间。空间数据,也即是这些拥有多维度的数据。这是空间数据的一个比较延展性的说法。但通常,空间数据都focus on 几何类型数据,比如点,线,面,球等,当然这些点、线都是可以任意维度的。对于空间数据的搜索,我们需要空间索引spatial index来提升搜素效率(速度)。目前主流数据库(SQL server, MySQL, PostgreSQL,etc)都已加入了对spatial data的支持,这其中最主要的就是数据类型和索引的支持。

R-tree

空间索引系列算法中最最最重要的就是R-tree了。R-tree由Guttman大神在1984年SIGMOD上提出。有时间的话我还是建议大家去感受下原文:

Guttman A. R-trees: A dynamic index structure for spatial searching[M]. ACM, 1984.

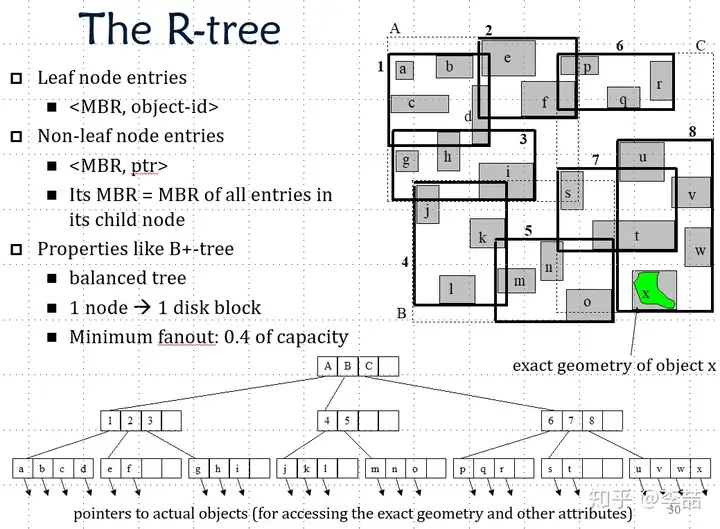

R-tree主要吸纳了B+tree的思想,对数据进行分割。已达到对数级访问时间。Guttman首先提出了MBR的概念,即Minimum Bounding Box。MBR的含义是用一个最小的矩形(通常默认矩形的边平行于坐标轴),来框住这个几何体。

这样我们需要找到这个几何体中的一部分是,我们只需要先找到这个MBR即可。而找MBR这件事,则容易了很多。接下来,我们只需要用一个更大的MBR框住内层的小MBR,通过先找外层的MBR,我们可以很快找到内层MBR的大概位置。这个一层一层构建MBR的操作,非常类似B+tree的层。最后,我们就建立了一个空间上的分割。下图是一个二维R-tree的栗子。

后续的研究比如R*-tree等对R-tree的提升主要是针对MBR的分割算法方面的。

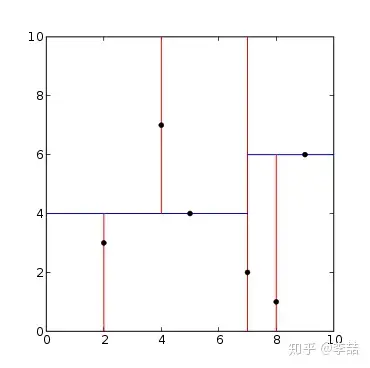

kd-tree

kd-tree的原理比R-tree要直接不少,对于k-dimension的数据,kd-tree的每一层,依次选一个维度把空间二分。对。。就这么简单。。。

Grid index

grid index即将要考虑的空间铺好网格,以便快速锁定区间。grid index尤其适合做最近邻搜索。毕竟只要考虑query所在grid的附近8个(2维时)grid就可以了。

oct-tree

八叉树是将3维空间的分成8份,依次再将每个子空间分成8份的操作,直到不需要再分为止。如果只在二维分的话,则每次分成四份,叫Quadtree。

虽然上述空间索引都很有效,但是当维度急剧提升时,空间索引的效率也会急剧下降。以R-tree为例,如果我们固定每个MBR最大容量为100,整个空间中有1M(million)个点,每个点的每个维度的范围是[0,1]。我们需要:1M/100 = 10000 个MBR。假设数据是均匀分布的。那么,设MBR边长为x,维度为n,则 𝑥𝑛∗10000=1𝑛 。

2D: 所有数据平铺在平面,每个MBR边长:0.01

3D:所有数据分散在3维空间,密度开始变得稀疏,每个MBR开始变大,边长:0.046

4D:边长:0.1

...

100D:边长:0.912

在该栗子下的MBR边长公式:nD:边长: (100/1000000)1/𝑛

可以看到,随着维度的增大,MBR的边长会越来越大,MBR之间的overlap也会越来越高,这样,R-tree的效率就会变得很低。这也是为什么高维度话题一直保持着较热的研究兴趣。今年(2018)SIGMOD做高维度的也大有人在,比如这一篇:

Wang, Yiqiu, et al. "Randomized Algorithms Accelerated over CPU-GPU for Ultra-High Dimensional Similarity Search."Proceedings of the 2018 International Conference on Management of Data. ACM, 2018.

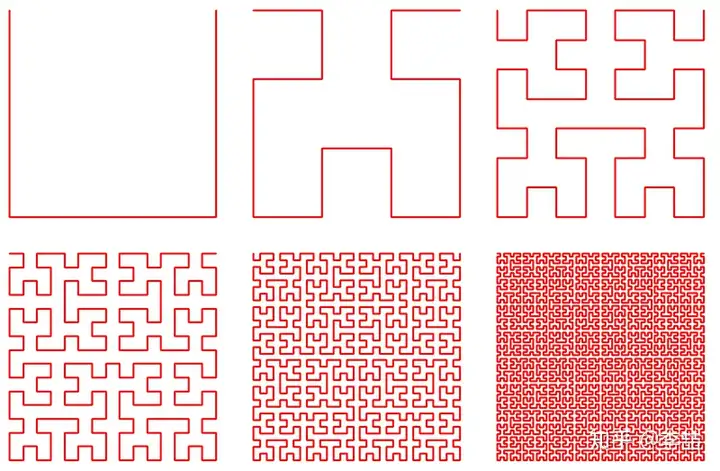

Space filling curve

space filling curve 是给高维度数据降维度的一种方法,通过给空间填充曲线,可以给每个点assign这条曲线上的位置。这样就从高维度多个坐标变成了曲线上的单一位置坐标。事实上你可以当作是空间排序算法。衡量space filling curve的最重要标准是,高维度相近的数据,在低维度上是否还相近。

目前space filling curve中效果最好的是 Hilbert curve,用的比较多实现比较简单的是Z-curve。要注意的是不管哪种curve,都是基于positive integer类型数据的,如果你的数据类型是float,那么要先整体平移到第一区间(正数),提升magnitude(保留一定原来的小数部分)在做rounding(变成整数)的预处理。

高维度下的利器:LSH(Locality Sensitive Hashing)

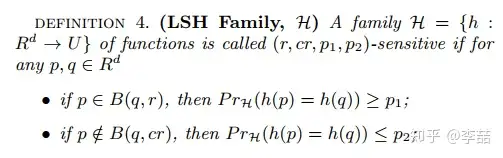

LSH是一系列可以将数据从高维度映射到低维度,同时提供理论性保证,使得在高维度相近的数据在低维度也大概率相近的哈希家族。理论性保证的形式为:

意思是,如果两个点p和q在高维度相近,那么他们在经过LSH映射到低维度后,在同一个桶内(即仍然相似)的概率高于p1。若p和q在高维度不相邻,那么他俩被映射到同一个桶内的概率应小于p2。

比较典型的LSH家族有:

基于Hamming distance 的 bit wise hashing

基于Jaccard distance 的 minHash

基于Cosine distance 的 SimHash

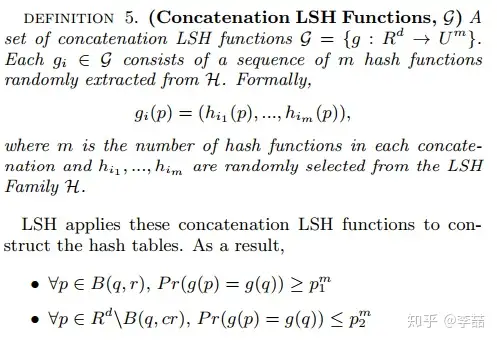

同时,为了降低上述p2,可以经过多个hash取and操作(concatenation LSH),但这样又会降低p1,此时可增加hash table的数量取or,来提p1。详细的做法,建议大家wiki。(如果以后有时间我会补一下)

DSH(Data Sensitive Hashing)

LSH是针对空间的,那么有没有针对数据的呢。2014年从高大神(我老板的partner,现NTU副教授)在SIGMOD提出了基于数据敏感的哈希家族DSH,使得数据的分割更加均匀,尤其适合KNN类问题。类似LSH,也是有理论性保证的。详细的就不扩展了,原文如下:

Gao J, Jagadish H V, Lu W, et al. DSH: data sensitive hashing for high-dimensional k-nnsearch[C]//Proceedings of the 2014 ACM SIGMOD international conference on Management of data. ACM, 2014: 1127-1138.

关于实现

做这一块不像是AI,到处都有写好的代码而且基本是是python,matlab这些几行搞定一个算法。。(默默的羡慕一波)。而我们这些,所有的实现都应当使用C++,因为以上的技术都是针对效率的,效率嘛,不用C++说不过去啊。而且别人的算法,一般都没有现成的代码,经常还需要自己小心实现出来。。。

安利一下相关的库:

Boost Geometry 的各类spatial index (就是宏太多,有点烦),还好有mailing list,不懂可以发邮件问

CGAL 的space filling curve和其他几何计算

CPLEX 的integer linear programming