腾讯开源可控视频生成框架 MimicMotion

腾讯宣布开源可控视频生成框架 MimicMotion,该框架可以通过提供参考人像及由骨骼序列表示的动作,来产生平滑的高质量人体动作视频。

公告称,大量的实验结果和用户调研表明 MimicMotion 在各种方面都显著优于以往的方法。目前模型及配套代码均已开源。

与以往的方法相比,MimicMotion 具有以下几个亮点:

- 首先,通过引入了置信度感知的姿态引导信号,大幅提升了帧间一致性,使得产生的视频在时序上能够做到平滑自然。

- 其次,通过放大置信度感知的区域损失,显著减少了图像失真,使得局部画面如人体手部细节得到了大幅改善。

-

最后,通过结合扩散过程的渐进式潜在特征融合策略,MimicMotion 能够在有限的算力资源内生成无限长的视频同时保证画面连贯。

主要优势:

- 生成结果细节更清晰 (尤其是手部细节);

- 生成视频时序平滑度更好,无明显闪烁;

- 能够生成长视频并且无明显跳变。

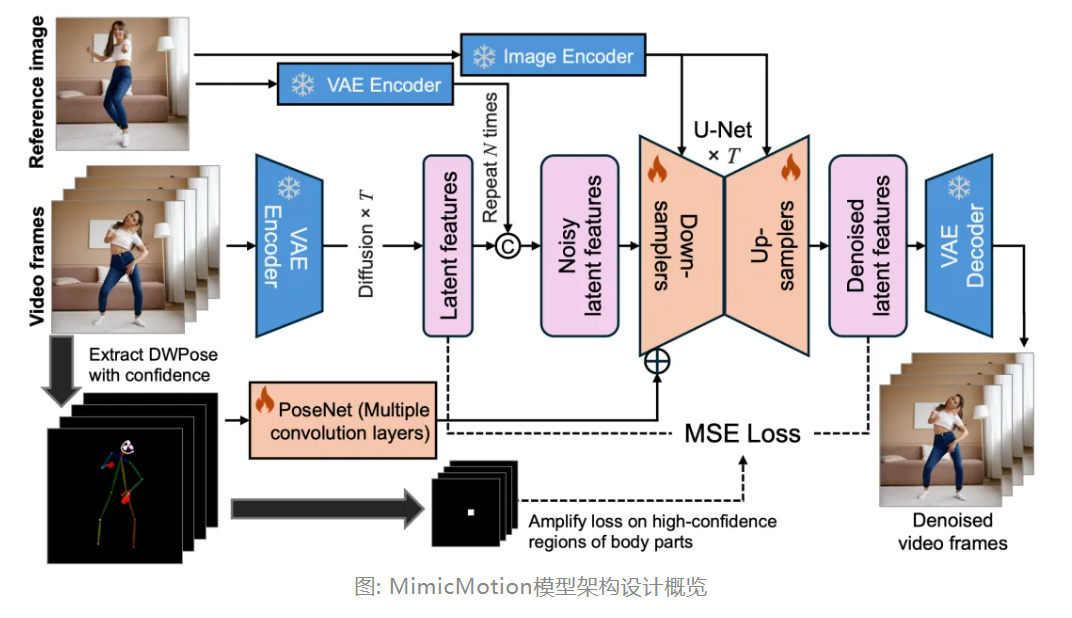

架构设计

MimicMotion 模型的核心结构是一个带有 U-Net 的隐空间视频扩散模型,用于在隐空间中进行逐步去噪。输入视频帧的 VAE 编码器和相应的解码器用于获取去噪视频帧,这些部分都加载了 Stable Video Diffusion (SVD) 预训练参数并将其冻结。VAE 编码器独立地应用于输入视频的每一帧以及条件参考图像,基于逐帧操作,不考虑时间或跨帧交互。不同的是,VAE 解码器处理经过 U-Net 时空交互的隐特征。为了确保生成流畅的视频,VAE 解码器在空间层外加入了时间层,以镜像 VAE 编码器的架构。

除了输入视频帧之外,参考图像和姿态序列是模型的另外两个输入。参考图像通过两个独立的路径输入到扩散模型中。一个路径是将图像输入到 U-Net 的每个模块中。具体来说,通过类似 CLIP 的视觉编码器,提取图像特征并将其输入到每个 U-Net 模块的交叉注意力中,以最终控制输出结果。另一个路径针对输入的隐特征。与原始视频帧类似,输入的参考图像使用相同的冻结 VAE 编码器进行编码,以在隐空间中获得其表示。然后,单个参考图像的隐特征沿着时间维度复制,以与输入视频帧的特征对齐。复制的隐参考图像与隐视频帧沿通道维度连接在一起,然后一起输入到 U-Net 中进行扩散。

为了引入姿态的指导,PoseNet 被设计为一个可训练的模块,用于提取输入姿态序列的特征,它由多个卷积层实现。不使用 VAE 编码器的原因是姿态序列的像素值分布与 VAE 自编码器训练的普通图像不同。通过 PoseNet 提取姿态特征,然后逐元素地添加到 U-Net 第一个卷积层的输出中。这样,姿态指导的影响可以从去噪的一开始就发挥作用。

MimicMotion 在生成多种形式的人体动作视频上均具有良好的结果,包括半身动作、全身动作以及谈话动作视频。相比现有的开源方案如 MagicPose、Moore-AnimateAnyone 等;

MimicMotion 具有以下几点优势:

1. 生成结果细节更加丰富且清晰,包括人体手部细节;

2. 帧间连续性更加优秀,画面无明显跳变;

3. 支持平滑的长视频生成。

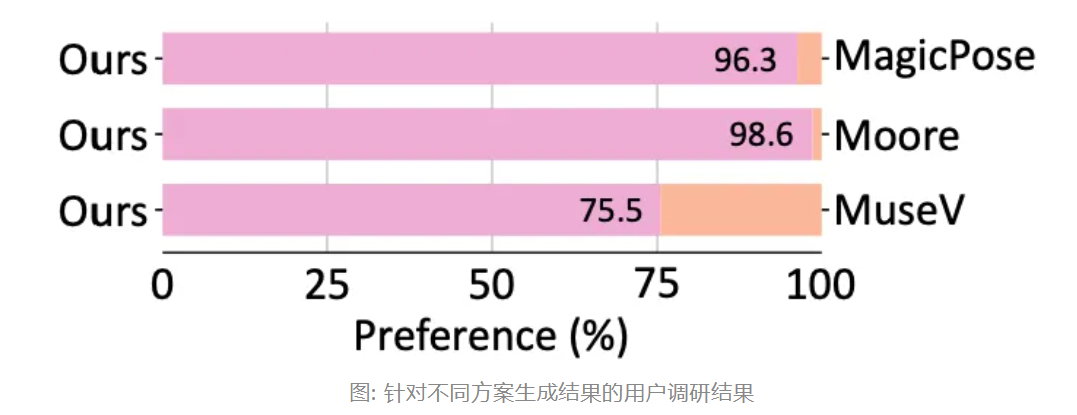

在量化指标评估实验中,MimicMotion 相比现有开源方案 MagicPose、Moore-AnimateAnyone 以及 MuseV,在 FID-VID 及 FVD 测试指标上均取得了领先。

考虑生成结果对于用户的直观感受,在由 36 位人员参与的用户调研中,MimicMotion 获得了 75.5% 以上的优胜率。

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】凌霞软件回馈社区,博客园 & 1Panel & Halo 联合会员上线

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】博客园社区专享云产品让利特惠,阿里云新客6.5折上折

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 微软正式发布.NET 10 Preview 1:开启下一代开发框架新篇章

· C# 集成 DeepSeek 模型实现 AI 私有化(本地部署与 API 调用教程)

· DeepSeek R1 简明指南:架构、训练、本地部署及硬件要求

· 没有源码,如何修改代码逻辑?

· NetPad:一个.NET开源、跨平台的C#编辑器

2022-07-19 拍下宇宙的韦伯空间望远镜,其飞行软件采用 C++ 编写、内置定制的 JS 解释器

2022-07-19 Hype 4.0(Mac系统)的布局功能

2022-07-19 Immer 入门

2022-07-19 设计克制

2022-07-19 adobe工具软件应用

2022-07-19 高性能动画的

2022-07-19 RN Weex的超过100片