ISSCC2025 Computing-In-Memory Session 趋势整理

今天下午ISSCC 2025发布会开完,CIM Session花落谁家终于清楚了。今年CIM被放到了Session 14,共录取七篇,投稿数如果和去年差不多的话,那么录取率应该是进一步下降了(去年录取了九篇)。只能说体感上来说就明显越来越卷。

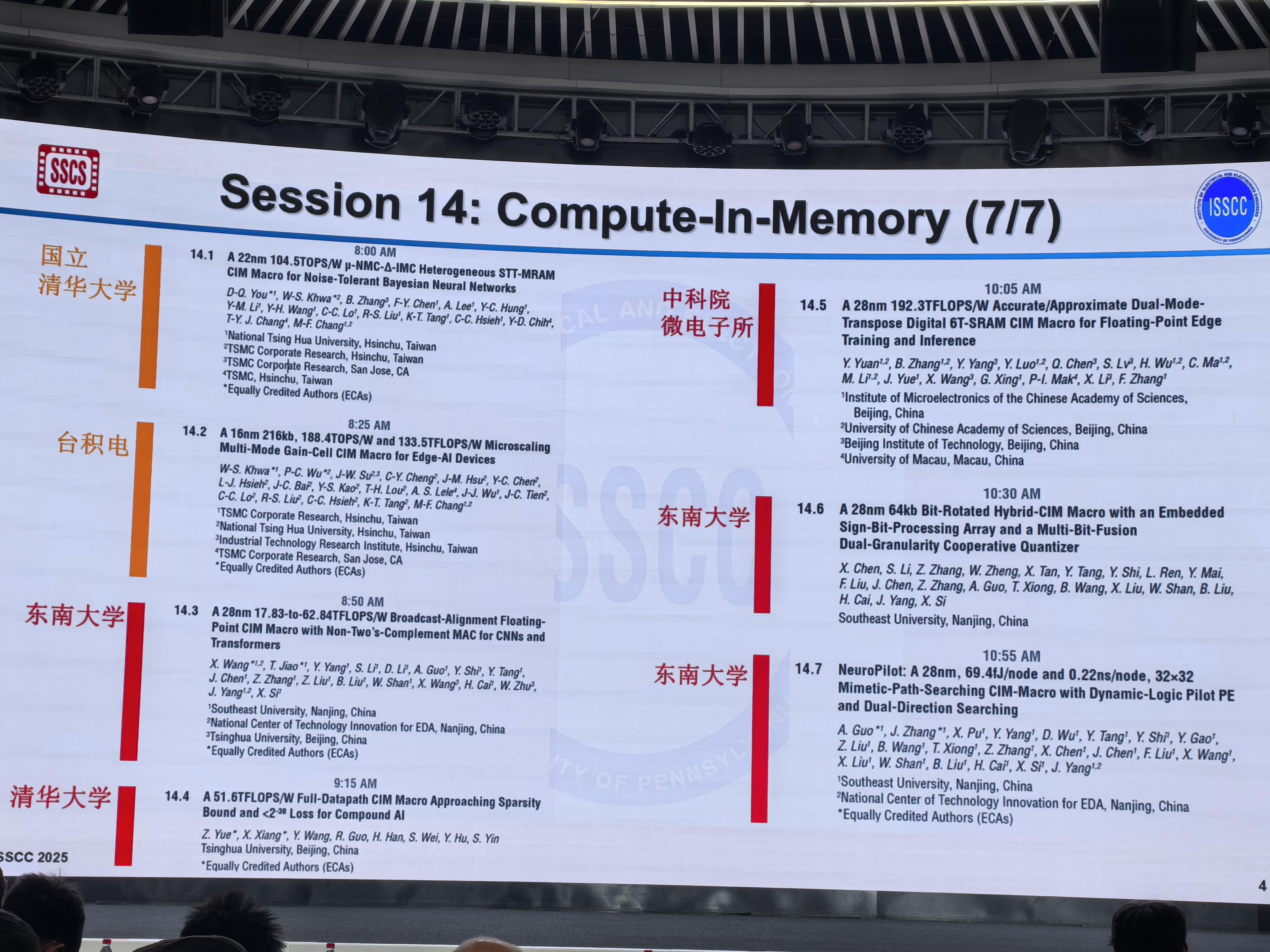

还是先来看一下录取的Paper:

7篇都来自远东,两篇台湾,五篇大陆,东南大学一己之力贡献3篇,非常牛逼。当然两篇highlight仍然是属于台湾的。

聊聊对趋势的一些简单看法。

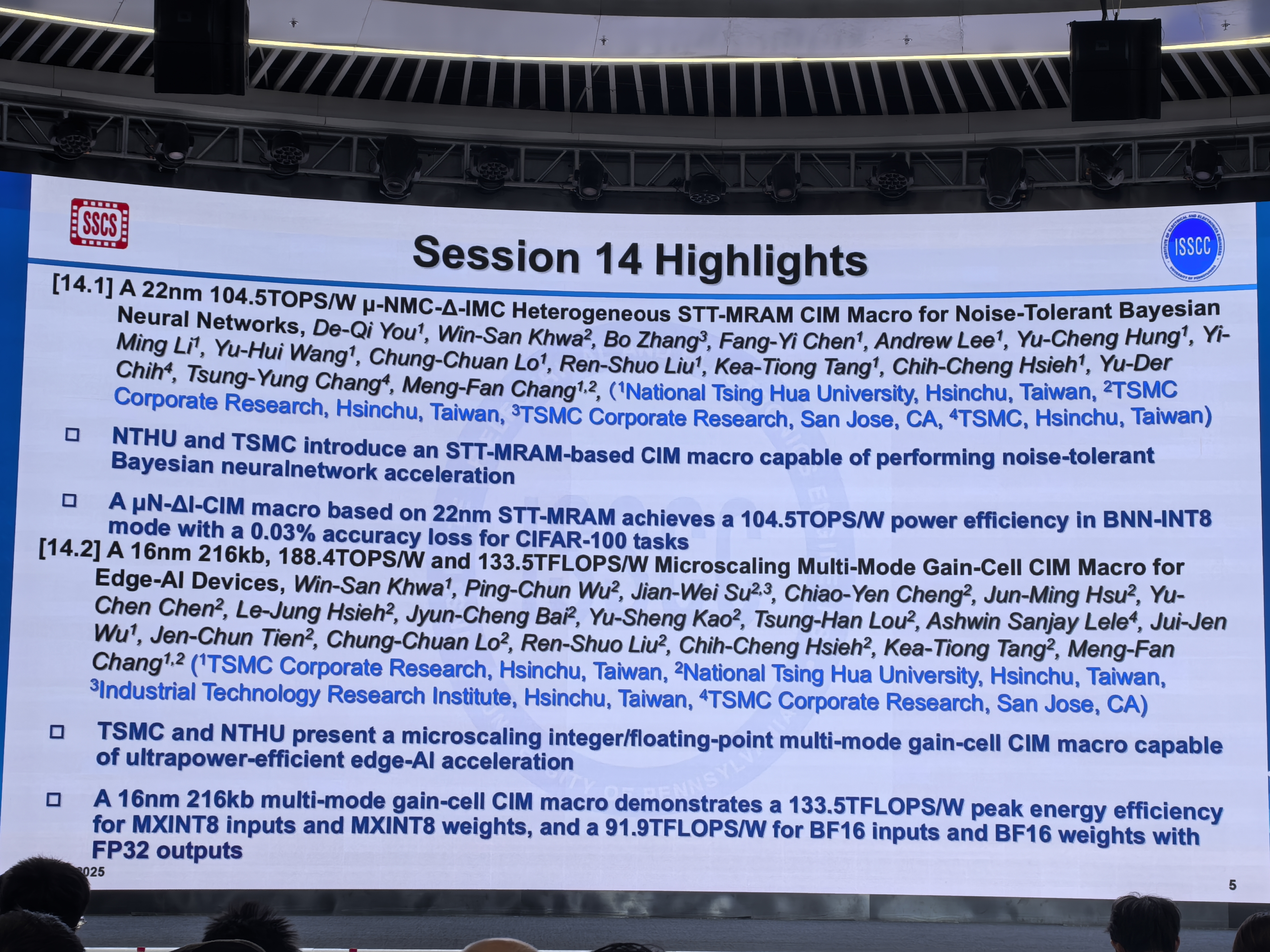

从存储介质的角度上来看,除了一篇Gain Cell和一篇STT-MRAM之外,其他五篇都是SRAM。和去年的百花齐放有所不同(去年Gain Cell,eDRAM,Flash,SRAM,RRAM都有),今年来看种类上相对来说比较单一,可能也是没有整出什么新的好活导致的。Gain Cell去年已经发过一篇,今年这篇14.2仍然是同单位,STT-MRAM去年没有作客CIM Session,今年又杀回来了。

从大的topic上来说,其实很明显可以感受到浮点CIM的问题还是有挖掘的空间,14.2,14.3,14.4,14.5四篇文章都在继续做FP CIM的主题,当然大家动机各有不同,14.2,14.3,14.4是冲着改进之前的预对齐浮点方案去的(实际上预对齐这招确实槽点很多),14.5对预对齐做了一点有限的改进,更主要的还是尝试把它和其他的场景做一下结合(比如训练)。

从类型上来看,一个模拟(14.1),一个混合域(14.6),剩下的都是数字。但这里想聊聊我的一个insight,其实数字的本质就是rail to rail的模拟,从信号的角度上来说,数字用最大的信号幅度去编码最少的信息(比特),而模拟用非轨到轨的更小信号幅度去编码更多的信息,所以从效率上来看,模拟域内的运算似乎有一定的优势,但问题在于两个点,一个是模拟域转换回数字域时的ADC开销跟模拟的信号幅度以及编码密度之间有着至少逆线性乃至逆指数关系的巨大开销,这代表着在模拟域内运算的高效优势可能会很快被抵消掉;另一个点是,模拟的编码方式实际上可以理解成是用SNR去trade效率,信号幅度越小或编码密度越高,效率自然越高,但是对应的SNR也就越差。第二点其实是我想通之后改变方法论的一个做法,用SNR去trade效率这种方法,我在数字里面也可以做,也就是用近似计算的思路用精度去换面积/能耗上的降低。同时我可以规避掉转换带来的开销问题,以及fabricate时模拟需要的一些calibrate,或者PVT上带来的问题,今年和工业界的一些人也在聊,至少在产品上去用(不管是做算力的,还是打算做边缘端SoC的),大家会异曲同工的偏好数字的方案。而近似计算本身就是一个有趣的topic,之前虽然ISSCC上有很多工作也挖掘过,但我觉得其实可以研究的问题还有很多,这是一个大的方向,我觉得值得长期往下做下去,去作为一个好的问题挖掘挖掘。

最后聊一下计算负载的问题,14.1关注了贝叶斯神经网络,14.3关注了CNN和Transformer两类负载的支持问题(这也是去年就有的一个trend)。14.5关注了edge training的问题。14.7提出了一个direction searching的负载,打破了长期以来CIM一直关注神经网络类型负载的状态。

总体上来看,感觉今年的CIM Session没有像去年那种很多新topic涌现的感觉,更多是对之前有的topic(hybrid CIM,FP CIM,CNN + Transformer)这些问题的进一步讨论。但FP CIM的范式通过三篇异曲同工的工作对预对齐方案做了一波拨乱反正还是挺有意思的,可以等论文正式放出来后看看具体的做法。14.7提出了非神经网络的负载,可能也意味着大家对于CIM的定义进一步放宽了,也许后面会有更多非网络的domain specific的任务通过CIM的方式做出来。

最后提提感想,今年拿下第二篇,更多的感觉是幸运,优秀的工作很多,能够杀出重围确实不容易。今年的工作从构思,工程实现到论文整体上比去年丝滑了很多,也是吃了一波经验增长的红利。希望后续还能再出一些更好的工作。

浙公网安备 33010602011771号

浙公网安备 33010602011771号