机器学习实战(一):k-近邻算法

k-近邻算法的工作原理

存在一个样本数据集合,也称作训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每一数据与所属分类的对应关系。

输入没有标签的新数据后,将新数据的每个特征与样本集中数据对应的特征进行比较,然后算法提取本集中特征最相近的数据(最近邻)的分类标签。

一般来说,我们只选择样本数据及前k个最相似的数据,这就是k-近邻算法中k的出处,通常k是不大于20的整数。最后,选择K个最相似数据中出现次数最多的

分类,作为新数据的分类。

k-近邻算法的优缺点及适用范围

优点:精度高、对异常值不敏感、无数据输入假定

缺点:计算复杂度高、空间复杂度高

适用数据范围:数值型和表称型

k-近邻算法的一般流程

- 收集数据:可以使用任何方法。

- 准备数据:距离计算所需要的数值,最好是结构化的数据格式。

- 分析数据:可以使用任何方法。

- 训练算法:此步骤不适用于k-近邻算法。

- 测试算法:计算错误率。

- 使用算法:首先需要输入样本数据和结构化的输出结果,然后运行k-近邻算法判定输入数据分别属于哪个分类,最好应对计算出的分类执行后续的处理

例子1 利用k-近邻算法确定未知影片的类型

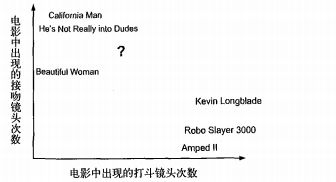

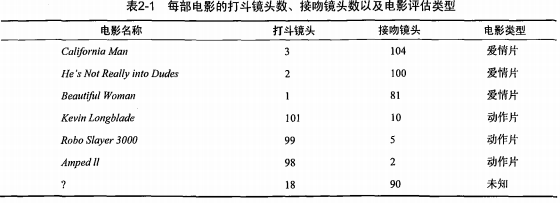

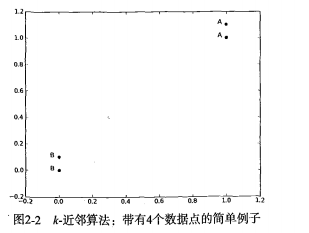

下图显示了6部电影的打斗和接吻镜头数,假如有一部未看过的电影,如何确定它是爱情片还是动作片?

图中问号部分是该未知电影出现的镜头数图形化展示,具体数值见下表:

我们可以通过某种方法计算得到该未知电影属于哪种类型。

第一步:计算未知电影与样本集中其他电影的距离

按照距离递增排序,可以找到k个距离最近的电影。假定k=3,则三个最靠近的电影依次是He's Not Really into Dudes,Beautiful Woman,California Man.

k-近邻算法按照距离最近的三部电影的类型,决定未知电影的类型,而这三部电影都是爱情片,因此我们判定未知电影是爱情片

这里主要讲解如何在实际环境中应用k-近邻算法,同时涉及如何使用Python工具和相关的机器学习术语

第二步:定义一些基本的通用函数

from numpy import * #排序操作会使用这个包 import operator def createDataSet(): group = array([[1.0,1.1],[1.0,1.0],[0,0],[0,0.1]]) labels = ['A','A','B','B'] return group,labels group,labels = createDataSet()

输出:

group array([[1. , 1.1], [1. , 1. ], [0. , 0. ], [0. , 0.1]])

labels ['A', 'A', 'B', 'B']

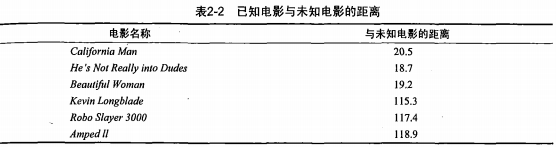

这里有4组数据,每组数据有两个我们已知的属性或者特征值。上面的group矩阵每行包含一个不同

的数据,我们可以把它想象成某个日志文件中不同的测量点或者入口。由于人类大脑的限制,我

们通常只能可视化处理三维以下的事务。因此,为了简单的实现数据可视化,对于每个数据点我们通常

只使用两个特征。

向量label包含了每个数据点的标签信息,label包含的元素个数等于group矩阵行数。这里我们将数据点

(1,1.1)定义为类A,数据点(0,0.1)定义为类B。为了说明方便,例子中的数值是任意选择的,并没有

给出轴标签。图2-2是带有类标签信息的四个数据点。

k-近邻算法的伪代码:

(1)计算已知类别数据集中的点与当前点之间的距离;

(2)按照距离递增次序排序;

(3)选取与当前点距离最小的k个点;

(4)确定前k个点所在类别的出现频率;

(5)返回前k个点出现频率最高的类别作为当前点的预测分类