Spark环境搭建(三)-----------yarn环境搭建及测试作业提交

配置好HDFS之后,接下来配置单节点的yarn环境

1,修改配置文件

文件 : /root/app/hadoop-2.6.0-cdh5.7.0/etc/hadoop/yarn-site-xml

插入

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

文件: /root/app/hadoop-2.6.0-cdh5.7.0/etc/hadoop/mapred-site.xml

插入

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

2,启动yarn

命令: sbin/start.yarn.sh

3,验证yarn启动成功

1) 命令:jps

显示

7945 Jps

6227 SecondaryNameNode

6060 DataNode

5745 NameNode

5031 NodeManager

4922 ResourceManager

2) 浏览器:

http://hadoop001:8088/

4,提交作业到yarn执行(以wordcount为例)

1) 现将一个文本文件上传到HDFS中

2)执行一个Jar文件,使用命令

hadoop jar /home/app/hadoop-2.6.0-cdh5.7.0/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.6.0-cdh5.7.0.jar wordcount /data/wc-text.txt /output/wc/

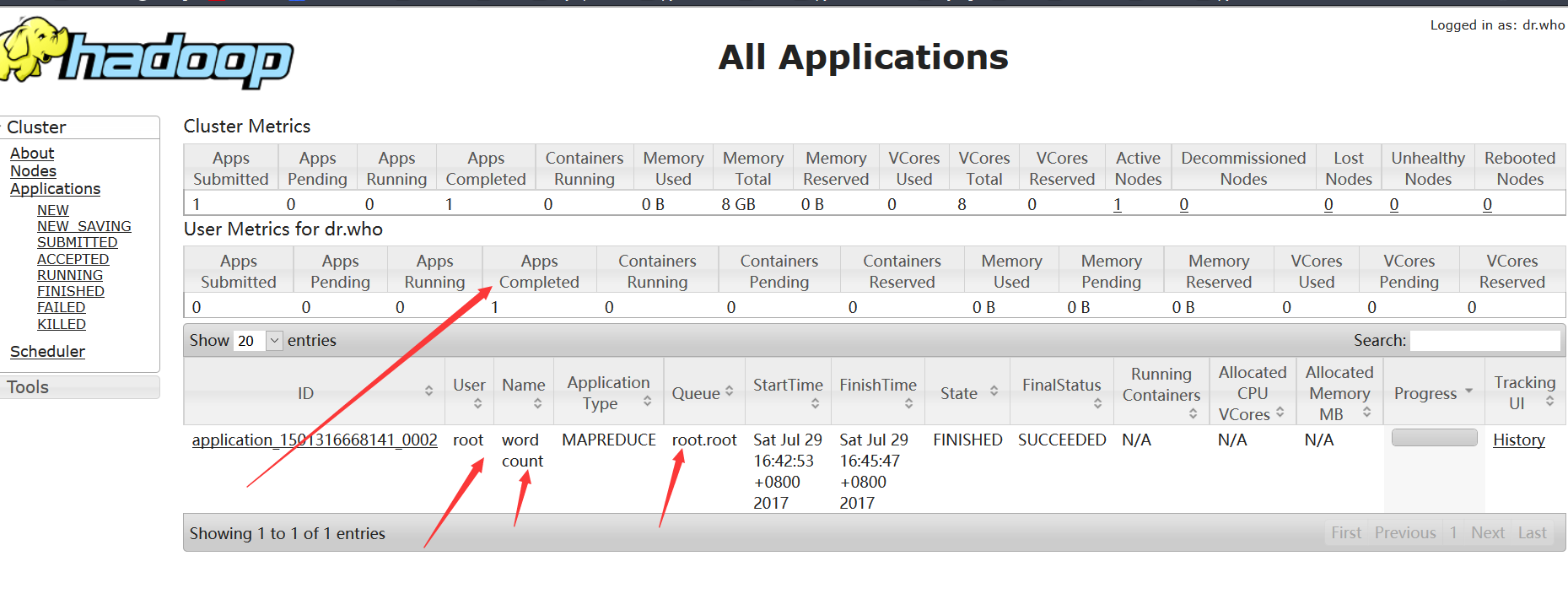

3) 使用浏览器查看任务

4)在HDFS中查看结果

命令: hadoop fs -ls -R /

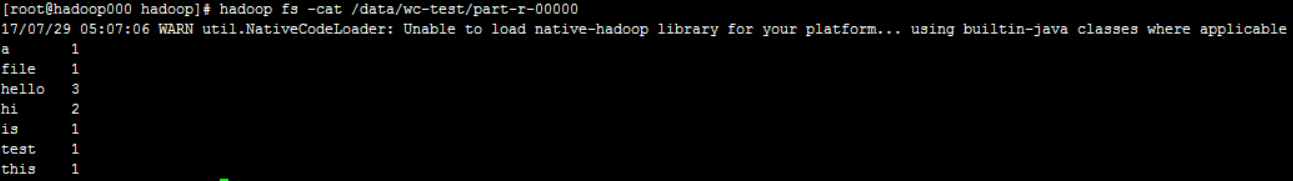

hadoop fs -cat /output/wc/part-r-00000

5)结果:

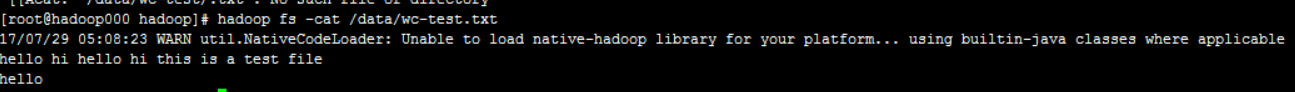

原文件:

至此,yarn环境搭建完毕

浙公网安备 33010602011771号

浙公网安备 33010602011771号