Spark 集群 任务提交模式

Spark 集群的模式及提交任务的方式

- 本文大致的内容图

-

Spark 集群的两种模式:

-

Standalone 模式

-

Standalone-client 任务提交方式

-

提交命令

./spark-submit --master spark://node1:7077 (主节点的位置) --class 类的包+类名 jar包的位置 1000 # 分区参数, 也可以说是并行度||

./spark-submit --master spark://node1:7077 --deploy-mode client --class 类的包+类名 jar包的位置 100 # 分区参数, 也可以说是并行度 -

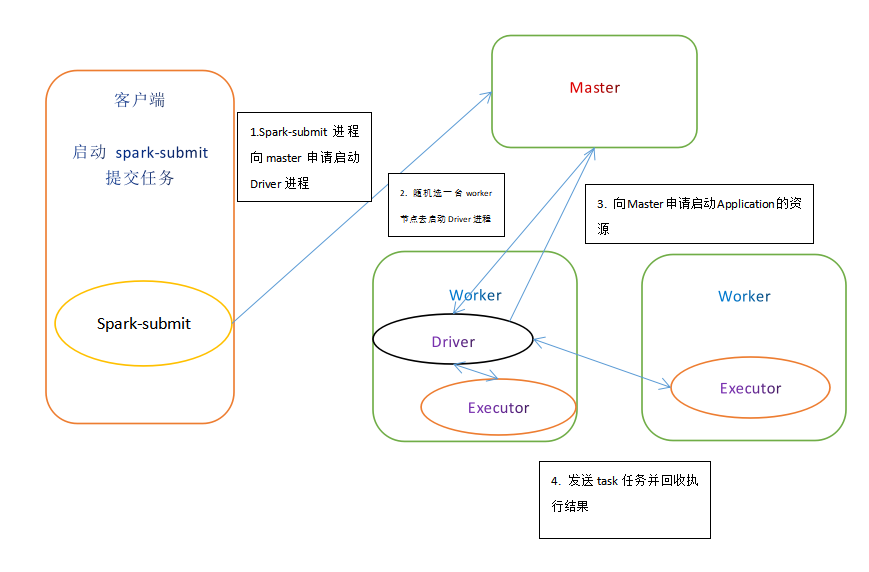

执行原理

-

执行流程

- client 模式提交任务后, 会在客户端启动Driver进程

- Driver 会向 Master 申请启动 Application启动的资源

- 资源申请成功, Driver 端将 task 发送到 worker端执行

- Worker 端将 task 执行结果 返回 到 Driver 端

-

总结

- client模式适用于测试调试程序。

- Driver进程是在客户端启动的。这里的客户端指的是应用程序的当前节点

- 在Driver端可以看到task执行的情况。

- 生产环境下不能使用client模式是因为: 假设提交100个 Application 到集群运行, Driver每次都会在client端启动, 那么就会导致客户端100次网卡流量暴增。

-

-

Standalone-cluster 任务提交方式

-

提交命令

./spark-submit --master spark://node1:7077 --deploy-mode cluster --class 包+类名 jar包的位置 100 # 分区参数, 也可以说是并行度 #注意:Standalone-cluster提交方式,应用程序使用的所有jar包和文件,必须保证所有的worker节点都要有,因为此种方式,spark不会自动上传包。 # 解决方式: # 1.将所有的依赖包和文件打到同一个包中,然后放在hdfs上。 # 2.将所有的依赖包和文件各放一份在worker节点上。 -

执行原理

-

执行流程

- cluster模式提交应用程序后会先向 Master 请求启动 Driver

- Master 接收请求, 随机在集中的一台节点启动Driver进程

- Driver启动后为当前的应用程序申请资源

- Driver端发送task到worker节点上执行

- worker 将执行情况和执行结果返回 Driver

-

总结

- Standalone-cluster 运行方式适用于生产环境

- 此时在driver端界面看不到执行任务情况

- 由于driver会被随机分配到worker节点上启动, 那么不会有流量激增问题

-

-

-

On Yarn 模式

-

Yarn-client 任务提交方式

-

提交命令

./spark-submit --master yarn --class 包+类名 jar文件位置 100||

./spark-submit --master yarn–client --class 包+类名 jar文件位置 100||

./spark-submit --master yarn --deploy-mode client --class 包+类名 jar文件位置 100 -

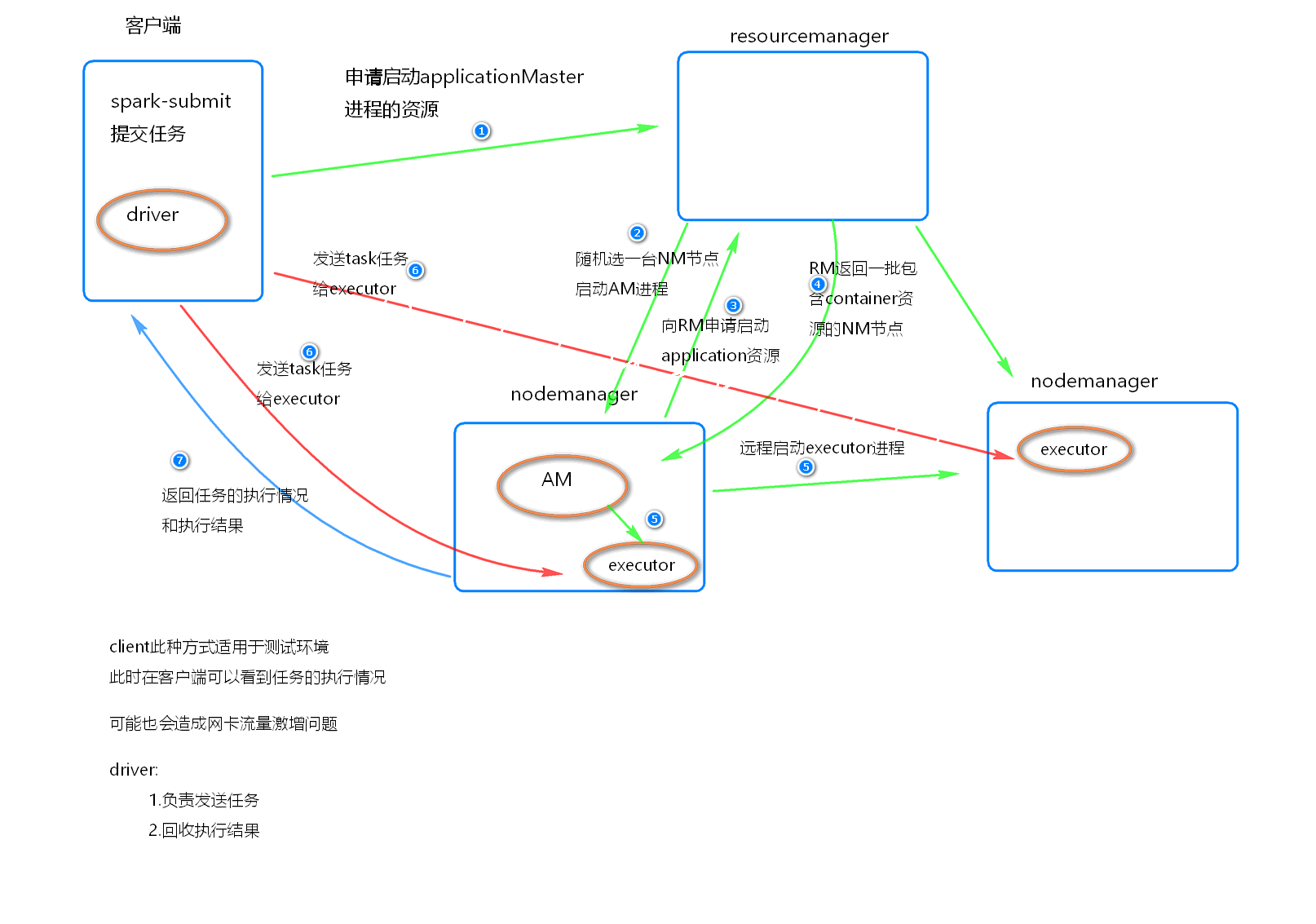

执行原理

-

执行流程

- 客户端提交一个 Application, 在客户端启动一盒Driver 进程。

- 应用程序启动后会向RM(ResourceManager) 发送请求, 启动AM(ApplicationMaster)

- RM 收到请求, 随机选择一台 NM(NodeManager)启动AM。这里的NM相当于Standalone中的Worker节点

- AM 启动后, 会向 RS 请求一批container资源, 用于启动Executor

- RM会找到一批NM返回给AM, 用于启动Executor

- AM会向NM发送命令启动Executor

- Executor 启动后, 会反向注册给Driver, Driver 发送 task 到 Executor, 执行情况和结果返回给Driver端

-

总结

-

Yarn-client模式同样适用于测试, 因为Driver运行在本地, Driver会与yarn集群中的Executor 进行大量的通信, 会造成客户机网卡流量的大量增加

-

ApplicationMaster 的作用:

-

为当前的Application申请资源

-

给NodeManager发送消息启动Executor

-

-

-

-

Yarn-cluster 任务提交方式

-

提交命令

./spark-submit --master yarn --deploy-mode cluster --class 包+类名 jar文件位置 100||

/spark-submit --master yarn-cluster --class 包+类名 jar文件位置 100 -

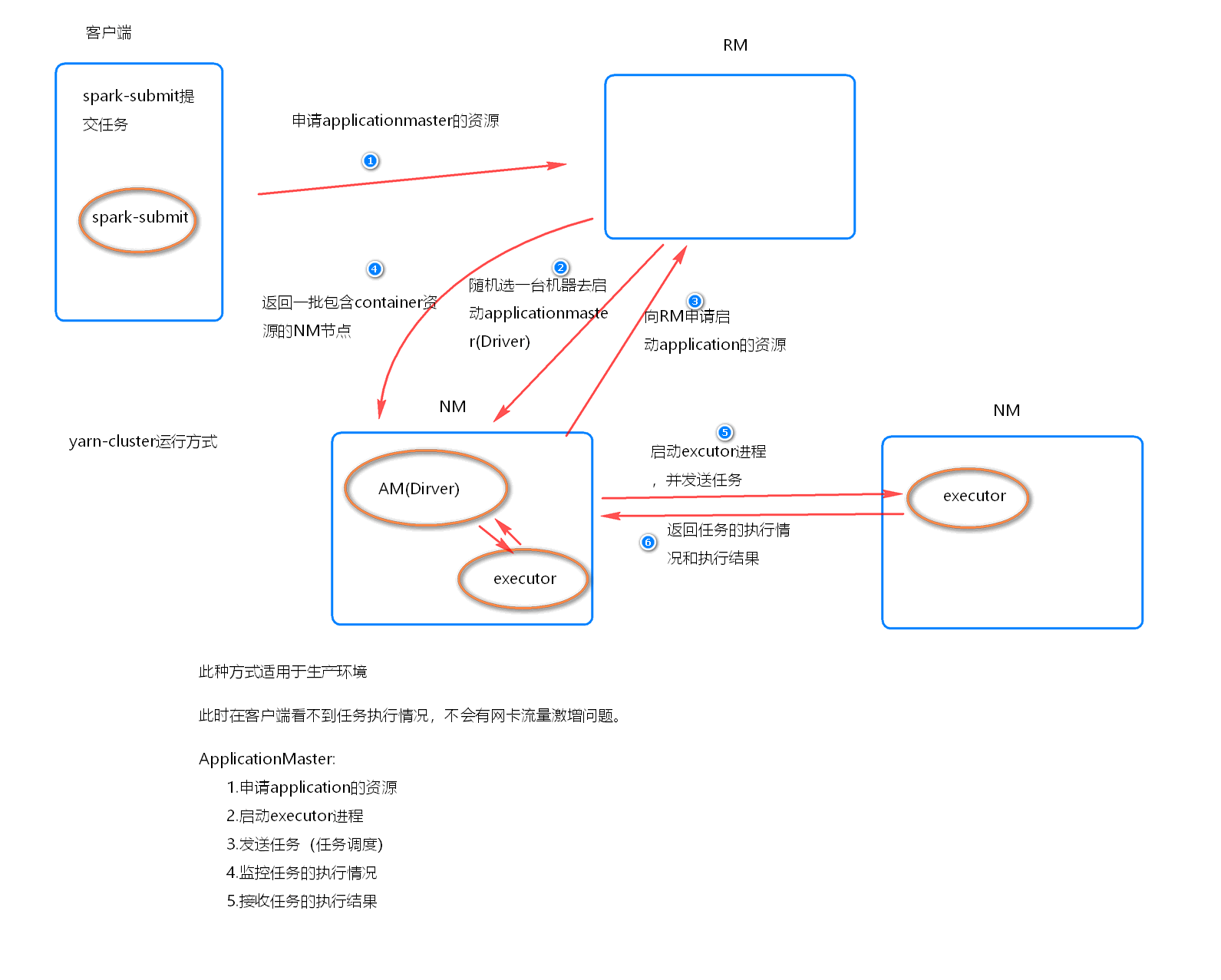

执行原理

-

执行流程

- 客户机提交Application应用程序, 发送请求到RM(ResourceManager), 请求启动(ApplicationMaster)

- RM收到请求后随即在一台 NM(NodeManager) 上启动 AM(相当于Driver 端)

- AM启动后, AM 发送请求到 RM, 申请一批容器(container)来启动Executor

- RM 返回一批 NM 节点 给 AM

- AM 连接到 NM, 发送请求到 NM 启动 Executor

- Executor 反向注册到 AM 所在节点的 Driver,Driver再发送task到Executor

-

总结

- Yarn-Cluster 主要用于生产环境中, 因为 Driver运行在 Yarn 集群中某一台NodeManager中, 每次提交任务的 Driver 所在机器都是随机的, 并不会产生一台机器网卡流量激增的现象。

- 缺点是提交任务不能看到日志, 只能通过yarn查看日志

- ApplicationMaster的作用

- 为当前的 Application 申请资源

- 给NodeManger 发送消息启动 Executor

- 任务调度

-

-

-