ES-windos环搭建-ik中文分词器

ik下载

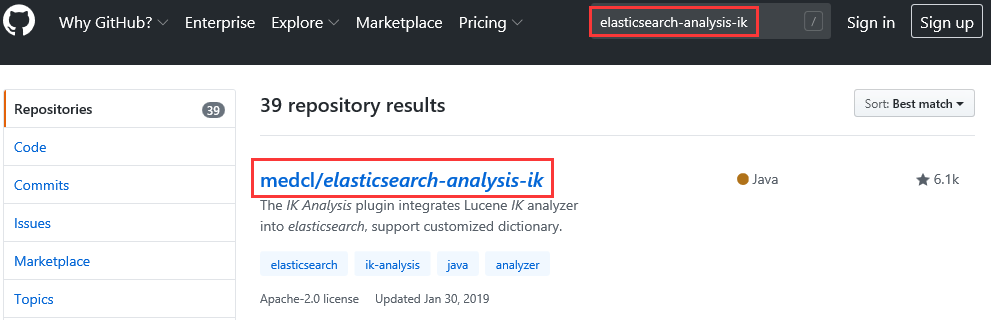

- 打开

Github官网,搜索elasticsearch-analysis-ik,单击medcl/elasticsearch-analysis-ik。或者直接点击

- 在

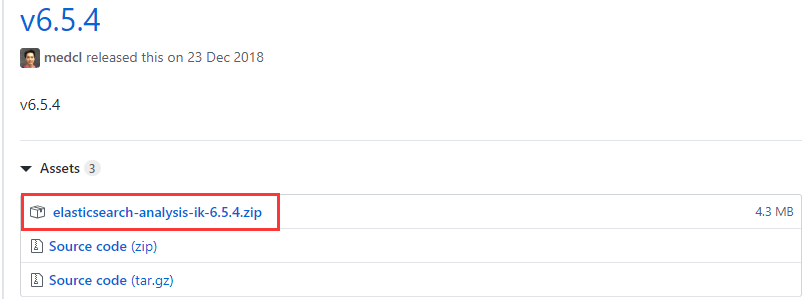

readme.md文件中,下拉选择预编译版本。

- 由于

ik与elasticsearch存在兼容问题。所以在下载ik时要选择和elasticsearch版本一致的,也就是选择v6.5.4版本,单击elasticsearch-analysis-ik-6.5.4.zip包,自动进入下载到本地。

- 本地下载成功后,是个

zip包。

安装

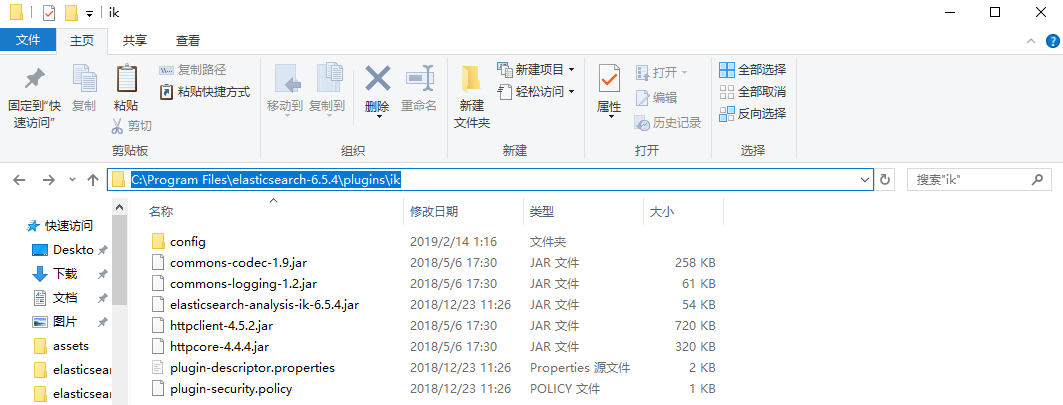

- 首先打开

C:\Program Files\elasticseach-6.5.4\plugins目录,新建一个名为ik的子目录,并将elasticsearch-analysis-ik-6.5.4.zip包解压到该ik目录内也就是C:\Program Files\elasticseach-6.5.4\plugins\ik目录。

测试

- 首先将

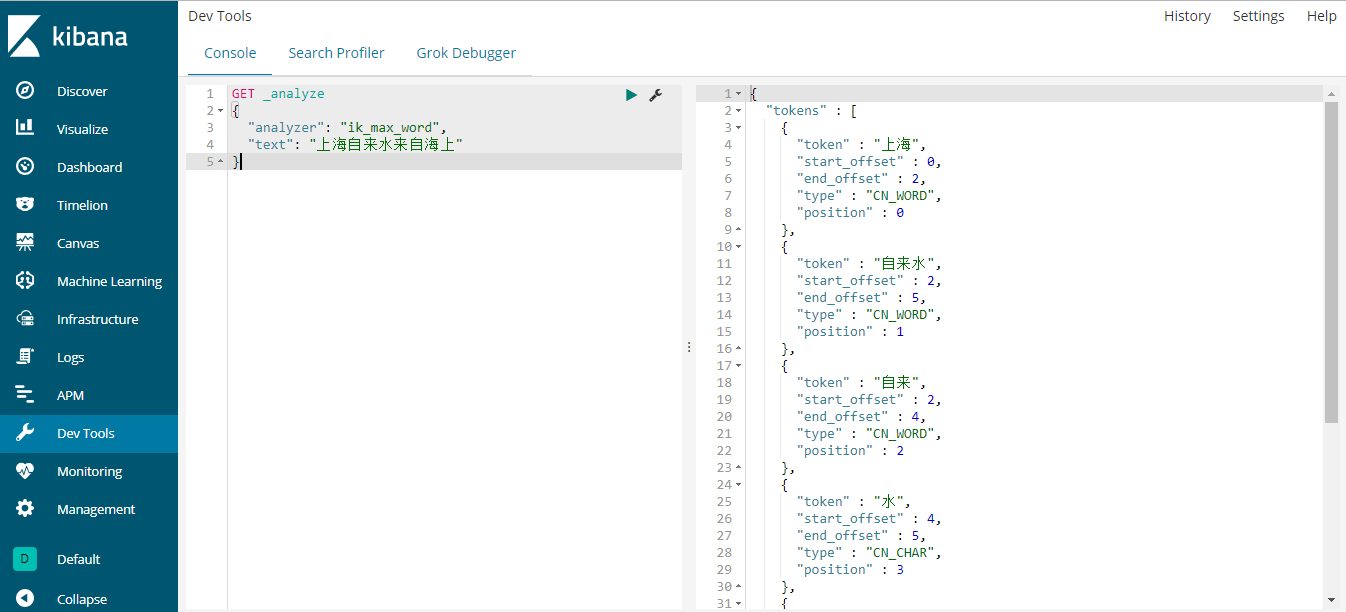

elascticsearch和kibana服务重启。 - 然后地址栏输入

http://localhost:5601,在Dev Tools中的Console界面的左侧输入命令,再点击绿色的执行按钮执行。

GET _analyze

{

"analyzer": "ik_max_word",

"text": "上海自来水来自海上"

}右侧就显示出结果了如下所示:

{

"tokens" : [

{

"token" : "上海",

"start_offset" : 0,

"end_offset" : 2,

"type" : "CN_WORD",

"position" : 0

},

{

"token" : "自来水",

"start_offset" : 2,

"end_offset" : 5,

"type" : "CN_WORD",

"position" : 1

},

{

"token" : "自来",

"start_offset" : 2,

"end_offset" : 4,

"type" : "CN_WORD",

"position" : 2

},

{

"token" : "水",

"start_offset" : 4,

"end_offset" : 5,

"type" : "CN_CHAR",

"position" : 3

},

{

"token" : "来自",

"start_offset" : 5,

"end_offset" : 7,

"type" : "CN_WORD",

"position" : 4

},

{

"token" : "海上",

"start_offset" : 7,

"end_offset" : 9,

"type" : "CN_WORD",

"position" : 5

}

]

}

OK,安装完毕,非常的简单。

浙公网安备 33010602011771号

浙公网安备 33010602011771号