DeepSeek-R1本地部署

一、Ollama部署

1、安装ollama

傻瓜式next安装即可

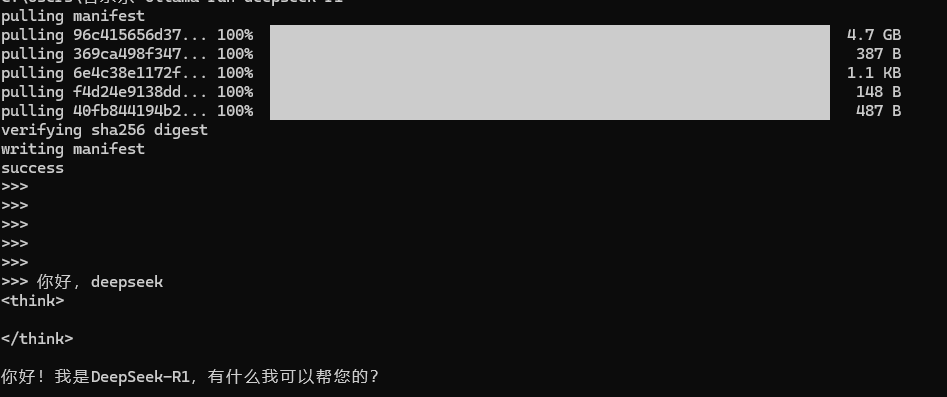

2、安装deepseek模型

默认安装7b,可以通过ollama run deepseek-r1:xxx 选择不同的模型

3、下载完成之后便可以看到啦

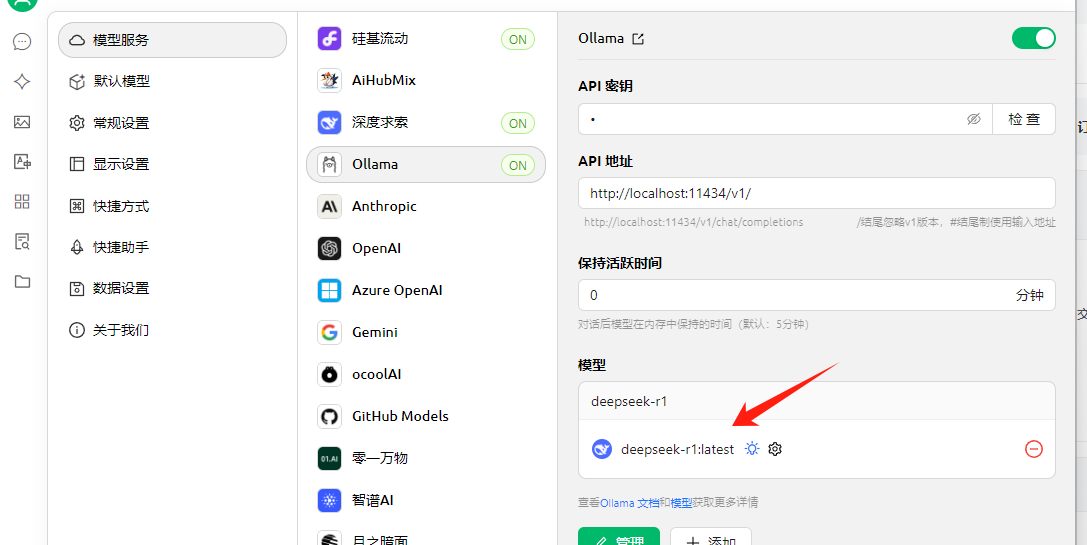

二、本地chat-cherry studio

下载cherry studio 也是傻瓜式安装即可

设置-->选择ollama-->管理-->选择本地安装的模型即可

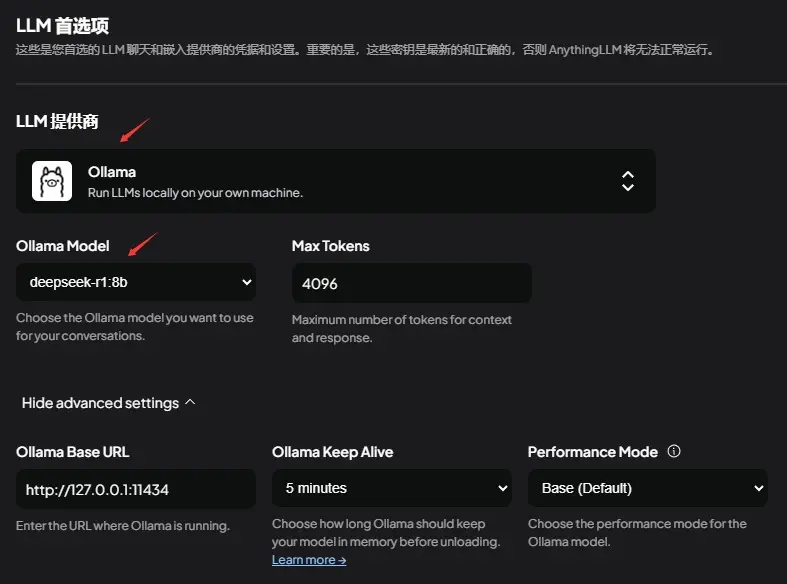

三、本地chat-AnythingLLM

安装也没有很复杂的地方

依次选择Ollama,deepseek-r1即可

四、编码辅助

1、vscode安装Cline插件

2、配置本地模型,选择Ollama

3、选择本地模型id即可

作者:紫陌花间客

欢迎任何形式的转载,但请务必注明出处。

限于本人水平,如果文章和代码有表述不当之处,还请不吝赐教。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· Docker 太简单,K8s 太复杂?w7panel 让容器管理更轻松!