kerberos

1第一章 Kerberos原理

1.1数据安全防护

用户在访问大数据集群数据时会有如下几个维度的安全防护方式来保证访问数据的安全:

- 边界安全(Perimeter Security):如设置防火墙、安全组控制端口。

- 认证(Authentication):大数据集群中组件服务开启身份认证功能,只有用户提供了合法的身份信息才有可能访问服务,它是后续授权的基础,没有身份认证的授权是有漏洞容易被冒充的。例如:任意连接到HDFS系统的用户都可以查看HDFS 中的数据,设置是可以操作HDFS中的数据,存在安全问题。

- 授权(Authorization):通过身份认证的用户并不能访问服务所有的资源,需要通过授权机制对用户访问服务中实际的资源进行控制。例如通过ranger对访问Hive的用户进行授权限制用户访问Hive表中的哪些数据。

- 审计(Audit):用户对服务资源的访问,需要利用审计日志进行监控/跟踪,便于问题/风险的排查。

- 加密(Encrypt):涉及数据传输加密/数据存储加密,防止数据被窃取/窃取后被破解等。

以上边界安全主要是针对企业大数据集群节点的防火墙和安全组端口控制,避免非法访问和操作集群数据,边界安全假设"坏人"在外面,这通常是一个非常糟糕的假设,大多数真正具有破坏性的计算机犯罪事件都是内部人员所为,所以对于可以访问集群节点的人员还需进一步认证;认证主要是针对通过边界安全维度后进行用户身份的确认,认证有很多形式,如服务组件自身提供了简单的用户名/密码认证方式、通过Kerberos认证服务对用户身份进行认证;为了更好细粒度控制通过认证用户访问的资源可以通过对用户授权方式来决定用户操作资源的权限,这就是授权;最终操作集群资源时可以对数据进行加密传输,所有操作都会通过审计日志进行记录,便于风险排查。

针对认证(Authorization)部分,目前大数据企业比较通用的是使用Kerberos协议,集群上启动的多个服务组件可以通过使用同一个第三方的Kerberos认证服务,对用户进行身份认证,例如大数据中HDFS默认安全认证的方式就采用的是Kerberos认证协议。

1.2什么是Kerberos

Kerberos 是一种网络身份验证协议,Kerberos协议通过使用密钥加密为Client/Server应用程序提供强大的身份验证。不同于其他网络安全协议的保证整个通信过程的传输安全,Kerberos侧重于通信前双方身份的认定工作,帮助客户端以及服务端验证是真正的自己并非他人,从而使得通信两端能够完全信任对方的身份,在一个不安全的网络中完成一次安全的身份认证继而进行安全的通信。

Kerberos由麻省理工学院(MIT)研发实现,官网地址为:https://web.mit.edu/kerberos/,Kerberos一词来源于古希腊神话中的 Cerberus —— 守护地狱之门的三头犬,下图是 Kerberos 的 LOGO:

在大数据开发中,很多大数据组件都支持Kerberos身份认证,例如:HDFS、Yarn、Hive、HBase、Spark、Kafka等。

1.3Kerberos认证原理

1.3.1加密

为了更好理解Kerberos认证原理,需要首先对加密和数字证书概念进行理解。互联网通信中 为了保证信息传输过程中 数据的机密性可以对数据进行加密,加密又分为对称加密和非对称加密。

- 对称加密 :

对称加密是指加密和解密使用相同的密钥。发送方使用该密钥将明文转换为密文,接收方使用相同的密钥将密文还原为明文。这种方法的优点是加密和解密速度快,适用于大量数据的加密,但缺点是需要保护好密钥,因为密钥一旦泄露,所有的加密信息都将暴露。在Kerberos中信息加密方式默认就是对称加密。

常见的对称加密算法有:DES、AES、3DES等。

- 非对称加密 :

非对称加密指的是:加密和解密使用不同的秘钥,一把作为公开的公钥,另一把作为私钥。 公钥加密的信息,只有私钥才能解密。私钥加密的信息,只有公钥才能解密。例如:发送方使用接收方的公钥加密明文,接收方使用自己的私钥解密密文。这种方法的优势就是即使密文和公钥被拦截,但是由于无法获取到私钥,也就无法破译到密文,但缺点是加密和解密速度相对较慢,不适用于大量数据的加密。

常见的非对称加密算法有:RSA、ECC等。

1.3.2Kerberos认证流程

整个Kerberos认证流程中涉及到三种角色:客户端Client、服务端Server、密钥分发中心KDC(Key Distribution Center)。

- 客户端 (Client):发送请求的一方。

- 服务端 (Server):接收请求的一方。

- 密钥分发中心 (Key Distribution Center , KDC):KDC是一个网络服务,提供ticket和临时会话密钥。由三个部分组成:认证服务器(Authentication Server,AS)、票证授予服务器(Ticket Grantion Server,TGS)、Kerberos数据库。

- 认证服务器 AS :认证服务器。负责认证客户端的身份并发放客户端访问TGS的TGT(Ticket Grantion Ticket,票据授予票据)。

- 票证授予服务器TGS:票据授予服务器。用来发放客户端访问服务端所需的服务授予票据(ticket)。

- Kerberos 数据库:客户端和服务端添加进keberos系统时有对应的密钥,数据负责存储这些密钥,并保存客户端和服务端的基本信息,如:用户名、用户IP地址、服务端IP、服务端名称等。

Kerberos认证流程图如下:

Kerberos认证过程总体流程为: 客户端向 KDC 请求要访问的目标服务器的服务授予票据( ticket ) , 然后客户端拿着从 KDC 获取的服务授予票据( ticket )访问服务端。 在以上这个过程中,需要保证客户端和服务端为正确的客户端和服务端,整个Keberos认证流程共有三次交互,如下:

- 客户端向KDC AS 获取 TGT

为了获取访问服务端的服务授予票据,客户端首先向KDC中AS获取TGT(票据授予票据),客户端需要使用TGT去KDC中的TGS(票据授予中心)获取访问服务端所需的Ticket(服务授予票据)才能进一步的与服务端通信。

客户端首先向KDC以明文方式发起请求,该请求中携带了访问KDC的用户名、主机IP、当前时间戳。由于客户端是第一次访问KDC,KDC中AS(认证服务器)接收请求后,去Kerberos数据库中验证是否存在访问的用户名,这个过程不会判断身份的可靠性。如果没有该用户名,认证失败;如果存在该用户名,AS会返回两部分信息给客户端:

- 第一部分信息为票据授予票据(TGT),TGT包含该客户端的名称、IP、当前时间戳、客户端即将访问TGS的名称、TGT的有效时间以及客户端与TGS之间通信的session_key(后续简称CT_SK),该key后续会用来对客户端向TGS发送的消息加密。

整个TGT使用TGS公钥加密,客户端是解密不了,后续客户端需要使用TGT去KDC中的TGS(票据授予中心)获取访问服务端所需的Ticket(服务授予票据)。

- 第二部分信息是使用客户端公钥加密的信息,该信息包含客户端和TGS通信的session_key(CT_SK)、客户端将要访问TGS的名称、TGT的有效时间以及当前时间戳。该部分内容由于是使用客户端密钥进行加密,所以客户端拿到该部分内容可以使用自己私钥进行解密,如果这时数据被劫持到一个假的客户端,由于真正客户端的私钥没有在网络中传输过,所以假的客户端无法对这部分信息进行解密,认证流程就会中断。只有正确的客户端才能对这部分信息进行解密,这个过程相当于是对客户端进行认证。

- 客户端向 KDC TGS 获取目标服务器的服务授予票据 ticket

客户端收到了来自KDC AS 返回的两部分信息后,对第二部分信息进行解密,可以获取与TGS通信的session_key(CT_SK)、将要访问TGS的名称、时间戳。首先会检查时间戳是否与自己返送数据的时间戳相差5分钟,如果大于5分钟则认为该AS是假的,认证中断。如果时延合理,客户端便向TGS发起请求去获取要访问目标服务端的服务授予票据ticket。

客户端向KDC TGS请求的信息包括三部分:

- 客户端将要访问的服务端名称

- 客户端从KDC AS中获取的第一部分信息,即:使用TGS密钥加密的TGT,通过TGT客户端可以从TGS中获取访问服务器的服务授予票据ticket。

- 使用CT_SK加密的信息,包括客户端名称、IP、时间戳。

当KDC中的TGS收到了客户端的请求后,首先去Kerberos数据库中查询是否存在该服务端,如果不存在认证失败。如果存在,TGS会使用自己的私钥对TGT进行解密,从而获取到经过KDC AS 认证过的客户端信息、CT_SK、时间戳信息,TGS会根据时间戳判断此次通信是否超出时间延迟,如果正常,TGS会对客户端发送过来的加密信息(使用CT_SK加密的信息)进行解密,获取客户端名称、IP信息,如果这部分信息与TGT中的客户端信息一致,那么就确认客户端的身份正确,否则中断认证。

KDC TGS通过确认是对的客户端后,会将如下两部分信息返回给客户端:

- 第一部分信息:客户端需要访问服务端需要的Server Ticket(服务授予票据,后续简称ST),该Ticket通过Server公钥进行加密,其中包括客户端名称、IP、需要访问的服务端的IP、ST有效时间、时间戳、用于客户端与服务端之间通信的session_key(后续简称CS_SK)。

- 第二部分信息:使用CT_SK加密的内容,这些加密内容包括:CS_SK、时间戳、ST有效时间,由于客户端与AS通信时,AS已经将CT_SK私钥通过客户端公钥加密交给了客户端,客户端缓存了CT_SK,并能对该部分内容进行解密。

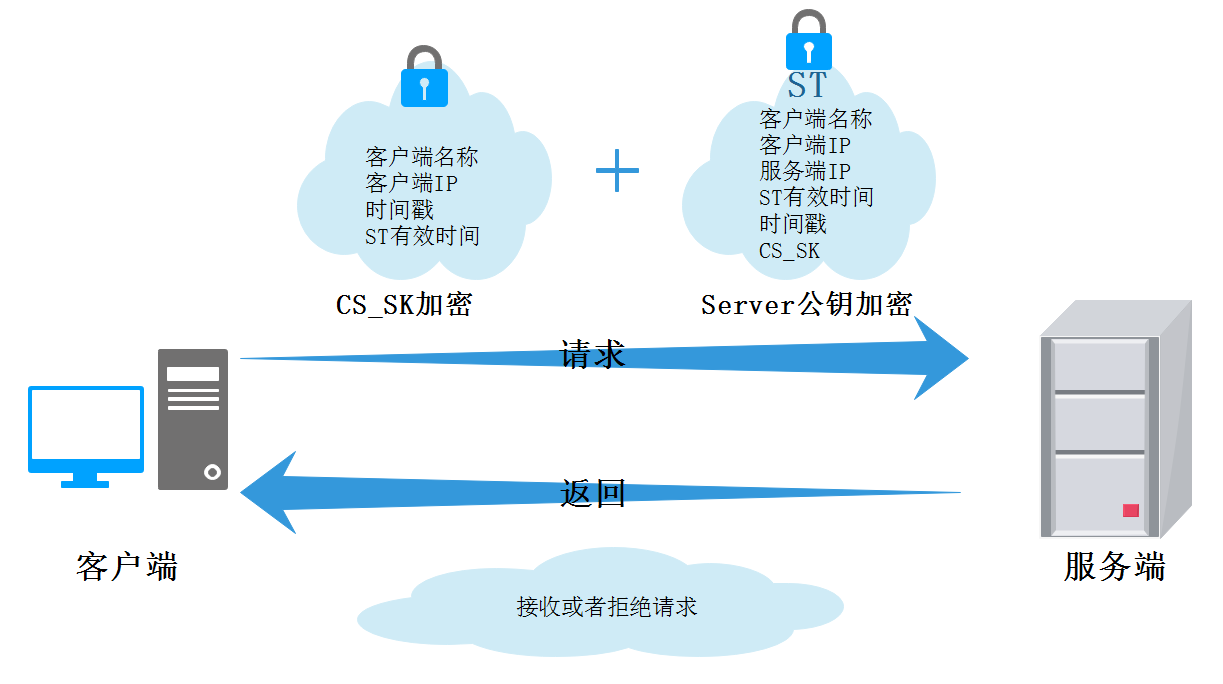

- 客户端向服务端发送通信请求

当客户端收到来自KDC TGS的响应后,对第二部分内容进行解密,获取CS_SK、时间戳、ST有效时间,检查时间戳在时间延迟范围内,向服务端进行请求。

客户端会通过CS_SK将客户端名称、时间戳进行加密发送给服务端,此外还会将服务授予票据ST发送给服务端。

服务端收到来自客户端的请求,会使用自己私钥对ST进行解密获取信息(客户端名称、IP、需要访问的服务端的IP、ST有效时间、时间戳、用于客户端与服务端之间通信的CS_SK),将CS_SK取出对客户端发来的通过CS_SK加密的内容进行解密获取信息(客户端名称、时间戳),如果客户端信息一致说明该客户端是通过KDC认证的客户端,可以进一步提供服务,这时服务端返回通过CS_SK加密的接收请求信息给客户端,客户端接收到该请求后,使用缓存在客户端的CS_SK解密后,也确认了服务端身份,这个过程服务端还会通过数字证书证明自己身份。

以上3个步骤代表了整个kerberos认证的流程,通信的客户端和服务端都确认了双方的身份信息。这个过程使用了各方的密钥,且密钥的种类一直变化,为了防止网络拦截密钥,这些密钥都是临时生成的Session key,即它们只在一次Session会话中起作用,即使密钥被劫持,等到密钥被破解可能这次会话都早已结束,这为整个Kerberos认证过程保证了较高的安全性。

1.4Kerberos优势

Kerberos具备如下三点优势:

- 密码无需进行网络传输。基于 Ticket 实现身份认证,保障密钥安全性。

- 双向认证。整个认证过程中,不仅需要客户端进行认证,待访问的服务也需要进行身份认证。

- 高性能。密钥采用对称加密方式,相比于SSL的密钥操作快几个数量级。一旦Client获得用过访问某个Server的Ticket,该Server就能根据这个Ticket实现对Client的验证,而无须KDC的再次参与。

2第二章 Kerberos安装及使用

2.1Kerberos术语

通过Kerberos认证原理介绍,我们已经了解到Kerberos的一些术语,还有一些术语可以更好的帮助我们学习Kerberos,如下:

- realm :领域,身份验证管理域,领域确定了管理边界,所有主体均属于特定的Kerberos域。

- principal :主体,Principal主体用于标识身份,每个参与Kerberos认证协议的用户和服务都需要一个主体来唯一标识自己。Principal由三部分组成:名字(name)、实例(instance)、域(realm),例如一个标准的Kerberos用户/服务表示为:name/instance@REALM。

- name :表示用户名。

- instance :对name的进一步描述,例如name所在的主机名或name的类型等。可以省略,与第一部分使用"/"分割

- realm :就是前面说的领域,表示Kerberos在管理上的划分,在 KDC 中所负责的一个域数据库称作为 Realm。这个数据库中存放有该网络范围内的所有 Principal 和它们的密钥,Realm一般都是大写。

用户principal的命名类似:zhangsan/admin@EXAMPLE.COM,形式是用户名/角色/realm域。

服务principal的命名类似:ftp/site.example.com@EXAMPLE.COM,形式是服务名/地址/realm域。

- keytab :Kerberos认证有两种方式——通过密码或者密钥文件进行认证。这里说的keytab就是密钥文件,该文件包含Principal主体的用户名及密码,客户端可以通过Keytab密钥文件进行身份验证。

- kadmin :即Kerberos administration server,运行在主kerberos节点。负责存储KDC数据库,管理principal信息。

2.2Kerberos安装

Kerberos架构是客户端/服务端架构方式,安装kerberos涉及到3个安装包:krb5-server、krb5-workstation、krb5-libs:

- krb5-server:Kerberos服务端程序,KDC所在节点。

- krb5-workstation:包含基本的Kerberos程序,如:kinit、klist、kdestroy、kpasswd,所有kerberos节点需要部署。

- krb5-libs:包含Kerberos程序的各种支持类库,所有节点部署。

这里搭建Kerberos选择一台节点当做Kerberos服务端,其他节点为Kerberos客户端,节点分布如下:

| 节点IP | 节点名称 | Kerberos 服务端 | Kerberos 客户端 |

|---|---|---|---|

| 192.168.179.4 | node1 | ★ | ★ |

| 192.168.179.5 | node2 | ★ | |

| 192.168.179.6 | node3 | ★ | |

| 192.168.179.7 | node4 | ★ | |

| 192.168.179.8 | node5 | ★ |

Kerberos安装步骤如下:

- 安装 Kerberos 服务端

在node1节点上安装kerberos服务端:

[root@node1 ~]# yum install -y krb5-server

以上安装完成后会在KDC主机上生成配置文件:/var/kerberos/krb5kdc/kdc.conf。

- 安装 kerberos 客户端

在node1~node5节点安装Kerberos客户端:

[root@node1 ~]# yum install -y krb5-workstation krb5-libs

[root@node2 ~]# yum install -y krb5-workstation krb5-libs

[root@node3 ~]# yum install -y krb5-workstation krb5-libs

[root@node4 ~]# yum install -y krb5-workstation krb5-libs

[root@node5 ~]# yum install -y krb5-workstation krb5-libs

以上安装完成后会在客户端生成配置文件/etc/krb5.conf。

- 配置服务端 kdc.conf 文件

kdc.conf文件位于node1服务端/var/kerberos/krb5kdc/路径中,可以通过配置改文件来增加realm域信息。

#vim /var/kerberos/krb5kdc/kdc.conf

[kdcdefaults]

kdc_ports = 88

kdc_tcp_ports = 88

[realms]

EXAMPLE.COM = {

#master_key_type = aes256-cts

acl_file = /var/kerberos/krb5kdc/kadm5.acl

dict_file = /usr/share/dict/words

admin_keytab = /var/kerberos/krb5kdc/kadm5.keytab

supported_enctypes = aes256-cts:normal aes128-cts:normal des3-hmac-sha1:normal arcfour-hmac:normal camellia256-cts:normal camellia128-cts:normal des-hmac-sha1:normal des-cbc-md5:normal des-cbc-crc:normal }

该配置文件中的各个配置项可以参考:https://web.mit.edu/kerberos/krb5-1.20/doc/admin/conf_files/kdc_conf.html#kdc-conf-5,以上针对各个配置说明:

- kdc_ports:KDC服务监听的端口。

- EXAMPLE.COM:设定的realms,名字随意。Kerberos可以支持多个realms,一般为大写。

- master_key_type:指定Kerberos主密钥加密算法类型,默认使用aes256-cts。

- acl_file:ACL文件路径,Kerberos通过该文件来确定哪些Principal具有哪些权限。

- dict_file:存放一个由多行字符串构成的文本文件,该文件中的字符串禁止作为密码使用。

- admin_keytab:KDC进行校验的keytab,该keytab用于认证管理员的密钥。

- supported_enctypes:支持的加密算法类型。

以上该文件暂时不做修改。

- 所有客户端配置 krb5.conf

krb5.conf文件位于客户端/etc/目录下,下面在node1客户端配置/etc/krb5.conf文件,配置完成后分发到node2~node5所有的客户端。

#node1客户端配置 /etc/krb5.conf文件如下:

# Configuration snippets may be placed in this directory as well

includedir /etc/krb5.conf.d/

[logging]

default = FILE:/var/log/krb5libs.log

kdc = FILE:/var/log/krb5kdc.log

admin_server = FILE:/var/log/kadmind.log

[libdefaults]

dns_lookup_realm = false

ticket_lifetime = 24h

renew_lifetime = 7d

forwardable = true

rdns = false

pkinit_anchors = FILE:/etc/pki/tls/certs/ca-bundle.crt

default_realm = EXAMPLE.COM

# default_ccache_name = KEYRING:persistent:%{uid}

[realms]

EXAMPLE.COM = {

kdc = node1

admin_server = node1

}

[domain_realm]

# .example.com = EXAMPLE.COM

# example.com = EXAMPLE.COM

关于该文件配置项的详细内容参考:https://web.mit.edu/kerberos/krb5-1.20/doc/admin/conf_files/krb5_conf.html#krb5-conf-5。该配置文件的解释如下:

- logging模块:配置默认即可,KDC和Kadmin服务的log文件路径。

- libdefaults模块:

- dns_lookup_realm:使用主机域名到kerberos domain的映射定位KDC。

- ticket_lifetime:ticket过期时间,超过这个时间ticket需要重新申请或renew。

- renew_lifetime:ticket可进行renew的时间限制。

- forwardable:如果配置为true,在KDC允许的情况下,初始ticket可以被转发。

- rdns:是否可使用逆向DNS。

- pkinit_anchors:签署KDC证书的根证书。

- default_realm:指定默认的realm,需要设置,否则后续Kerberos服务不能正常启动。

- default_ccache_name:默认凭据缓存的命名规则,这里注释掉,否则后续HDFS客户端不能认证操作HDFS。

- realms模块:

realms模块按照如下模板进行配置即可:

EXAMPLE.COM = {

kdc = kerberos.example.com

admin_server = kerberos.example.com

}

- kdc:KDC服务所在节点。

- admin_server:kadmin服务所在节点,即Kerberos administration server。

- domain_realm模块:

此模块配置了domain name 或者hostname同kerberos realm之间的映射关系。将以上配置好的文件,发送到node2~node5节点上:

[root@node1 ~]# scp /etc/krb5.conf node2:/etc/

[root@node1 ~]# scp /etc/krb5.conf node3:/etc/

[root@node1 ~]# scp /etc/krb5.conf node4:/etc/

[root@node1 ~]# scp /etc/krb5.conf node5:/etc/

- 服务端配置 kadm5.acl 文件

kadm5.acl位于服务端/var/kerberos/krb5kdc/kadm5.acl,该ACL文件用于控制kadmin数据库的访问权限,以及哪些Principal可以操作其他的Principal,配置如下:

*/admin@EXAMPLE.COM *

以上配置表示名称匹配*/admin@EXAMPLE.COM的Principal都认为是admin管理员角色,权限是*代表全部权限。可以根据自己配置情况修改对应的域,这里暂不做修改。

6.服务初始化Kadmin 数据库

初始化Kadmin数据库的命令格式为:

kdb5_util create -s -r [realm]

以上-s表示生成存储文件,-r指定realm name ,以上命令需要在服务端执行,执行后默认创建的数据库路径为:/var/kerberos/krb5kdc,如果需要重建数据库,将该目录下的principal相关的文件删除即可,请牢记数据库密码。

这里在node1节点上初始化Kadmin数据库,操作如下:

[root@node1 ~]# kdb5_util create -s -r EXAMPLE.COM

Loading random data

Initializing database '/var/kerberos/krb5kdc/principal' for realm 'EXAMPLE.COM',

master key name 'K/M@EXAMPLE.COM'

You will be prompted for the database Master Password.

It is important that you NOT FORGET this password.

Enter KDC database master key: 123456

Re-enter KDC database master key to verify:123456

当Kerberos database创建好了之后,在/var/kerberos/krb5kdc路径中可以看到生成的principal相关文件。

- 启动 Kerberos 服务并设置开机自启动

在服务端启动Kerberos服务。

#启动Kerberos服务命令,两个服务也可分开启动

[root@node1 ~]# systemctl start krb5kdc

[root@node1 ~]# systemctl start kadmin

#设置开机自启动

[root@node1 ~]# systemctl enable krb5kdc

[root@node1 ~]# systemctl enable kadmin

#查看两个服务启动状态

[root@node1 ~]# systemctl status krb5kdc kadmin

2.3Kerberos使用

2.3.1Kadmin 数据库操作

可以在客户端和服务端对Kadmin数据库进行操作,由于Kadmin数据库本身就在服务端,所以如果在服务端操作Kadmin数据库只需要通过输入"kadmin.local"命令即可,如果在客户端操作Kadmin数据库,可以直接输入"kadmin"命令,但需要先在客户端进行主体认证,才可以在客户端对数据库进行操作。

下面在服务端操作Kadmin数据库进行命令演示。在node1输入"kadmin.local"命令:

[root@node1 ~]# kadmin.local

Authenticating as principal root/admin@EXAMPLE.COM with password.

kadmin.local:

以上进入交互窗口,输入"?"可以获取所有命令和解释:

kadmin.local: ?

Available kadmin.local requests:

add_principal, addprinc, ank

Add principal

delete_principal, delprinc

Delete principal

modify_principal, modprinc

Modify principal

rename_principal, renprinc

Rename principal

change_password, cpw Change password

get_principal, getprinc Get principal

list_principals, listprincs, get_principals, getprincs

List principals

add_policy, addpol Add policy

modify_policy, modpol Modify policy

delete_policy, delpol Delete policy

get_policy, getpol Get policy

list_policies, listpols, get_policies, getpols

List policies

get_privs, getprivs Get privileges

ktadd, xst Add entry(s) to a keytab

ktremove, ktrem Remove entry(s) from a keytab

lock Lock database exclusively (use with extreme caution!)

unlock Release exclusive database lock

purgekeys Purge previously retained old keys from a principal

get_strings, getstrs Show string attributes on a principal

set_string, setstr Set a string attribute on a principal

del_string, delstr Delete a string attribute on a principal

list_requests, lr, ? List available requests.

quit, exit, q Exit program.

kadmin.local:

我们也可以直接在服务端执行:kadmin.local -q "命令",不进入交互窗口直接操作Kadmin数据库,下面介绍常见的操作命令。

2.3.1.1list princs

listprincs命令是列出所有的Principal主体

kadmin.local: listprincs

K/M@EXAMPLE.COM

kadmin/admin@EXAMPLE.COM

kadmin/changepw@EXAMPLE.COM

kadmin/node1@EXAMPLE.COM

kiprop/node1@EXAMPLE.COM

krbtgt/EXAMPLE.COM@EXAMPLE.COM

2.3.1.2addprinc

addprinc命令是添加一个principal。

kadmin.local: addprinc test/admin

WARNING: no policy specified for test/admin@EXAMPLE.COM; defaulting to no policy

Enter password for principal "test/admin@EXAMPLE.COM": 123456

Re-enter password for principal "test/admin@EXAMPLE.COM": 123456

Principal "test/admin@EXAMPLE.COM" created.

#再次查看principal

kadmin.local: listprincs

K/M@EXAMPLE.COM

kadmin/admin@EXAMPLE.COM

kadmin/changepw@EXAMPLE.COM

kadmin/node1@EXAMPLE.COM

kiprop/node1@EXAMPLE.COM

krbtgt/EXAMPLE.COM@EXAMPLE.COM

test/admin@EXAMPLE.COM

#再次添加principal,该principal没有指定对应的角色权限,也是可以的。

kadmin.local: addprinc test2

WARNING: no policy specified for test2@EXAMPLE.COM; defaulting to no policy

Enter password for principal "test2@EXAMPLE.COM": 123456

Re-enter password for principal "test2@EXAMPLE.COM": 123456

Principal "test2@EXAMPLE.COM" created.

#查看principal

kadmin.local: listprincs

K/M@EXAMPLE.COM

kadmin/admin@EXAMPLE.COM

kadmin/changepw@EXAMPLE.COM

kadmin/node1@EXAMPLE.COM

kiprop/node1@EXAMPLE.COM

krbtgt/EXAMPLE.COM@EXAMPLE.COM

test/admin@EXAMPLE.COM

test2@EXAMPLE.COM

注意:

- 以上创建的test/admin principal第二部分是admin,根据之前在kadm5.acl文件中指定的匹配规则,该principal就相当于是admin管理员用户。在创建Principal是也可以不指定第二部分,这种用户就是普通用户。

- 关于创建好的用户如何去认证,参考后续kinit命令。

2.3.1.3delprinc

delprinc可以删除principal

kadmin.local: delprinc test2

Are you sure you want to delete the principal "test2@EXAMPLE.COM"? (yes/no): yes

Principal "test2@EXAMPLE.COM" deleted.

Make sure that you have removed this principal from all ACLs before reusing.

kadmin.local: delprinc test/admin

Are you sure you want to delete the principal "test/admin@EXAMPLE.COM"? (yes/no): yes

Principal "test/admin@EXAMPLE.COM" deleted.

Make sure that you have removed this principal from all ACLs before reusing.

#再次查看principal,之前创建的principal已经被删除

kadmin.local: listprincs

K/M@EXAMPLE.COM

kadmin/admin@EXAMPLE.COM

kadmin/changepw@EXAMPLE.COM

kadmin/node1@EXAMPLE.COM

kiprop/node1@EXAMPLE.COM

krbtgt/EXAMPLE.COM@EXAMPLE.COM

2.3.1.4change_password

change_password命令可以修改principal密码。

#创建test/admin principal主体,指定密码为123123

kadmin.local: addprinc test/admin

WARNING: no policy specified for test/admin@EXAMPLE.COM; defaulting to no policy

Enter password for principal "test/admin@EXAMPLE.COM": 123123

Re-enter password for principal "test/admin@EXAMPLE.COM": 123123

Principal "test/admin@EXAMPLE.COM" created.

#修改test/admin principal主体密码为123456

kadmin.local: change_password test/admin

Enter password for principal "test/admin@EXAMPLE.COM": 123456

Re-enter password for principal "test/admin@EXAMPLE.COM": 123456

Password for "test/admin@EXAMPLE.COM" changed.

注意:对Principal主体修改密码后,需要使用kinit命令认证时需要使用新密码。

2.3.1.5ktadd

ktadd命令key生成一个keytab文件,或者将一个principal加入到keytab。Kerberos客户端的认证支持两种方式,一种是用户名和密码认证方式,适合交互式应用。另一种是可以使用keytab密钥文件认证,可以通过ktadd命令将对应的principal主体添加到keytab文件,这样客户端就可以拿着keytab文件进行认证。关于参看后文kinit命令。

#在node1上创建目录,用于存储keytab文件

[root@node1 ~]# mkdir /root/kerberos_keytab

#将test/admin@EXAMPLE.COM主体加入到keytab文件

kadmin.local: ktadd -norandkey -kt /root/kerberos_keytab/test.keytab test/admin@EXAMPLE.COM

Entry for principal test/admin@EXAMPLE.COM with kvno 2, encryption type aes256-cts-hmac-sha1-96 added to keytab WRFILE:/root/kerberos_keytab/test

.keytab.Entry for principal test/admin@EXAMPLE.COM with kvno 2, encryption type aes128-cts-hmac-sha1-96 added to keytab WRFILE:/root/kerberos_keytab/test

.keytab.Entry for principal test/admin@EXAMPLE.COM with kvno 2, encryption type des3-cbc-sha1 added to keytab WRFILE:/root/kerberos_keytab/test.keytab.

Entry for principal test/admin@EXAMPLE.COM with kvno 2, encryption type arcfour-hmac added to keytab WRFILE:/root/kerberos_keytab/test.keytab.

Entry for principal test/admin@EXAMPLE.COM with kvno 2, encryption type camellia256-cts-cmac added to keytab WRFILE:/root/kerberos_keytab/test.ke

ytab.Entry for principal test/admin@EXAMPLE.COM with kvno 2, encryption type camellia128-cts-cmac added to keytab WRFILE:/root/kerberos_keytab/test.ke

ytab.Entry for principal test/admin@EXAMPLE.COM with kvno 2, encryption type des-hmac-sha1 added to keytab WRFILE:/root/kerberos_keytab/test.keytab.

Entry for principal test/admin@EXAMPLE.COM with kvno 2, encryption type des-cbc-md5 added to keytab WRFILE:/root/kerberos_keytab/test.keytab.

针对以上"ktadd -norandkey -kt /root/kerberos_keytab/test.keytab test/admin@EXAMPLE.COM"命令解释如下:

- 命令中"-norandkey"表示不使用随机密码,如果不指定那么会对该主体随机生成密码,源密码不可用,建议指定,这样客户端使用该主体即可使用密码验证也可以使用keytab密钥文件验证。

- 命令执行后产生了8个entry,原因是在kdc.conf的supported_enctypes配置项指定了8种加密算法,因此这里会打印出8个entry。

- 关于生成keytab文件,如果指定路径下没有该文件,会生成一个新的keytbl文件,然后将指定principal添加到该keytab;如果有该keytab文件会直接追加写入。

- 关于如何使用keytab方式认证命令参考下文kinit命令。

我们也可以使用ktadd命令将多个principal加入到同一个keytab文件中,这样该keytab就可以用于认证多个用户,操作如下:

#创建新的principal主体demo/admin

kadmin.local: addprinc demo/admin

WARNING: no policy specified for demo/admin@EXAMPLE.COM; defaulting to no policy

Enter password for principal "demo/admin@EXAMPLE.COM": 123456

Re-enter password for principal "demo/admin@EXAMPLE.COM": 123456

Principal "demo/admin@EXAMPLE.COM" created.

#将demo/admin加入到/root/kerberos_keytab/test.keytab密钥中

kadmin.local: ktadd -norandkey -kt /root/kerberos_keytab/test.keytab demo/admin@EXAMPLE.COM

#可以退出kadmin.local数据库操作窗口,执行如下命令查看keytab 文件关联的principal

[root@node1 ~]# klist -kt /root/kerberos_keytab/test.keytab

Keytab name: FILE:/root/kerberos_keytab/test.keytab

KVNO Principal

---- --------------------------------------------------------------------------

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

1 demo/admin@EXAMPLE.COM

1 demo/admin@EXAMPLE.COM

1 demo/admin@EXAMPLE.COM

1 demo/admin@EXAMPLE.COM

1 demo/admin@EXAMPLE.COM

1 demo/admin@EXAMPLE.COM

1 demo/admin@EXAMPLE.COM

1 demo/admin@EXAMPLE.COM

2.3.1.6ktremove

keremove命令可以从keytab文件中删除关联的pricipal

针对keytab文件中关联的多个pricipal可以通过ktremove命令来删除pricipal主体与keytab密钥文件的关联。

[root@node1 ~]# kadmin.local

kadmin.local: ktremove -kt /root/kerberos_keytab/test.keytab demo/admin@EXAMPLE.COM

以上命令将demo/admin@EXAMPLE.COM主体与keytab文件删除了关联。再次查看keytab 文件关联的principal。

[root@node1 ~]# klist -kt /root/kerberos_keytab/test.keytab

Keytab name: FILE:/root/kerberos_keytab/test.keytab

KVNO Principal

---- --------------------------------------------------------------------------

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

2 test/admin@EXAMPLE.COM

2.3.2Kerberos命令

2.3.2.1kinit

kinit命令可以对Principal主体进行认证,获取principal授予的票据并缓存。Kerberos客户端支持两种认证方式,一是使用Principal + Password,二是使用Principal + keytab,前者适合用户进行交互式应用,例如hadoop fs -ls 这种,后者适合服务,例如yarn的rm、nm等。principal + keytab就类似于ssh免密码登录,登录时不需要密码。

无论使用以上哪种认证方式需要在Kerberos数据库中创建对应Principal主体,下面在服务端创建主体test/test ,也可以不指定对应的角色,并且生成keytab文件。

#node1服务端创建test/test主体

[root@node1 ~]# kadmin.local -q "addprinc test/test"

Authenticating as principal root/admin@EXAMPLE.COM with password.

WARNING: no policy specified for test/test@EXAMPLE.COM; defaulting to no policy

Enter password for principal "test/test@EXAMPLE.COM": 123456

Re-enter password for principal "test/test@EXAMPLE.COM": 123456

Principal "test/test@EXAMPLE.COM" created.

#将主体添加到keytab文件中

[root@node1 ~]# kadmin.local -q "ktadd -norandkey -kt /root/kerberos_keytab/my.keytab test/test@EXAMPLE.COM"

- 使用 password 进行认证

在node1~node5任意客户端上使用kinit命令进行认证。

[root@node2 ~]# kinit test/test@EXAMPLE.COM

Password for test/test@EXAMPLE.COM: 123456

注意:可以使用kinit -h 查看kinit的使用参数。

- 使用 keytab 进行认证

在node1~node5任意客户端上准备keytab文件,然后通过kinit 命令指定keytab文件进行认证。

#将node1节点上生成的my.keytab文件分发到node2节点/root目录下

[root@node1 ~]# scp /root/kerberos_keytab/my.keytab node2:/root/

#在node2节点进行客户端认证

[root@node2 ~]# kinit test/test@EXAMPLE.COM -kt /root/my.keytab

注意:指定keytab文件时必须写成 -kt。

也可以在客户端节点上执行kadmin命令,需要使用具有admin权限的Principal主体,命令如下:

[root@node5 ~]# kadmin -p test/admin@EXAMPLE.COM -w 123456

Authenticating as principal test/admin@EXAMPLE.COM with password.

kadmin: listprincs

K/M@EXAMPLE.COM

demo/admin@EXAMPLE.COM

kadmin/admin@EXAMPLE.COM

kadmin/changepw@EXAMPLE.COM

kadmin/node1@EXAMPLE.COM

kiprop/node1@EXAMPLE.COM

krbtgt/EXAMPLE.COM@EXAMPLE.COM

test/admin@EXAMPLE.COM

test/test@EXAMPLE.COM

2.3.2.2klist

通过 klist命令可以查看当前凭据缓存内的票据Ticket。

[root@node2 ~]# klist

Ticket cache: KEYRING:persistent:0:0

Default principal: test/test@EXAMPLE.COM

Valid starting Expires Service principal

2023-05-10T15:03:37 2023-05-11T15:03:37 krbtgt/EXAMPLE.COM@EXAMPLE.COM

#如果在没有认证的客户端节点执行klist命令,查询不到缓存的Ticket

[root@node3 kerberos]# klist

klist: Credentials cache keyring 'persistent:0:0' not found

除之外,klist还可以列出keytab文件关联的Pricipal主体:

[root@node2 ~]# klist -kt /root/my.keytab

Keytab name: FILE:/root/my.keytab

KVNO Timestamp Principal

---- ------------------- ------------------------------------------------------

1 2023-05-10T14:58:23 test/test@EXAMPLE.COM

1 2023-05-10T14:58:23 test/test@EXAMPLE.COM

1 2023-05-10T14:58:23 test/test@EXAMPLE.COM

1 2023-05-10T14:58:23 test/test@EXAMPLE.COM

1 2023-05-10T14:58:23 test/test@EXAMPLE.COM

1 2023-05-10T14:58:23 test/test@EXAMPLE.COM

1 2023-05-10T14:58:23 test/test@EXAMPLE.COM

1 2023-05-10T14:58:23 test/test@EXAMPLE.COM

2.3.2.3kdestroy

kdestroy命令用来销毁当前认证缓存的票据,该命令不需要任何参数,可以指定kdestroy -A 删除所有用户的票据缓存,不指定-A 仅删除当前用户的票据缓存。

[root@node2 ~]# kdestroy

Other credential caches present, use -A to destroy all

3第三章 大数据技术组件搭建

这里使用5台节点组成大数据集群:node1~node5,所有技术组件搭建到该集群中,默认这些节点配置为4core+4G,每个节点都已经配置了IP、主机名称、关闭防火墙、关闭Selinux、配置阿里yum源、设置时间自动同步、所有节点配置安装jdk8、node2节点已经安装mysql5.7、节点之间root用户已经两两免密。节点信息如下:

| 节点IP | 节点名称 |

|---|---|

| 192.168.179.4 | node1 |

| 192.168.179.5 | node2 |

| 192.168.179.6 | node3 |

| 192.168.179.7 | node4 |

| 192.168.179.8 | node5 |

3.1安装Zookeeper

3.1.1节点划分

这里搭建zookeeper版本为3.6.3,搭建zookeeper对应的角色分布如下

| 节点IP | 节点名称 | Zookeeper |

|---|---|---|

| 192.168.179.4 | node1 | |

| 192.168.179.5 | node2 | |

| 192.168.179.6 | node3 | ★ |

| 192.168.179.7 | node4 | ★ |

| 192.168.179.8 | node5 | ★ |

3.1.2 安装Zookeeper

- 上传zookeeper 并解压 , 配置环境变量

将zookeeper安装包上传到node3节点/software目录下并解压:

[root@node3 software]# tar -zxvf ./apache-zookeeper-3.6.3-bin.tar.gz

在node3节点配置环境变量:

#进入vim /etc/profile,在最后加入:

export ZOOKEEPER_HOME=/software/apache-zookeeper-3.6.3-bin/

export PATH=$PATH:$ZOOKEEPER_HOME/bin

#使配置生效

source /etc/profile

- 在node3 节点配置 zookeeper

进入"$ZOOKEEPER_HOME/conf"修改zoo_sample.cfg为zoo.cfg:

[root@node3 conf]# mv zoo_sample.cfg zoo.cfg

配置zoo.cfg中内容如下:

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/opt/data/zookeeper

clientPort=2181

server.1=node3:2888:3888

server.2=node4:2888:3888

server.3=node5:2888:3888

- 将配置好的zookeeper 发送到 node4,node5节点

[root@node3 software]# scp -r apache-zookeeper-3.6.3-bin node4:/software/

[root@node3 software]# scp -r apache-zookeeper-3.6.3-bin node5:/software/

- 各个节点上创建数据目录,并配置zookeeper环境变量

在node3,node4,node5各个节点上创建zoo.cfg中指定的数据目录"/opt/data/zookeeper"。

mkdir -p /opt/data/zookeeper

在node4,node5节点配置zookeeper环境变量

#进入vim /etc/profile,在最后加入:

export ZOOKEEPER_HOME=/software/apache-zookeeper-3.6.3-bin/

export PATH=$PATH:$ZOOKEEPER_HOME/bin

#使配置生效

source /etc/profile

- 各个节点创建节点 ID

在node3,node4,node5各个节点路径"/opt/data/zookeeper"中添加myid文件分别写入1,2,3:

#在node3的/opt/data/zookeeper中创建myid文件写入1

#在node4的/opt/data/zookeeper中创建myid文件写入2

#在node5的/opt/data/zookeeper中创建myid文件写入3

- 各个节点启动zookeeper, 并检查进程状态

#各个节点启动zookeeper命令

zkServer.sh start

#检查各个节点zookeeper进程状态

zkServer.sh status

3.2安装HDFS

3.2.1节点划分

这里安装HDFS版本为3.3.4,搭建HDFS对应的角色在各个节点分布如下:

| 节点IP | 节点名称 | NN | DN | ZKFC | JN | RM | NM |

|---|---|---|---|---|---|---|---|

| 192.168.179.4 | node1 | ★ | ★ | ★ | |||

| 192.168.179.5 | node2 | ★ | ★ | ★ | |||

| 192.168.179.6 | node3 | ★ | ★ | ★ | |||

| 192.168.179.7 | node4 | ★ | ★ | ★ | |||

| 192.168.179.8 | node5 | ★ | ★ | ★ |

3.2.2 安装配置HDFS

- 各个节点安装HDFS HA自动切换必须的依赖

yum -y install psmisc

- 上传下载好的Hadoop 安装包到 node1节点上,并解压

[root@node1 software]# tar -zxvf ./hadoop-3.3.4.tar.gz

- 在node1 节点上配置 Hadoop的环境变量

[root@node1 software]# vim /etc/profile

export HADOOP_HOME=/software/hadoop-3.3.4/

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:

#使配置生效

source /etc/profile

- 配置$HADOOP_HOME/etc/hadoop 下的 hadoop-env.sh文件

#导入JAVA_HOME

export JAVA_HOME=/usr/java/jdk1.8.0_181-amd64/

- 配置$HADOOP_HOME/etc/hadoop 下的 hdfs-site.xml文件

<configuration>

<property>

<!--这里配置逻辑名称,可以随意写 -->

<name>dfs.nameservices</name>

<value>mycluster</value>

</property>

<property>

<!-- 禁用权限 -->

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

<property>

<!-- 配置namenode 的名称,多个用逗号分割 -->

<name>dfs.ha.namenodes.mycluster</name>

<value>nn1,nn2</value>

</property>

<property>

<!-- dfs.namenode.rpc-address.[nameservice ID].[name node ID] namenode 所在服务器名称和RPC监听端口号 -->

<name>dfs.namenode.rpc-address.mycluster.nn1</name>

<value>node1:8020</value>

</property>

<property>

<!-- dfs.namenode.rpc-address.[nameservice ID].[name node ID] namenode 所在服务器名称和RPC监听端口号 -->

<name>dfs.namenode.rpc-address.mycluster.nn2</name>

<value>node2:8020</value>

</property>

<property>

<!-- dfs.namenode.http-address.[nameservice ID].[name node ID] namenode 监听的HTTP协议端口 -->

<name>dfs.namenode.http-address.mycluster.nn1</name>

<value>node1:50070</value>

</property>

<property>

<!-- dfs.namenode.http-address.[nameservice ID].[name node ID] namenode 监听的HTTP协议端口 -->

<name>dfs.namenode.http-address.mycluster.nn2</name>

<value>node2:50070</value>

</property>

<property>

<!-- namenode 共享的编辑目录, journalnode 所在服务器名称和监听的端口 -->

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://node3:8485;node4:8485;node5:8485/mycluster</value>

</property>

<property>

<!-- namenode高可用代理类 -->

<name>dfs.client.failover.proxy.provider.mycluster</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

<property>

<!-- 使用ssh 免密码自动登录 -->

<name>dfs.ha.fencing.methods</name>

<value>sshfence</value>

</property>

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/root/.ssh/id_rsa</value>

</property>

<property>

<!-- journalnode 存储数据的地方 -->

<name>dfs.journalnode.edits.dir</name>

<value>/opt/data/journal/node/local/data</value>

</property>

<property>

<!-- 配置namenode自动切换 -->

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

</configuration>

- 配置$HADOOP_HOME/ect/hadoop/core-site.xml

<configuration>

<property>

<!-- 为Hadoop 客户端配置默认的高可用路径 -->

<name>fs.defaultFS</name>

<value>hdfs://mycluster</value>

</property>

<property>

<!-- Hadoop 数据存放的路径,namenode,datanode 数据存放路径都依赖本路径,不要使用 file:/ 开头,使用绝对路径即可

namenode 默认存放路径 :file://${hadoop.tmp.dir}/dfs/name

datanode 默认存放路径 :file://${hadoop.tmp.dir}/dfs/data

-->

<name>hadoop.tmp.dir</name>

<value>/opt/data/hadoop/</value>

</property>

<property>

<!-- 指定zookeeper所在的节点 -->

<name>ha.zookeeper.quorum</name>

<value>node3:2181,node4:2181,node5:2181</value>

</property>

</configuration>

- 配置$HADOOP_HOME/etc/hadoop/yarn-site.xml

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

<property>

<!-- 配置yarn为高可用 -->

<name>yarn.resourcemanager.ha.enabled</name>

<value>true</value>

</property>

<property>

<!-- 集群的唯一标识 -->

<name>yarn.resourcemanager.cluster-id</name>

<value>mycluster</value>

</property>

<property>

<!-- ResourceManager ID -->

<name>yarn.resourcemanager.ha.rm-ids</name>

<value>rm1,rm2</value>

</property>

<property>

<!-- 指定ResourceManager 所在的节点 -->

<name>yarn.resourcemanager.hostname.rm1</name>

<value>node1</value>

</property>

<property>

<!-- 指定ResourceManager 所在的节点 -->

<name>yarn.resourcemanager.hostname.rm2</name>

<value>node2</value>

</property>

<property>

<!-- 指定ResourceManager Http监听的节点 -->

<name>yarn.resourcemanager.webapp.address.rm1</name>

<value>node1:8088</value>

</property>

<property>

<!-- 指定ResourceManager Http监听的节点 -->

<name>yarn.resourcemanager.webapp.address.rm2</name>

<value>node2:8088</value>

</property>

<property>

<!-- 指定zookeeper所在的节点 -->

<name>yarn.resourcemanager.zk-address</name>

<value>node3:2181,node4:2181,node5:2181</value>

</property>

<property>

<!-- 关闭虚拟内存检查 -->

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

<!-- 启用节点的内容和CPU自动检测,最小内存为1G -->

<!--<property>

<name>yarn.nodemanager.resource.detect-hardware-capabilities</name>

<value>true</value>

</property>-->

</configuration>

8. 配置$HADOOP_HOME/etc/hadoop/mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

- 配置$HADOOP_HOME/etc/hadoop/workers文件

[root@node1 ~]# vim /software/hadoop-3.3.4/etc/hadoop/workers

node3

node4

node5

- 配置$HADOOP_HOME/sbin/start-dfs.sh 和 stop-dfs.sh 两个文件中顶部添加以下参数,防止启动错误

HDFS_DATANODE_USER=root

HDFS_DATANODE_SECURE_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_JOURNALNODE_USER=root

HDFS_ZKFC_USER=root

11. 配置 $HADOOP_HOME/sbin/start-yarn.sh 和 stop-yarn.sh 两个文件顶部添加以下参数,防止启动错误

YARN_RESOURCEMANAGER_USER=root

YARN_NODEMANAGER_USER=root

- 将配置好的 Hadoop 安装包发送到其他 4个节点

[root@node1 ~]# scp -r /software/hadoop-3.3.4 node2:/software/

[root@node1 ~]# scp -r /software/hadoop-3.3.4 node3:/software/

[root@node1 ~]# scp -r /software/hadoop-3.3.4 node4:/software/

[root@node1 ~]# scp -r /software/hadoop-3.3.4 node5:/software/

也可以在对应其他节点上解压对应的安装包后,只发送对应的配置文件,这样速度较快。

- 在node2 、 node3 、 node4 、 node5 节点上配置 HADOOP_HOME

#分别在node2、node3、node4、node5节点上配置HADOOP_HOME

vim /etc/profile

export HADOOP_HOME=/software/hadoop-3.3.4/

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:

#最后记得Source

source /etc/profile

3.2.3初始化HDFS

#在node3,node4,node5节点上启动zookeeper

zkServer.sh start

#在node1上格式化zookeeper

[root@node1 ~]# hdfs zkfc -formatZK

#在每台journalnode中启动所有的journalnode,这里就是node3,node4,node5节点上启动

hdfs --daemon start journalnode

#在node1中格式化namenode

[root@node1 ~]# hdfs namenode -format

#在node1中启动namenode,以便同步其他namenode

[root@node1 ~]# hdfs --daemon start namenode

#高可用模式配置namenode,使用下列命令来同步namenode(在需要同步的namenode中执行,这里就是在node2上执行):

[root@node2 software]# hdfs namenode -bootstrapStandby

3.2.4启动及停止

#node1上启动HDFS,启动Yarn

[root@node1 sbin]# start-dfs.sh

[root@node1 sbin]# start-yarn.sh

注意以上也可以使用start-all.sh命令启动Hadoop集群。

#停止集群

[root@node1 ~]# stop-dfs.sh

[root@node1 ~]# stop-yarn.sh

注意:以上也可以使用 stop-all.sh 停止集群。

3.2.5访问WebUI

#访问HDFS : http://node1:50070

3.3安装Hive

3.3.1节点划分

这里搭建Hive的版本为3.1.3,搭建Hive的节点划分如下:

| 节点IP | 节点名称 | Hive服务器 | Hive客户端 | MySQL |

|---|---|---|---|---|

| 192.168.179.4 | node1 | ★ | ||

| 192.168.179.5 | node2 | ★(已搭建) | ||

| 192.168.179.6 | node3 | ★ |

3.3.2安装配置Hive

- 将下载好的Hive 安装包上传到 node1 节点上 ,并修改名称

[root@node1 ~]# cd /software/

[root@node1 software]# tar -zxvf ./apache-hive-3.1.3-bin.tar.gz

[root@node1 software]# mv apache-hive-3.1.3-bin hive-3.1.3

- 将解压好的Hive 安装包发送到 node3节点上

[root@node1 software]# scp -r /software/hive-3.1.3/ node3:/software/

- 配置 node1 、 node3 两台节点的 Hive 环境变量

vim /etc/profile

export HIVE_HOME=/software/hive-3.1.3/

export PATH=$PATH:$HIVE_HOME/bin

#source 生效

source /etc/profile

- 在 node1 节点 $HIVE_HOME/conf 下创建 hive-site.xml 并配置

<configuration>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

</property>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://node2:3306/hive?createDatabaseIfNotExist=true&useSSL=false</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

</configuration>

- 在node3 节点 $HIVE_HOME/conf/ 中创建 hive-site.xml并配置

<configuration>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

</property>

<property>

<name>hive.metastore.local</name>

<value>false</value>

</property>

<property>

<name>hive.metastore.uris</name>

<value>thrift://node1:9083</value>

</property>

</configuration>

- node1 、 node3 节点删除 $HIVE_HOME/lib 下" guava" 包,使用 Hadoop 下的包替换

#删除Hive lib目录下“guava-19.0.jar ”包

[root@node1 ~]# rm -rf /software/hive-3.1.3/lib/guava-19.0.jar

[root@node3 ~]# rm -rf /software/hive-3.1.3/lib/guava-19.0.jar

#将Hadoop lib下的“guava”包拷贝到Hive lib目录下

[root@node1 ~]# cp /software/hadoop-3.3.4/share/hadoop/common/lib/guava-27.0-jre.jar /software/hive-3.1.3/lib/

[root@node3 ~]# cp /software/hadoop-3.3.4/share/hadoop/common/lib/guava-27.0-jre.jar /software/hive-3.1.3/lib/

- 将"mysql-connector-java-5.1.47.jar" 驱动包上传到 $HIVE_HOME/lib目录下

这里node1,node3节点都需要传入,将mysql驱动包上传$HIVE_HOME/lib/目录下。

- 在node1 节点中初始化 Hive

#初始化hive,hive2.x版本后都需要初始化

[root@node1 ~]# schematool -dbType mysql -initSchema

3.3.3HiveServer2与Beeline

Hive Beeline 是Hive0.11版本引入的新命令行客户端,它是基于SQLLine Cli的JDBC客户端。Beeline工作模式有两种,即本地嵌入模式和远程模式。嵌入模式情况下,它返回一个嵌入式的Hive(类似于Hive CLI)。而远程模式则是通过Thrift协议与某个单独的HiveServer2进程进行连接通信。

想要通过Beeline写SQL查询Hive数据,必须配置HiveServer2服务,HiveServer2(HS2)是一种使客户端能够对Hive执行查询的服务。HiveServer2是已被废弃的HiveServer1(仅支持单客户端访问)的继承者。HiveServer2支持多客户端并发和身份验证。它旨在为JDBC和ODBC等开放API客户端提供更好的支持。

通过beeline和Hiverserver2连接操作Hive时,需要指定一个用户,这个用户可以随意指定,但是需要在HDFS中允许使用代理用户配置,需要在每台Hadoop 节点配置core-site.xml:

<!-- 配置代理访问用户 -->

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.users</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

配置好完成之后,将以上文件分发到各个hadoo节点上,然后重新启动HDFS。

3.3.4Hive 操作

- 服务端和客户端 client 操作

在服务端和客户端操作Hive,操作Hive之前首先启动HDFS集群,命令为:start-all.sh,启动HDFS集群后再进行Hive以下操作:

#在node1中登录Hive ,创建表test

[root@node1 conf]# hive

hive> create table test (id int,name string,age int ) row format delimited fields terminated by '\t';

#向表test中插入数据

hive> insert into test values(1,"zs",18);

#在node1启动Hive metastore

[root@node1 hadoop]# hive --service metastore &

#在node3上登录Hive客户端查看表数据

[root@node3 lib]# hive

hive> select * from test;

OK

1 zs 18

- 本地嵌入模式使用 Beeline

首先在Hive服务端node1启动HiverServer2,然后在node1上可以直接登录beeline,操作如下:

#在node1 Hive服务端启动hiveserver2

[root@node1 ~]# hiveserver2

#在node1 Hive服务端进行操作

beeline

beeline> !connect jdbc:hive2://mynode1:10000

随意输入用户名和密码即可

另外也可以使用另外一种方式登录beeline:

beeline -u "jdbc:hive2://node1:10000"

- 远程模式使用 Beeline

在实际开发中建议远程模式使用beeline,这样并不是在Hive的服务端进行操作,比较安全。远程使用beeline就是直接找到Hive的客户端然后启动beeline,前提是需要在Hive的服务端启动Hiveserver2服务,这种情况下客户端的beeline是通过Thrift协议与服务端的HiveServer2进程进行连接通信。

#在node1节点上启动HiveServer2,如启动可以忽略

[root@node1 ~]# hiveserver2

#在node3客户端登录beeline,然后可以正常查询SQL语句

[root@node1 ~]# hiveserver2

beeline

beeline> !connect jdbc:hive2://mynode1:10000

3.4安装HBase

3.4.1节点划分

这里选择HBase版本为2.2.6,搭建HBase各个角色分布如下:

| 节点 IP | 节点名称 | HBase服务 |

|---|---|---|

| 192.168.179.6 | node3 | RegionServer |

| 192.168.179.7 | node4 | HMaster,RegionServer |

| 192.168.179.8 | node5 | RegionServer |

3.4.2安装配置HBase

- 将下载好的安装包发送到node4 节点上 , 并解压 , 配置环境变量

#将下载好的HBase安装包上传至node4节点/software下,并解压

[root@node4 software]# tar -zxvf ./hbase-2.2.6-bin.tar.gz

当前节点配置HBase环境变量

#配置HBase环境变量

[root@node4 software]# vim /etc/profile

export HBASE_HOME=/software/hbase-2.2.6/

export PATH=$PATH:$HBASE_HOME/bin

#使环境变量生效

[root@node4 software]# source /etc/profile

- 配置$HBASE_HOME/conf/hbase-env.sh

#配置HBase JDK

export JAVA_HOME=/usr/java/jdk1.8.0_181-amd64/

#配置 HBase不使用自带的zookeeper

export HBASE_MANAGES_ZK=false

#Hbase中的jar包和HDFS中的jar包有冲突,以下配置设置为true,启动hbase不加载HDFS jar包

export HBASE_DISABLE_HADOOP_CLASSPATH_LOOKUP="true"

- 配置$HBASE_HOME/conf/hbase-site.xml

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://mycluster/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>node3,node4,node5</value>

</property>

<property>

<name>hbase.unsafe.stream.capability.enforce</name>

<value>false</value>

</property>

</configuration>

- 配置$HBASE_HOME/conf/regionservers ,配置 RegionServer 节点

node3

node4

node5

- 配置backup-masters文件

手动创建$HBASE_HOME/conf/backup-masters文件,指定备用的HMaster,需要手动创建文件,这里写入node5,在HBase任意节点都可以启动HMaster,都可以成为备用Master ,可以使用命令:hbase-daemon.sh start master启动。

#创建 $HBASE_HOME/conf/backup-masters 文件,写入node5

[root@node4 conf]# vim backup-masters

node5

- 复制hdfs-site.xml 到 $HBASE_HOME/conf/ 下

[root@node4 ~]# cp /software/hadoop-3.3.4/etc/hadoop/hdfs-site.xml /software/hbase-2.2.6/conf/

- 将HBase 安装包发送到 node3 , node5 节点上,并在 node3 , node5 节点上配置 HBase 环境变量

[root@node4 ~]# scp -r /software/hbase-2.2.6 node3:/software/

[root@node4 ~]# scp -r /software/hbase-2.2.6 node5:/software/

注意:在node3、node5上配置HBase环境变量。

vim /etc/profile

export HBASE_HOME=/software/hbase-2.2.6/

export PATH=$PATH:$HBASE_HOME/bin

#使环境变量生效

source /etc/profile

- 重启Zookeeper 、重启 HDFS 及启动 HBase集群

#注意:一定要重启Zookeeper,重启HDFS,在node4节点上启动HBase集群

[root@node4 software]# start-hbase.sh

#访问WebUI,http://node4:16010。

停止集群:在任意一台节点上stop-hbase.sh

3.4.3HBase操作

在Hbase中创建表test,指定'cf1','cf2'两个列族,并向表test中插入几条数据:

#进入hbase

[root@node4 ~]# hbase shell

#创建表test

create 'test','cf1','cf2'

#查看创建的表

list

#向表test中插入数据

put 'test','row1','cf1:id','1'

put 'test','row1','cf1:name','zhangsan'

put 'test','row1','cf1:age',18

#查询表test中rowkey为row1的数据

get 'test','row1'

3.5安装Kafka

3.5.1节点划分

这里选择Kafka版本为3.3.1,对应的搭建节点如下:

| 节点IP | 节点名称 | Kafka服务 |

|---|---|---|

| 192.168.179.4 | node1 | kafka broker |

| 192.168.179.5 | node2 | kafka broker |

| 192.168.179.6 | node3 | kafka broker |

3.5.2安装配置Kafka

- 上传解压

[root@node1 software]# tar -zxvf ./kafka_2.12-3.3.1.tgz

- 配置Kafka环境变量

# 在node1节点上编辑profile文件,vim /etc/profile

export KAFKA_HOME=/software/kafka_2.12-3.3.1/

export PATH=$PATH:$KAFKA_HOME/bin

#使环境变量生效

source /etc/profile

- 配置Kafka

在node1节点上配置Kafka,进入$KAFKA_HOME/config中修改server.properties,修改内容如下:

broker.id=0 #注意:这里要唯一的Integer类型

log.dirs=/kafka-logs #真实数据存储的位置

zookeeper.connect=node3:2181,node4:2181,node5:2181 #zookeeper集群

- 将以上配置发送到node2 , node3节点上

[root@node1 software]# scp -r /software/kafka_2.12-3.3.1 node2:/software/

[root@node1 software]# scp -r /software/kafka_2.12-3.3.1 node3:/software/

发送完成后,在node2、node3节点上配置Kafka的环境变量。

- 修改node2,node3 节点上的 server.properties 文件

node2、node3节点修改$KAFKA_HOME/config/server.properties文件中的broker.id,node2中修改为1,node3节点修改为2。

- 创建Kafka启动脚本

在node1,node2,node3节点$KAFKA_HOME/bin路径中编写Kafka启动脚本"startKafka.sh",内容如下:

nohup /software/kafka_2.12-3.3.1/bin/kafka-server-start.sh /software/kafka_2.12-3.3.1/config/server.properties > /software/kafka_2.12-3.3.1/kafkalog.txt 2>&1 &

node1,node2,node3节点配置完成后修改"startKafka.sh"脚本执行权限:

chmod +x ./startKafka.sh

- 启动Kafka集群

在node1,node2,node3三台节点上分别执行startKafka.sh脚本,启动Kafka。

[root@node1 ~]# startKafka.sh

[root@node2 ~]# startKafka.sh

[root@node3 ~]# startKafka.sh

3.5.3Kafka命令操作

在Kafka 任意节点上操作如下命令测试Kafka。

#创建topic

kafka-topics.sh --create --bootstrap-server node1:9092,node2:9092,node3:9092 --topic testtopic --partitions 3 --replication-factor 3

#查看集群中的topic

kafka-topics.sh --list --bootstrap-server node1:9092,node2:9092,node3:9092

#console控制台向topic 中生产数据

kafka-console-producer.sh --bootstrap-server node1:9092,node2:9092,node3:9092 --topic testtopic

#console控制台消费topic中的数据

kafka-console-consumer.sh --bootstrap-server node1:9092,node2:9092,node3:9092 --topic testtopic

注意:以上创建好之后,可以向Kafka topic中写入数据测试Kafka是否正常。

#删除topic

kafka-topics.sh --bootstrap-server node1:9092,node2:9092,node3:9092 --delete --topic testtopic

4第四章 Hadoop Kerberos安全配置

4.1安装libcrypto.so库

当使用Kerberos对Hadoop进行数据安全管理时,需要使用LinuxContainerExecutor,该类型Executor只支持在GNU / Linux操作系统上运行,并且可以提供更好的容器级别的安全性控制,例如通过在容器内运行应用程序的用户和组进行身份验证,此外,LinuxContainerExecutor还可以确保容器内的本地文件和目录仅能被应用程序所有者和NodeManager访问,这可以提高系统的安全性。

使用LinuxContainerExecutor时,会检测本地是否有libcrypto.so.1.1库,可以通过命令"find / -name "libcrypto.so.1.1""来确定该库是否存在,目前这里使用的Centos7系统中默认没有该库,这里需要在node1~node5各个节点上进行安装,安装步骤如下。

- 下载 openssl 源码包进行编译获取 libcrypto.so.1.1 库

在node1节点上下载openssl源码包,进行编译,步骤如下:

#下载openssl源码包,该源码也可以在资料中获取,名为:openssl-1.1.1k.tar.gz

[root@node1 ~]# cd /software && wget https://www.openssl.org/source/openssl-1.1.1k.tar.gz --no-check-certificate

#安装编译源码所需依赖

[root@node1 openssl-1.1.1k]# yum -y install gcc+ gcc-c++ zlib-devel

#解压并编译

[root@node1 software]# tar -zxvf openssl-1.1.1k.tar.gz

[root@node1 software]# cd openssl-1.1.1k

[root@node1 openssl-1.1.1k]# ./config --prefix=/usr/local/openssl --openssldir=/usr/local/openssl shared zlib

[root@node1 openssl-1.1.1k]# make

[root@node1 openssl-1.1.1k]# make install

经过以上步骤已经获取了libcrypto.so.1.1库,位于/software/openssl-1.1.1k目录下。

- 同步openssl 安装包到其他节点

这里同步编译好的openssl安装包到node2~node5节点:

[root@node1 ~]# cd /software/

[root@node1 software]# scp -r openssl-1.1.1k node2:/software/

[root@node1 software]# scp -r openssl-1.1.1k node3:/software/

[root@node1 software]# scp -r openssl-1.1.1k node4:/software/

[root@node1 software]# scp -r openssl-1.1.1k node5:/software/

- 各个节点创建libcrypto.so.1.1 软链接

#在node1~node5节点执行如下命令,创建软链接

ln /software/openssl-1.1.1k/libcrypto.so.1.1 /usr/lib64/libcrypto.so.1.1

4.2创建HDFS服务用户

企业Hadoop中一般由不同的用户来控制不同的服务,这些用户分为hdfs、yarn和mapred用户,多用户的目的是为了实现权限控制和管理,不同的用户只能访问其需要的资源和操作,从而提高整个Hadoop集群的安全性和稳定性。

官方对于以上三种用户、所属组及管理的服务如下:

| User:Group | Daemons |

|---|---|

| hdfs:hadoop | NameNode, Secondary NameNode, JournalNode, DataNode |

| yarn:hadoop | ResourceManager, NodeManager |

| mapred:hadoop | MapReduce JobHistory Server |

按照如下步骤在所有节点上创建以上用户组、用户及设置密码:

- 创建 hadoop 用户组

#node1~node5所有节点执行如下命令,创建hadoop用户组

groupadd hadoop

- 创建用户

#node1~node5所有节点执行如下命令,创建各用户并指定所属hadoop组

useradd hdfs -g hadoop

useradd yarn -g hadoop

useradd mapred -g hadoop

- 设置各个用户密码

#node1~node5所有节点上设置以上用户密码,这里设置为123456

passwd hdfs

passwd yarn

passwd mapred

4.3配置各服务用户两两节点免密

每个用户控制不同服务会涉及到各个节点之间通信,这时需要设置各个用户之间的免密通信,按照如下步骤实现。

- 设置 hdfs 用户两两节点之间免密

#所有节点切换成hdfs用户

su hdfs

cd ~

#node1~node5所有节点生成SSH密钥

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

#node1~node5所有节点公钥复制到node1节点上,这个过程需要输入yes和密码

ssh-copy-id node1

#将node1 authorized_keys文件分发到node1~node5各节点,这个过程需要输入密码

[hdfs@node1 ~]$ cd ~/.ssh/

[hdfs@node1 .ssh]$ scp authorized_keys node2:`pwd`

[hdfs@node1 .ssh]$ scp authorized_keys node3:`pwd`

[hdfs@node1 .ssh]$ scp authorized_keys node4:`pwd`

[hdfs@node1 .ssh]$ scp authorized_keys node5:`pwd`

#两两节点进行ssh测试,这一步骤必须做,然后node1~node5节点退出当前hdfs用户

exit

- 设置 yarn 用户两两节点之间免密

#所有节点切换成yarn用户

su yarn

cd ~

#node1~node5所有节点生成SSH密钥

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

#node1~node5所有节点公钥复制到node1节点上,这个过程需要输入yes和密码

ssh-copy-id node1

#将node1 authorized_keys文件分发到node1~node5各节点,这个过程需要输入密码

[yarn@node1 ~]$ cd ~/.ssh/

[yarn@node1 .ssh]$ scp authorized_keys node2:`pwd`

[yarn@node1 .ssh]$ scp authorized_keys node3:`pwd`

[yarn@node1 .ssh]$ scp authorized_keys node4:`pwd`

[yarn@node1 .ssh]$ scp authorized_keys node5:`pwd`

#两两节点进行ssh测试,这一步骤必须做,然后node1~node5节点退出当前yarn用户

exit

- 设置 mapred 用户两两节点之间免密

#所有节点切换成mapred用户

su mapred

cd ~

#node1~node5所有节点生成SSH密钥

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

#node1~node5所有节点公钥复制到node1节点上,这个过程需要输入yes和密码

ssh-copy-id node1

#将node1 authorized_keys文件分发到node1~node5各节点,这个过程需要输入密码

[mapred@node1 ~]$ cd ~/.ssh/

[mapred@node1 .ssh]$ scp authorized_keys node2:`pwd`

[mapred@node1 .ssh]$ scp authorized_keys node3:`pwd`

[mapred@node1 .ssh]$ scp authorized_keys node4:`pwd`

[mapred@node1 .ssh]$ scp authorized_keys node5:`pwd`

#两两节点进行ssh测试,这一步骤必须做,然后node1~node5节点退出当前mapred用户

exit

4.4修改本地目录权限

Hadoop中不同的用户对不同目录拥有不同权限,下面是Hadoop官方给出的不同Hadoop相关目录对应的权限,这里需要按照该权限进行设置。

| Filesystem | Path | User:Group | Permissions |

|---|---|---|---|

| local | dfs.namenode.name.dir | hdfs:hadoop | drwx------ |

| local | dfs.datanode.data.dir | hdfs:hadoop | drwx------ |

| local | $HADOOP_LOG_DIR | hdfs:hadoop | drwxrwxr-x |

| local | $YARN_LOG_DIR | yarn:hadoop | drwxrwxr-x |

| local | yarn.nodemanager.local-dirs | yarn:hadoop | drwxr-xr-x |

| local | yarn.nodemanager.log-dirs | yarn:hadoop | drwxr-xr-x |

| local | dfs.journalnode.edits.dir | hdfs:hadoop | drwx------ |

对于以上目录的解释如下:

- dfs.namenode.name.dir

该配置项用于指定NameNode的数据存储目录,NameNode将所有的文件、目录和块信息存储在该目录下。该配置项配置在hdfs-site.xml中,默认值为file://${hadoop.tmp.dir}/dfs/name,${hadoop.tmp.dir}配置于core-site.xml中,默认为/opt/data/hadoop。这里我们需要修改/opt/data/hadoop/dfs/name路径的所有者和组为hdfs:hadoop,访问权限为700。

- dfs.datanode.data.dir

该配置项用于指定DataNode的数据存储目录,DataNode将块数据存储在该目录下。在hdfs-site.xml中配置,默认值为file://${hadoop.tmp.dir}/dfs/data,这里我们需要修改/opt/data/hadoop/dfs/data路径的所有者和组为hdfs:hadoop,访问权限为700。

- HADOOP_LOG_DIR与YARN_LOG_DIR

HADOOP_LOG_DIR为Hadoop各组件的日志目录,YARN_LOG_DIR为YARN各组件的日志目录,两者默认日志路径为HADOOP_HOME/logs。这里我们需要修改/software/hadoop-3.3.4/logs/路径的所有者和组为hdfs:hadoop,访问权限为775。

- yarn.nodemanager.local-dirs

该配置指定指定NodeManager的本地工作目录。在yarn-site.xml中配置,默认值为file://${hadoop.tmp.dir}/nm-local-dir。这里我们修改/opt/data/hadoop/nm-local-dir路径的所有者和组为yarn:hadoop,访问权限为755。

- yarn.nodemanager.log-dirs

该配置项指定NodeManager的日志目录。在yarn-site.xml中配置,默认值为 HADOOP_LOG_DIR/userlogs。这里我们修改/software/hadoop-3.3.4/logs/userlogs/路径的所有者和组为yarn:hadoop,访问权限为755。

- dfs.journalnode.edits.dir

该配置项指定JournalNode的edits存储目录。在hdfs-site.xml中配置,默认值为/tmp/hadoop/dfs/journalnode/。这里我们配置的路径为/opt/data/journal/node/local/data,所以这里修改该路径的所有者和组为hdfs:hadoop,访问权限为700。

下面在node1~node5各个节点上执行如下命令进行以上用户和组、权限设置:

#在node1~node2 NameNode节点执行

chown -R hdfs:hadoop /opt/data/hadoop/dfs/name

chmod 700 /opt/data/hadoop/dfs/name

#在node3~node5 DataNode节点执行

chown -R hdfs:hadoop /opt/data/hadoop/dfs/data

chmod 700 /opt/data/hadoop/dfs/data

#在node1~node5所有节点执行

chown hdfs:hadoop /software/hadoop-3.3.4/logs/

chmod 775 /software/hadoop-3.3.4/logs/

#在node3~node5 NodeManager、JournalNode节点执行

chown -R yarn:hadoop /opt/data/hadoop/nm-local-dir

chmod -R 755 /opt/data/hadoop/nm-local-dir

chown yarn:hadoop /software/hadoop-3.3.4/logs/userlogs/

chmod 755 /software/hadoop-3.3.4/logs/userlogs/

chown -R hdfs:hadoop /opt/data/journal/node/local/data

chmod 700 /opt/data/journal/node/local/data

4.5创建各服务Princial主体

Hadoop配置Kerberos安全认证后,为了让Hadoop集群中的服务能够相互通信并在集群中安全地进行数据交换,需要为每个服务实例配置其Kerberos主体,这样,各个服务实例就能够以其Kerberos主体身份进行身份验证,并获得访问Hadoop集群中的数据和资源所需的授权,Hadoop服务主体格式如下:ServiceName/HostName@REAL。

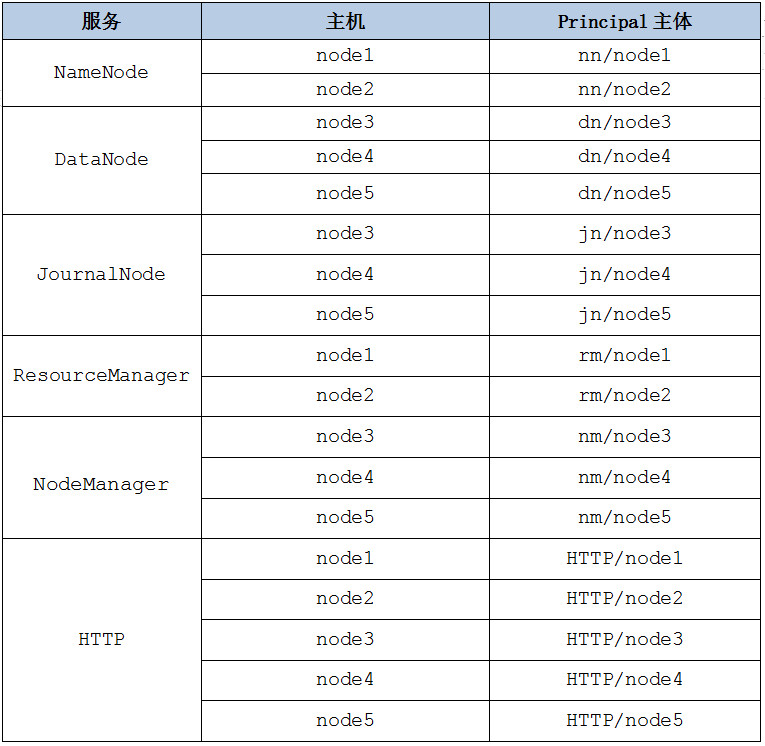

根据Hadoop集群各个节点服务分布,在Hadoop中创建的Kerbreos服务主体如下:

注意:以上HTTP服务主体用于Hadoop的Web控制台向Kerberos验证身份。

按照如下步骤在Kerberos服务端创建各个Hadoop服务主体并指定密码为123456。

#在Kerberos服务端node1节点执行如下命令

kadmin.local -q "addprinc -pw 123456 nn/node1"

kadmin.local -q "addprinc -pw 123456 nn/node2"

kadmin.local -q "addprinc -pw 123456 dn/node3"

kadmin.local -q "addprinc -pw 123456 dn/node4"

kadmin.local -q "addprinc -pw 123456 dn/node5"

kadmin.local -q "addprinc -pw 123456 jn/node3"

kadmin.local -q "addprinc -pw 123456 jn/node4"

kadmin.local -q "addprinc -pw 123456 jn/node5"

kadmin.local -q "addprinc -pw 123456 rm/node1"

kadmin.local -q "addprinc -pw 123456 rm/node2"

kadmin.local -q "addprinc -pw 123456 nm/node3"

kadmin.local -q "addprinc -pw 123456 nm/node4"

kadmin.local -q "addprinc -pw 123456 nm/node5"

kadmin.local -q "addprinc -pw 123456 HTTP/node1"

kadmin.local -q "addprinc -pw 123456 HTTP/node2"

kadmin.local -q "addprinc -pw 123456 HTTP/node3"

kadmin.local -q "addprinc -pw 123456 HTTP/node4"

kadmin.local -q "addprinc -pw 123456 HTTP/node5"

注意:以上命令也可以在客户端执行类似"kadmin -p test/admin -w 123456 -q "addprinc -pw 123456 xx/xx""这种命令来创建Hadoop各服务主体。

创建好Hadoop各服务主体后,可以将这些主体写入不同的Keytab密钥文件,然后将这些文件分发到Hadoop各个节点上,当Hadoop各服务之间通信认证时可以通过keytab密钥文件进行认证,按照如下步骤来完成keytab文件生成以及赋权:

- 创建存储 keytab 文件的路径

在node1~node5所有节点创建keytab文件路径,命令如下:

#node1~node5各节点执行如下命令

mkdir -p /home/keytabs

- 将 Hadoop 服务主体写入到 keytab 文件

在Kerberos服务端node1节点上,执行如下命令将Hadoop各服务主体写入到keytab文件。

#node1 节点执行如下命令

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/nn.service.keytab nn/node1@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/nn.service.keytab nn/node2@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/dn.service.keytab dn/node3@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/dn.service.keytab dn/node4@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/dn.service.keytab dn/node5@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/jn.service.keytab jn/node3@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/jn.service.keytab jn/node4@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/jn.service.keytab jn/node5@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/rm.service.keytab rm/node1@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/rm.service.keytab rm/node2@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/nm.service.keytab nm/node3@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/nm.service.keytab nm/node4@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/nm.service.keytab nm/node5@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/spnego.service.keytab HTTP/node1@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/spnego.service.keytab HTTP/node2@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/spnego.service.keytab HTTP/node3@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/spnego.service.keytab HTTP/node4@EXAMPLE.COM"

kadmin.local -q "ktadd -norandkey -kt /home/keytabs/spnego.service.keytab HTTP/node5@EXAMPLE.COM"

以上命令执行之后,可以在node1节点/home/keytabs路径下看到创建的各个keytab文件。

[root@node1 ~]# ls /home/keytabs/

dn.service.keytab nm.service.keytab rm.service.keytab

jn.service.keytab nn.service.keytab spnego.service.keytab

- 发送 keytab 文件到其他节点

将在node1 kerberos服务端生成的keytab文件发送到Hadoop各个节点。

#node1节点执行如下命令

[root@node1 ~]# scp -r /home/keytabs/* node2:/home/keytabs/

[root@node1 ~]# scp -r /home/keytabs/* node3:/home/keytabs/

[root@node1 ~]# scp -r /home/keytabs/* node4:/home/keytabs/

[root@node1 ~]# scp -r /home/keytabs/* node5:/home/keytabs/

- 修改keytab 文件权限

这里修改各个节点的keytab文件访问权限目的是为了保证hdfs、yarn、mapred各个用户能访问到这些keytab文件。

#node1~node5各节点执行如下命令

chown -R root:hadoop /home/keytabs

chmod 770 /home/keytabs/*

chmod 770 /home/keytabs/

4.6修改Hadoop配置文件

这里分别需要对Hadoop各个节点core-site.xml、hdfs-site.xml、yarn-site.xm配置kerberos安全认证。

4.6.1配置core-site.xml

在node1~node5各个节点上配置core-site.xml,追加如下配置:

<!-- 启用Kerberos安全认证 -->

<property>

<name>hadoop.security.authentication</name>

<value>kerberos</value>

</property>

<!-- 启用Hadoop集群授权管理 -->

<property>

<name>hadoop.security.authorization</name>

<value>true</value>

</property>

<!-- 外部系统用户身份映射到Hadoop用户的机制 -->

<property>

<name>hadoop.security.auth_to_local.mechanism</name>

<value>MIT</value>

</property>

<!-- Kerberos主体到Hadoop用户的具体映射规则 -->

<property>

<name>hadoop.security.auth_to_local</name>

<value>

RULE:[2:$1/$2@$0]([ndj]n\/.*@EXAMPLE\.COM)s/.*/hdfs/

RULE:[2:$1/$2@$0]([rn]m\/.*@EXAMPLE\.COM)s/.*/yarn/

RULE:[2:$1/$2@$0](jhs\/.*@EXAMPLE\.COM)s/.*/mapred/

DEFAULT

</value>

</property>

以上关于 "hadoop.security.auth_to_local"配置项中的value解释如下,规则 RULE:2:$1/$2@$0s/.*/hdfs/ 表示对于 Kerberos 主体中以 nn/、dn/、jn/ 开头的名称,在 EXAMPLE.COM 域中使用正则表达式 .* 进行匹配,将其映射为 Hadoop 中的 hdfs 用户名。其中,$0 表示 Kerberos 主体中的域名部分,$1 和 $2 表示其他两个部分。

4.6.2配置hdfs-site.xml

在node1~node5各个节点上配置core-site.xml,追加如下配置:

<!-- 开启访问DataNode数据块需Kerberos认证 -->

<property>

<name>dfs.block.access.token.enable</name>

<value>true</value>

</property>

<!-- NameNode服务的Kerberos主体 -->

<property>

<name>dfs.namenode.kerberos.principal</name>

<value>nn/_HOST@EXAMPLE.COM</value>

</property>

<!-- NameNode服务的keytab密钥文件路径 -->

<property>

<name>dfs.namenode.keytab.file</name>

<value>/home/keytabs/nn.service.keytab</value>

</property>

<!-- DataNode服务的Kerberos主体 -->

<property>

<name>dfs.datanode.kerberos.principal</name>

<value>dn/_HOST@EXAMPLE.COM</value>

</property>

<!-- DataNode服务的keytab密钥文件路径 -->

<property>

<name>dfs.datanode.keytab.file</name>

<value>/home/keytabs/dn.service.keytab</value>

</property>

<!-- JournalNode服务的Kerberos主体 -->

<property>

<name>dfs.journalnode.kerberos.principal</name>

<value>jn/_HOST@EXAMPLE.COM</value>

</property>

<!-- JournalNode服务的keytab密钥文件路径 -->

<property>

<name>dfs.journalnode.keytab.file</name>

<value>/home/keytabs/jn.service.keytab</value>

</property>

<!-- 配置HDFS支持HTTPS协议 -->

<property>

<name>dfs.http.policy</name>

<value>HTTPS_ONLY</value>

</property>

<!-- 配置DataNode数据传输保护策略为仅认证模式 -->

<property>

<name>dfs.data.transfer.protection</name>

<value>authentication</value>

</property>

<!-- HDFS WebUI服务认证主体 -->

<property>

<name>dfs.web.authentication.kerberos.principal</name>

<value>HTTP/_HOST@EXAMPLE.COM</value>

</property>

<!-- HDFS WebUI服务keytab密钥文件路径 -->

<property>

<name>dfs.web.authentication.kerberos.keytab</name>

<value>/home/keytabs/spnego.service.keytab</value>

</property>

<!-- NameNode WebUI 服务认证主体 -->

<property>

<name>dfs.namenode.kerberos.internal.spnego.principal</name>

<value>HTTP/_HOST@EXAMPLE.COM</value>

</property>

<!-- JournalNode WebUI 服务认证主体 -->

<property>

<name>dfs.journalnode.kerberos.internal.spnego.principal</name>

<value>HTTP/_HOST@EXAMPLE.COM</value>

</property>

注意:以上配置中"_HOST" 将被替换为运行 Web 服务的实际主机名。

此外,还需要修改hdfs-site.xml中如下属性为hdfs用户下的rsa私钥文件,否则在节点之间HA切换时不能正常切换。

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/home/hdfs/.ssh/id_rsa</value>

</property>

4.6.3配置Yarn-site.xml

在node1~node5各个节点上配置yarn-site.xml,追加如下配置:

<!-- ResourceManager 服务主体 -->

<property>

<name>yarn.resourcemanager.principal</name>

<value>rm/_HOST@EXAMPLE.COM</value>

</property>

<!-- ResourceManager 服务keytab密钥文件 -->

<property>

<name>yarn.resourcemanager.keytab</name>

<value>/home/keytabs/rm.service.keytab</value>

</property>

<!-- NodeManager 服务主体-->

<property>

<name>yarn.nodemanager.principal</name>

<value>nm/_HOST@EXAMPLE.COM</value>

</property>

<!-- NodeManager 服务keytab密钥文件 -->

<property>

<name>yarn.nodemanager.keytab</name>

<value>/home/keytabs/nm.service.keytab</value>

</property>

4.7配置Hadoop Https访问

HTTP的全称是Hypertext Transfer Protocol Vertion (超文本传输协议),HTTPS的全称是Secure Hypertext Transfer Protocol(安全超文本传输协议),HTTPS基于HTTP开发,使用安全套接字层(SSL)进行信息交换,简单来说它是HTTP的安全版,HTTPS = HTTP+SSL。

SSL(Secure Sockets Layer)是一种加密通信协议,它使用公钥加密和私钥解密的方式来确保数据传输的安全性。Hadoop配置Kerberos对Hadoop访问进行认证时,官方建议对Hadoop采用HTTPS访问方式保证数据安全传输,防止在数据传输过程中被窃听、篡改或伪造等攻击,提高数据的保密性、完整性和可靠性。按照如下步骤对Hadoop设置HTTPS访问。

- 生成私钥和证书文件

在node1节点执行如下命令生成私钥和证书文件:

#执行如下命令需要输入密码,这里设置密码为123456

[root@node1 ~]# openssl req -new -x509 -keyout /root/hdfs_ca_key -out /root/hdfs_ca_cert -days 36500 -subj '/C=CN/ST=beijing/L=haidian/O=devA/OU=devB/CN=devC'

以上命令使用 OpenSSL 工具生成一个自签名的 X.509 证书,执行完成后,会在/root目录下生成私钥文件hdfs_ca_key和证书文件hdfs_ca_cert。

- 将证书文件和私钥文件发送到其他节点

这里将证书文件和私钥文件发送到node2~node5节点上,后续各节点需要基于两个文件生成SSL认证文件。

[root@node1 ~]# scp ./hdfs_ca_cert ./hdfs_ca_key node2:/root/

[root@node1 ~]# scp ./hdfs_ca_cert ./hdfs_ca_key node3:/root/

[root@node1 ~]# scp ./hdfs_ca_cert ./hdfs_ca_key node4:/root/

[root@node1 ~]# scp ./hdfs_ca_cert ./hdfs_ca_key node5:/root/

- 生成 keystore 文件

keystore文件存储了SSL握手所涉及的私钥以及证书链信息,在node1~node5各节点执行如下命令,各个节点对应--alise不同且CN不同, 这里的 CN 虽说是组织名随意取名,但是在后续配置中建议配置为各节点的 hostname ,这样不会出现验证出错。

[root@node1 ~]# keytool -keystore /root/keystore -alias node1 -genkey -keyalg RSA -dname "CN=node1, OU=dev, O=dev, L=dev, ST=dev, C=CN"

[root@node2 ~]# keytool -keystore /root/keystore -alias node2 -genkey -keyalg RSA -dname "CN=node2, OU=dev, O=dev, L=dev, ST=dev, C=CN"

[root@node3 ~]# keytool -keystore /root/keystore -alias node3 -genkey -keyalg RSA -dname "CN=node3, OU=dev, O=dev, L=dev, ST=dev, C=CN"

[root@node4 ~]# keytool -keystore /root/keystore -alias node4 -genkey -keyalg RSA -dname "CN=node4, OU=dev, O=dev, L=dev, ST=dev, C=CN"

[root@node5 ~]# keytool -keystore /root/keystore -alias node5 -genkey -keyalg RSA -dname "CN=node5, OU=dev, O=dev, L=dev, ST=dev, C=CN"

以上命令执行时需要密钥库口令,这里设置为123456,执行完成后会在/root目录下产生keystore文件。关于该命令每个选项和参数解释如下:

- keytool:Java密钥和证书管理工具的命令行实用程序。

- -keystore /home/keystore:指定密钥库的位置和名称,这里为"/home/keystore"。

- -alias jetty:指定别名,这里为各节点hostname,用于标识存储在密钥库中的密钥对。

- -genkey:指定将生成新密钥对的操作。

- -keyalg RSA:指定密钥算法,这里为RSA。

- -dname "CN=dev1, OU=dev2, O=dev3, L=dev4, ST=dev5, C=CN":指定用于生成证书请求的"主题可分辨名称",包含以下信息:

- CN(Common Name):指定通用名称,这里建议配置为各hostname。

- OU(Organizational Unit):指定组织单位。

- O(Organization):指定组织名称。

- L(Locality):指定所在城市或地点。

- ST(State or Province):指定所在省份或州。

- C(Country):指定所在国家或地区,这里为"CN"(中国)。

- 生成 truststore 文件

truststore文件存储了可信任的根证书,用于验证服务器证书链中的证书是否可信,在node1~node5各个节点执行如下命令生成truststore文件。

keytool -keystore /root/truststore -alias CARoot -import -file /root/hdfs_ca_cert

以上命令使用 Java 工具 keytool 将之前生成的自签名 CA 证书 hdfs_ca_cert 导入到指定的 truststore 文件中,并将其命名为 CARoot。命令执行后会在各个节点/root目录下生成truststore文件。

- 从 keystore 中导出 cert

在各个节点上执行命令,从对应的keystore文件中提取证书请求并保存在cert文件中。

#各节点-alias不同,需要输入口令,这里设置为123456

[root@node1 ~]# keytool -certreq -alias node1 -keystore /root/keystore -file /root/cert

[root@node2 ~]# keytool -certreq -alias node2 -keystore /root/keystore -file /root/cert

[root@node3 ~]# keytool -certreq -alias node3 -keystore /root/keystore -file /root/cert

[root@node4 ~]# keytool -certreq -alias node4 -keystore /root/keystore -file /root/cert

[root@node5 ~]# keytool -certreq -alias node5 -keystore /root/keystore -file /root/cert

注意:--alias 需要与各节点生成keystore指定的别名一致。命令执行后,在各个节点上会生成/root/cert文件。

- 生成自签名证书

这里使用最开始生成的hdfs_ca_cert证书文件和hdfs_ca_key密钥文件对cert进行签名,生成自签名证书。在node1~node5各节点执行如下命令,命令执行后会在/root下生成cert_signed文件。

#执行如下命令需要输入CA证书文件口令,默认123456

openssl x509 -req -CA /root/hdfs_ca_cert -CAkey /root/hdfs_ca_key -in /root/cert -out /root/cert_signed -days 36500 -CAcreateserial

- 将 CA 证书导入到 keystore

在node1~node5各个节点上执行如下命令,将之前生成的hdfs_ca_cert证书文件导入到keystore中。

#执行如下命令,需要输入keystore口令,默认123456

keytool -keystore /root/keystore -alias CARoot -import -file /root/hdfs_ca_cert

- 将自签名证书导入到 keystore

在node1~node5各个节点上执行如下命令,将生成的cert_signed自签名证书导入到keystore中。

#各个节点 alias不同。执行如下命令,需要输入keystore口令,默认123456

[root@node1 ~]# keytool -keystore /root/keystore -alias node1 -import -file /root/cert_signed

[root@node2 ~]# keytool -keystore /root/keystore -alias node2 -import -file /root/cert_signed

[root@node3 ~]# keytool -keystore /root/keystore -alias node3 -import -file /root/cert_signed

[root@node4 ~]# keytool -keystore /root/keystore -alias node4 -import -file /root/cert_signed

[root@node5 ~]# keytool -keystore /root/keystore -alias node5 -import -file /root/cert_signed

- 将 keystore 和 trustores 存入 /home 目录

将目前在/root目录下生成的keystore和trustores文件复制到/home目录下,并修改访问权限。

#在node1~node5所有节点执行如下命令

cp keystore truststore /home/

chown -R root:hadoop /home/keystore

chown -R root:hadoop /home/truststore

chmod 770 /home/keystore

chmod 770 /home/truststore

- 配置 ssl-server.xml 文件

ssl-server.xml位于HADOOP_HOME/etc/hadoop/目录下,包含了Hadoop服务器端(如NameNode和DataNode)用于配置SSL/TLS连接的参数。在node1~node5所有节点中都需要配置ssl-server.xml文件。

#node1~node5所有节点执行

cd /software/hadoop-3.3.4/etc/hadoop/

mv ssl-server.xml.example ssl-server.xml

#配置的ssl-server.xml文件内容如下:

<configuration>

<property>

<name>ssl.server.truststore.location</name>

<value>/home/truststore</value>

<description>Truststore to be used by NN and DN. Must be specified.

</description>

</property>

<property>

<name>ssl.server.truststore.password</name>

<value>123456</value>

<description>Optional. Default value is "".

</description>

</property>

<property>

<name>ssl.server.truststore.type</name>

<value>jks</value>

<description>Optional. The keystore file format, default value is "jks".

</description>

</property>

<property>

<name>ssl.server.truststore.reload.interval</name>

<value>10000</value>

<description>Truststore reload check interval, in milliseconds.

Default value is 10000 (10 seconds).

</description>

</property>

<property>

<name>ssl.server.keystore.location</name>

<value>/home/keystore</value>

<description>Keystore to be used by NN and DN. Must be specified.

</description>

</property>

<property>

<name>ssl.server.keystore.password</name>

<value>123456</value>

<description>Must be specified.

</description>

</property>

<property>

<name>ssl.server.keystore.keypassword</name>

<value>123456</value>

<description>Must be specified.

</description>

</property>

<property>

<name>ssl.server.keystore.type</name>

<value>jks</value>

<description>Optional. The keystore file format, default value is "jks".

</description>

</property>

<property>

<name>ssl.server.exclude.cipher.list</name>

<value>TLS_ECDHE_RSA_WITH_RC4_128_SHA,SSL_DHE_RSA_EXPORT_WITH_DES40_CBC_SHA,

SSL_RSA_WITH_DES_CBC_SHA,SSL_DHE_RSA_WITH_DES_CBC_SHA,

SSL_RSA_EXPORT_WITH_RC4_40_MD5,SSL_RSA_EXPORT_WITH_DES40_CBC_SHA,

SSL_RSA_WITH_RC4_128_MD5</value>

<description>Optional. The weak security cipher suites that you want excluded

from SSL communication.</description>

</property>

</configuration>

- 配置ssl-client.xml 文件

ssl-client.xml位于HADOOP_HOME/etc/hadoop/目录下,包含了Hadoop客户端端(如HDFS客户端和YARN客户端)用于配置SSL/TLS连接的参数。在node1~node5所有节点中都需要配置ssl-client.xml文件。

#node1~node5所有节点执行

cd /software/hadoop-3.3.4/etc/hadoop/

mv ssl-client.xml.example ssl-client.xml

#配置的ssl-client.xml文件内容如下:

<configuration>

<property>

<name>ssl.client.truststore.location</name>

<value>/home/truststore</value>

<description>Truststore to be used by clients like distcp. Must be

specified.

</description>

</property>

<property>

<name>ssl.client.truststore.password</name>

<value>123456</value>

<description>Optional. Default value is "".

</description>

</property>

<property>

<name>ssl.client.truststore.type</name>

<value>jks</value>

<description>Optional. The keystore file format, default value is "jks".

</description>

</property>

<property>

<name>ssl.client.truststore.reload.interval</name>

<value>10000</value>

<description>Truststore reload check interval, in milliseconds.

Default value is 10000 (10 seconds).

</description>

</property>

<property>

<name>ssl.client.keystore.location</name>

<value>/home/keystore</value>

<description>Keystore to be used by clients like distcp. Must be

specified.

</description>

</property>

<property>

<name>ssl.client.keystore.password</name>

<value>123456</value>

<description>Optional. Default value is "".

</description>

</property>

<property>

<name>ssl.client.keystore.keypassword</name>

<value>123456</value>

<description>Optional. Default value is "".

</description>

</property>

<property>

<name>ssl.client.keystore.type</name>

<value>jks</value>

<description>Optional. The keystore file format, default value is "jks".

</description>

</property>

</configuration>

注意:以上ssl-server.xml和ssl-client.xml也可以先在node1节点配置完成后,然后分发到node2~node5节点:

[root@node1 hadoop]# scp ./ssl-server.xml ./ssl-client.xml node2:`pwd`

[root@node1 hadoop]# scp ./ssl-server.xml ./ssl-client.xml node3:`pwd`

[root@node1 hadoop]# scp ./ssl-server.xml ./ssl-client.xml node4:`pwd`

[root@node1 hadoop]# scp ./ssl-server.xml ./ssl-client.xml node5:`pwd`

4.8Yarn配置LCE

LinuxContainerExecutor(LCE)是Hadoop用于管理容器的一种执行器,它可以创建、启动和停止应用程序容器,并且能够隔离和限制容器内的资源使用,例如内存、CPU、网络和磁盘等资源。在使用Kerberos进行身份验证和安全通信时,需要使用LCE作为容器的执行器。可以按照如下步骤进行配置。

- 修改 container-executor 所有者和权限

container-executor位于HADOOP_HOME/bin目录中,该文件是LinuxContainerExecutor的可执行脚本文件,该文件所有者和权限如下:

#node1~node5所有节点执行

chown root:hadoop /software/hadoop-3.3.4/bin/container-executor

chmod 6050 /software/hadoop-3.3.4/bin/container-executor

- 配置 container-executor.cfg 文件

container-executor.cfg文件位于HADOOP_HOME/etc/hadoop/中,该文件是Hadoop中LinuxContainerExecutor(LCE)使用的配置文件,它定义了LCE如何运行容器,以及如何设置容器的用户和组映射。

在node1~node5所有节点上修改HADOOP_HOME/etc/hadoop/container-executor.cfg文件配置,内容如下:

#在node1~node5所有节点配置container-executor.cfg

#vim /software/hadoop-3.3.4/etc/hadoop/container-executor.cfg

yarn.nodemanager.linux-container-executor.group=hadoop

banned.users=hdfs,yarn,mapred

min.user.id=1000

allowed.system.users=foo,bar

feature.tc.enabled=false

- 修改 container-executor.cfg 所有者和权限

container-executor.cfg文件所有者和权限设置如下:

#node1~node5所有节点执行

chown root:hadoop /software/hadoop-3.3.4/etc/hadoop/container-executor.cfg

chown root:hadoop /software/hadoop-3.3.4/etc/hadoop

chown root:hadoop /software/hadoop-3.3.4/etc

chown root:hadoop /software/hadoop-3.3.4

chown root:hadoop /software

chmod 400 /software/hadoop-3.3.4/etc/hadoop/container-executor.cfg

- 配置 yarn-site.xml

需要在hadoop各个节点上配置yarn-site.xml配置文件,指定使用LinuxContainerExecutor。这里在node1~node5各个节点上向yarn-site.xml追加如下内容。

#在node1~node5所有节点向yarn-site.xml中追加如下内容

#vim /software/hadoop-3.3.4/etc/hadoop/yarn-site.xml

<!-- 配置NodeManager使用LinuxContainerExecutor管理Container -->

<property>

<name>yarn.nodemanager.container-executor.class</name>

<value>org.apache.hadoop.yarn.server.nodemanager.LinuxContainerExecutor</value>

</property>

<!-- 配置NodeManager的启动用户的所属组 -->

<property>

<name>yarn.nodemanager.linux-container-executor.group</name>

<value>hadoop</value>

</property>

<!-- LinuxContainerExecutor脚本路径 -->

<property>

<name>yarn.nodemanager.linux-container-executor.path</name>

<value>/software/hadoop-3.3.4/bin/container-executor</value>

</property>

4.9启动安全认证的Hadoop集群

这里首先需要配置HADOOP_HOME/sbin/目录中的start-dfs.sh、stop-dfs.sh、start-yarn.sh、stop-yarn.sh启动脚本中不同服务对应用户信息。配置如下:

- 配置 dfs 启停脚本

在node1节点上配置start-dfs.sh && stop-dfs.sh,两文件中修改如下配置:

# 在两个文件中加入如下配置

HDFS_DATANODE_USER=hdfs

HDFS_DATANODE_SECURE_USER=hdfs

HDFS_NAMENODE_USER=hdfs

HDFS_JOURNALNODE_USER=hdfs

HDFS_ZKFC_USER=hdfs

- 配置 yarn 启停脚本

在node1 节点上配置start-yarn.sh && stop-yarn.sh,两文件中修改如下配置:

#在两个文件中加入如下配置

YARN_RESOURCEMANAGER_USER=yarn

YARN_NODEMANAGER_USER=yarn

- 分发到所有 hadoop 节点

将以上配置文件分发到node2~node5所有节点上。

#node1节点执行,分发到其他节点

[root@node1 ~]# cd /software/hadoop-3.3.4/sbin/

[root@node1 sbin]# scp ./start-dfs.sh stop-dfs.sh start-yarn.sh stop-yarn.sh node2:`pwd`

[root@node1 sbin]# scp ./start-dfs.sh stop-dfs.sh start-yarn.sh stop-yarn.sh node3:`pwd`

[root@node1 sbin]# scp ./start-dfs.sh stop-dfs.sh start-yarn.sh stop-yarn.sh node4:`pwd`

[root@node1 sbin]# scp ./start-dfs.sh stop-dfs.sh start-yarn.sh stop-yarn.sh node5:`pwd`

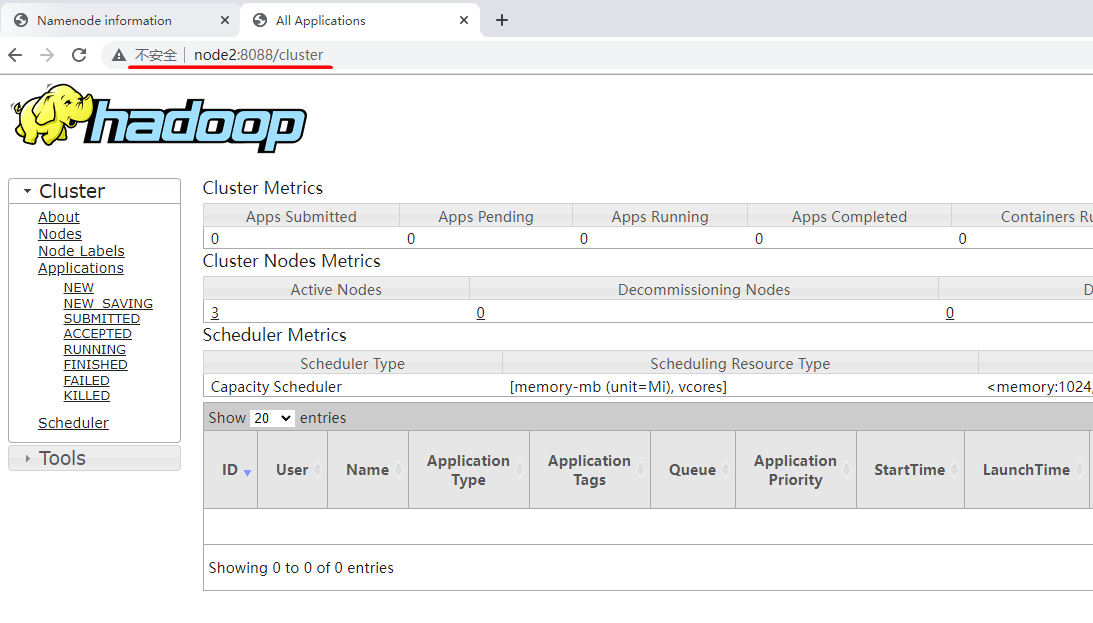

以上配置完成后,在node1节点启动Kerberos认证的HDFS集群,命令如下:

#在node1节点执行如下命令启动Hadoop集群

[root@node1 ~]# start-dfs.sh

[root@node1 ~]# start-yarn.sh

注意启动HDFS后,由于开启的SSL配置,HDFS默认的WEBUI访问端口为9871。HDFS访问URL为https://node1:9871,Yarn访问URL为https://node1:8088。

4.10修改HDFS路径访问权限

Hadoop启动后,不同的用户对于HDFS中的目录访问权限不同,以下是官方建议的HDFS目录访问用户、组、权限。启动HDFS后按照如下权限进行设置。

| Filesystem | Path | User:Group | Permissions |

|---|---|---|---|

| hdfs | / | hdfs:hadoop | drwxr-xr-x |

| hdfs | /tmp | hdfs:hadoop | drwxrwxrwxt |

| hdfs | /user | hdfs:hadoop | drwxr-xr-x |

| hdfs | yarn.nodemanager.remote-app-log-dir | yarn:hadoop | drwxrwxrwxt |

| hdfs | mapreduce.jobhistory.intermediate-done-dir | mapred:hadoop | drwxrwxrwxt |

| hdfs | mapreduce.jobhistory.done-dir | mapred:hadoop | drwxr-x--- |

- yarn.nodemanager.remote-app-log-dir

该参数指定NodeManager在HDFS上存储应用程序日志的目录,在yarn-site.xml中配置,默认是/tmp/logs,目前在HDFS中没有该目录,需要先创建,然后进行用户及组、访问权限设置。

- mapreduce.jobhistory.intermediate-done-dir

该参数指定JobHistory Server在任务完成后将中间数据保存到的目录,在mapred-site.xml中配置,默认为/tmp/hadoop-yarn/staging/history/done_intermediate,目前在HDFS中没有该目录,需要先创建,然后进行用户及组、访问权限设置。

- mapreduce.jobhistory.done-dir

该参数指定JobHistory Server在任务完成后将最终结果保存到的目录,在mapred-site.xml中配置,默认为/tmp/hadoop-yarn/staging/history/done,该目录不存在,需要先创建,然后进行用户及组、访问权限设置。

下面对以上HDFS中的目录进行用户组和权限设置。

- 创建 hdfs Principal 用户主体

创建hdfs用户主体进行目录权限设置。

#在node1 kerberos 服务节点执行

[root@node1 ~]# kadmin.local -q "addprinc -pw 123456 hdfs"

#在node1~node5任意一节点进行认证hdfs用户主体,这里在node1节点认证

[root@node1 ~]# kinit hdfs

Password for hdfs@EXAMPLE.COM: 123456

#查看认证结果

[root@node1 ~]# klist

Ticket cache: FILE:/tmp/krb5cc_0

Default principal: hdfs@EXAMPLE.COM

Valid starting Expires Service principal

2023-05-13T18:30:00 2023-05-14T18:30:00 krbtgt/EXAMPLE.COM@EXAMPLE.COM

- 登录 HDFS 创建缺失目录

#在node1登录hdfs创建目录

[root@node1 ~]# hdfs dfs -mkdir /tmp

[root@node1 ~]# hdfs dfs -mkdir /user

[root@node1 ~]# hdfs dfs -mkdir /tmp/logs

[root@node1 ~]# hdfs dfs -mkdir -p /tmp/hadoop-yarn/staging/history/done_intermediate

[root@node1 ~]# hdfs dfs -mkdir -p /tmp/hadoop-yarn/staging/history/done

- 设置对应目录用户、所属组及权限

#在node1登录hdfs,设置HDFS对应目录权限

[root@node1 ~]# hadoop fs -chown hdfs:hadoop / /tmp /user

[root@node1 ~]# hadoop fs -chmod 755 /

[root@node1 ~]# hadoop fs -chmod 777 /tmp

[root@node1 ~]# hadoop fs -chmod 755 /user

[root@node1 ~]# hadoop fs -chown yarn:hadoop /tmp/logs

[root@node1 ~]# hadoop fs -chmod 777 /tmp/logs

[root@node1 ~]# hadoop fs -chown mapred:hadoop /tmp/hadoop-yarn/staging/history/done_intermediate

[root@node1 ~]# hadoop fs -chmod 777 /tmp/hadoop-yarn/staging/history/done_intermediate

[root@node1 ~]# hadoop fs -chown mapred:hadoop /tmp/hadoop-yarn/staging/history/

[root@node1 ~]# hadoop fs -chown mapred:hadoop /tmp/hadoop-yarn/staging/

[root@node1 ~]# hadoop fs -chown mapred:hadoop /tmp/hadoop-yarn/

[root@node1 ~]# hadoop fs -chmod 770 /tmp/hadoop-yarn/staging/history/

[root@node1 ~]# hadoop fs -chmod 770 /tmp/hadoop-yarn/staging/

[root@node1 ~]# hadoop fs -chmod 770 /tmp/hadoop-yarn/

[root@node1 ~]# hadoop fs -chown mapred:hadoop /tmp/hadoop-yarn/staging/history/done

[root@node1 ~]# hadoop fs -chmod 777 /tmp/hadoop-yarn/staging/history/done

5第五章 访问Kerberos安全认证Hadoop

5.1Shell访问HDFS

这里以普通用户访问Kerberos安全认证的HDFS为例来演示普通用户访问HDFS及提交MR任务。

- 创建 zhangsan 用户及设置组

在node1~node5所有节点创建zhangsan普通用户并设置密码,将zhangsan加入到hadoop组。

#node1~node5所有节点执行,设置用户密码为123456

useradd zhangsan -g hadoop

passwd zhangsan

目前登录zhangsan用户后,没有权限操作HDFS。

- 创建用户主体

在node1节点上创建执行如下命令,创建用户主体。

#node1 kerberos服务端执行

[root@node1 ~]# kadmin.local -q"addprinc -pw 123456 zhangsan"

- 操作 HDFS

可以在node1~node5任意节点认证zhangsan用户主体,这里选择在node5节点认证,并操作HDFS。

#在node1~node5任意节点认证zhangsan用户主体,这里选择在node5节点认证。

[root@node5 ~]# su zhangsan

[zhangsan@node5 ~]$

[zhangsan@node5 ~]# kinit zhangsan

Password for zhangsan@EXAMPLE.COM: 123456

#查看认证的用户主体

[zhangsan@node5 ~]# klist