3. 注意力机制

深度学习中的注意力机制(Attention Mechanism)是一种模仿人类视觉和认知系统的方法,它允许神经网络在处理输入数据时集中注意力于相关的部分。通过引入注意力机制,神经网络能够自动地学习并选择性地关注输入中的重要信息,提高模型的性能和泛化能力。

最典型的注意力机制包括自注意力机制、空间注意力机制和时间注意力机制

1. 自注意力机制

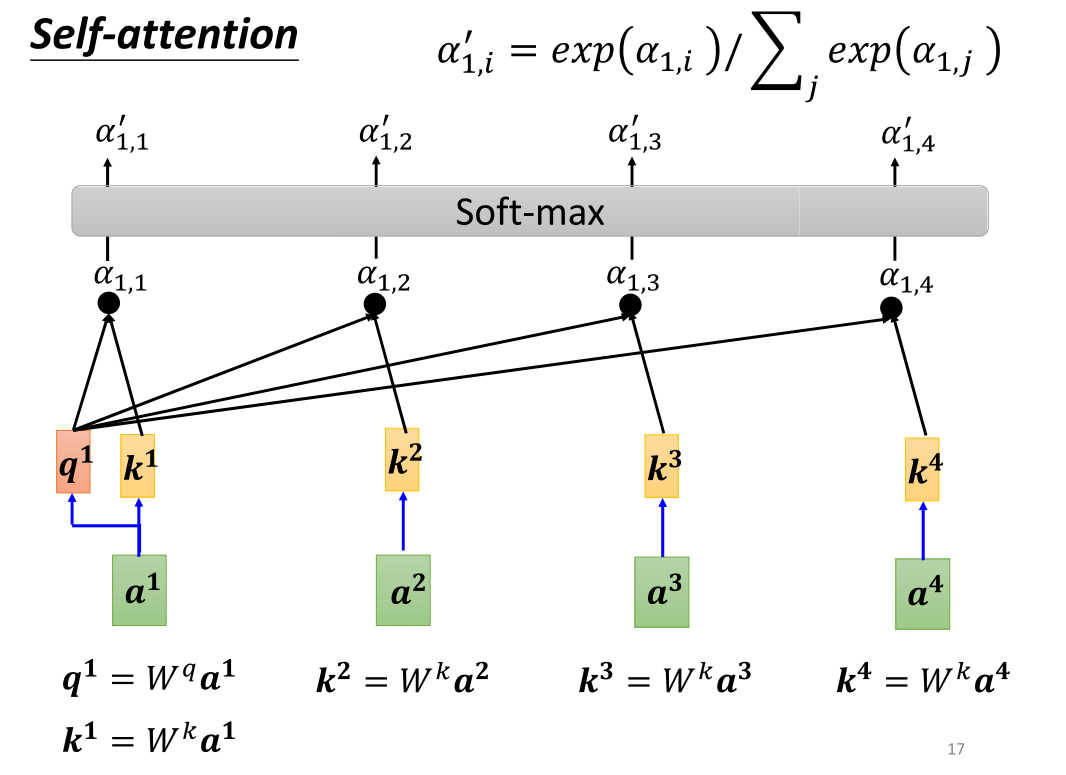

具体而言,对于序列中的每个元素,自注意力机制计算其与其他元素之间的相似度,并将这些相似度归一化为注意力权重。然后,通过将每个元素与对应的注意力权重进行加权求和,可以得到自注意力机制的输出。

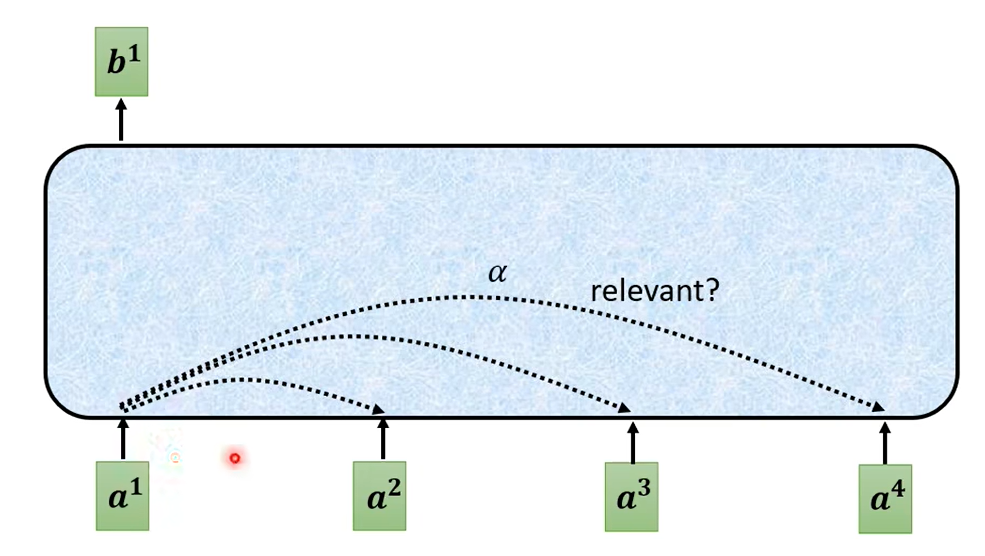

输入整个语句的向量到self-attention中,输出对应个数的向量,再将其结果输入到全连接网络,最后输出标签。以上过程可多次重复:

1.1 运行原理

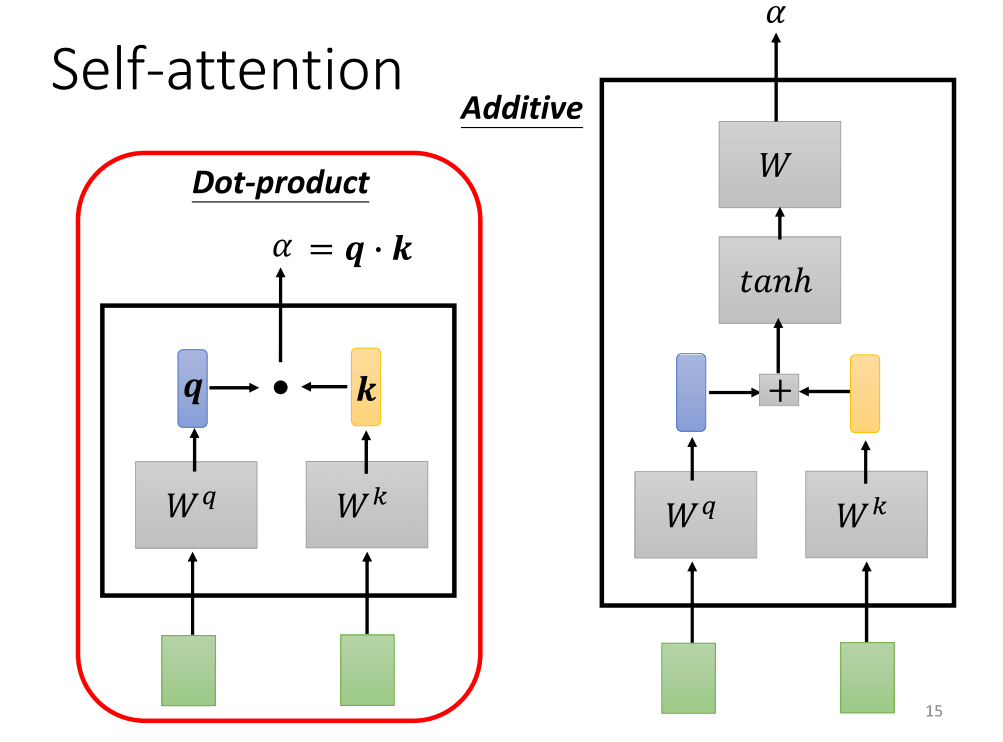

使用表示每一个向量之间的关联程度,而也有许多方法产生,例如下图中的两个

上图左边的方法是最常用的,左乘矩阵再进行dot得到,这也是transformer使用的方法

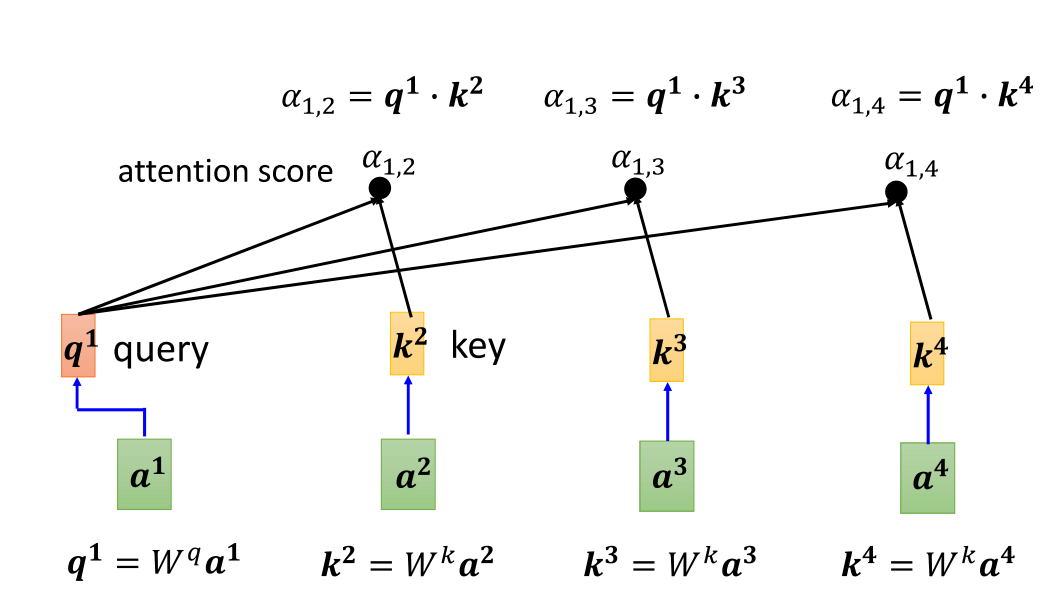

分别计算关联性可以得到

谁的分数更大,谁的v就更影响结果

1.2 总结

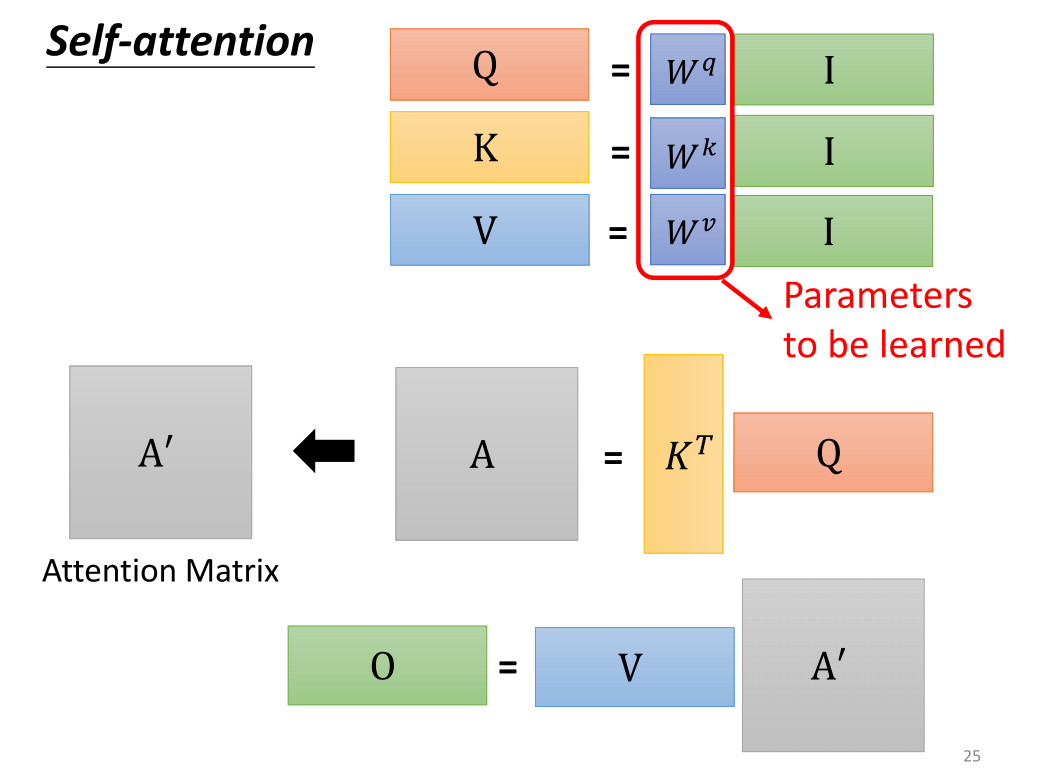

上述过程可总结为

- 输入矩阵分别乘以三个得到三个矩阵 。

- ,经过处理得到注意力矩阵

- 输出

即

其中, 为向量的长度。

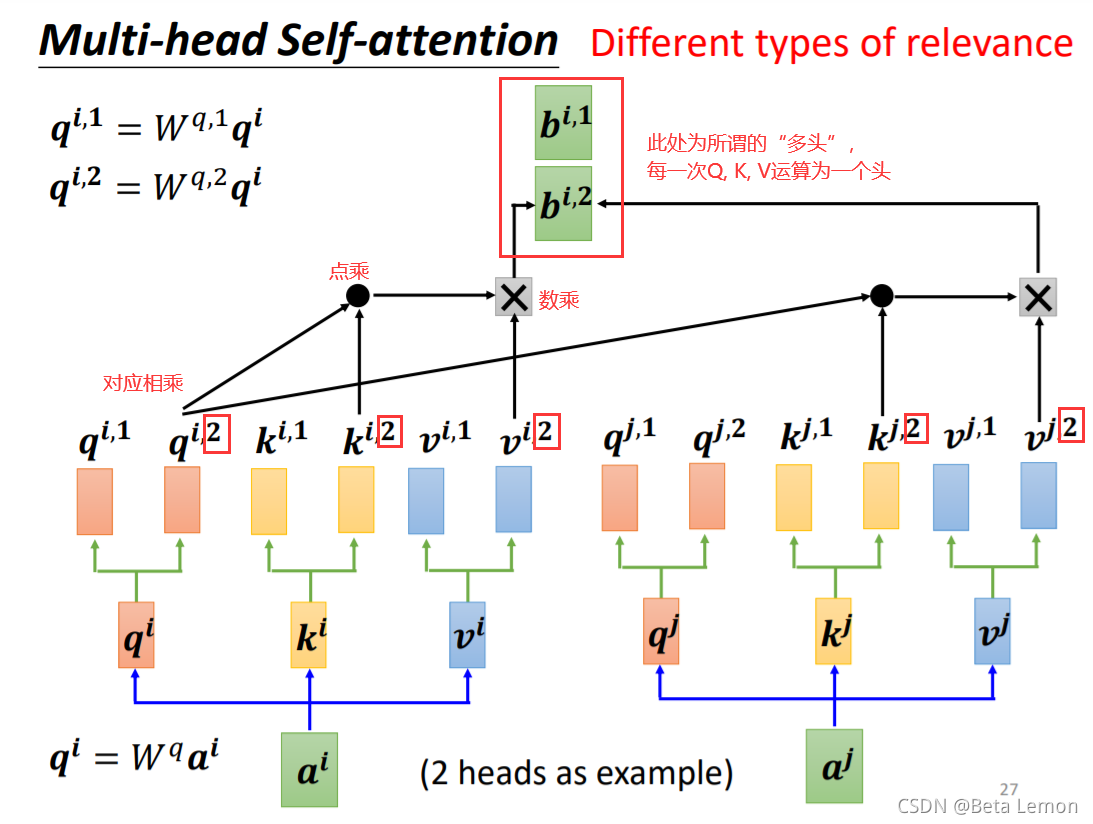

2. 多头注意力机制

多头注意力机制则是在乘以一个后,会再分配多个 ,这里以2个为例,如下图所示;

参考:

本文作者:乐池

本文链接:https://www.cnblogs.com/ratillase/p/18083806

版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 2.5 中国大陆许可协议进行许可。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步