2018顺丰视觉岗笔试几个知识点

1. K-means算法的基本步骤,K-means算法和EM的联系与区别,为什么会陷入局部最优解?:EM算法(期望最大化)——从EM算法角度理解K-Means与GMM的区别

2.对于特征工程,样本不平衡,缺乏数据,冷启动都是实际工程容易遇到的

连续数据经常采用离散化处理之后再放入模型。离散化可以理解为提取特征的过程,比如在LR模型,由于是广义线性模型表达能力有限,因此通过特征离散化来了提高非线性学习能力

大致有两类方法:

1. 卡方检验方法:(统计样本的实际观测值与理论推断值之间的偏离程度,卡方值越大,越不符合;卡方值越小,偏差越小,越趋于符合)

- 分裂方法:找到一个分裂点看,左右2个区间,在目标值上分布是否有- 显著差异,有显著差异就分裂,否则就忽略。这个点可以每次找差异最大的点

- 合并方法:先划分如果很小单元区间,按顺序合并在目标值上分布不显著的相邻区间,直到收敛

2. 信息增益方法:

- 分裂方法:找到一个分裂点看,左右2个区间,看分裂前后信息增益变化阈值,如果差值超过阈值(正值,分列前-分裂后信息熵),则分裂。每次找差值最大的点做分裂点,直到收敛

- 合并方法:先划分 如果很小单元区间,按顺序合并信息增益小于阈值的相邻区间,直到收敛

特征工程整理流程和涉及技术点

对于样本不均衡问题:主要通过欠采样,过采样,阈值移动(优化代价函数)三种方法解决,但是数据分布不一定起决定作用,主要还是要分析特征,找到能够区分正负样本的特征,去掉冗余,正负样本重合的特征,找到有效特征,去掉无效特征。

在分类中如何处理训练集中不平衡问题

3. 最大熵和最大似然等价,说明什么:机器学习之从极大似然估计到最大熵原理以及EM算法详解

5.缺值处理,冷启动问题: 推荐系统冷启动问题

5. 过拟合,欠拟合

欠拟合解决方法:

1)添加其他特征项,有时候我们模型出现欠拟合的时候是因为特征项不够导致的,可以添加其他特征项来很好地解决。例如,“组合”、“泛化”、“相关性”三类特征是特征添加的重要手段,无论在什么场景,都可以照葫芦画瓢,总会得到意想不到的效果。除上面的特征之外,“上下文特征”、“平台特征”等等,都可以作为特征添加的首选项。

2)添加多项式特征,这个在机器学习算法里面用的很普遍,例如将线性模型通过添加二次项或者三次项使模型泛化能力更强。例如上面的图片的例子。

3)减少正则化参数,正则化的目的是用来防止过拟合的,但是现在模型出现了欠拟合,则需要减少正则化参数。

过拟合解决方法:

1)重新清洗数据,导致过拟合的一个原因也有可能是数据不纯导致的,如果出现了过拟合就需要我们重新清洗数据。

2)增大数据的训练量,还有一个原因就是我们用于训练的数据量太小导致的,训练数据占总数据的比例过小。

3)采用正则化方法。正则化方法包括L0正则、L1正则和L2正则,而正则一般是在目标函数之后加上对于的范数。但是在机器学习中一般使用L2正则,下面看具体的原因。

L0范数是指向量中非0的元素的个数。L1范数是指向量中各个元素绝对值之和,也叫“稀疏规则算子”(Lasso regularization)。两者都可以实现稀疏性,既然L0可以实现稀疏,为什么不用L0,而要用L1呢?个人理解一是因为L0范数很难优化求解(NP难问题),二是L1范数是L0范数的最优凸近似,而且它比L0范数要容易优化求解。所以大家才把目光和万千宠爱转于L1范数。

L2范数是指向量各元素的平方和然后求平方根。可以使得W的每个元素都很小,都接近于0,但与L1范数不同,它不会让它等于0,而是接近于0。L2正则项起到使得参数w变小加剧的效果,但是为什么可以防止过拟合呢?一个通俗的理解便是:更小的参数值w意味着模型的复杂度更低,对训练数据的拟合刚刚好(奥卡姆剃刀),不会过分拟合训练数据,从而使得不会过拟合,以提高模型的泛化能力。还有就是看到有人说L2范数有助于处理 condition number不好的情况下矩阵求逆很困难的问题(具体这儿我也不是太理解)。

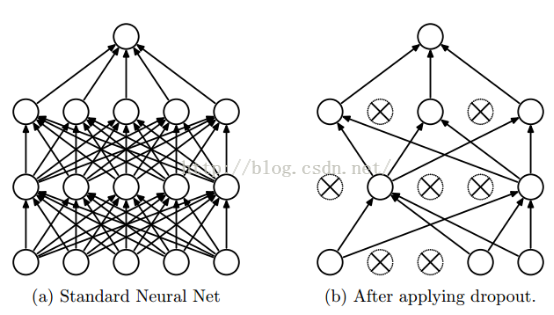

4)采用dropout方法。这个方法在神经网络里面很常用。dropout方法是ImageNet中提出的一种方法,通俗一点讲就是dropout方法在训练的时候让神经元以一定的概率不工作。具体看下图:

如上图所示,左边a图是没用用dropout方法的标准神经网络,右边b图是在训练过程中使用了dropout方法的神经网络,即在训练时候以一定的概率p来跳过一定的神经元。