Word embedding

目录

1. 背景知识

2. 如何实现word embedding?

3. 预测架构来生成 word vector

4. word vector的有趣现象

5. 文章的编码

1. 背景知识

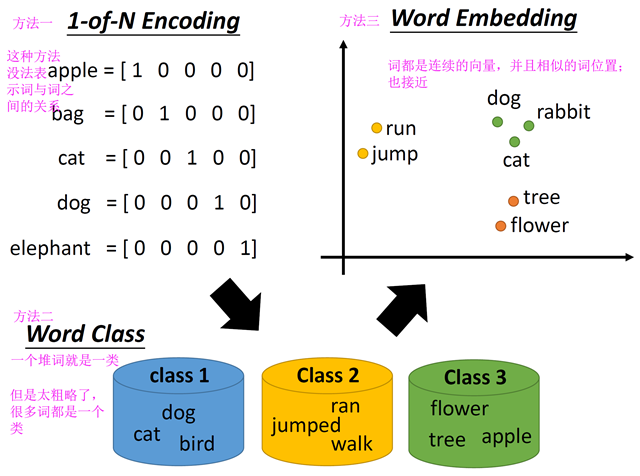

我们在处理语言之前,需要先把字符转化为向量,怎么做呢?

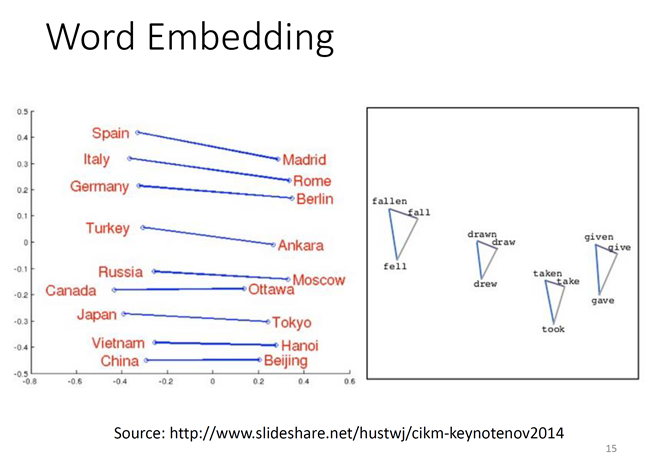

word embedding的原理:

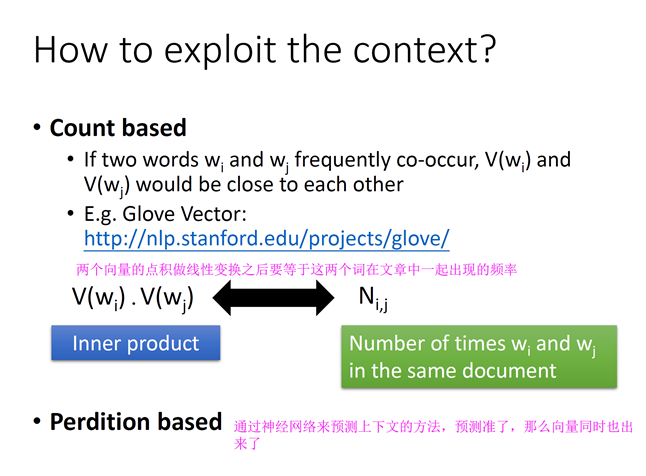

一个词,可以后上下文找到这个词的语义。

对了,这里有个小知识: “潮水” 中,潮是一个字,而“潮水”才是一个词。

2. 如何实现word embedding?

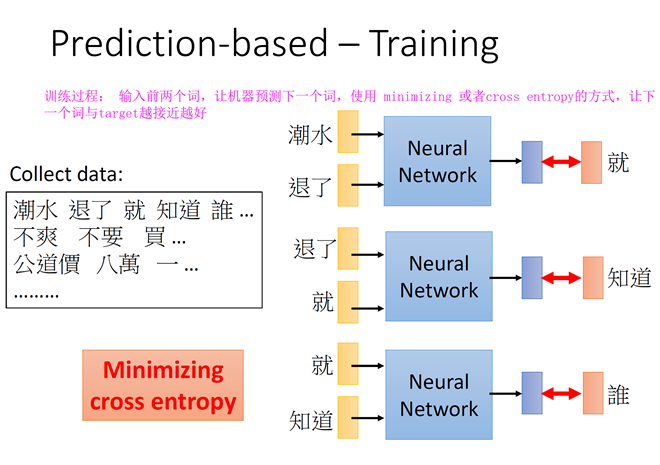

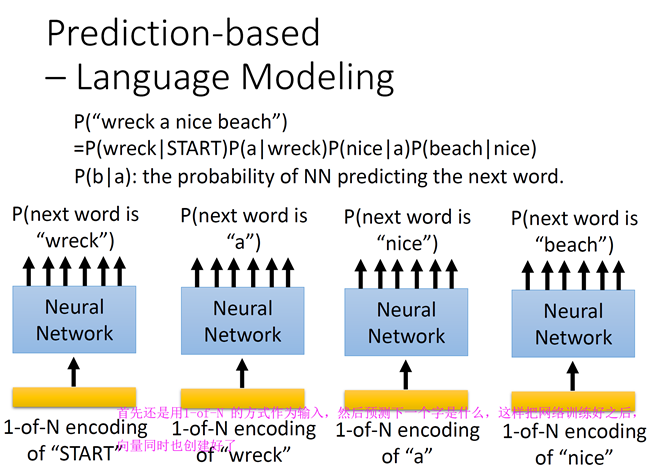

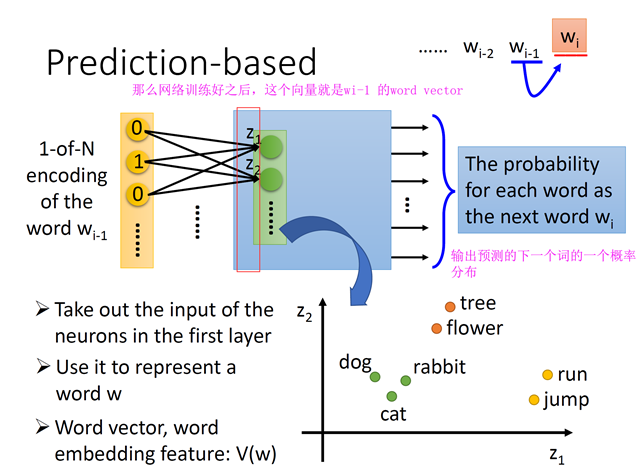

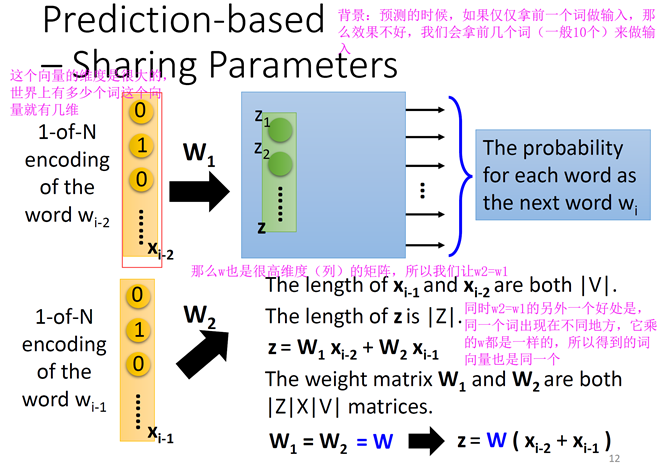

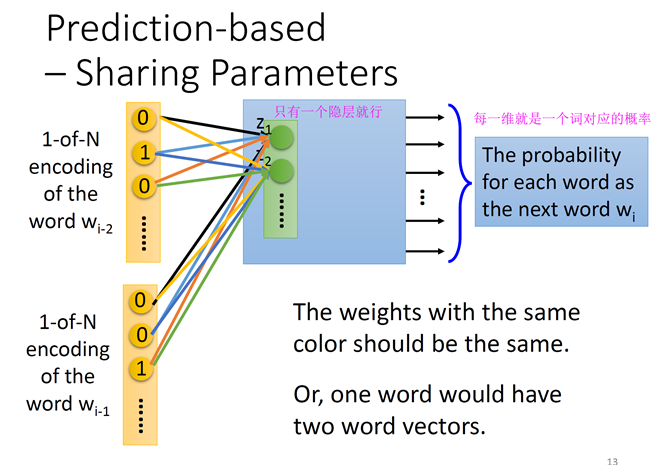

prediction based 的训练方式:

如果问题集里面有十万个词,那么这个network 的输出就是一个十万维的向量。

3. 预测架构来生成 word vector

预测下文的预测模型来生成word vector

一般上面的这个神经网络是一个一维的,提出者表示,没必要是deep的

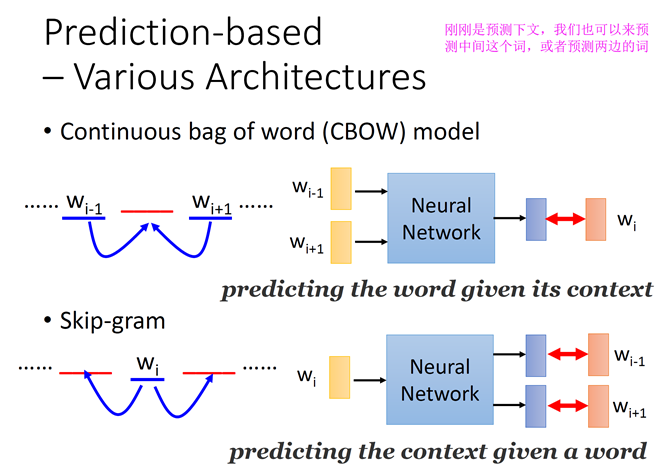

其他的预测模型

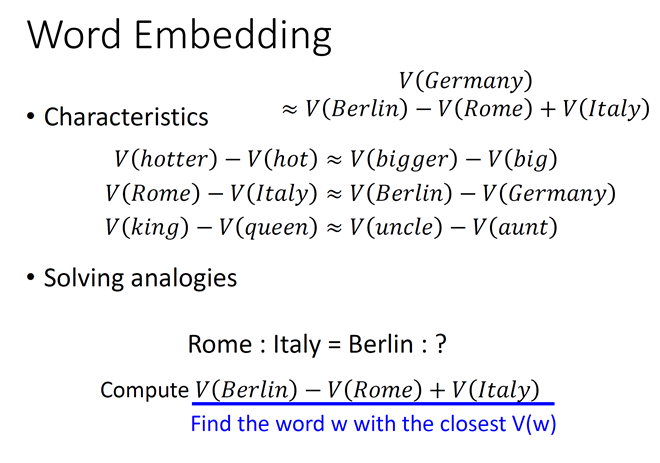

4. word vector的有趣现象:

5. 文章的编码

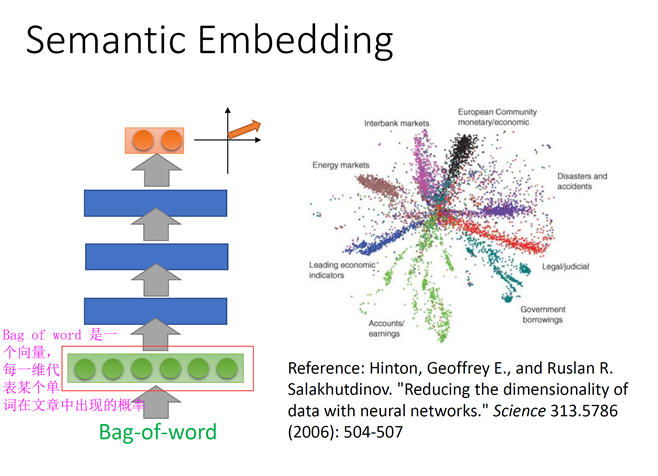

方法一:bag of word

把文章的bag of word 丢到auto-encoder里面就可以得到文章的embedding了

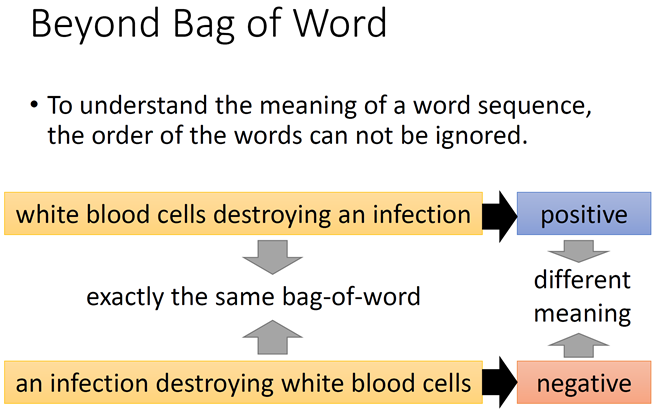

但是词之间的顺序是很重要的,同样的bag of word 可能有不同的意思

Reference:

李宏毅,Unsupervised Learning: Word Embedding,http://speech.ee.ntu.edu.tw/~tlkagk/courses_ML17.html