Python jieba[结巴分词]

1、简要说明

结巴分词支持三种分词模式,支持繁体字,支持自定义词典

2、三种分词模式

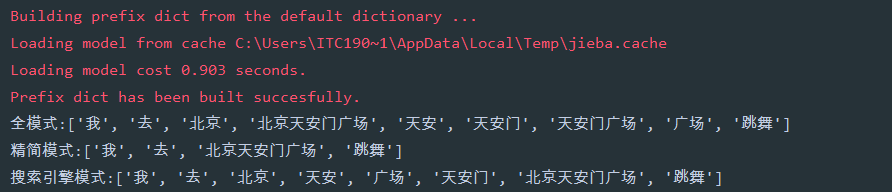

全模式:把句子中所有的可以成词的词语都扫描出来, 速度非常快,但是不能解决歧义

精简模式:把句子最精确的分开,不会添加多余单词,看起来就像是把句子分割一下

搜索引擎模式:在精简模式下,对长词再度切分

# -*- encoding=utf-8 -*- import jieba if __name__ == '__main__': str1 = '我去北京天安门广场跳舞' a = jieba.lcut(str1, cut_all=True) # 全模式 print('全模式:{}'.format(a)) b = jieba.lcut(str1, cut_all=False) # 精简模式 print('精简模式:{}'.format(b)) c = jieba.lcut_for_search(str1) # 搜索引擎模式 print('搜索引擎模式:{}'.format(c))

运行

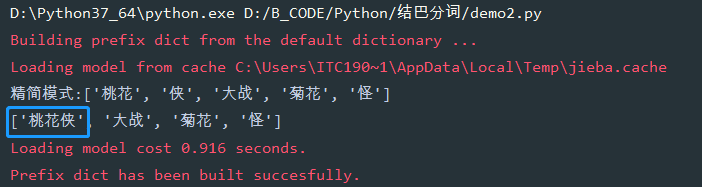

3、某个词语不能被分开

# -*- encoding=utf-8 -*- import jieba if __name__ == '__main__': str1 = '桃花侠大战菊花怪' b = jieba.lcut(str1, cut_all=False) # 精简模式 print('精简模式:{}'.format(b)) # 如果不把桃花侠分开 jieba.add_word('桃花侠') d = jieba.lcut(str1) # 默认是精简模式 print(d)

运行

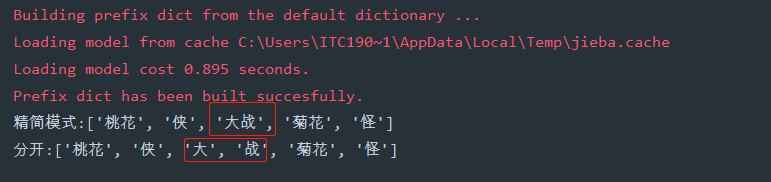

4、 某个单词必须被分开

# -*- encoding=utf-8 -*- import jieba if __name__ == '__main__': # HMM参数,默认为True '''HMM 模型,即隐马尔可夫模型(Hidden Markov Model, HMM),是一种基于概率的统计分析模型, 用来描述一个系统隐性状态的转移和隐性状态的表现概率。 在 jieba 中,对于未登录到词库的词,使用了基于汉字成词能力的 HMM 模型和 Viterbi 算法, 其大致原理是: 采用四个隐含状态,分别表示为单字成词,词组的开头,词组的中间,词组的结尾。 通过标注好的分词训练集,可以得到 HMM 的各个参数,然后使用 Viterbi 算法来解释测试集,得到分词结果。 ''' str1 = '桃花侠大战菊花怪' b = jieba.lcut(str1, cut_all=False, HMM=False) # 精简模式,且不使用HMM模型 print('精简模式:{}'.format(b)) # 分开大战为大和战 jieba.suggest_freq(('大', '战'), True) e = jieba.lcut(str1, HMM=False) # 不使用HMM模型 print('分开:{}'.format(e))

运行

参考链接

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· AI与.NET技术实操系列(二):开始使用ML.NET

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· 葡萄城 AI 搜索升级:DeepSeek 加持,客户体验更智能

· 什么是nginx的强缓存和协商缓存

· 一文读懂知识蒸馏