如何准备自己的YOLO目标检测数据集

如何使用YOLOv8训练自己的模型和进行预测

准备文件夹

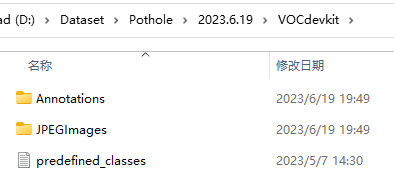

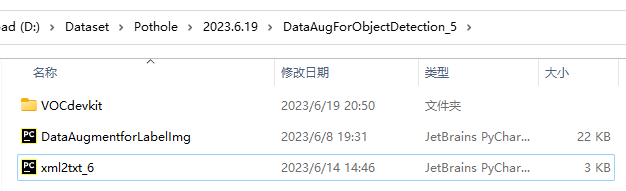

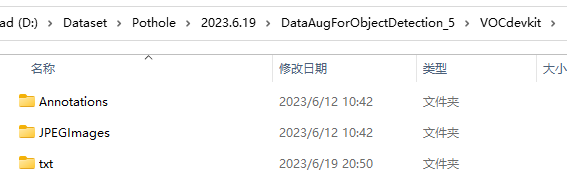

删除重复的照片。然后以图片采集的日期新建一个文件夹,如“2023.6.19”,并在其中新建一个名为VOCdevkit的文件夹,VOCdevkit里面创建一个名为JPEGImages的文件夹存放需要打标签的图片文件;再创建一个名为Annotations存放标注的标签文件;最后创建一个名为 predefined_classes的txt文件来存放所要标注的类别名称。

如下图所示:

在JPEGImages这个文件夹中放置待标注的图片。

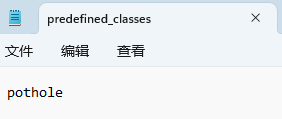

在 predefined_classes这个txt文档里面输入定义的类别种类,如下图所示:

接着进行以下5步,其中统一横纵向、统一分辨率及数据增强可根据自己的需求决定是否进行。

1. 统一为纵向,统一分辨率

将JPEGImages文件夹中照片的横纵向和分辨率进行统一。

具体操作为:新建ChuLiTuPian_1.py文件,放入以下代码,将代码中的folder_path替换为JPEGImages文件夹的绝对路径;将target_resolution替换为我们的目标分辨率,最好也为3:4,如900:1200、720:960。然后运行。

import os

from PIL import Image

folder_path = "D:\Dataset\Pothole/2023.6.25\VOCdevkit\JPEGImages" # Replace with the actual folder path

# 1.将图片统一为纵向 --------------------------------------------------------------------------------------------------

# Iterate over the files in the folder

for filename in os.listdir(folder_path):

if filename.endswith(".jpg") or filename.endswith(".png"): # Adjust file extensions as needed

file_path = os.path.join(folder_path, filename)

# Open the image

image = Image.open(file_path)

width, height = image.size

# Compare horizontal and vertical pixel values

if width > height:

# Rotate the image 90 degrees clockwise

rotated_image = image.rotate(-90, expand=True)

# Save the rotated image, overwrite the original file

rotated_image.save(file_path)

print(f"Image '{filename}' rotated.")

else:

print(f"No operation required for image '{filename}'.")

# 2.统一图片分辨率 --------------------------------------------------------------------------------------------------

def resize_images(folder_path, target_resolution):

# 遍历文件夹中的所有文件

for filename in os.listdir(folder_path):

file_path = os.path.join(folder_path, filename)

# 检查文件是否是图片

if not os.path.isfile(file_path) or not any(

file_path.endswith(extension) for extension in ['.jpg', '.jpeg', '.png']):

continue

# 打开图片

image = Image.open(file_path)

# 获取原始分辨率

original_resolution = image.size

# 计算调整比例

ratio = min(target_resolution[0] / original_resolution[0], target_resolution[1] / original_resolution[1])

# 计算调整后的尺寸

resized_size = (int(original_resolution[0] * ratio), int(original_resolution[1] * ratio))

# 调整图片分辨率

resized_image = image.resize(resized_size)

# 创建空白画布

canvas = Image.new('RGB', target_resolution, (255, 255, 255))

# 在画布上居中粘贴调整后的图片

offset = ((target_resolution[0] - resized_size[0]) // 2, (target_resolution[1] - resized_size[1]) // 2)

canvas.paste(resized_image, offset)

# 保存调整后的图片

canvas.save(file_path)

# 指定文件夹路径和目标分辨率

target_resolution = (720, 960) # 替换为你的目标分辨率

# 调用函数进行图片分辨率统一

resize_images(folder_path, target_resolution)

2. 利用labelimg标注数据集

2.1 labelimg介绍

Labelimg是一款开源的数据标注工具,可以标注三种格式。

(1)VOC标签格式,保存为xml文件。

(2)yolo标签格式,保存为txt文件。

(3)createML标签格式,保存为json格式。

2.2 labelimg在Windows下的安装

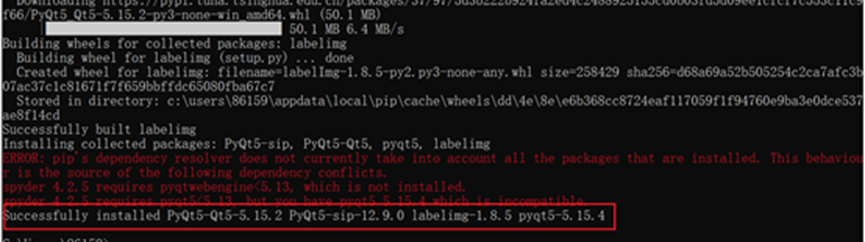

打开cmd命令行(快捷键:win+R)。进入cmd命令行控制台。输入如下命令并运行:

pip install labelimg -i https://pypi.tuna.tsinghua.edu.cn/simple

出现如下红色框框中的告诉我们成功安装的时候,说明labelimg安装成功了。

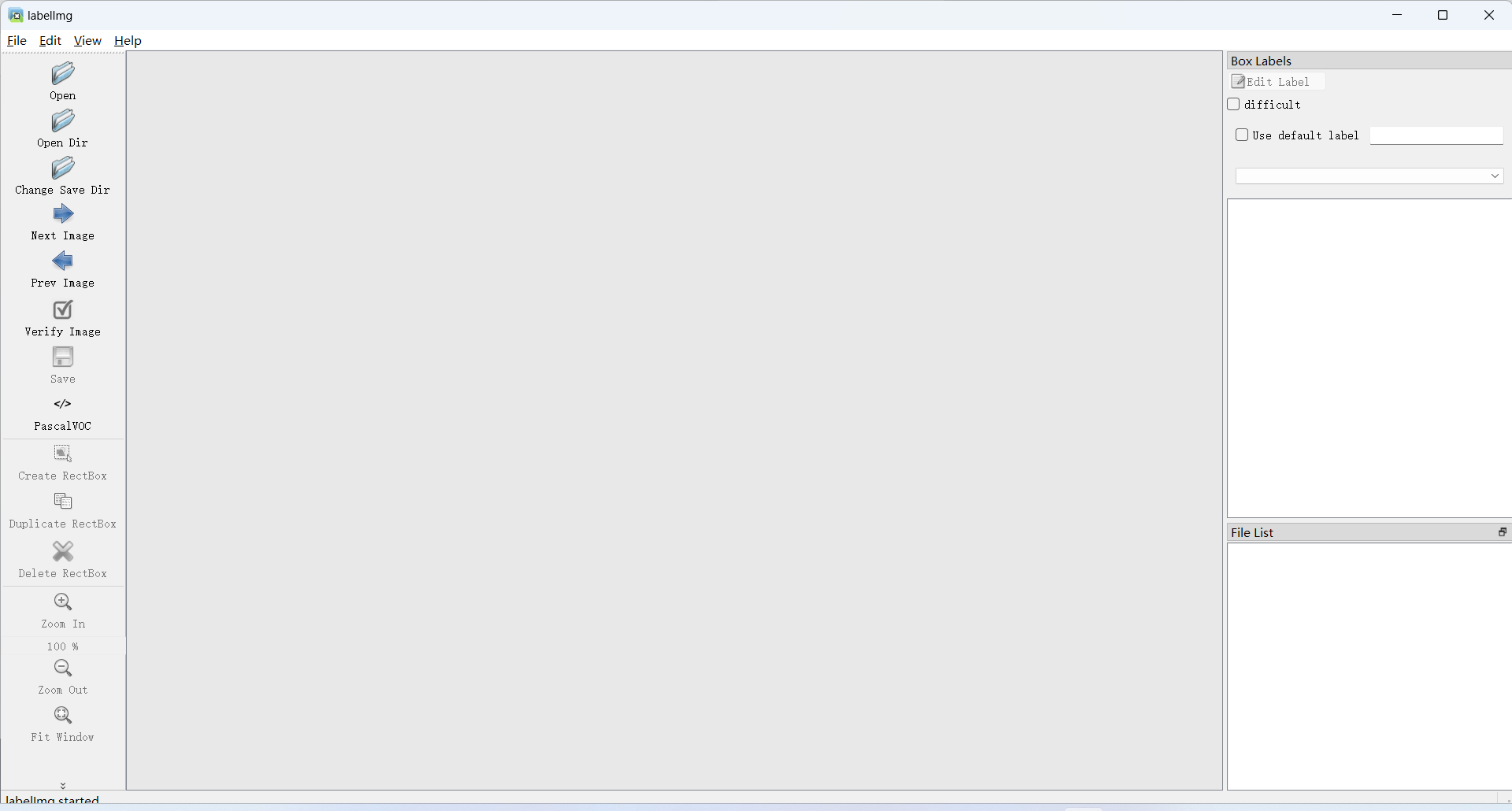

2.3 使用labelimg

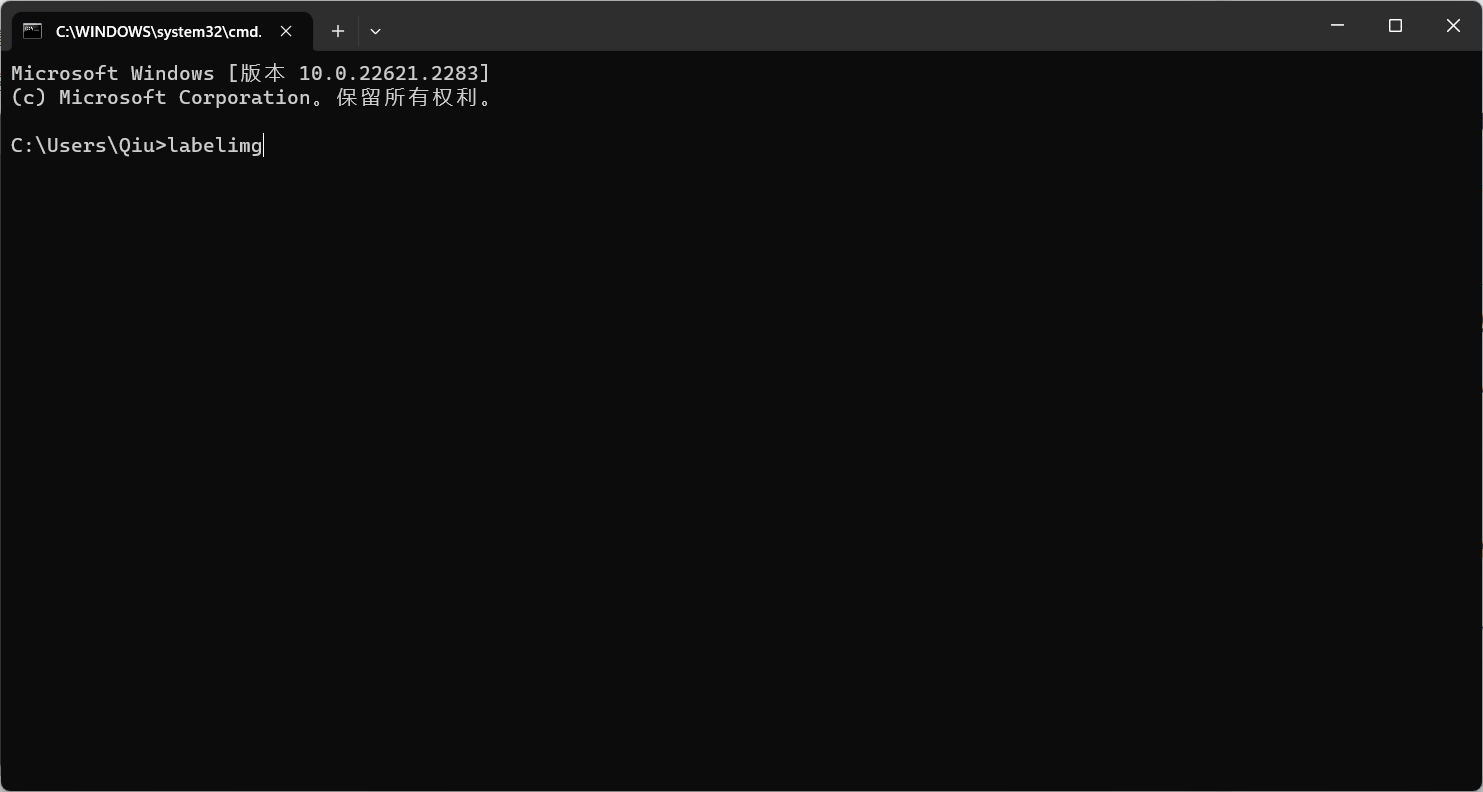

在VOCdevkit文件夹下右击,选择”在终端中打开“。

输入labelimg打开labelimg

运行如上的命令就会打开这个工具,如下。

修改三处设置:

:待标注图片数据的路径文件夹,选择JPEGImages文件夹。

:待标注图片数据的路径文件夹,选择JPEGImages文件夹。

:保存类别标签的路径文件夹,选择Annotations文件夹。

:保存类别标签的路径文件夹,选择Annotations文件夹。

:选择标注的标签为PascalVOC(xml)格式。

:选择标注的标签为PascalVOC(xml)格式。

接下来,点击view,会出现如图红色框框中的选项。勾选以下三项:

Auto Save mode:切换到下一张图的时候,会自动保存标签。

Display Labels:会显示标注框和标签

Advanced Mode:标注的十字架会一直悬浮在窗口。

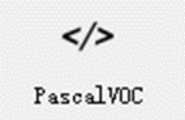

开始标注

对JPEGImages文件夹中所有图片逐个进行标注:

按快捷键W,然后选定我们需要标注的对象。按住鼠标左键拖出框框就可以了。如下图所示,当我们选定目标以后,就会加载出来predefined_classes.txt 定义自己要标注的所有类别。打好的标签框框上会有该框框的类别。然后界面最右边会出现打好的类别标签。打好一张照片以后,快捷键D,就会进入下一张。在Annotations文件夹中会自动保存标签文件,而且标签文件的名称会与JPEGImages中对应图片的名称一致。

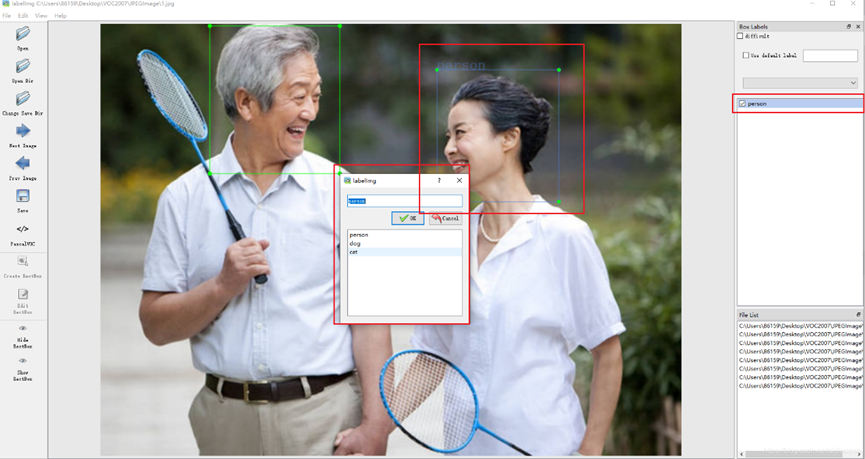

3.进行数据增强

(1)在“2023.6.19”文件夹中建立一个DataAugForObjectDetection_3文件夹,将进行第2章处理后得到的VOCdevkit文件夹复制粘贴到DataAugForObjectDetection_3文件夹中,并在DataAugForObjectDetection_3文件夹中新建一个DataAugmentforLabelImg.py如下图所示:

(2)在VOCdevkit文件夹中新建两个子文件夹:JPEGImages2和Annotations2,最终VOCdevkit文件夹中包含四个子文件夹,如下图所示:

(3)在(1)中创建的DataAugmentforLabelImg.py文件中放入以下代码,运行后会分别在JPEGImages2和Annotations2文件夹中产生扩充后的图片和标签文件。

(4)运行过后删除VOCdevkit里的JPEGImages和Annotations文件夹,并将得到的JPEGImages2和Annotations2文件夹分别改名为JPEGImages和Annotations。

# -*- coding=utf-8 -*-

##############################################################

# description:

# data augmentation for obeject detection

# author:

# pureyang 2019-08-26

# 参考:https://github.com/maozezhong/CV_ToolBox/blob/master/DataAugForObjectDetection

##############################################################

# 包括:

# 1. 裁剪(需改变bbox)

# 2. 平移(需改变bbox)

# 3. 改变亮度

# 4. 加噪声

# 5. 旋转角度(需要改变bbox)

# 6. 镜像(需要改变bbox)

# 7. cutout

# 注意:

# random.seed(),相同的seed,产生的随机数是一样的!!

import time

import random

import copy

import cv2

import os

import math

import numpy as np

from skimage.util import random_noise

from lxml import etree, objectify

import xml.etree.ElementTree as ET

import argparse

# 显示图片

def show_pic(img, bboxes=None):

'''

输入:

img:图像array

bboxes:图像的所有boudning box list, 格式为[[x_min, y_min, x_max, y_max]....]

names:每个box对应的名称

'''

for i in range(len(bboxes)):

bbox = bboxes[i]

x_min = bbox[0]

y_min = bbox[1]

x_max = bbox[2]

y_max = bbox[3]

cv2.rectangle(img, (int(x_min), int(y_min)), (int(x_max), int(y_max)), (0, 255, 0), 3)

cv2.namedWindow('pic', 0) # 1表示原图

cv2.moveWindow('pic', 0, 0)

cv2.resizeWindow('pic', 1200, 800) # 可视化的图片大小

cv2.imshow('pic', img)

cv2.waitKey(0)

cv2.destroyAllWindows()

# 图像均为cv2读取

class DataAugmentForObjectDetection():

def __init__(self, rotation_rate=0.5, max_rotation_angle=5,

crop_rate=0.5, shift_rate=0.5, change_light_rate=0.5,

add_noise_rate=0.5, flip_rate=0.5,

cutout_rate=0.5, cut_out_length=50, cut_out_holes=1, cut_out_threshold=0.5,

is_addNoise=True, is_changeLight=True, is_cutout=True, is_rotate_img_bbox=True,

is_crop_img_bboxes=True, is_shift_pic_bboxes=True, is_filp_pic_bboxes=True):

# 配置各个操作的属性

self.rotation_rate = rotation_rate

self.max_rotation_angle = max_rotation_angle

self.crop_rate = crop_rate

self.shift_rate = shift_rate

self.change_light_rate = change_light_rate

self.add_noise_rate = add_noise_rate

self.flip_rate = flip_rate

self.cutout_rate = cutout_rate

self.cut_out_length = cut_out_length

self.cut_out_holes = cut_out_holes

self.cut_out_threshold = cut_out_threshold

# 是否使用某种增强方式

self.is_addNoise = is_addNoise

self.is_changeLight = is_changeLight

self.is_cutout = is_cutout

self.is_rotate_img_bbox = is_rotate_img_bbox

self.is_crop_img_bboxes = is_crop_img_bboxes

self.is_shift_pic_bboxes = is_shift_pic_bboxes

self.is_filp_pic_bboxes = is_filp_pic_bboxes

# 加噪声

def _addNoise(self, img):

'''

输入:

img:图像array

输出:

加噪声后的图像array,由于输出的像素是在[0,1]之间,所以得乘以255

'''

# return cv2.GaussianBlur(img, (11, 11), 0)

return random_noise(img, mode='gaussian', seed=int(time.time()), clip=True) * 255

# 调整亮度

def _changeLight(self, img):

alpha = random.uniform(0.35, 1)

blank = np.zeros(img.shape, img.dtype)

return cv2.addWeighted(img, alpha, blank, 1 - alpha, 0)

# cutout

def _cutout(self, img, bboxes, length=100, n_holes=1, threshold=0.5):

'''

原版本:https://github.com/uoguelph-mlrg/Cutout/blob/master/util/cutout.py

Randomly mask out one or more patches from an image.

Args:

img : a 3D numpy array,(h,w,c)

bboxes : 框的坐标

n_holes (int): Number of patches to cut out of each image.

length (int): The length (in pixels) of each square patch.

'''

def cal_iou(boxA, boxB):

'''

boxA, boxB为两个框,返回iou

boxB为bouding box

'''

# determine the (x, y)-coordinates of the intersection rectangle

xA = max(boxA[0], boxB[0])

yA = max(boxA[1], boxB[1])

xB = min(boxA[2], boxB[2])

yB = min(boxA[3], boxB[3])

if xB <= xA or yB <= yA:

return 0.0

# compute the area of intersection rectangle

interArea = (xB - xA + 1) * (yB - yA + 1)

# compute the area of both the prediction and ground-truth

# rectangles

boxAArea = (boxA[2] - boxA[0] + 1) * (boxA[3] - boxA[1] + 1)

boxBArea = (boxB[2] - boxB[0] + 1) * (boxB[3] - boxB[1] + 1)

iou = interArea / float(boxBArea)

return iou

# 得到h和w

if img.ndim == 3:

h, w, c = img.shape

else:

_, h, w, c = img.shape

mask = np.ones((h, w, c), np.float32)

for n in range(n_holes):

chongdie = True # 看切割的区域是否与box重叠太多

while chongdie:

y = np.random.randint(h)

x = np.random.randint(w)

y1 = np.clip(y - length // 2, 0,

h) # numpy.clip(a, a_min, a_max, out=None), clip这个函数将将数组中的元素限制在a_min, a_max之间,大于a_max的就使得它等于 a_max,小于a_min,的就使得它等于a_min

y2 = np.clip(y + length // 2, 0, h)

x1 = np.clip(x - length // 2, 0, w)

x2 = np.clip(x + length // 2, 0, w)

chongdie = False

for box in bboxes:

if cal_iou([x1, y1, x2, y2], box) > threshold:

chongdie = True

break

mask[y1: y2, x1: x2, :] = 0.

img = img * mask

return img

# 旋转

def _rotate_img_bbox(self, img, bboxes, angle=5, scale=1.):

'''

参考:https://blog.csdn.net/u014540717/article/details/53301195crop_rate

输入:

img:图像array,(h,w,c)

bboxes:该图像包含的所有boundingboxs,一个list,每个元素为[x_min, y_min, x_max, y_max],要确保是数值

angle:旋转角度

scale:默认1

输出:

rot_img:旋转后的图像array

rot_bboxes:旋转后的boundingbox坐标list

'''

# ---------------------- 旋转图像 ----------------------

w = img.shape[1]

h = img.shape[0]

# 角度变弧度

rangle = np.deg2rad(angle) # angle in radians

# now calculate new image width and height

nw = (abs(np.sin(rangle) * h) + abs(np.cos(rangle) * w)) * scale

nh = (abs(np.cos(rangle) * h) + abs(np.sin(rangle) * w)) * scale

# ask OpenCV for the rotation matrix

rot_mat = cv2.getRotationMatrix2D((nw * 0.5, nh * 0.5), angle, scale)

# calculate the move from the old center to the new center combined

# with the rotation

rot_move = np.dot(rot_mat, np.array([(nw - w) * 0.5, (nh - h) * 0.5, 0]))

# the move only affects the translation, so update the translation

rot_mat[0, 2] += rot_move[0]

rot_mat[1, 2] += rot_move[1]

# 仿射变换

rot_img = cv2.warpAffine(img, rot_mat, (int(math.ceil(nw)), int(math.ceil(nh))), flags=cv2.INTER_LANCZOS4)

# ---------------------- 矫正bbox坐标 ----------------------

# rot_mat是最终的旋转矩阵

# 获取原始bbox的四个中点,然后将这四个点转换到旋转后的坐标系下

rot_bboxes = list()

for bbox in bboxes:

xmin = bbox[0]

ymin = bbox[1]

xmax = bbox[2]

ymax = bbox[3]

point1 = np.dot(rot_mat, np.array([(xmin + xmax) / 2, ymin, 1]))

point2 = np.dot(rot_mat, np.array([xmax, (ymin + ymax) / 2, 1]))

point3 = np.dot(rot_mat, np.array([(xmin + xmax) / 2, ymax, 1]))

point4 = np.dot(rot_mat, np.array([xmin, (ymin + ymax) / 2, 1]))

# 合并np.array

concat = np.vstack((point1, point2, point3, point4))

# 改变array类型

concat = concat.astype(np.int32)

# 得到旋转后的坐标

rx, ry, rw, rh = cv2.boundingRect(concat)

rx_min = rx

ry_min = ry

rx_max = rx + rw

ry_max = ry + rh

# 加入list中

rot_bboxes.append([rx_min, ry_min, rx_max, ry_max])

return rot_img, rot_bboxes

# 裁剪

def _crop_img_bboxes(self, img, bboxes):

'''

裁剪后的图片要包含所有的框

输入:

img:图像array

bboxes:该图像包含的所有boundingboxs,一个list,每个元素为[x_min, y_min, x_max, y_max],要确保是数值

输出:

crop_img:裁剪后的图像array

crop_bboxes:裁剪后的bounding box的坐标list

'''

# ---------------------- 裁剪图像 ----------------------

w = img.shape[1]

h = img.shape[0]

x_min = w # 裁剪后的包含所有目标框的最小的框

x_max = 0

y_min = h

y_max = 0

for bbox in bboxes:

x_min = min(x_min, bbox[0])

y_min = min(y_min, bbox[1])

x_max = max(x_max, bbox[2])

y_max = max(y_max, bbox[3])

d_to_left = x_min # 包含所有目标框的最小框到左边的距离

d_to_right = w - x_max # 包含所有目标框的最小框到右边的距离

d_to_top = y_min # 包含所有目标框的最小框到顶端的距离

d_to_bottom = h - y_max # 包含所有目标框的最小框到底部的距离

# 随机扩展这个最小框

crop_x_min = int(x_min - random.uniform(0, d_to_left))

crop_y_min = int(y_min - random.uniform(0, d_to_top))

crop_x_max = int(x_max + random.uniform(0, d_to_right))

crop_y_max = int(y_max + random.uniform(0, d_to_bottom))

# 随机扩展这个最小框 , 防止别裁的太小

# crop_x_min = int(x_min - random.uniform(d_to_left//2, d_to_left))

# crop_y_min = int(y_min - random.uniform(d_to_top//2, d_to_top))

# crop_x_max = int(x_max + random.uniform(d_to_right//2, d_to_right))

# crop_y_max = int(y_max + random.uniform(d_to_bottom//2, d_to_bottom))

# 确保不要越界

crop_x_min = max(0, crop_x_min)

crop_y_min = max(0, crop_y_min)

crop_x_max = min(w, crop_x_max)

crop_y_max = min(h, crop_y_max)

crop_img = img[crop_y_min:crop_y_max, crop_x_min:crop_x_max]

# ---------------------- 裁剪boundingbox ----------------------

# 裁剪后的boundingbox坐标计算

crop_bboxes = list()

for bbox in bboxes:

crop_bboxes.append([bbox[0] - crop_x_min, bbox[1] - crop_y_min, bbox[2] - crop_x_min, bbox[3] - crop_y_min])

return crop_img, crop_bboxes

# 平移

def _shift_pic_bboxes(self, img, bboxes):

'''

参考:https://blog.csdn.net/sty945/article/details/79387054

平移后的图片要包含所有的框

输入:

img:图像array

bboxes:该图像包含的所有boundingboxs,一个list,每个元素为[x_min, y_min, x_max, y_max],要确保是数值

输出:

shift_img:平移后的图像array

shift_bboxes:平移后的bounding box的坐标list

'''

# ---------------------- 平移图像 ----------------------

w = img.shape[1]

h = img.shape[0]

x_min = w # 裁剪后的包含所有目标框的最小的框

x_max = 0

y_min = h

y_max = 0

for bbox in bboxes:

x_min = min(x_min, bbox[0])

y_min = min(y_min, bbox[1])

x_max = max(x_max, bbox[2])

y_max = max(y_max, bbox[3])

d_to_left = x_min # 包含所有目标框的最大左移动距离

d_to_right = w - x_max # 包含所有目标框的最大右移动距离

d_to_top = y_min # 包含所有目标框的最大上移动距离

d_to_bottom = h - y_max # 包含所有目标框的最大下移动距离

x = random.uniform(-(d_to_left - 1) / 3, (d_to_right - 1) / 3)

y = random.uniform(-(d_to_top - 1) / 3, (d_to_bottom - 1) / 3)

M = np.float32([[1, 0, x], [0, 1, y]]) # x为向左或右移动的像素值,正为向右负为向左; y为向上或者向下移动的像素值,正为向下负为向上

shift_img = cv2.warpAffine(img, M, (img.shape[1], img.shape[0]))

# ---------------------- 平移boundingbox ----------------------

shift_bboxes = list()

for bbox in bboxes:

shift_bboxes.append([bbox[0] + x, bbox[1] + y, bbox[2] + x, bbox[3] + y])

return shift_img, shift_bboxes

# 镜像

def _filp_pic_bboxes(self, img, bboxes):

'''

参考:https://blog.csdn.net/jningwei/article/details/78753607

平移后的图片要包含所有的框

输入:

img:图像array

bboxes:该图像包含的所有boundingboxs,一个list,每个元素为[x_min, y_min, x_max, y_max],要确保是数值

输出:

flip_img:平移后的图像array

flip_bboxes:平移后的bounding box的坐标list

'''

# ---------------------- 翻转图像 ----------------------

flip_img = copy.deepcopy(img)

h, w, _ = img.shape

sed = random.random()

if 0 < sed < 0.33: # 0.33的概率水平翻转,0.33的概率垂直翻转,0.33是对角反转

flip_img = cv2.flip(flip_img, 0) # _flip_x

inver = 0

elif 0.33 < sed < 0.66:

flip_img = cv2.flip(flip_img, 1) # _flip_y

inver = 1

else:

flip_img = cv2.flip(flip_img, -1) # flip_x_y

inver = -1

# ---------------------- 调整boundingbox ----------------------

flip_bboxes = list()

for box in bboxes:

x_min = box[0]

y_min = box[1]

x_max = box[2]

y_max = box[3]

if inver == 0:

#0:垂直翻转

flip_bboxes.append([x_min, h - y_max, x_max, h - y_min])

elif inver == 1:

# 1:水平翻转

flip_bboxes.append([w - x_max, y_min, w - x_min, y_max])

elif inver == -1:

# -1:水平垂直翻转

flip_bboxes.append([w - x_max, h - y_max, w - x_min, h - y_min])

return flip_img, flip_bboxes

# 图像增强方法

def dataAugment(self, img, bboxes):

'''

图像增强

输入:

img:图像array

bboxes:该图像的所有框坐标

输出:

img:增强后的图像

bboxes:增强后图片对应的box

'''

change_num = 0 # 改变的次数

# print('------')

while change_num < 1: # 默认至少有一种数据增强生效

if self.is_rotate_img_bbox:

if random.random() > self.rotation_rate: # 旋转

change_num += 1

angle = random.uniform(-self.max_rotation_angle, self.max_rotation_angle)

scale = random.uniform(0.7, 0.8)

img, bboxes = self._rotate_img_bbox(img, bboxes, angle, scale)

if self.is_shift_pic_bboxes:

if random.random() < self.shift_rate: # 平移

change_num += 1

img, bboxes = self._shift_pic_bboxes(img, bboxes)

if self.is_changeLight:

if random.random() > self.change_light_rate: # 改变亮度

change_num += 1

img = self._changeLight(img)

if self.is_addNoise:

if random.random() < self.add_noise_rate: # 加噪声

change_num += 1

img = self._addNoise(img)

if self.is_cutout:

if random.random() < self.cutout_rate: # cutout

change_num += 1

img = self._cutout(img, bboxes, length=self.cut_out_length, n_holes=self.cut_out_holes,

threshold=self.cut_out_threshold)

if self.is_filp_pic_bboxes:

if random.random() < self.flip_rate: # 翻转

change_num += 1

img, bboxes = self._filp_pic_bboxes(img, bboxes)

return img, bboxes

# xml解析工具

class ToolHelper():

# 从xml文件中提取bounding box信息, 格式为[[x_min, y_min, x_max, y_max, name]]

def parse_xml(self, path):

'''

输入:

xml_path: xml的文件路径

输出:

从xml文件中提取bounding box信息, 格式为[[x_min, y_min, x_max, y_max, name]]

'''

tree = ET.parse(path)

root = tree.getroot()

objs = root.findall('object')

coords = list()

for ix, obj in enumerate(objs):

name = obj.find('name').text

box = obj.find('bndbox')

x_min = int(box[0].text)

y_min = int(box[1].text)

x_max = int(box[2].text)

y_max = int(box[3].text)

coords.append([x_min, y_min, x_max, y_max, name])

return coords

# 保存图片结果

def save_img(self, file_name, save_folder, img):

cv2.imwrite(os.path.join(save_folder, file_name), img)

# 保持xml结果

def save_xml(self, file_name, save_folder, img_info, height, width, channel, bboxs_info):

'''

:param file_name:文件名

:param save_folder:#保存的xml文件的结果

:param height:图片的信息

:param width:图片的宽度

:param channel:通道

:return:

'''

folder_name, img_name = img_info # 得到图片的信息

E = objectify.ElementMaker(annotate=False)

anno_tree = E.annotation(

E.folder(folder_name),

E.filename(img_name),

E.path(os.path.join(folder_name, img_name)),

E.source(

E.database('Unknown'),

),

E.size(

E.width(width),

E.height(height),

E.depth(channel)

),

E.segmented(0),

)

labels, bboxs = bboxs_info # 得到边框和标签信息

for label, box in zip(labels, bboxs):

anno_tree.append(

E.object(

E.name(label),

E.pose('Unspecified'),

E.truncated('0'),

E.difficult('0'),

E.bndbox(

E.xmin(box[0]),

E.ymin(box[1]),

E.xmax(box[2]),

E.ymax(box[3])

)

))

etree.ElementTree(anno_tree).write(os.path.join(save_folder, file_name), pretty_print=True)

if __name__ == '__main__':

need_aug_num = 10 # 每张图片需要增强的次数

is_endwidth_dot = True # 文件是否以.jpg或者png结尾

dataAug = DataAugmentForObjectDetection() # 数据增强工具类

toolhelper = ToolHelper() # 工具

# 获取相关参数

parser = argparse.ArgumentParser()

parser.add_argument('--source_img_path', type=str, default='VOCdevkit/JPEGImages')

parser.add_argument('--source_xml_path', type=str, default='VOCdevkit/Annotations')

parser.add_argument('--save_img_path', type=str, default='VOCdevkit/JPEGImages2')

parser.add_argument('--save_xml_path', type=str, default='VOCdevkit/Annotations2')

args = parser.parse_args()

source_img_path = args.source_img_path # 图片原始位置

source_xml_path = args.source_xml_path # xml的原始位置

save_img_path = args.save_img_path # 图片增强结果保存文件

save_xml_path = args.save_xml_path # xml增强结果保存文件

# 如果保存文件夹不存在就创建

if not os.path.exists(save_img_path):

os.mkdir(save_img_path)

if not os.path.exists(save_xml_path):

os.mkdir(save_xml_path)

for parent, _, files in os.walk(source_img_path):

files.sort()

for file in files:

cnt = 0

pic_path = os.path.join(parent, file)

xml_path = os.path.join(source_xml_path, file[:-4] + '.xml')

values = toolhelper.parse_xml(xml_path) # 解析得到box信息,格式为[[x_min,y_min,x_max,y_max,name]]

coords = [v[:4] for v in values] # 得到框

labels = [v[-1] for v in values] # 对象的标签

# 如果图片是有后缀的

if is_endwidth_dot:

# 找到文件的最后名字

dot_index = file.rfind('.')

_file_prefix = file[:dot_index] # 文件名的前缀

_file_suffix = file[dot_index:] # 文件名的后缀

img = cv2.imread(pic_path)

# show_pic(img, coords) # 显示原图

while cnt < need_aug_num: # 继续增强

auged_img, auged_bboxes = dataAug.dataAugment(img, coords)

auged_bboxes_int = np.array(auged_bboxes).astype(np.int32)

height, width, channel = auged_img.shape # 得到图片的属性

img_name = '{}_{}{}'.format(_file_prefix, cnt + 1, _file_suffix) # 图片保存的信息

toolhelper.save_img(img_name, save_img_path,

auged_img) # 保存增强图片

toolhelper.save_xml('{}_{}.xml'.format(_file_prefix, cnt + 1),

save_xml_path, (save_img_path, img_name), height, width, channel,

(labels, auged_bboxes_int)) # 保存xml文件

# show_pic(auged_img, auged_bboxes) # 强化后的图

print(img_name)

cnt += 1 # 继续增强下一张

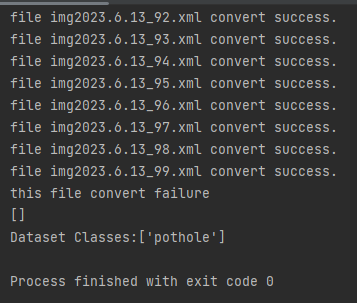

4.将.xml格式的标签文件转换为.txt格式

YOLO算法使用的标签文件实际是.txt格式的,而我们通过前3步处理得到的标签文件实际为.xml格式,所以我们需要将.xml格式的标签文件转换为.txt格式。

在DataAugForObjectDetection_3文件夹中新建xml2txt_4.py文件,如下图所示:

在xml2txt_4.py文件中放入以下代码:

import xml.etree.ElementTree as ET

import os, cv2

import numpy as np

from os import listdir

from os.path import join

classes = []

def convert(size, box):

dw = 1. / (size[0])

dh = 1. / (size[1])

x = (box[0] + box[1]) / 2.0 - 1

y = (box[2] + box[3]) / 2.0 - 1

w = box[1] - box[0]

h = box[3] - box[2]

x = x * dw

w = w * dw

y = y * dh

h = h * dh

return (x, y, w, h)

def convert_annotation(xmlpath, xmlname):

with open(xmlpath, "r", encoding='utf-8') as in_file:

txtname = xmlname[:-4] + '.txt'

txtfile = os.path.join(txtpath, txtname)

tree = ET.parse(in_file)

root = tree.getroot()

filename = root.find('filename')

img = cv2.imdecode(np.fromfile('{}/{}.{}'.format(imgpath, xmlname[:-4], postfix), np.uint8), cv2.IMREAD_COLOR)

h, w = img.shape[:2]

res = []

for obj in root.iter('object'):

cls = obj.find('name').text

if cls not in classes:

classes.append(cls)

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('ymax').text))

bb = convert((w, h), b)

res.append(str(cls_id) + " " + " ".join([str(a) for a in bb]))

if len(res) != 0:

with open(txtfile, 'w+') as f:

f.write('\n'.join(res))

if __name__ == "__main__":

postfix = 'jpg'

imgpath = 'VOCdevkit/JPEGImages'

xmlpath = 'VOCdevkit/Annotations'

txtpath = 'VOCdevkit/txt'

if not os.path.exists(txtpath):

os.makedirs(txtpath, exist_ok=True)

list = os.listdir(xmlpath)

error_file_list = []

for i in range(0, len(list)):

try:

path = os.path.join(xmlpath, list[i])

if ('.xml' in path) or ('.XML' in path):

convert_annotation(path, list[i])

print(f'file {list[i]} convert success.')

else:

print(f'file {list[i]} is not xml format.')

except Exception as e:

print(f'file {list[i]} convert error.')

print(f'error message:\n{e}')

error_file_list.append(list[i])

print(f'this file convert failure\n{error_file_list}')

print(f'Dataset Classes:{classes}')

运行后会在VOCdevkit文件夹中生成txt文件夹,其中存有转换后的.txt格式的标签文件。

命令行中则会输出以下:

这里的pothole即为标签类别。

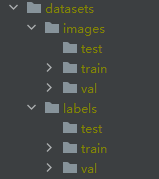

5.划分训练集、验证集、测试集

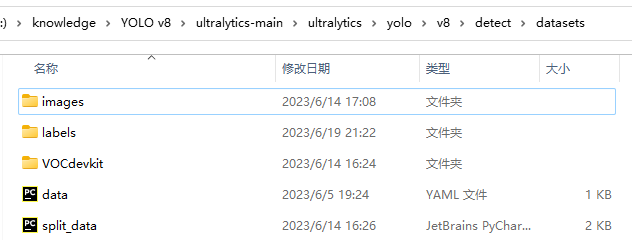

在文件夹路径YOLO v8\ultralytics-main\ultralytics\yolo\v8\detect下,新建datasets文件夹

将第4章处理后得到的VOCdevkit文件夹复制粘贴到datasets文件夹中,并删掉其中的Annotations文件夹

在datasets文件夹中新建split_data.py文件

在split_data.py文件中放入以下代码并运行,这个文件是划分训练、验证、测试集。其中支持修改train_percent、val_percent、test_percent,改变训练集、验证集和测试集比例

# 将图片和标注数据按比例切分为 训练集和测试集

import shutil

import random

import os

import argparse

# 检查文件夹是否存在

def mkdir(path):

if not os.path.exists(path):

os.makedirs(path)

def main(image_dir, txt_dir, save_dir):

# 创建文件夹

mkdir(save_dir)

images_dir = os.path.join(save_dir, 'images')

labels_dir = os.path.join(save_dir, 'labels')

img_train_path = os.path.join(images_dir, 'train')

img_test_path = os.path.join(images_dir, 'test')

img_val_path = os.path.join(images_dir, 'val')

label_train_path = os.path.join(labels_dir, 'train')

label_test_path = os.path.join(labels_dir, 'test')

label_val_path = os.path.join(labels_dir, 'val')

mkdir(images_dir);

mkdir(labels_dir);

mkdir(img_train_path);

mkdir(img_test_path);

mkdir(img_val_path);

mkdir(label_train_path);

mkdir(label_test_path);

mkdir(label_val_path);

# 数据集划分比例,训练集80%,验证集10%,测试集10%,按需修改

train_percent = 0.8

val_percent = 0.1

test_percent = 0.1

total_txt = os.listdir(txt_dir)

num_txt = len(total_txt)

list_all_txt = range(num_txt) # 范围 range(0, num)

num_train = int(num_txt * train_percent)

num_val = int(num_txt * val_percent)

num_test = num_txt - num_train - num_val

train = random.sample(list_all_txt, num_train)

# 在全部数据集中取出train

val_test = [i for i in list_all_txt if not i in train]

# 再从val_test取出num_val个元素,val_test剩下的元素就是test

val = random.sample(val_test, num_val)

print("训练集数目:{}, 验证集数目:{},测试集数目:{}".format(len(train), len(val), len(val_test) - len(val)))

for i in list_all_txt:

name = total_txt[i][:-4]

srcImage = os.path.join(image_dir, name + '.jpg')

srcLabel = os.path.join(txt_dir, name + '.txt')

if i in train:

dst_train_Image = os.path.join(img_train_path, name + '.jpg')

dst_train_Label = os.path.join(label_train_path, name + '.txt')

shutil.copyfile(srcImage, dst_train_Image)

shutil.copyfile(srcLabel, dst_train_Label)

elif i in val:

dst_val_Image = os.path.join(img_val_path, name + '.jpg')

dst_val_Label = os.path.join(label_val_path, name + '.txt')

shutil.copyfile(srcImage, dst_val_Image)

shutil.copyfile(srcLabel, dst_val_Label)

else:

dst_test_Image = os.path.join(img_test_path, name + '.jpg')

dst_test_Label = os.path.join(label_test_path, name + '.txt')

shutil.copyfile(srcImage, dst_test_Image)

shutil.copyfile(srcLabel, dst_test_Label)

if __name__ == '__main__':

"""

python split_datasets.py --image-dir my_datasets/color_rings/imgs --txt-dir my_datasets/color_rings/txts --save-dir my_datasets/color_rings/train_data

"""

parser = argparse.ArgumentParser(description='split datasets to train,val,test params')

parser.add_argument('--image-dir', type=str, default=r"VOCdevkit\images", help='image path dir')

parser.add_argument('--txt-dir', type=str, default=r"VOCdevkit\txt", help='txt path dir')

parser.add_argument('--save-dir', default=r"VOCdevkit\datsets", type=str, help='save dir')

args = parser.parse_args()

image_dir = args.image_dir

txt_dir = args.txt_dir

save_dir = args.save_dir

main(image_dir, txt_dir, save_dir)

运行以上代码后将会在datasets文件夹中生成images和labels文件夹,其中分别存有训练集、验证集和测试集的图片及标签文件。

5.新建data.yaml文件

(1)在YOLO v8\ultralytics-main\ultralytics\yolo\v8\detect\文件夹下新建data.yaml文件

在data.yaml文件中放入以下代码,注意修改其中的三个文件夹路径以及对应数据集的nc和class name:

# dataset path

train: E:\knowledge\YOLO v8\ultralytics-main\ultralytics\yolo\v8\detect\datasets\images\train

val: E:\knowledge\YOLO v8\ultralytics-main\ultralytics\yolo\v8\detect\datasets\images\val

test: E:\knowledge\YOLO v8\ultralytics-main\ultralytics\yolo\v8\detect\datasets\images\test

# number of classes

nc: 1

# class names

names: ['pothole']

本文作者:Ah_Qiu

本文链接:https://www.cnblogs.com/qqsj/p/17492360.html

版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 2.5 中国大陆许可协议进行许可。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· winform 绘制太阳,地球,月球 运作规律

· AI与.NET技术实操系列(五):向量存储与相似性搜索在 .NET 中的实现

· 超详细:普通电脑也行Windows部署deepseek R1训练数据并当服务器共享给他人

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 上周热点回顾(3.3-3.9)