flume配置参数的意义

1.监控端口数据:

flume启动:

[bingo@hadoop102 flume]$ bin/flume-ng agent --conf conf/ --name a1 --conf-file job/flume-telnet-logger.conf -Dflume.root.logger=INFO,console

参数说明:

--conf conf/ :表示配置文件存储在conf/目录

--name a1 :表示给agent起名为a1

--conf-file job/flume-telnet.conf :flume本次启动读取的配置文件是在job文件夹下的flume-telnet.conf文件。

-Dflume.root.logger==INFO,console :-D表示flume运行时动态修改flume.root.logger参数属性值,并将控制台日志打印级别设置为INFO级别。日志级别包括:log、info、warn、error。

2.实时读取本地文件导HDFS:

执行监控配置

[bingo@hadoop102 flume]$ bin/flume-ng agent --conf conf/ --name a2 --conf-file job/flume-file-hdfs.conf

开启Hadoop和Hive并操作Hive产生日志

[bingo@hadoop102 hadoop-2.7.2]$ sbin/start-dfs.sh [bingo@hadoop103 hadoop-2.7.2]$ sbin/start-yarn.sh [bingo@hadoop102 hive]$ bin/hive hive (default)>

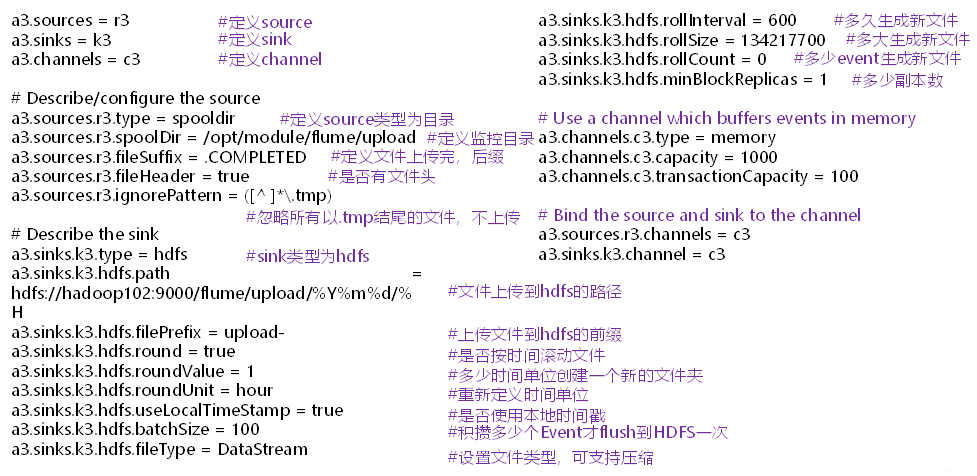

3.实时读取本地目录文件导HDFS:

启动监控文件夹命令

[bingo@hadoop102 flume]$ bin/flume-ng agent --conf conf/ --name a3 --conf-file job/flume-dir-hdfs.conf

说明: 在使用Spooling Directory Source时

1) 不要在监控目录中创建并持续修改文件

2) 上传完成的文件会以.COMPLETED结尾

3) 被监控文件夹每500毫秒扫描一次文件变动

3. 向upload文件夹中添加文件

在/opt/module/flume目录下创建upload文件夹

[bingo@hadoop102 flume]$ mkdir upload

向upload文件夹中添加文件

[bingo@hadoop102 upload]$ touch atguigu.txt

[bingo@hadoop102 upload]$ touch atguigu.tmp

[bingo@hadoop102 upload]$ touch atguigu.log