中文词频统计

中文分词

- 下载一中文长篇小说,并转换成UTF-8编码。

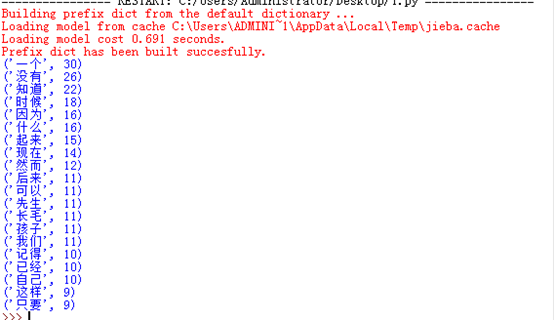

- 使用jieba库,进行中文词频统计,输出TOP20的词及出现次数。

- 排除一些无意义词、合并同一词。

- 对词频统计结果做简单的解读。

#读取小说,转换成utf-8编码 import jieba a=open('朝花夕拾.txt','r',encoding='utf-8').read() #分隔符'.,:;?!-_"’ for i in ',。!?“”、:《》()…-;': a=a.replace(i,'') #分隔--精确模式 sw=list(jieba.cut(a)) #中文词频统计 d={} s=set(sw) exc={'\ufeff','\n'} s=s-exc #排除一些无意义词、合并同义词 for i in s: if len(i)>1: d[i]=sw.count(i) #排除长度小于1的词 s=list(d.items()) s.sort(key=lambda x:x[1],reverse=True) #输出TOP20 for i in range(20): print(s[i])

所选小说是鲁迅所写的朝花夕拾里的其中3个小故事,都是作者小时候发生的有趣的事情。