Hadoop学习之路(八)在eclispe上搭建Hadoop开发环境

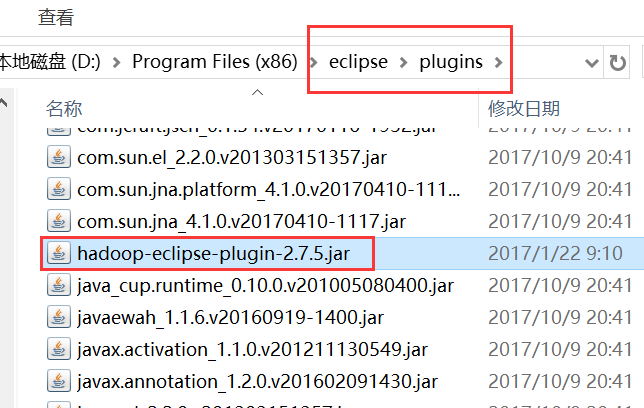

一、添加插件

将hadoop-eclipse-plugin-2.7.5.jar放入eclipse的plugins文件夹中

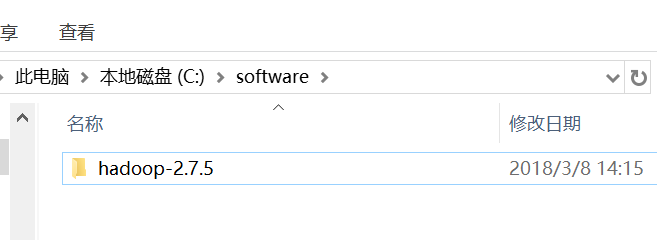

二、在Windows上安装Hadoop2.7.5

版本最好与Linux集群中的hadoop版本保持一致

1、将hadoop-2.7.5-centos-6.7.tar.gz解压到Windows上的C盘software目录中

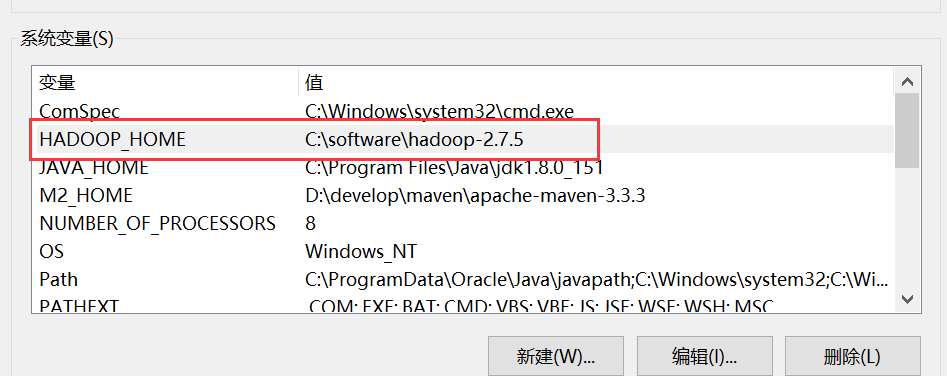

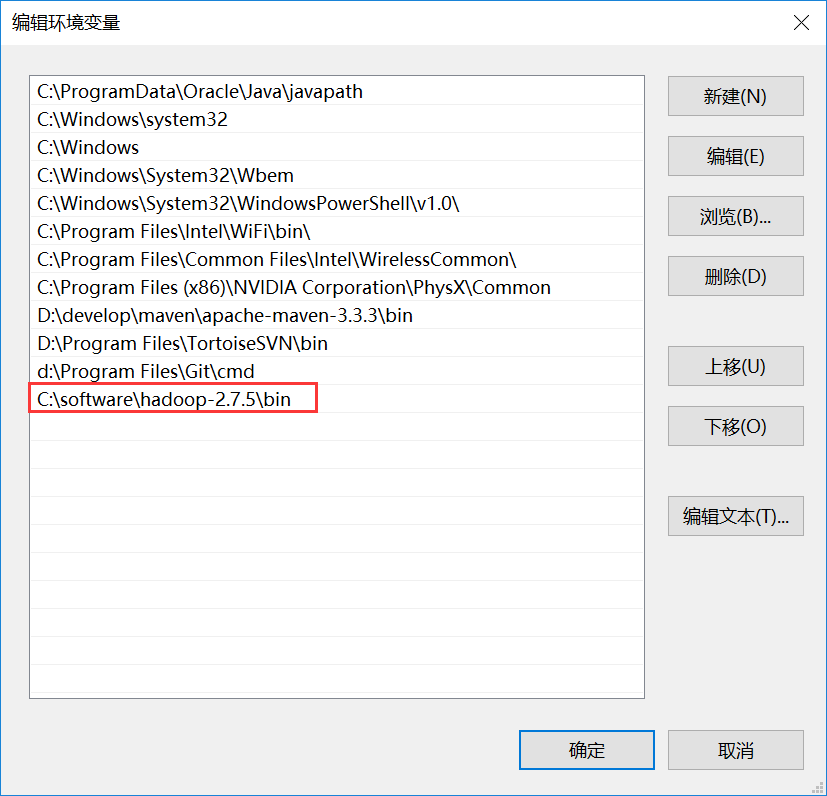

2、配置hadoop的环境变量

HADOOP_HOME=C:\software\hadoop-2.7.5

Path=C:\software\hadoop-2.7.5\bin

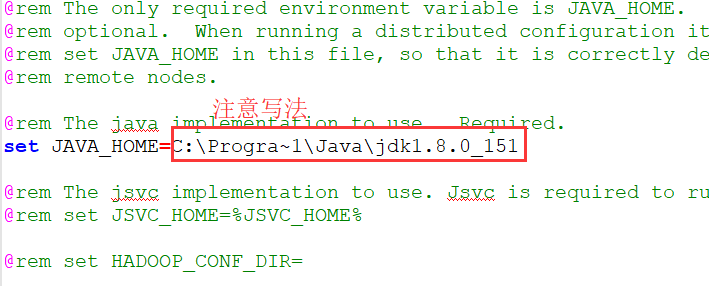

3、修改Hadoop安装目录C:\software\hadoop-2.7.5\etc\hadoop中hadoop-env.cmd

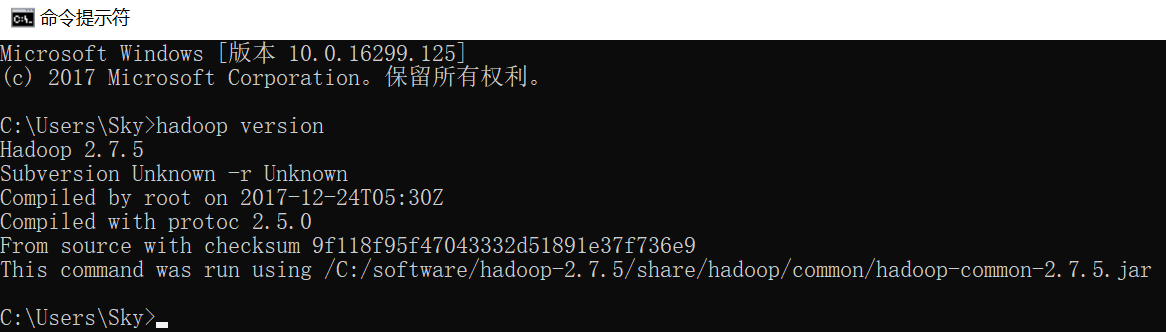

4、查看Hadoop版本

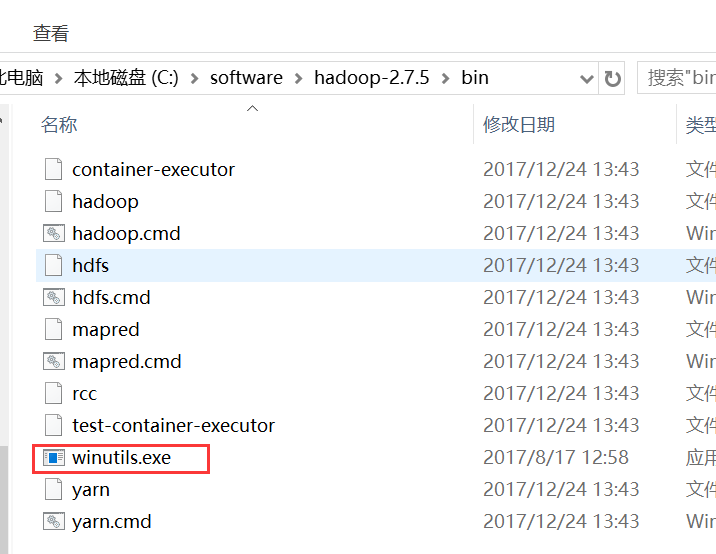

5、添加Windows支持文件

因为安装的Hadoop编译的版本是CentOS6.7的版本,在Windows上运行需要添加文件

1)winutils.exe 放在windows平台中你安装的hadoop的bin目录下

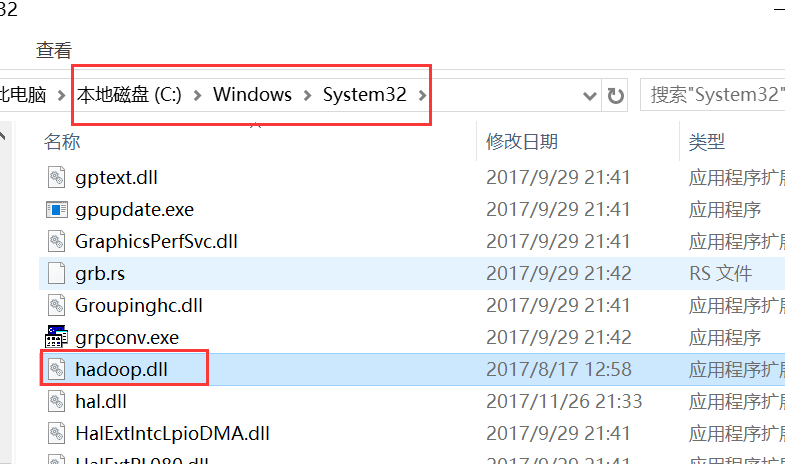

2) hadoop.dll 放在windows操作系统的 c:/windows/system32目录下

6、重新启动eclipse

三、eclipse中的配置

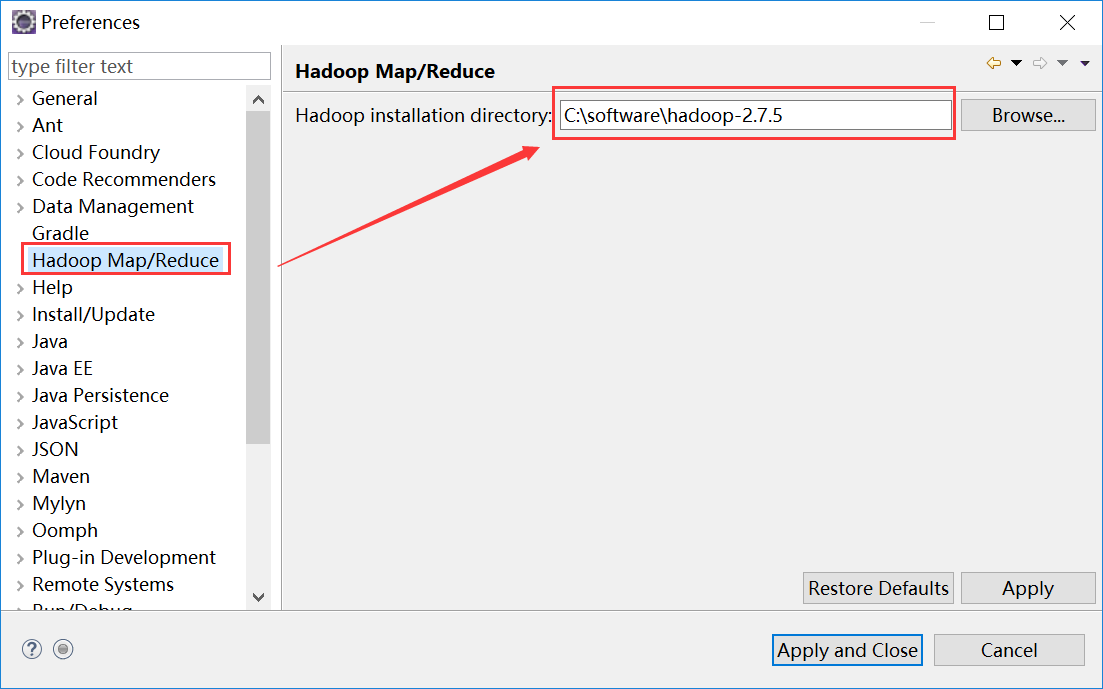

1、重新启动eclipse,打开windows->Preferences的Hadoop Map/Reduce中设置安装目录

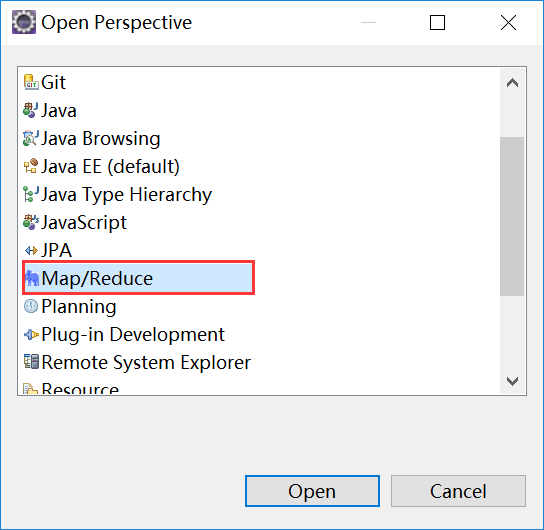

2、打开Windows->Open Perspective中的Map/Reduce,在此perspective下进行hadoop程序开发

3、打开Windows->Show View中的Map/Reduce Locations,如下图右键选择New Hadoop location…新建hadoop连接。

4、配置相关信息

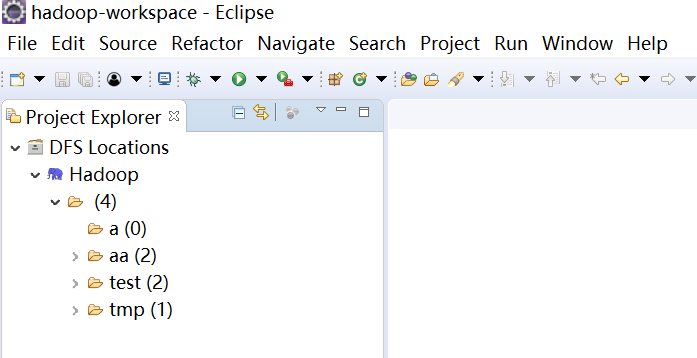

5、配置成功之后再右侧显示如下

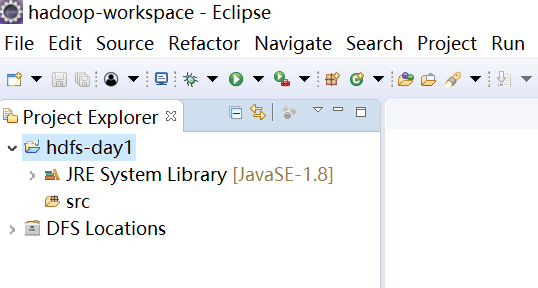

四、创建HDFS项目

1、创建一个java project

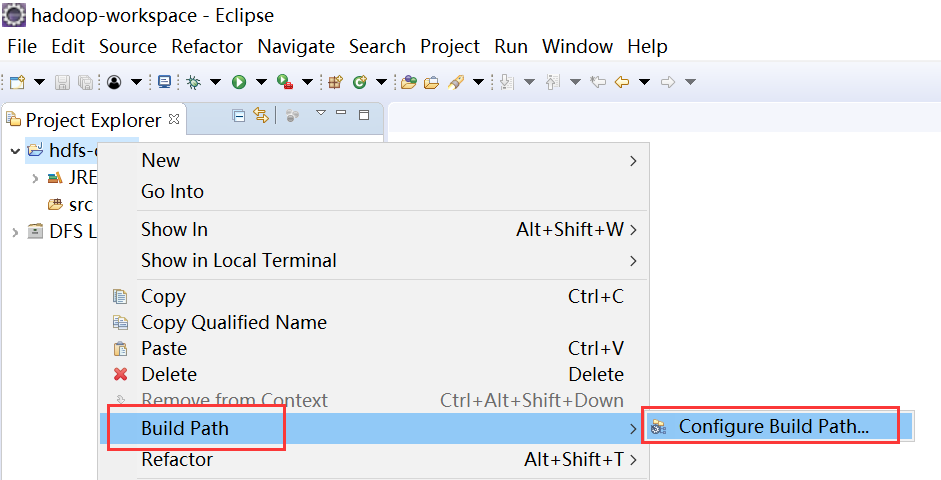

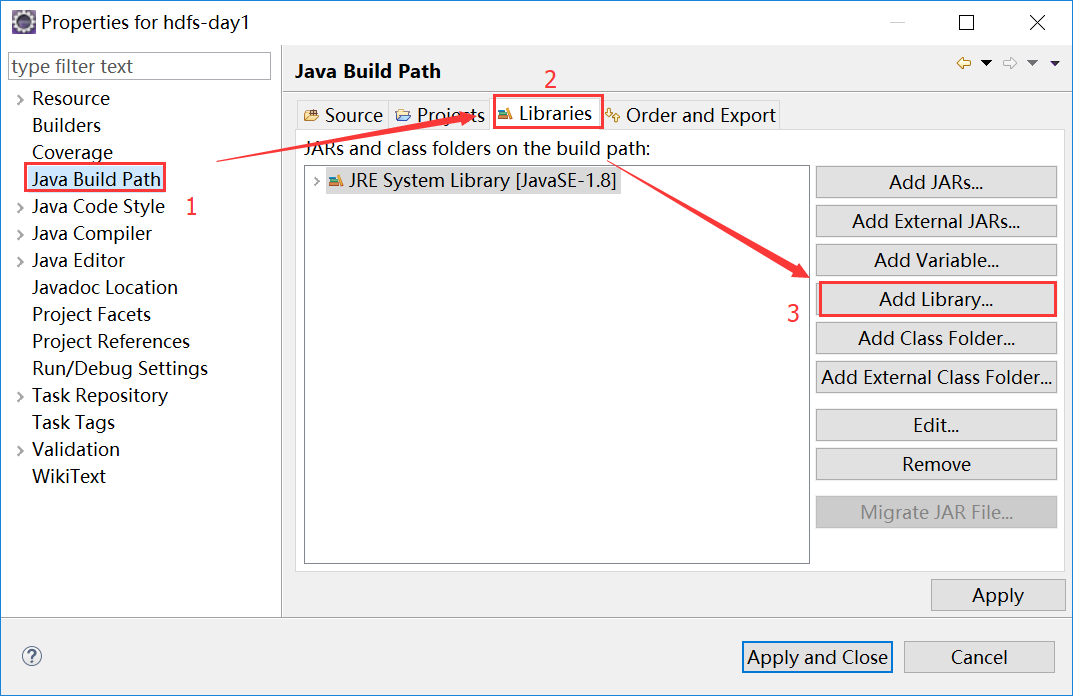

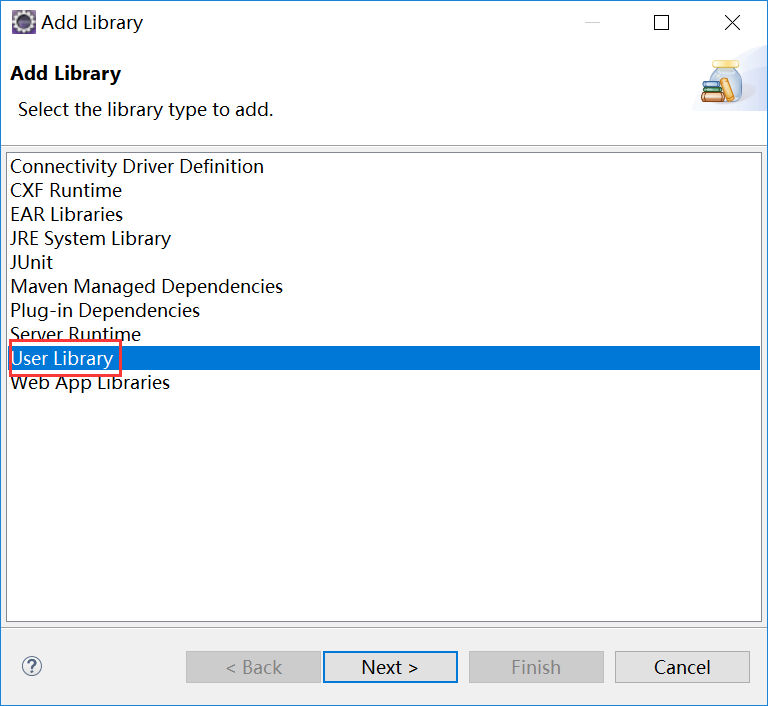

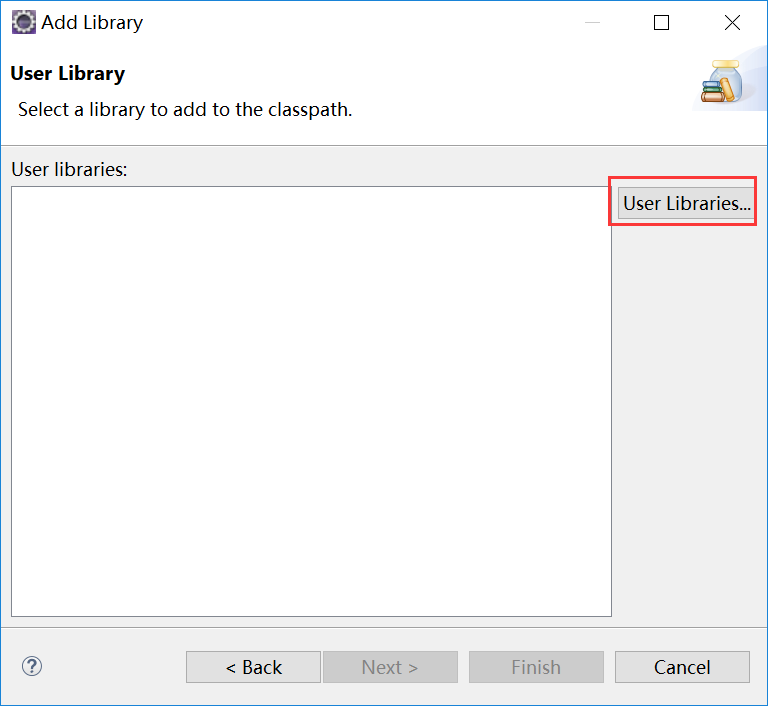

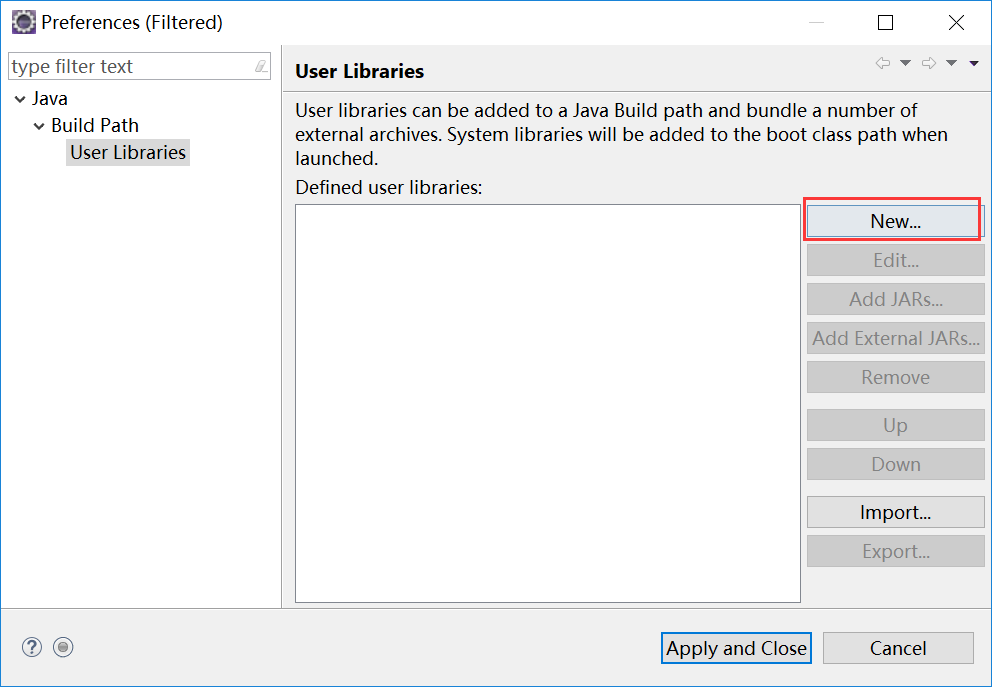

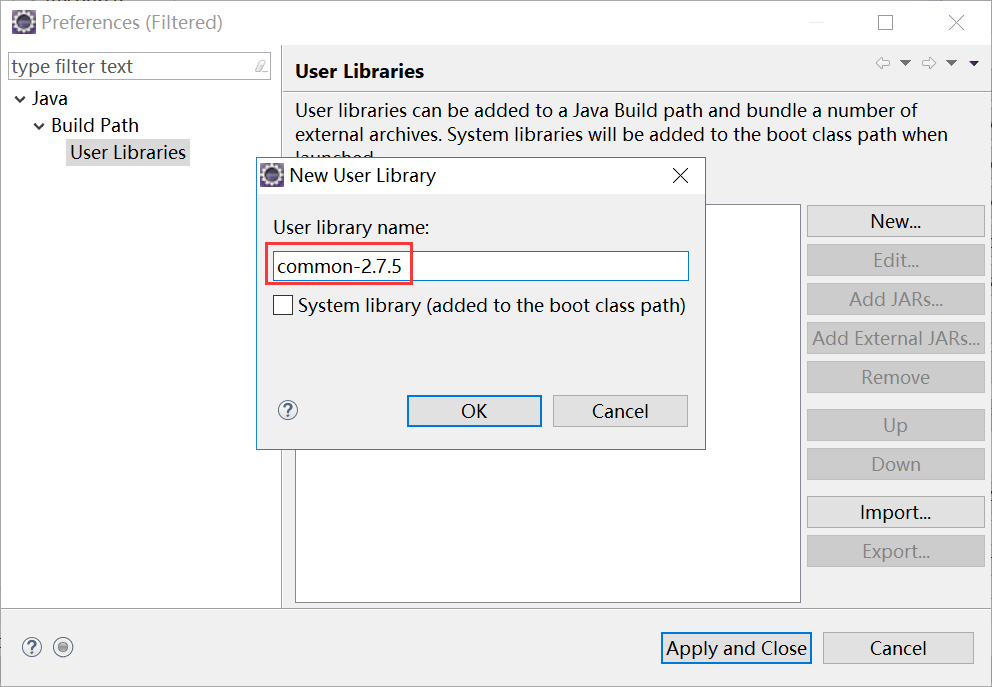

2、添加jar包这里使用第二种

有三种方式可以往项目中添加jar依赖:

1)直接创建一个lib文件夹,然后放入对应的依赖包,最后add build path

优点:移植方便

缺点:项目臃肿

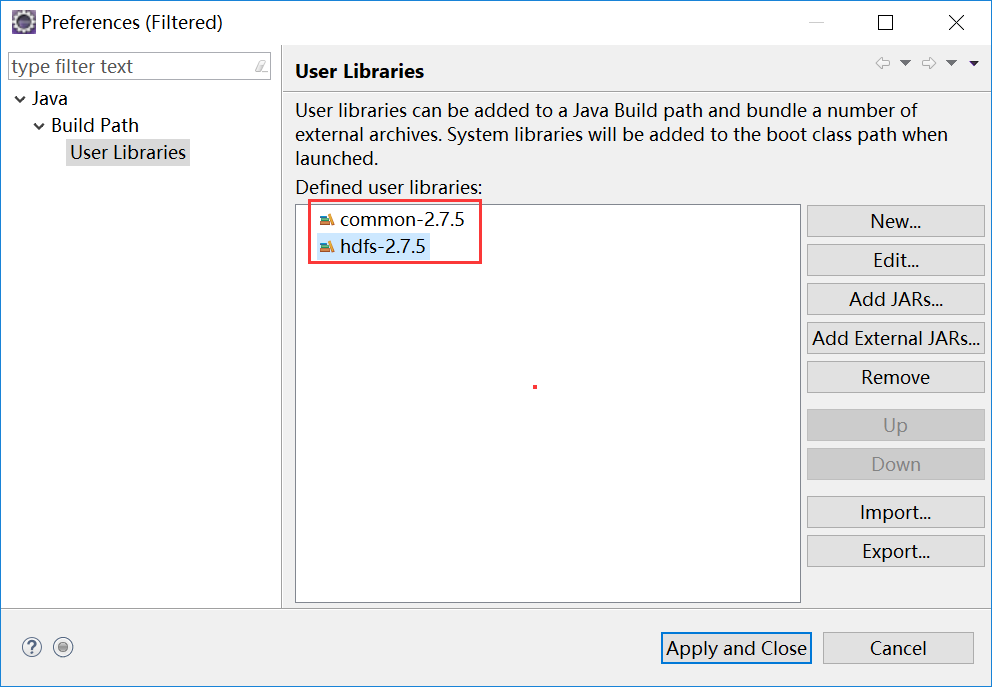

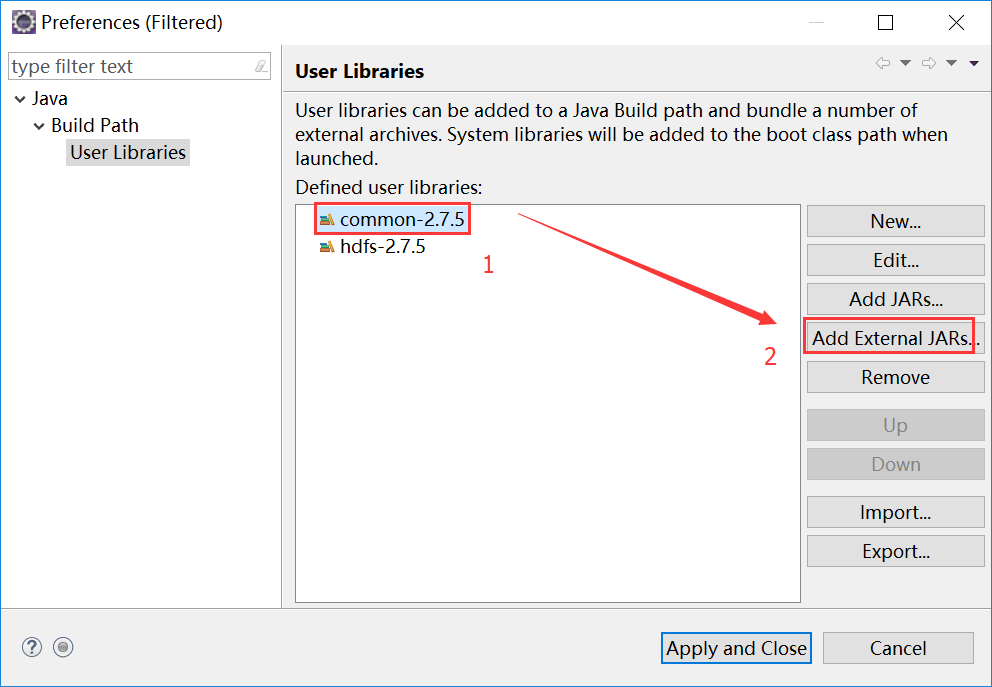

2)在eclipse中创建user libarary, 然后引入

优点:解决了不同项目中的相同jar的重复依赖问题, 不是直接放入,是引入的方式

缺点:移植不方便

3)最后直接使用maven管理jar依赖

完美解决方案:使用maven 我们在项目中只需要编写好:pom.xml文件即可

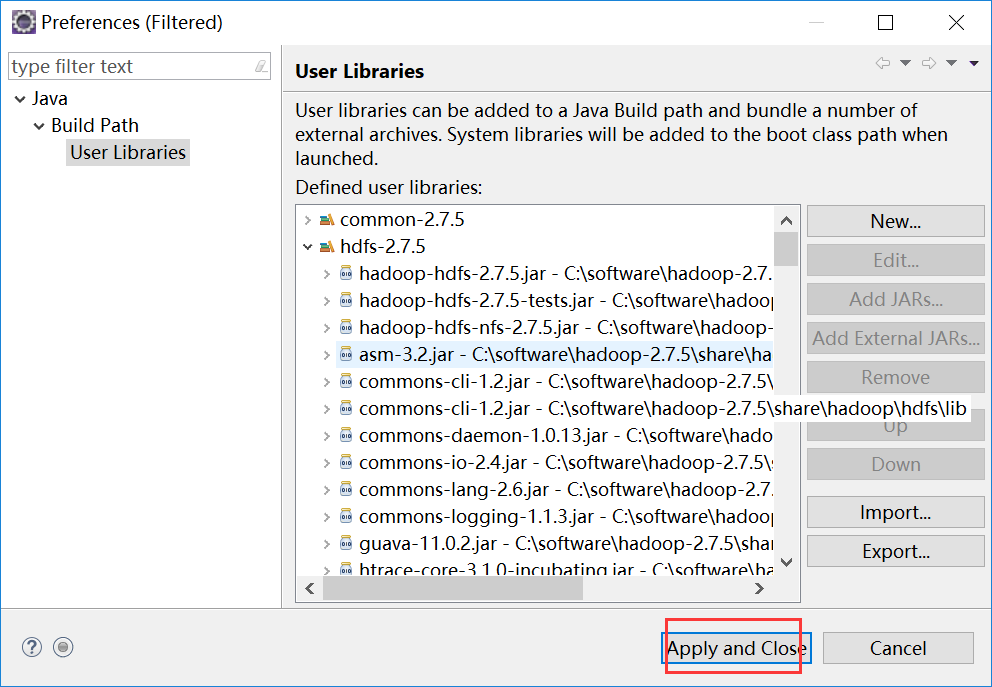

目前只是操作HDFS,所以只需要引入common和HDFS相关的jar包即可。

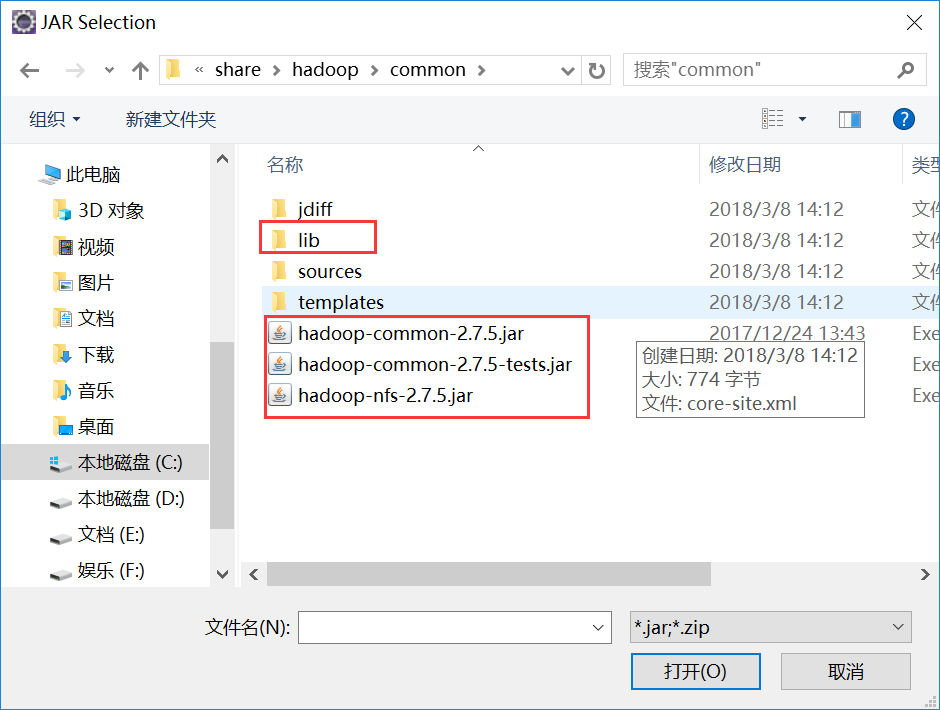

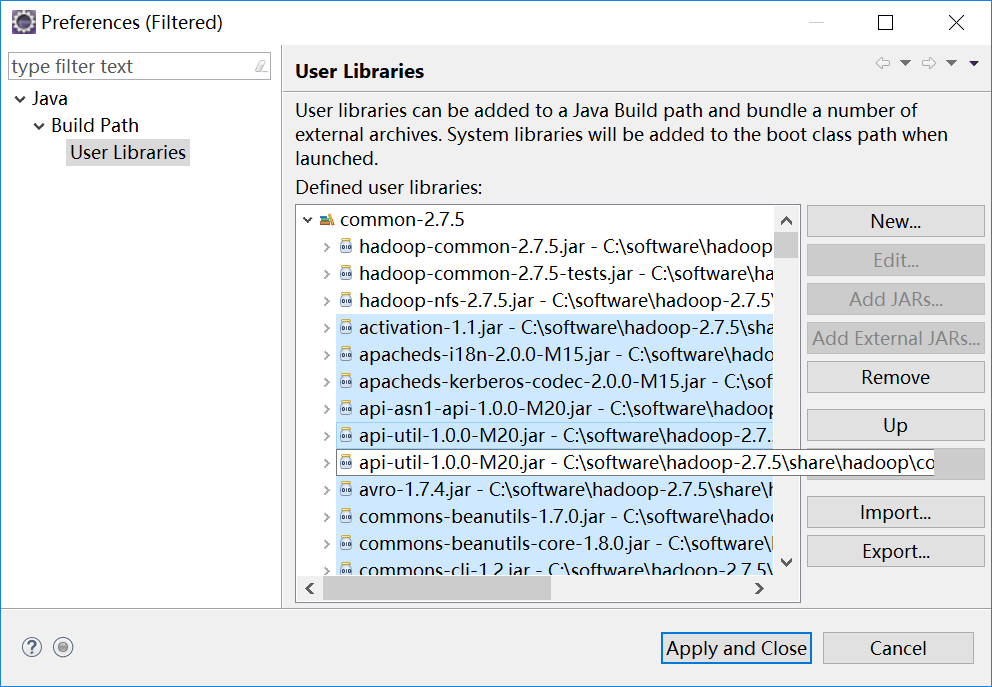

Hadoop的common、hdfs、MapReduce、yarn的相关jar包的位置在安装目录的C:\software\hadoop-2.7.5\share\hadoop文件夹中,各自文件夹下的jar包是核心jar包,lib下的jar包是核心jar包的依赖jar包,都需要引入

hdfs的jar包用相同的方法引入

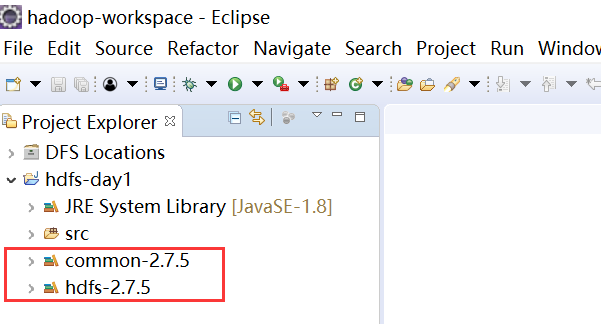

这样项目就成功引入了common和hdfs相关的jar包

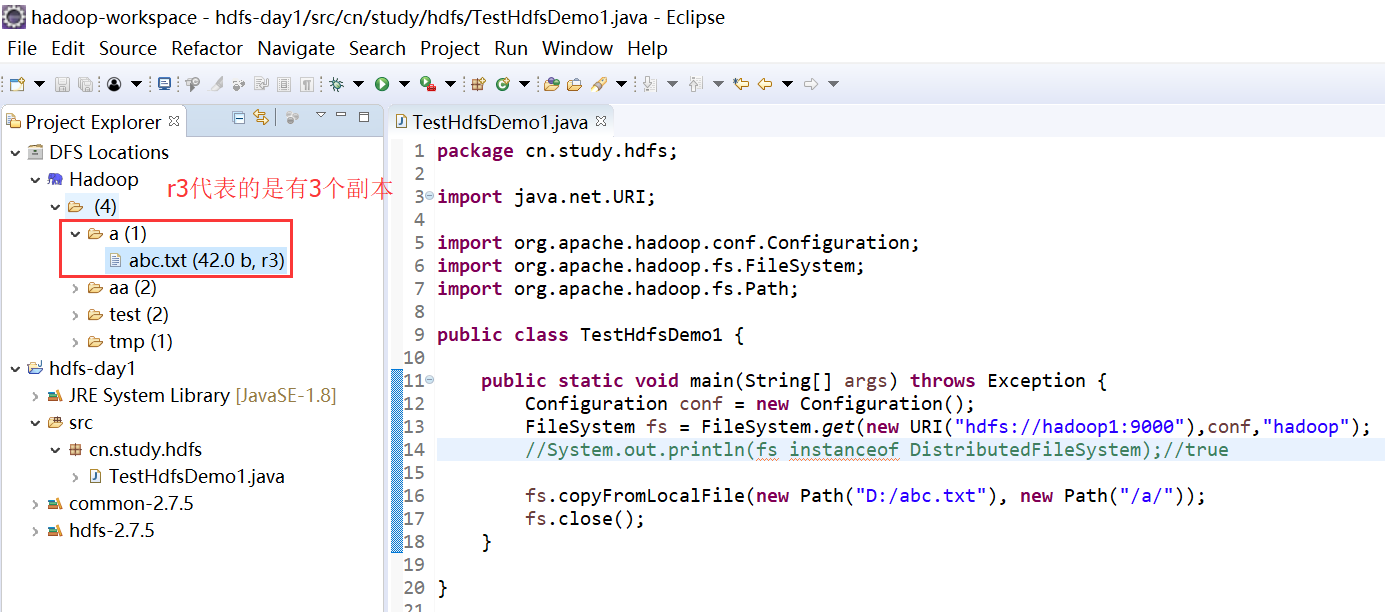

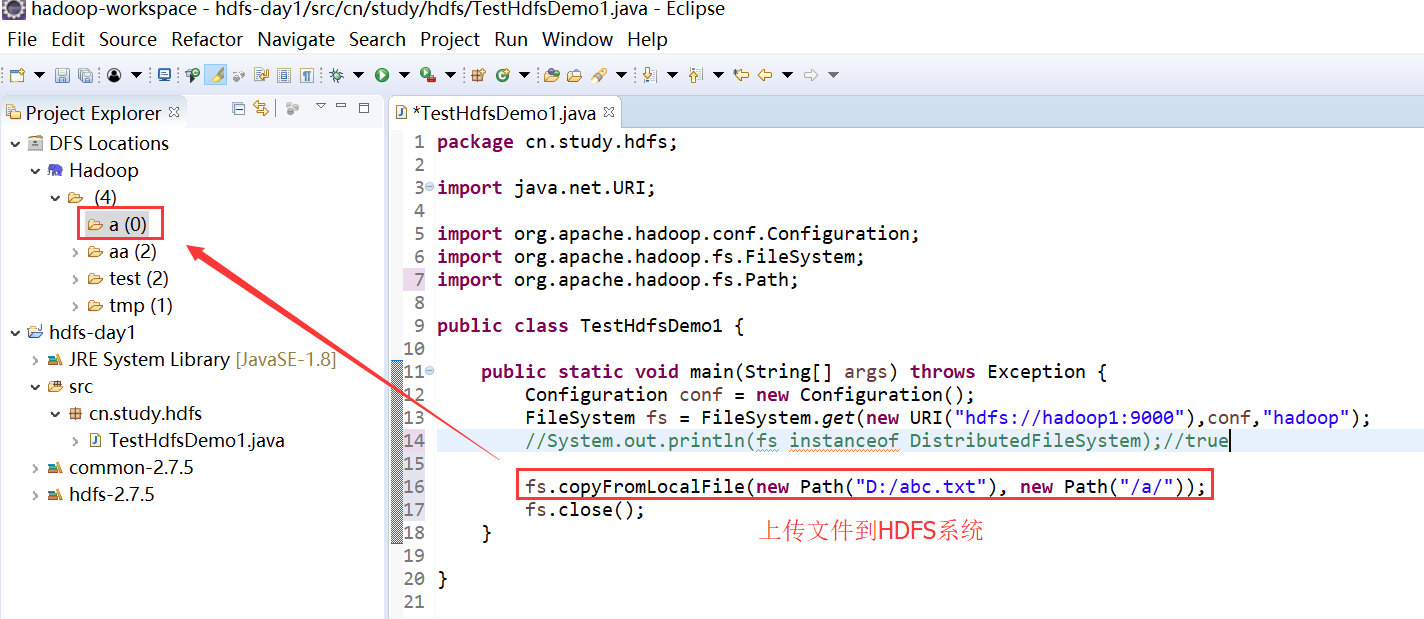

3、创建测试类

package cn.study.hdfs; import java.net.URI; import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.FileSystem; import org.apache.hadoop.fs.Path; public class TestHdfsDemo1 { public static void main(String[] args) throws Exception { Configuration conf = new Configuration(); FileSystem fs = FileSystem.get(new URI("hdfs://hadoop1:9000"),conf,"hadoop"); //System.out.println(fs instanceof DistributedFileSystem);//true fs.copyFromLocalFile(new Path("D:/abc.txt"), new Path("/a/")); fs.close(); } }

测试之前

测试之后