loss

## cross-entropy loss

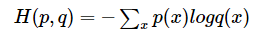

给定两个概率分布:p(理想结果即正确标签向量)和q(神经网络输出结果即经过softmax转换后的结果向量),则通过q来表示p的交叉熵为:

交叉熵刻画的是通过概率分布q来表达概率分布p的困难程度,其中p是正确答案,q是预测值,也就是交叉熵值越小,两个概率分布越接近

binary cross-entropy loss

交叉熵值越小,两个概率分布越接近

\(L=-[y log \hat{y}+(1-y)log(1-\hat{y})]\)

其中,\(y\)表示样本 i 的 label,正类为1,负类为0

\(\hat y\)表示样本 i 预测为正的概率(sigmoid的输出)(0,1)

y=1/2 时,

对抗损失

参考